Inoltre, una considerazione cruciale è il modo in cui queste tecnologie di intelligenza artificiale possono adattarsi e rivoluzionare gli ecosistemi esistenti all’interno di infrastrutture di alto valore e ad alta domanda, come aeroporti, aerei e vari sistemi di mobilità avanzati.

Utilizzando tecnologie AI innovative e sfruttando i vantaggi della piattaforma dell'Università di Cranfield, il Corso di Laurea Magistrale in Intelligenza Artificiale Applicata mira a coltivare i futuri leader nell'intelligenza artificiale applicata in diversi settori dell'ingegneria. Il suo obiettivo principale è accelerare lo sviluppo e l’implementazione di tecnologie IA affidabili per applicazioni critiche per la sicurezza in tutto il mondo.

Il Group Design Project (GDP) è un modulo di apprendimento basato sui problemi e lo scopo del GDP è che gli studenti progettino, implementino, convalidino e testino sistemi basati sull'intelligenza artificiale in tempo reale per risolvere problemi del mondo reale. Il GDP mira inoltre a fornire agli studenti l'esperienza di lavorare su un progetto di ingegneria collaborativa, soddisfacendo le esigenze di un potenziale cliente e rispettando le scadenze.

Nel 2022 e 2023, agli studenti iscritti al nostro Master in Intelligenza Artificiale Applicata è stato assegnato un progetto di design di gruppo stimolante ed impegnativo. L'obiettivo era sfruttare le conoscenze applicate sull'intelligenza artificiale acquisite dai corsi per sviluppare prodotti aeroportuali innovativi e più sicuri. Lavorando in piccoli team di sei persone, gli studenti sono stati incaricati di progettare soluzioni che comprendessero architettura software e hardware, sviluppo e test di modelli di intelligenza artificiale, nonché aspetti di coinvolgimento nel mondo reale.

L'argomento del progetto era intenzionalmente ampio e richiedeva agli studenti di collaborare all'interno dei loro gruppi per esplorare e perfezionare aree di interesse specifiche in base alle loro competenze e interessi collettivi. Questo approccio ha favorito la creatività, il lavoro di squadra e una comprensione più profonda dell’applicazione pratica delle tecnologie di intelligenza artificiale in scenari del mondo reale.

A ciascun gruppo è stato chiesto di sviluppare soluzioni di intelligenza artificiale in tempo reale per aeroporti intelligenti per ottenere le seguenti funzionalità:

- Il sistema dovrà essere in grado di rilevare gli utenti umani e di stimarne le pose e i comportamenti sulla base del rilevamento e del tracciamento precisi della posa.

- Il sistema dovrà essere in grado di classificare diversi comportamenti della folla e chiarirne le ragioni, l'importanza e la fattibilità.

- Il modello di intelligenza artificiale dovrebbe essere convalidato in modo incrociato con diverse metriche in termini di accuratezza, calcolo e inferenza.

- Il modello di intelligenza artificiale dovrebbe poter essere implementato in tempo reale per informare sui vantaggi e gli svantaggi delle attuali tecnologie di intelligenza artificiale in queste applicazioni critiche per la sicurezza.

- Il sistema può fare affidamento su diverse fonti di sensori come input per consentire la fusione dei sensori per prestazioni robuste, tuttavia sono benvenute anche soluzioni a basso costo ma efficienti.

Caso di studio 1: rilevamento delle cadute in un ambiente di manutenzione di un aeromobile.

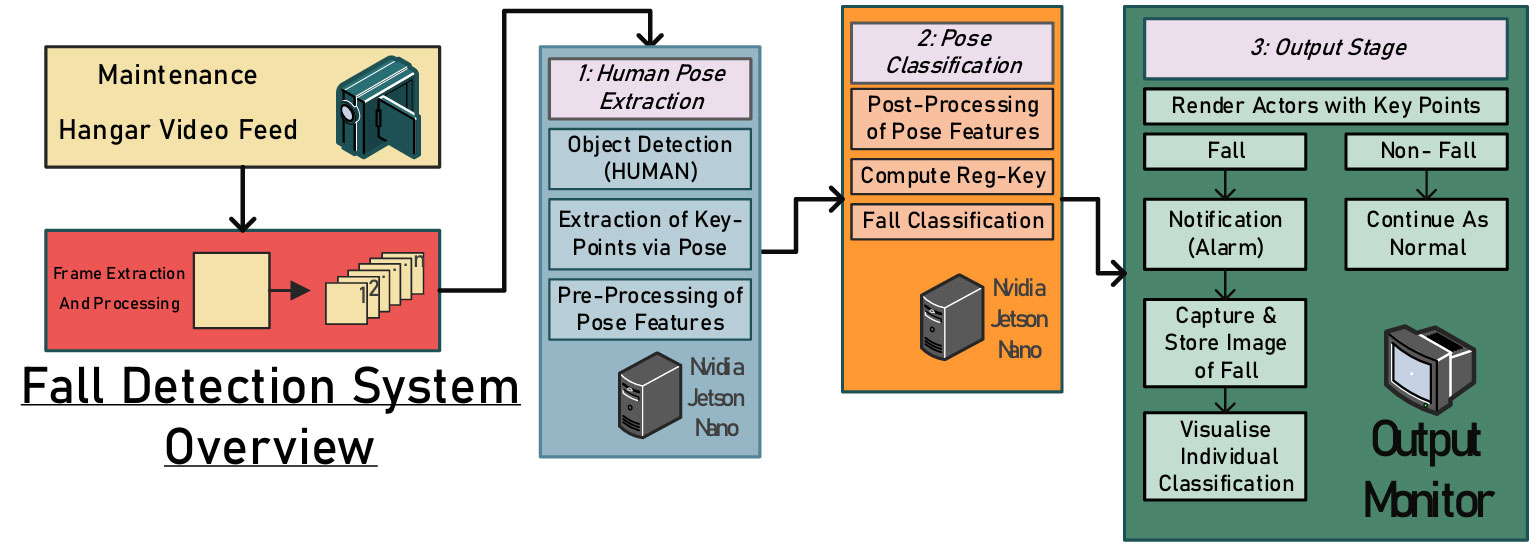

Gli ambienti di manutenzione presentano rischi significativi, tra cui macchinari incustoditi, recinzioni o protezioni fisiche inadeguate vicino ad aree pericolose e spazi di lavoro disordinati. Tra questi rischi, le lesioni mortali da caduta sono comuni in modo allarmante. Il rilevamento e la segnalazione tempestiva di incidenti non mortali potrebbero prevenire ulteriori danni o decessi. Pertanto, questo lavoro propone un sistema integrato basato sulla visione per monitorare i dipendenti durante le attività di manutenzione degli aeromobili, migliorando la sicurezza e prevenendo gli incidenti (vedere la figura seguente).

.fusion-gallery-1 .fusion-gallery-image {border:0px solid #e2e2e2;}

Dai risultati iniziali di formazione e validazione del modello progettato, l'apparente assenza di un set di dati già pronto per la manutenzione dell'hangar aeroportuale presenta la possibilità di una distorsione verso le immagini provenienti da video catturati da angoli di ripresa perpendicolari ripresi dalla vicinanza al soggetto. Sfruttando i vantaggi di Cranfield, l'hangar di manutenzione dell'Università di Cranfield è stato scelto e utilizzato per la raccolta dei dati in questo progetto.

In totale sono stati registrati circa 50 brevi video (da due a cinque minuti) di attività di manutenzione simulata, alcune con cadute e altre senza. I video catturati sono stati suddivisi in fotogrammi e annotati utilizzando la libreria software di stima della posa MoveNet e sono state generate mappe vettoriali delle principali posizioni articolari del soggetto. La figura seguente mostra alcune istantanee dei dati sperimentali.

.fusion-gallery-2 .fusion-gallery-image {border:0px solid #e2e2e2;}

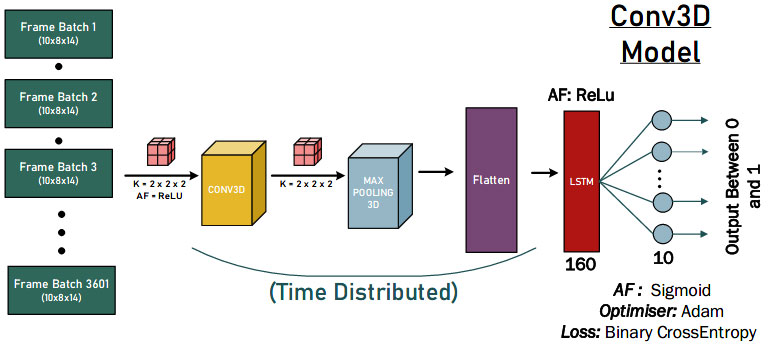

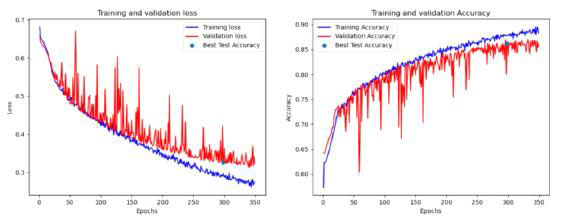

I nostri studenti hanno testato gli approcci di rete neurale convoluzionale 1-D, 2-D e 3-D per valutare quantitativamente la progettazione del modello di intelligenza artificiale più potente. La figura seguente è una dimostrazione delle soluzioni di convoluzione 3D.

.fusion-gallery-3 .fusion-gallery-image {border:0px solid #e2e2e2;}

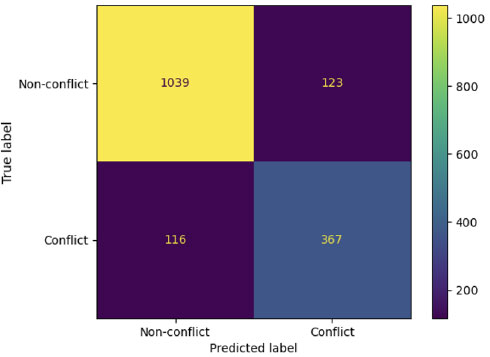

Infine, le soluzioni AI proposte hanno ottenuto buoni risultati di rilevamento del comportamento di caduta, come mostrato nella figura seguente. Si possono trarre alcune conclusioni. Innanzitutto, il modello aveva classificazioni 0 FP, il che suggerisce che il modello non classifica erroneamente una caduta. In secondo luogo, ci sono 940 veri negativi per ciascun modello, ciò potrebbe probabilmente essere dovuto al fatto che i dati di ciascun test contengono una porzione di mancate cadute (classificate come 0) prima che l'attore cada.

.fusion-gallery-4 .fusion-gallery-image {border:0px solid #e2e2e2;}

Caso di studio 2: rilevamento dei segni vitali di infarto miocardico mediante visione artificiale e intelligenza artificiale edge

Edge AI si riferisce all'implementazione di applicazioni di intelligenza artificiale in dispositivi situati nell'ambiente fisico. La convenienza e la facilità d’uso sono fattori chiave nell’adozione di algoritmi di intelligenza artificiale in situazioni in cui gli utenti finali incontrano sfide del mondo reale. In questo progetto, il nostro studente ha proposto un modello di rilevamento dell'infarto leggero e a basso costo per la risposta rapida e il salvataggio in aeroporto. Il processo è composto da quattro fasi principali, come mostrato nella figura seguente.

.fusion-gallery-5 .fusion-gallery-image {border:0px solid #e2e2e2;}

La prima fase costituisce l'adeguata selezione e preparazione di un set di dati di immagini, insieme alle annotazioni necessarie per i riquadri di delimitazione delle classi (dolore toracico, caduta).

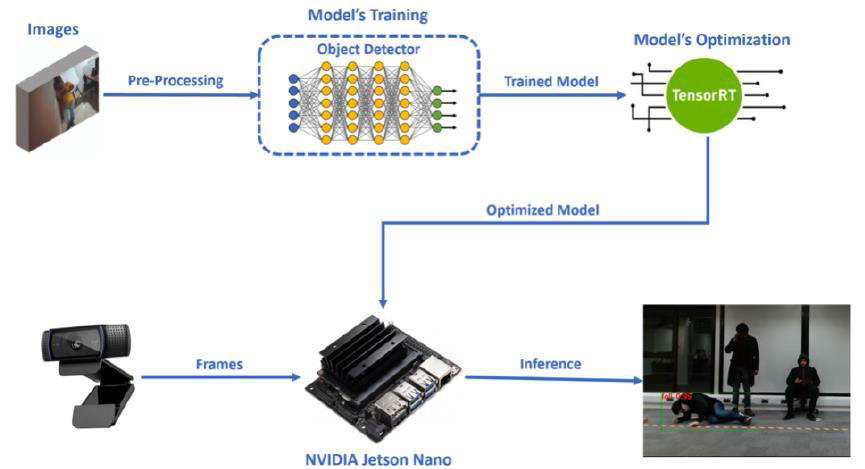

Inoltre, come seconda fase avviene l'addestramento del nostro modello di rilevatore di oggetti tramite l'apprendimento del trasferimento. La fase specifica è stata eseguita in Google Colab, utilizzando PyTorch. Successivamente, dopo il completamento della fase di formazione, il modello è stato inserito nel Jetson Nano di NVIDIA, che era il dispositivo embedded da noi scelto da utilizzare per la nostra applicazione di visione artificiale Edge AI.

La terza fase della progettazione del nostro sistema è stata la conversione e l'ottimizzazione appropriate del modello, affinché potesse funzionare in modo più efficiente su Jetson Nano. L'ottimizzazione del nostro modello è stata eseguita utilizzando il motore di inferenza TensorRT di NVIDIA e il processo specifico è stato eseguito in Jetson Nano (come mostrato nella figura seguente).

.fusion-gallery-6 .fusion-gallery-image {border:0px solid #e2e2e2;}

L'ultimo passaggio è l'esecuzione ottimizzata del modello su Jetson Nano, utilizzando come input i frame che riceve da una webcam, per eseguire il processo di rilevamento degli oggetti in tempo reale e rilevare le nostre classi (dolore toracico, caduta). Insieme a questo processo, nel codice di inferenza eseguito su Jetson Nano, erano presenti due scenari specifici. I risultati finali dell'inferenza sono mostrati nella figura seguente.

.fusion-gallery-7 .fusion-gallery-image {border:0px solid #e2e2e2;}

Caso studio 3: monitoraggio della folla e analisi del distanziamento sociale

Gli aeroporti registrano ogni giorno enormi afflussi di flussi di passeggeri e, analogamente ad altri luoghi e organizzazioni affollati, devono garantire la sicurezza pubblica e garantire che siano implementate misure adeguate per mitigare i rischi durante le pandemie. In questo progetto, i nostri studenti hanno proposto un sistema integrato basato sulla visione artificiale che fornisce monitoraggio e analisi multifunzionali della folla negli aeroporti. I risultati del sistema sono destinati ad avvantaggiare il personale di gestione dell’aeroporto e i passeggeri, fornendo analisi e intelligence basate sulla folla.

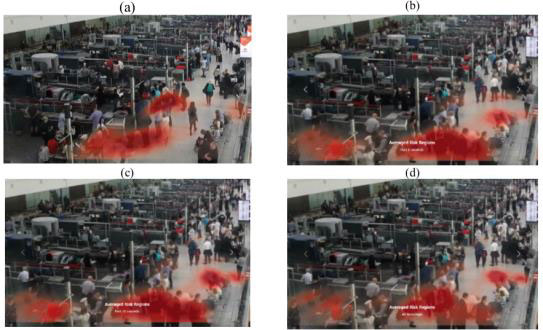

Il sistema è costituito da una piattaforma integrata (vedi figura sotto) per analizzare e monitorare la folla in luoghi pubblici utilizzando i feed di videosorveglianza. L’attenzione si concentra specificamente sugli aeroporti intelligenti, ma il quadro di base è adattabile a qualsiasi contesto pubblico in cui sia utile analizzare e monitorare le caratteristiche della folla.

.fusion-gallery-8 .fusion-gallery-image {border:0px solid #e2e2e2;}

Le caratteristiche della posa estratte da una scena vengono utilizzate dai modelli a valle del sistema per eseguire attività uniche. Ciò include il conteggio delle persone, la stima della distanza interpersonale, il rilevamento degli oggetti mascherati, la classificazione dello stato (seduto, in piedi, camminando, sdraiato ecc.) e il raggruppamento sociale. I risultati vengono quindi combinati per formare il dashboard integrato e il sistema di monitoraggio. Ad eccezione dell'uso comune delle caratteristiche di posa, queste attività rappresentano sfide uniche con diversi approcci di modellazione. Fortunatamente, grazie alla progettazione modulare del sistema, è stato possibile astrarre ogni attività e farla sviluppare da diversi membri del team.

.fusion-gallery-9 .fusion-gallery-image {border:0px solid #e2e2e2;}

Infine, un'interfaccia interagibile è progettata per integrare tutti gli output downstream in un unico viewport (vedere la figura seguente). L'app carica i file di dati creati dai modelli downstream sulla dashboard in tempo reale in modo da poter effettuare l'analisi dello stato attuale della scena. In qualsiasi momento, è possibile visualizzare il filmato originale della scena, insieme alle caratteristiche della posa estratte da ciascuna persona, su un lettore video adiacente. Il decisore può passare da una visualizzazione boxplot a una visualizzazione mappa termica e successivamente modificare il metraggio in cui i dati vengono ricevuti da due menu a discesa. Le statistiche riguardanti la scena vengono visualizzate all'estrema destra del viewport. Queste statistiche sono lo stato totale della maschera delle persone, il profilo di rischio totale, lo stato della posa totale delle persone, il conteggio totale delle persone, le proporzioni di distanziamento sociale e il boxplot delle proporzioni.

.fusion-gallery-10 .fusion-gallery-image {border:0px solid #e2e2e2;}

Caso studio 4: Rilevamento della violenza in aeroporto

Infine, uno dei nostri gruppi mira a sviluppare un quadro di rilevamento della violenza che stima le pose umane e classifica il comportamento violento nei filmati di sorveglianza (come mostrato nella figura seguente). Invece di estrarre direttamente le caratteristiche dai fotogrammi video, questo framework utilizza ViTPose per rilevare le pose umane in ogni fotogramma, quindi preelabora ed estrae le caratteristiche dalle informazioni sui punti chiave.

.fusion-gallery-11 .fusion-gallery-image {border:0px solid #e2e2e2;}

Dopo l'analisi completa di vari modelli utilizzando più set di dati (basati sull'angolo, sulla distanza, su sequenze di 1 secondo e 2 secondi) con un totale di 162 combinazioni di iperparametri, il team ha finalmente identificato diversi modelli promettenti che soddisfano criteri di valutazione specifici. Si può concludere che i modelli possono estrarre informazioni preziose sul comportamento violento utilizzando le caratteristiche della distanza dei punti chiave del corpo, come mostrato nella figura seguente.

.fusion-gallery-12 .fusion-gallery-image {border:0px solid #e2e2e2;}

Infine, collaborando con Saab UK, i nostri studenti possono sviluppare e integrare i loro modelli di intelligenza artificiale con la piattaforma di livello industriale (SAFE), una potente piattaforma di consapevolezza della situazione ampiamente utilizzata in molte stazioni di polizia del Regno Unito per la sorveglianza. Il gateway KAFKA viene applicato seguendo il motore AI e inoltrato al terminale del cliente per ulteriori visualizzazioni e avvisi. Se viene rilevata violenza nel video intercettato con riquadri di delimitazione, attiverà l'allarme che abbiamo configurato appositamente per il nostro modello mostrando il video intercettato nel layout del client SAFE, ci fornirà il messaggio di avviso con i dettagli. Alla fine, i nostri studenti hanno implementato con successo il modello di intelligenza artificiale del nostro centro DARTeC e hanno comunicato con il sistema Saab SAFE per aumentare la consapevolezza della situazione umana.

.fusion-gallery-13 .fusion-gallery-image {border:0px solid #e2e2e2;}

Creare gli ingegneri dell’intelligenza artificiale applicata del futuro

Questi sono solo alcuni esempi selezionati di interessanti progetti GDP del corso MSc AAI. Recentemente i nostri attuali studenti hanno intrapreso progetti PIL più impegnativi nell'interfaccia spiegabile con l'intelligenza artificiale, nel ragionamento causale per la pianificazione del movimento autonomo, nell'intelligenza artificiale basata sulla fisica per veicoli autonomi e nella futura gestione dello spazio aereo. Riteniamo che presto i nostri studenti di Master forniranno ricerche più interessanti.

Controlla le seguenti pubblicazioni di ricerca dei nostri studenti durante il PIL per scoprire quanto siano interessanti le soluzioni finali e i risultati:

- Osigbesan, Adeyemi, Solene Barrat, Harkeerat Singh, Dongzi Xia, Siddharth Singh, Yang Xing, Weisi Guo e Antonios Tsourdos. "Rilevamento delle cadute basato sulla visione nell'ambiente di manutenzione degli aeromobili con stima della posa." Nel 2022 Conferenza internazionale IEEE sulla fusione multisensore e l'integrazione per sistemi intelligenti (MFI), pp. 1-6. IEEE, 2022.

- Fraser, Benjamin, Brendan Copp, Gurpreet Singh, Orhan Keyvan, Tongfei Bian, Valentin Sonntag, Yang Xing, Weisi Guo e Antonios Tsourdos. “Riduzione della trasmissione virale attraverso il monitoraggio della folla basato sull’intelligenza artificiale e l’analisi del distanziamento sociale”. Nel 2022 Conferenza internazionale IEEE sulla fusione multisensore e l'integrazione per sistemi intelligenti (MFI), pp. 1-6. IEEE, 2022.

- Üstek, İ., Desai, J., Torrecillas, IL, Abadou, S., Wang, J., Fever, Q., Kasthuri, SR, Xing, Y., Guo, W. e Tsourdos, A., 2023, Agosto. Rilevamento della violenza a due fasi utilizzando ViTPose e modelli di classificazione negli aeroporti intelligenti. Nel 2023 IEEE Smart World Congress (SWC) (pagg. 797-802). IEEE.

- Benoit, Paul, Marc Bresson, Yang Xing, Weisi Guo e Antonios Tsourdos. "Rilevamento di azioni violente basate sulla visione in tempo reale tramite telecamere CCTV con stima della posa." Nel 2023 IEEE Smart World Congress (SWC), pp. 844-849. IEEE, 2023.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://blogs.cranfield.ac.uk/aerospace/exploring-safer-and-smarter-airports-with-the-applied-artificial-intelligence-msc-group-design-project/