Immagine dell'autore

Per molti di noi, esplorare le possibilità dei LLM è sembrato fuori portata. Che si tratti di scaricare software complicati, di capire la codifica o di aver bisogno di macchine potenti, iniziare con i LLM può sembrare scoraggiante. Ma immaginate se potessimo interagire con questi potenti modelli linguistici con la stessa facilità con cui avviamo qualsiasi altro programma sui nostri computer. Nessuna installazione, nessuna codifica, basta fare clic e parlare. Questa accessibilità è fondamentale sia per gli sviluppatori che per gli utenti finali. llamaFile emerge come una nuova soluzione, unendo il file lama.cpp con Biblioteca cosmopolita in un unico quadro. Questo quadro riduce la complessità dei LLM offrendo a eseguibile con un solo file chiamato "llama file", che viene eseguito su computer locali senza necessità di installazione.

Quindi, come funziona? offerte di lamaFile due metodi convenienti per l'esecuzione di LLM:

- Il primo metodo prevede il download dell'ultima versione di llamafile insieme ai pesi del modello corrispondente da Hugging Face. Una volta che hai quei file, sei a posto!

- Il secondo metodo è ancora più semplice: puoi accedere file di lama di esempio preesistenti che hanno pesi incorporati.

In questo tutorial lavorerai con il file lama del file Modello LLaVa utilizzando il secondo metodo. È un modello da 7 miliardi di parametri quantizzato a 4 bit con cui puoi interagire tramite chat, caricare immagini e porre domande. Sono disponibili anche file di lama di esempio di altri modelli, ma lavoreremo con il modello LLaVa poiché la dimensione del file di lama è 3.97 GB, mentre Windows ha una dimensione massima del file eseguibile di 4 GB. Il processo è abbastanza semplice e puoi eseguire LLM seguendo i passaggi indicati di seguito.

Innanzitutto, devi scaricare l'eseguibile llava-v1.5-7b-q4.llamafile (3.97 GB) dalla fonte fornita qui.

Apri il terminale del tuo computer e vai alla directory in cui si trova il file. Quindi esegui il comando seguente per concedere l'autorizzazione al tuo computer per eseguire questo file.

chmod +x llava-v1.5-7b-q4.llamafileSe utilizzi Windows, aggiungi ".exe" al nome del file llama alla fine. A questo scopo è possibile eseguire il seguente comando sul terminale.

rename llava-v1.5-7b-q4.llamafile llava-v1.5-7b-q4.llamafile.exeEsegui il file lama con il seguente comando.

./llava-v1.5-7b-q4.llamafile -ngl 9999

⚠️ Poiché MacOS utilizza zsh come shell predefinita e se ti imbatti in zsh: exec format error: ./llava-v1.5-7b-q4.llamafile errore allora devi eseguire questo:

bash -c ./llava-v1.5-7b-q4.llamafile -ngl 9999

Per Windows, il comando potrebbe assomigliare a questo:

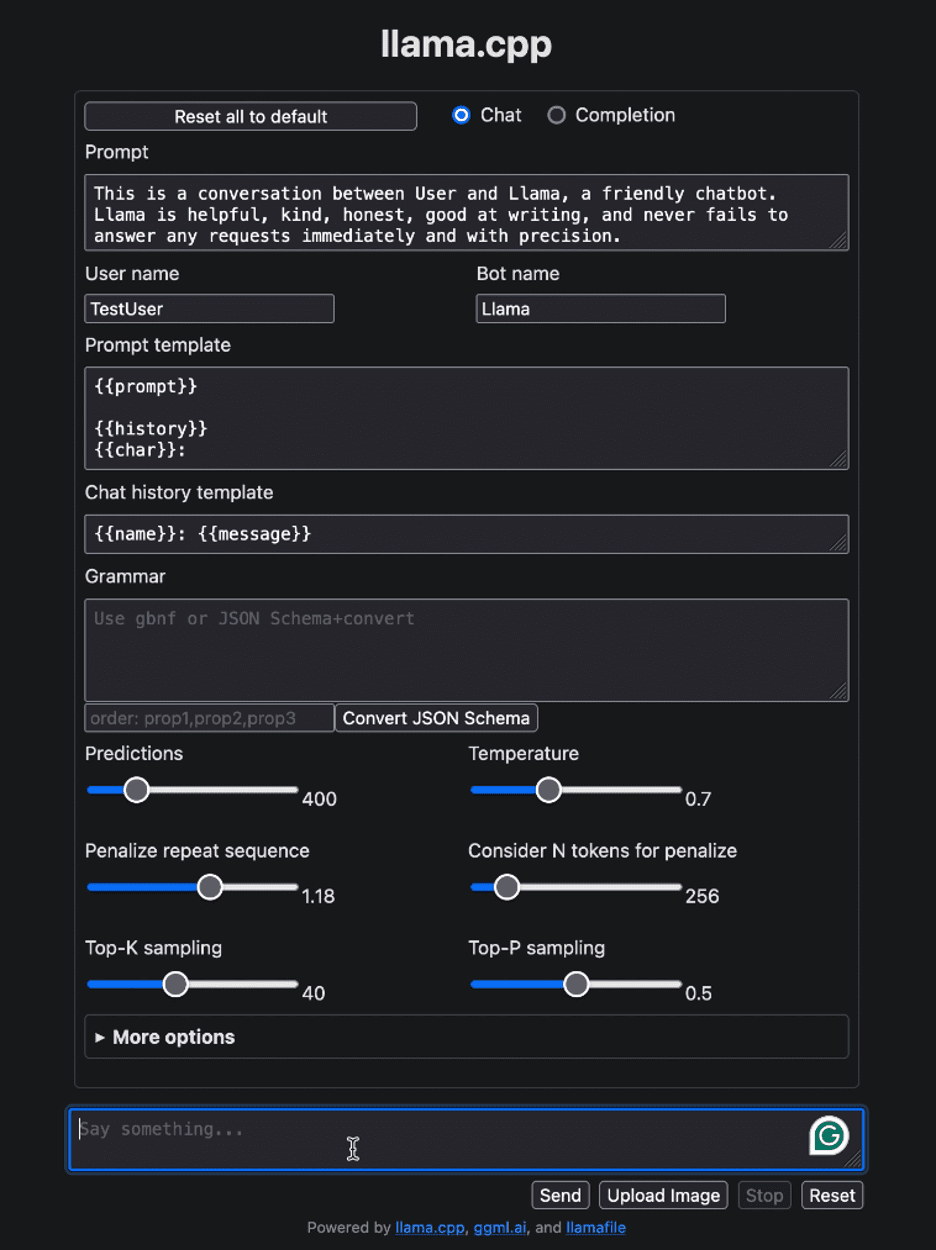

llava-v1.5-7b-q4.llamafile.exe -ngl 9999Dopo aver eseguito il file lama, dovrebbe aprire automaticamente il browser predefinito e visualizzare l'interfaccia utente come mostrato di seguito. In caso contrario, aprire il browser e accedere a http://localhost:8080 manualmente.

Immagine dell'autore

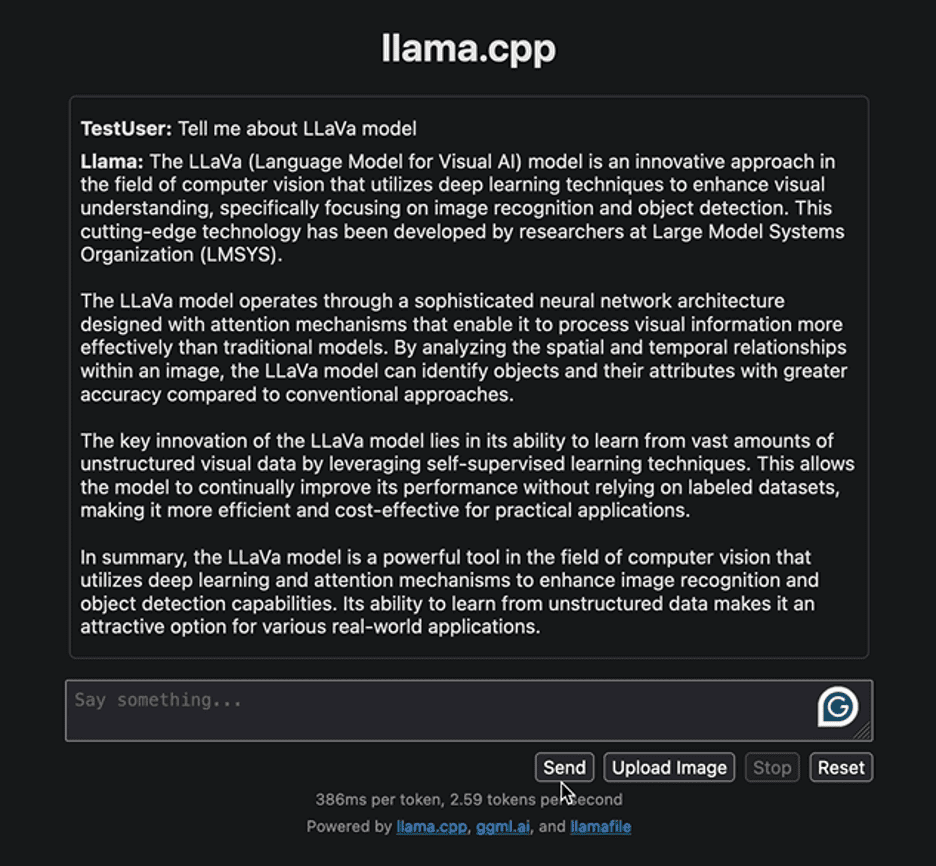

Iniziamo interagendo con l'interfaccia con una semplice domanda per fornire alcune informazioni relative al modello LLaVa. Di seguito è riportata la risposta generata dal modello:

Immagine dell'autore

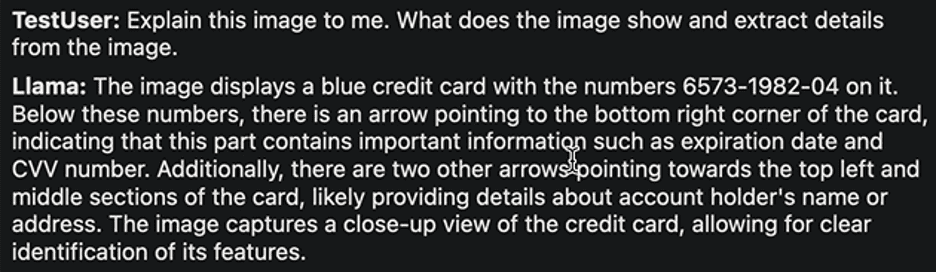

La risposta evidenzia l’approccio allo sviluppo del modello LLaVa e delle sue applicazioni. La risposta generata è stata ragionevolmente veloce. Proviamo a implementare un'altra attività. Caricheremo la seguente immagine di esempio di una carta bancaria con i dettagli su di essa e da essa estrarremo le informazioni richieste.

Immagine di Ruby Thompson

Ecco la risposta:

Immagine dell'autore

Ancora una volta, la risposta è abbastanza ragionevole. Gli autori di LLaVa affermano che raggiunge prestazioni di alto livello in vari compiti. Sentiti libero di esplorare diversi compiti, osservarne i successi e i limiti e sperimentare tu stesso le eccezionali prestazioni di LLaVa.

Una volta completata l'interazione con LLM, puoi chiudere il file lama tornando al terminale e premendo "Control - C".

Distribuire e gestire LLM non è mai stato così semplice. In questo tutorial, abbiamo spiegato con quanta facilità puoi eseguire e sperimentare diversi modelli con un solo file di lama eseguibile. Ciò non solo consente di risparmiare tempo e risorse, ma espande anche l'accessibilità e l'utilità nel mondo reale degli LLM. Ci auguriamo che questo tutorial ti sia stato utile e ci piacerebbe sentire la tua opinione al riguardo. Inoltre, se hai domande o feedback, non esitare a contattarci. Siamo sempre felici di aiutarti e apprezzare il tuo contributo.

Grazie per aver letto!

Kanwal Mehreen Kanwal è un ingegnere di machine learning e uno scrittore tecnico con una profonda passione per la scienza dei dati e l'intersezione dell'intelligenza artificiale con la medicina. È coautrice dell'ebook "Massimizzare la produttività con ChatGPT". In qualità di Google Generation Scholar 2022 per l'APAC, sostiene la diversità e l'eccellenza accademica. È stata anche riconosciuta come Teradata Diversity in Tech Scholar, Mitacs Globalink Research Scholar e Harvard WeCode Scholar. Kanwal è un ardente sostenitore del cambiamento, avendo fondato FEMCodes per dare potere alle donne nei campi STEM.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://www.kdnuggets.com/distribute-and-run-llms-with-llamafile-in-5-simple-steps?utm_source=rss&utm_medium=rss&utm_campaign=distribute-and-run-llms-with-llamafile-in-5-simple-steps