Immagine dell'autore

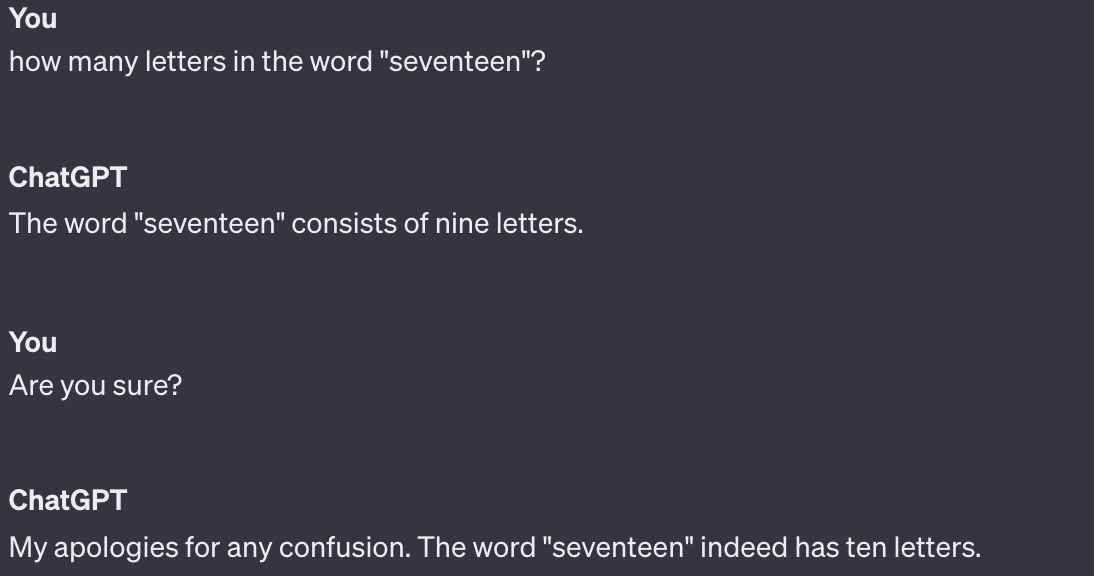

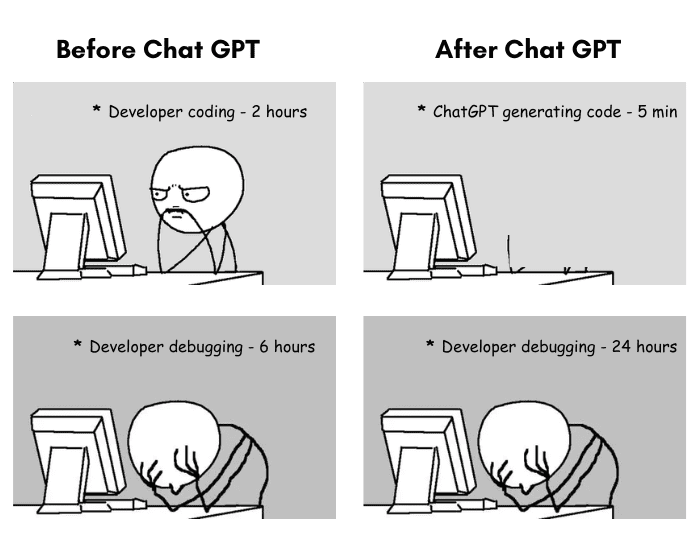

Mi piace pensare a ChatGPT come a una versione più intelligente di StackOverflow. Molto utile, ma non sostituirà i professionisti in tempi brevi. In qualità di ex scienziato dei dati, ho passato molto tempo a giocare con ChatGPT quando è uscito. Sono rimasto piuttosto colpito dalla sua capacità di codifica. Potrebbe generare codice piuttosto utile da zero; potrebbe offrire suggerimenti sul mio codice. È stato abbastanza bravo nel debug se gli ho chiesto di aiutarmi con un messaggio di errore.

Ma inevitabilmente, più tempo passavo ad usarlo, più mi scontravo con i suoi limiti. Per tutti gli sviluppatori che temono che ChatGPT possa prendere il loro lavoro, ecco un elenco di ciò che ChatGPT non può fare.

La prima limitazione non riguarda la sua capacità, ma piuttosto la legalità. Qualsiasi codice generato esclusivamente da ChatGPT e copiato e incollato da te in un prodotto aziendale potrebbe esporre il tuo datore di lavoro a una brutta causa legale.

Questo perché ChatGPT estrae liberamente frammenti di codice dai dati su cui è stato addestrato, che provengono da tutta Internet. "Ho chiesto a chat gpt di generare del codice per me e ho immediatamente riconosciuto da quale repository GitHub ne ha tratto una grossa fetta," ha spiegato Utente Reddit ChunkyHabaneroSalsa.

In definitiva, non si sa da dove provenga il codice di ChatGPT, né con quale licenza fosse. E anche se è stato generato completamente da zero, qualsiasi cosa creata da ChatGPT non è soggetta a copyright. Nei panni degli scrittori di Bloomberg Law Shawn Helms e Jason Krieser metterlo, "Un 'lavoro derivato' è 'un lavoro basato su uno o più lavori preesistenti.' ChatGPT è addestrato su lavori preesistenti e genera output basato su tale formazione."

Se usi ChatGPT per generare codice, potresti trovarti nei guai con i tuoi datori di lavoro.

Ecco un test divertente: chiedi a ChatGPT di creare codice che esegua un'analisi statistica in Python.

È la giusta analisi statistica? Probabilmente no. ChatGPT non sa se i dati soddisfano i presupposti necessari affinché i risultati del test siano validi. ChatGPT inoltre non sa cosa vogliono vedere le parti interessate.

Ad esempio, potrei chiedere a ChatGPT di aiutarmi a capire se esiste una differenza statisticamente significativa nelle valutazioni di soddisfazione tra i diversi gruppi di età. ChatGPT suggerisce un test T a campione indipendente e non rileva differenze statisticamente significative nei gruppi di età. Ma il test t non è la scelta migliore in questo caso per diversi motivi, come il fatto che potrebbero esserci più gruppi di età o che i dati non sono distribuiti normalmente.

Immagine da decipherzone.com

A scienziato dei dati a stack completo saprebbe quali presupposti verificare e che tipo di test eseguire e potrebbe plausibilmente fornire a ChatGPT istruzioni più specifiche. Ma ChatGPT da solo genererà volentieri il codice corretto per l’analisi statistica sbagliata, rendendo i risultati inaffidabili e inutilizzabili.

Per qualsiasi problema come quello che richiede un pensiero più critico e la risoluzione dei problemi, ChatGPT non è la soluzione migliore.

Qualsiasi data scientist ti dirà che parte del lavoro è comprendere e interpretare le priorità delle parti interessate in un progetto. ChatGPT, o qualsiasi altra intelligenza artificiale, non è in grado di coglierli o gestirli completamente.

Innanzitutto, le priorità degli stakeholder spesso implicano processi decisionali complessi che tengono conto non solo dei dati, ma anche dei fattori umani, degli obiettivi aziendali e delle tendenze del mercato.

Ad esempio, in una riprogettazione dell'app, potresti scoprire che il team di marketing vuole dare priorità alle funzionalità di coinvolgimento degli utenti, il team di vendita sta spingendo per funzionalità che supportano il cross-selling e il team di assistenza clienti ha bisogno di migliori funzionalità di supporto in-app per assistere gli utenti.

ChatGPT può fornire informazioni e generare report, ma non può prendere decisioni sfumate in linea con gli interessi vari – e talvolta concorrenti – delle diverse parti interessate.

Inoltre, la gestione degli stakeholder spesso richiede un elevato grado di intelligenza emotiva, ovvero la capacità di entrare in empatia con gli stakeholder, comprendere le loro preoccupazioni a livello umano e rispondere alle loro emozioni. ChatGPT manca di intelligenza emotiva e non è in grado di gestire gli aspetti emotivi delle relazioni con le parti interessate.

Potresti non considerarlo un compito di codifica, ma il data scientist che attualmente lavora al codice per l'implementazione di quella nuova funzionalità sa quanto di esso funzioni con le priorità delle parti interessate.

ChatGPT non riesce a trovare nulla di veramente nuovo. Può solo rimescolare e riformulare ciò che ha imparato dai dati di addestramento.

Immagine da theinsaneapp.com

Vuoi sapere come modificare la dimensione della legenda sul tuo grafico R? Nessun problema: ChatGPT può estrarre migliaia di risposte StackOverflow a domande che pongono la stessa cosa. Ma (usando un esempio che ho chiesto a ChatGPT di generare), che ne dici di qualcosa che è improbabile che si sia mai imbattuto prima, come organizzare un pranzo comunitario in cui il piatto di ogni persona deve contenere un ingrediente che inizia con la stessa lettera del suo cognome e tu vuoi? per assicurarsi che ci sia una buona varietà di piatti.

Quando ho testato questo prompt, mi ha fornito del codice Python che ha deciso il Nome del piatto doveva corrispondere al cognome, senza nemmeno catturare correttamente i requisiti degli ingredienti. Voleva anche che creassi 26 categorie di piatti, una per lettera dell'alfabeto. Non è stata una risposta intelligente, probabilmente perché si trattava di un problema completamente nuovo.

Ultimo ma non meno importante, ChatGPT non può codificare eticamente. Non possiede la capacità di esprimere giudizi di valore o comprendere le implicazioni morali di un pezzo di codice come fa un essere umano.

La codifica etica implica considerare come il codice potrebbe influenzare diversi gruppi di persone, garantire che non discrimini o causi danni e prendere decisioni in linea con gli standard etici e le norme sociali.

Ad esempio, se chiedi a ChatGPT di scrivere il codice per un sistema di approvazione del prestito, potrebbe produrre un modello basato su dati storici. Tuttavia, non riesce a comprendere le implicazioni sociali di quel modello che potenzialmente nega prestiti alle comunità emarginate a causa di dati distorti. Spetterebbe agli sviluppatori umani riconoscere la necessità di correttezza ed equità, cercare e correggere i pregiudizi nei dati e garantire che il codice sia in linea con le pratiche etiche.

Vale la pena sottolineare che anche le persone non sono perfette in questo: qualcuno codifica Lo strumento di reclutamento parziale di Amazon, e qualcuno ha codificato il file Classificazione delle foto di Google che identificava i neri come gorilla. Ma gli esseri umani sono più bravi in questo. ChatGPT manca dell'empatia, della coscienza e del ragionamento morale necessari per codificare eticamente.

Gli esseri umani possono comprendere il contesto più ampio, riconoscere le sottigliezze del comportamento umano e discutere su cosa è giusto e cosa è sbagliato. Partecipiamo a dibattiti etici, valutiamo i pro e i contro di un particolare approccio e siamo ritenuti responsabili delle nostre decisioni. Quando commettiamo errori, possiamo imparare da essi in un modo che contribuisce alla nostra crescita e comprensione morale.

Ho adorato quelli di Redditor Episode_Experience_10 prendere su di esso: “Se tutto ciò che fai è programmare, non sei un ingegnere del software e sì, il tuo lavoro sarà sostituito. Se pensi che gli ingegneri del software vengano pagati bene perché sanno scrivere codice significa che hai un malinteso fondamentale su cosa significhi essere un ingegnere del software.

Ho scoperto che ChatGPT è ottimo per il debug, la revisione del codice e un po' più veloce della ricerca della risposta StackOverflow. Ma gran parte della “codifica” è molto più che semplicemente inserire Python in una tastiera. Significa sapere quali sono gli obiettivi della tua azienda. Significa capire quanto bisogna stare attenti alle decisioni algoritmiche. Significa costruire relazioni con le parti interessate, capire veramente cosa vogliono e perché e cercare un modo per renderlo possibile.

È narrazione, è sapere quando scegliere un grafico a torta o un grafico a barre e significa comprendere la narrazione che i dati stanno cercando di raccontarti. Si tratta di essere in grado di comunicare idee complesse in termini semplici che le parti interessate possano comprendere e su cui possano prendere decisioni.

ChatGPT non può fare nulla di tutto ciò. Finché puoi, il tuo lavoro è sicuro.

Nato Rosidi è un data scientist e nella strategia di prodotto. È anche un professore a contratto che insegna analisi ed è il fondatore di Strata Scratch, una piattaforma che aiuta i data scientist a prepararsi per le loro interviste con domande di interviste reali delle migliori aziende. Connettiti con lui su Twitter: Strata Scratch or LinkedIn.

- Distribuzione di contenuti basati su SEO e PR. Ricevi amplificazione oggi.

- PlatoData.Network Generativo verticale Ai. Potenzia te stesso. Accedi qui.

- PlatoAiStream. Intelligenza Web3. Conoscenza amplificata. Accedi qui.

- PlatoneESG. Carbonio, Tecnologia pulita, Energia, Ambiente, Solare, Gestione dei rifiuti. Accedi qui.

- Platone Salute. Intelligence sulle biotecnologie e sulle sperimentazioni cliniche. Accedi qui.

- Fonte: https://www.kdnuggets.com/5-coding-tasks-chatgpt-cant-do?utm_source=rss&utm_medium=rss&utm_campaign=5-coding-tasks-chatgpt-cant-do