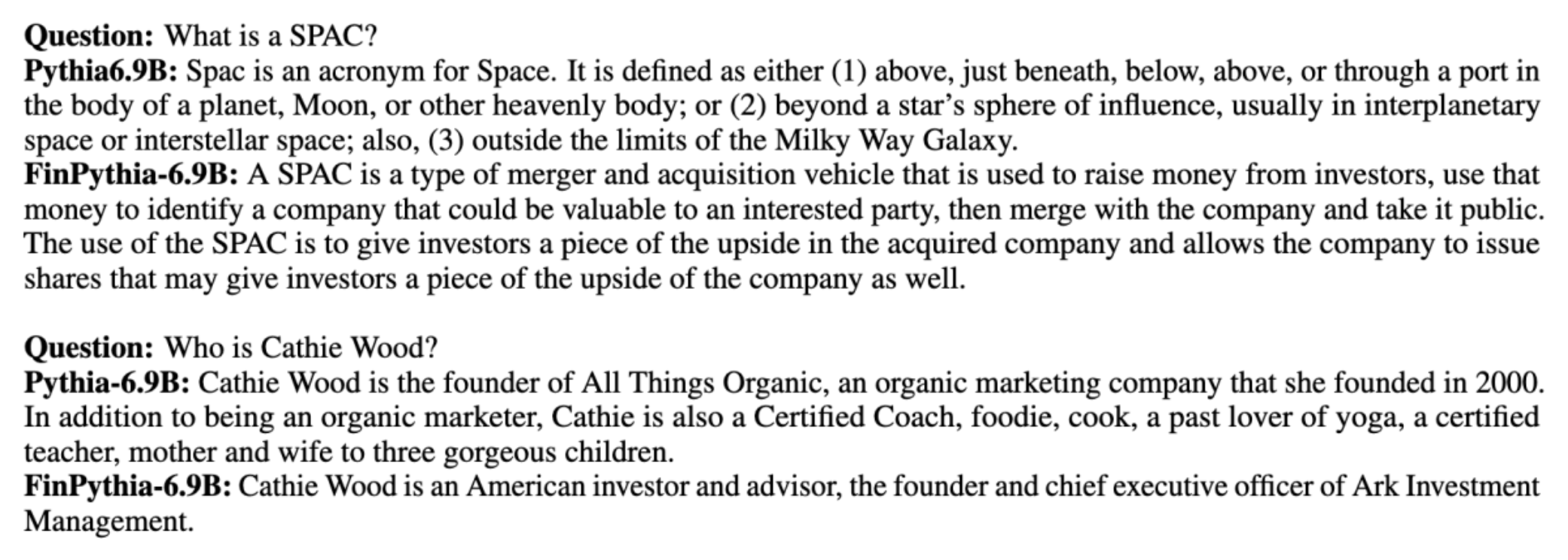

Model bahasa besar (LLM) umumnya dilatih pada kumpulan data besar yang tersedia untuk umum dan bersifat agnostik domain. Misalnya, Llama Meta model dilatih pada kumpulan data seperti Perayapan Umum, C4, Wikipedia, dan ArXiv. Kumpulan data ini mencakup berbagai topik dan domain. Meskipun model yang dihasilkan memberikan hasil yang luar biasa baik untuk tugas umum, seperti pembuatan teks dan pengenalan entitas, terdapat bukti bahwa model yang dilatih dengan kumpulan data khusus domain dapat lebih meningkatkan kinerja LLM. Misalnya data pelatihan yang digunakan untuk BloombergGPT adalah 51% dokumen khusus domain, termasuk berita keuangan, pengarsipan, dan materi keuangan lainnya. LLM yang dihasilkan mengungguli LLM yang dilatih pada kumpulan data non-domain spesifik ketika diuji pada tugas khusus keuangan. Para penulis dari BloombergGPT menyimpulkan bahwa model mereka mengungguli semua model lain yang diuji untuk empat dari lima tugas keuangan. Model ini bahkan memberikan kinerja yang lebih baik ketika diuji untuk tugas keuangan internal Bloomberg dengan selisih yang besar—sebanyak 60 poin lebih baik (dari 100). Meskipun Anda dapat mempelajari lebih lanjut tentang hasil evaluasi komprehensif di kertas, sampel berikut diambil dari BloombergGPT makalah ini dapat memberi Anda gambaran sekilas tentang manfaat pelatihan LLM menggunakan data khusus domain keuangan. Seperti yang ditunjukkan dalam contoh, model BloombergGPT memberikan jawaban yang benar sementara model khusus non-domain lainnya mengalami kesulitan:

Posting ini memberikan panduan untuk melatih LLM khusus untuk domain keuangan. Kami mencakup bidang-bidang utama berikut:

- Pengumpulan dan persiapan data – Panduan dalam mencari dan mengatur data keuangan yang relevan untuk pelatihan model yang efektif

- Pra-pelatihan berkelanjutan vs. penyesuaian – Kapan menggunakan setiap teknik untuk mengoptimalkan kinerja LLM Anda

- Pra-pelatihan berkelanjutan yang efisien – Strategi untuk menyederhanakan proses pra-pelatihan yang berkelanjutan, menghemat waktu dan sumber daya

Postingan ini menyatukan keahlian tim peneliti ilmu terapan dalam Amazon Finance Technology dan tim AWS Worldwide Specialist untuk Industri Keuangan Global. Beberapa konten didasarkan pada makalah Pra-pelatihan Berkelanjutan yang Efisien untuk Membangun Model Bahasa Besar Khusus Domain.

Mengumpulkan dan menyiapkan data keuangan

Pra-pelatihan berkelanjutan domain memerlukan kumpulan data spesifik domain berskala besar, berkualitas tinggi. Berikut ini adalah langkah-langkah utama kurasi dataset domain:

- Identifikasi sumber data – Sumber data potensial untuk korpus domain meliputi web terbuka, Wikipedia, buku, media sosial, dan dokumen internal.

- Filter data domain – Karena tujuan utamanya adalah menyusun korpus domain, Anda mungkin perlu menerapkan langkah tambahan untuk menyaring sampel yang tidak relevan dengan domain target. Hal ini mengurangi corpus yang tidak berguna untuk pra-pelatihan berkelanjutan dan mengurangi biaya pelatihan.

- Pemrosesan awal – Anda dapat mempertimbangkan serangkaian langkah prapemrosesan untuk meningkatkan kualitas data dan efisiensi pelatihan. Misalnya, sumber data tertentu dapat berisi cukup banyak token yang berisik; deduplikasi dianggap sebagai langkah yang berguna untuk meningkatkan kualitas data dan mengurangi biaya pelatihan.

Untuk mengembangkan LLM keuangan, Anda dapat menggunakan dua sumber data penting: News CommonCrawl dan pengajuan SEC. Pengajuan SEC adalah laporan keuangan atau dokumen formal lainnya yang diserahkan ke Komisi Sekuritas dan Bursa AS (SEC). Perusahaan publik wajib mengajukan berbagai dokumen secara berkala. Hal ini menciptakan sejumlah besar dokumen selama bertahun-tahun. News CommonCrawl adalah kumpulan data yang dirilis oleh CommonCrawl pada tahun 2016. Ini berisi artikel berita dari situs berita di seluruh dunia.

Berita CommonCrawl tersedia di Layanan Penyimpanan Sederhana Amazon (Amazon S3) di commoncrawl ember di crawl-data/CC-NEWS/. Anda bisa mendapatkan daftar file menggunakan Antarmuka Baris Perintah AWS (AWS CLI) dan perintah berikut:

In Pra-pelatihan Berkelanjutan yang Efisien untuk Membangun Model Bahasa Besar Khusus Domain, penulis menggunakan pendekatan berbasis URL dan kata kunci untuk menyaring artikel berita keuangan dari berita umum. Secara khusus, penulis menyimpan daftar outlet berita keuangan penting dan serangkaian kata kunci yang terkait dengan berita keuangan. Kami mengidentifikasi artikel sebagai berita keuangan jika artikel tersebut berasal dari outlet berita keuangan atau kata kunci apa pun yang muncul di URL. Pendekatan sederhana namun efektif ini memungkinkan Anda mengidentifikasi berita keuangan tidak hanya dari outlet berita keuangan tetapi juga bagian keuangan dari outlet berita umum.

Pengajuan SEC tersedia online melalui database EDGAR (Electronic Data Gathering, Analysis, and Retrieval) SEC, yang menyediakan akses data terbuka. Anda dapat mengambil pengajuan dari EDGAR secara langsung, atau menggunakan API di dalamnya Amazon SageMaker dengan beberapa baris kode, untuk jangka waktu tertentu dan untuk sejumlah besar ticker (yaitu, pengidentifikasi yang ditetapkan SEC). Untuk mempelajari lebih lanjut, lihat Pengambilan Pengarsipan SEC.

Tabel berikut merangkum detail utama dari kedua sumber data.

| . | Berita Perayapan Umum | Pengarsipan SEC |

| Liputan | 2016-2022 | 1993-2022 |

| Ukuran | 25.8 miliar kata | 5.1 miliar kata |

Penulis melakukan beberapa langkah pra-pemrosesan tambahan sebelum data dimasukkan ke dalam algoritma pelatihan. Pertama, kami mengamati bahwa pengajuan SEC mengandung teks yang berisik karena penghapusan tabel dan gambar, sehingga penulis menghapus kalimat pendek yang dianggap sebagai label tabel atau gambar. Kedua, kami menerapkan algoritma hashing yang sensitif terhadap lokalitas untuk menghapus duplikat artikel dan pengajuan baru. Untuk pengajuan SEC, kami menghapus duplikatnya di tingkat bagian, bukan di tingkat dokumen. Terakhir, kami menggabungkan dokumen menjadi string yang panjang, melakukan tokenisasi, dan membagi tokenisasi menjadi beberapa bagian dengan panjang input maksimal yang didukung oleh model yang akan dilatih. Hal ini meningkatkan hasil pra-pelatihan berkelanjutan dan mengurangi biaya pelatihan.

Pra-pelatihan berkelanjutan vs. penyesuaian

Sebagian besar LLM yang tersedia bertujuan umum dan tidak memiliki kemampuan khusus domain. LLM domain telah menunjukkan kinerja yang luar biasa dalam bidang medis, keuangan, atau ilmiah. Agar LLM memperoleh pengetahuan khusus domain, ada empat metode: pelatihan dari awal, pra-pelatihan berkelanjutan, penyesuaian instruksi pada tugas domain, dan Retrieval Augmented Generation (RAG).

Dalam model tradisional, penyesuaian biasanya digunakan untuk membuat model khusus tugas untuk suatu domain. Ini berarti mempertahankan beberapa model untuk berbagai tugas seperti ekstraksi entitas, klasifikasi maksud, analisis sentimen, atau menjawab pertanyaan. Dengan munculnya LLM, kebutuhan untuk mempertahankan model terpisah sudah tidak berlaku lagi karena menggunakan teknik seperti pembelajaran dalam konteks atau prompting. Hal ini menghemat upaya yang diperlukan untuk memelihara tumpukan model untuk tugas yang terkait namun berbeda.

Secara intuitif, Anda dapat melatih LLM dari awal dengan data khusus domain. Meskipun sebagian besar pekerjaan untuk membuat LLM domain berfokus pada pelatihan dari awal, biayanya sangat mahal. Misalnya, model GPT-4 berharga lebih dari $ 100 juta untuk melatih. Model ini dilatih pada gabungan data domain terbuka dan data domain. Prapelatihan berkelanjutan dapat membantu model memperoleh pengetahuan khusus domain tanpa menimbulkan biaya prapelatihan dari awal karena Anda melakukan prapelatihan LLM domain terbuka yang ada hanya pada data domain.

Dengan penyempurnaan instruksi pada suatu tugas, Anda tidak dapat membuat model memperoleh pengetahuan domain karena LLM hanya memperoleh informasi domain yang terkandung dalam kumpulan data penyempurnaan instruksi. Kecuali jika kumpulan data yang sangat besar digunakan untuk menyempurnakan instruksi, hal tersebut tidak cukup untuk memperoleh pengetahuan domain. Mendapatkan kumpulan data instruksi berkualitas tinggi biasanya merupakan tantangan dan merupakan alasan untuk menggunakan LLM. Selain itu, penyempurnaan instruksi pada satu tugas dapat memengaruhi kinerja pada tugas lainnya (seperti terlihat pada gambar kertas ini). Namun, penyesuaian instruksi lebih hemat biaya dibandingkan alternatif pra-pelatihan.

Gambar berikut membandingkan penyesuaian khusus tugas tradisional. vs paradigma pembelajaran dalam konteks dengan LLM.

RAG adalah cara paling efektif untuk memandu LLM untuk menghasilkan respons yang didasarkan pada suatu domain. Meskipun dapat memandu model untuk menghasilkan respons dengan memberikan fakta dari domain sebagai informasi tambahan, model tersebut tidak memperoleh bahasa khusus domain karena LLM masih mengandalkan gaya bahasa non-domain untuk menghasilkan respons.

RAG adalah cara paling efektif untuk memandu LLM untuk menghasilkan respons yang didasarkan pada suatu domain. Meskipun dapat memandu model untuk menghasilkan respons dengan memberikan fakta dari domain sebagai informasi tambahan, model tersebut tidak memperoleh bahasa khusus domain karena LLM masih mengandalkan gaya bahasa non-domain untuk menghasilkan respons.

Pra-pelatihan berkelanjutan adalah jalan tengah antara pra-pelatihan dan penyesuaian instruksi dalam hal biaya sekaligus menjadi alternatif yang kuat untuk memperoleh pengetahuan dan gaya khusus domain. Ini dapat memberikan model umum di mana penyempurnaan instruksi lebih lanjut pada data instruksi terbatas dapat dilakukan. Pra-pelatihan yang berkelanjutan dapat menjadi strategi yang hemat biaya untuk domain khusus yang kumpulan tugas hilirnya besar atau tidak diketahui dan data penyetelan instruksi berlabel terbatas. Dalam skenario lain, penyempurnaan instruksi atau RAG mungkin lebih cocok.

Untuk mempelajari lebih lanjut tentang penyesuaian, RAG, dan pelatihan model, lihat Menyempurnakan model fondasi, Pengambilan Augmented Generation (RAG), dan Latih Model dengan Amazon SageMaker, masing-masing. Untuk posting ini, kami fokus pada pra-pelatihan berkelanjutan yang efisien.

Metodologi pra-pelatihan berkelanjutan yang efisien

Pra-pelatihan berkelanjutan terdiri dari metodologi berikut:

- Pra-pelatihan Berkelanjutan Adaptif Domain (DACP) – Di koran Pra-pelatihan Berkelanjutan yang Efisien untuk Membangun Model Bahasa Besar Khusus Domain, penulis terus melatih rangkaian model bahasa Pythia pada korpus keuangan untuk menyesuaikannya dengan domain keuangan. Tujuannya adalah untuk menciptakan LLM keuangan dengan memasukkan data dari seluruh domain keuangan ke dalam model sumber terbuka. Karena korpus pelatihan berisi semua kumpulan data yang dikurasi dalam domain tersebut, model yang dihasilkan harus memperoleh pengetahuan khusus keuangan, sehingga menjadi model serbaguna untuk berbagai tugas keuangan. Ini menghasilkan model FinPythia.

- Pra-pelatihan Berkelanjutan yang Adaptif Tugas (TACP) – Penulis melakukan pra-latihan model lebih lanjut pada data tugas berlabel dan tidak berlabel guna menyesuaikannya untuk tugas tertentu. Dalam keadaan tertentu, pengembang mungkin lebih memilih model yang memberikan performa lebih baik pada sekelompok tugas dalam domain daripada model umum domain. TACP dirancang sebagai pra-pelatihan berkelanjutan yang bertujuan untuk meningkatkan kinerja pada tugas-tugas yang ditargetkan, tanpa persyaratan untuk data berlabel. Secara khusus, penulis terus melakukan pra-pelatihan model sumber terbuka pada token tugas (tanpa label). Keterbatasan utama TACP terletak pada pembuatan LLM khusus tugas, bukan LLM dasar, karena hanya menggunakan data tugas yang tidak berlabel untuk pelatihan. Meskipun DACP menggunakan korpus yang jauh lebih besar, biayanya sangat mahal. Untuk menyeimbangkan keterbatasan ini, penulis mengusulkan dua pendekatan yang bertujuan untuk membangun LLM landasan khusus domain sambil mempertahankan kinerja unggul pada tugas-tugas target:

- DACP Serupa Tugas yang Efisien (ETS-DACP) – Penulis mengusulkan untuk memilih subset korpus keuangan yang sangat mirip dengan data tugas menggunakan kesamaan penyematan. Subset ini digunakan untuk pra-pelatihan berkelanjutan agar lebih efisien. Secara khusus, penulis terus melakukan pra-pelatihan LLM sumber terbuka pada korpus kecil yang diambil dari korpus keuangan yang dekat dengan target tugas dalam distribusi. Hal ini dapat membantu meningkatkan kinerja tugas karena kami mengadopsi model tersebut pada distribusi token tugas meskipun data berlabel tidak diperlukan.

- DACP Agnostik Tugas yang Efisien (ETA-DACP) – Penulis mengusulkan penggunaan metrik seperti kebingungan dan entropi tipe token yang tidak memerlukan data tugas untuk memilih sampel dari korpus keuangan untuk pra-pelatihan berkelanjutan yang efisien. Pendekatan ini dirancang untuk menangani skenario ketika data tugas tidak tersedia atau model domain yang lebih serbaguna untuk domain yang lebih luas lebih disukai. Penulis mengadopsi dua dimensi untuk memilih sampel data yang penting untuk memperoleh informasi domain dari subkumpulan data domain pra-pelatihan: kebaruan dan keragaman. Kebaruan, diukur dengan kebingungan yang dicatat oleh model target, mengacu pada informasi yang belum pernah dilihat oleh LLM sebelumnya. Data dengan kebaruan yang tinggi menunjukkan pengetahuan baru untuk LLM, dan data tersebut dipandang lebih sulit untuk dipelajari. Ini memperbarui LLM generik dengan pengetahuan domain intensif selama pra-pelatihan berkelanjutan. Diversity, di sisi lain, menangkap keragaman distribusi tipe token dalam domain corpus, yang telah didokumentasikan sebagai fitur yang berguna dalam penelitian pembelajaran kurikulum tentang pemodelan bahasa.

Gambar berikut membandingkan contoh ETS-DACP (kiri) vs. ETA-DACP (kanan).

Kami mengadopsi dua skema pengambilan sampel untuk secara aktif memilih titik data dari korpus keuangan yang dikurasi: pengambilan sampel keras dan pengambilan sampel lunak. Yang pertama dilakukan dengan pertama-tama memberi peringkat pada korpus keuangan berdasarkan metrik yang sesuai dan kemudian memilih sampel k teratas, di mana k telah ditentukan sebelumnya sesuai dengan anggaran pelatihan. Untuk yang terakhir, penulis menetapkan bobot pengambilan sampel untuk setiap titik data sesuai dengan nilai metrik, dan kemudian secara acak mengambil sampel sebanyak k titik data untuk memenuhi anggaran pelatihan.

Hasil dan analisis

Para penulis mengevaluasi LLM keuangan yang dihasilkan berdasarkan serangkaian tugas keuangan untuk menyelidiki kemanjuran pra-pelatihan berkelanjutan:

- Bank Frase Keuangan – Tugas klasifikasi sentimen pada berita keuangan.

- FiQA SA – Tugas klasifikasi sentimen berdasarkan aspek berdasarkan berita dan berita utama keuangan.

- Membintangi – Tugas klasifikasi biner mengenai apakah judul suatu entitas keuangan berisi informasi tertentu.

- APM – Tugas ekstraksi entitas bernama keuangan berdasarkan bagian penilaian risiko kredit dalam laporan SEC. Kata-kata dalam tugas ini dianotasi dengan PER, LOC, ORG, dan MISC.

Karena LLM keuangan adalah instruksi yang disesuaikan, penulis mengevaluasi model dalam pengaturan 5-shot untuk setiap tugas demi ketahanan. Rata-rata, FinPythia 6.9B mengungguli Pythia 6.9B sebesar 10% dalam empat tugas, yang menunjukkan kemanjuran pra-pelatihan berkelanjutan khusus domain. Untuk model 1B, peningkatannya tidak terlalu besar, namun performa masih meningkat rata-rata 2%.

Gambar berikut menggambarkan perbedaan performa sebelum dan sesudah DACP pada kedua model.

Gambar berikut menunjukkan dua contoh kualitatif yang dihasilkan oleh Pythia 6.9B dan FinPythia 6.9B. Untuk dua pertanyaan terkait keuangan mengenai manajer investor dan istilah keuangan, Pythia 6.9B tidak memahami istilah tersebut atau mengenali namanya, sedangkan FinPythia 6.9B menghasilkan jawaban terperinci dengan benar. Contoh kualitatif menunjukkan bahwa pra-pelatihan yang berkelanjutan memungkinkan LLM memperoleh pengetahuan domain selama proses berlangsung.

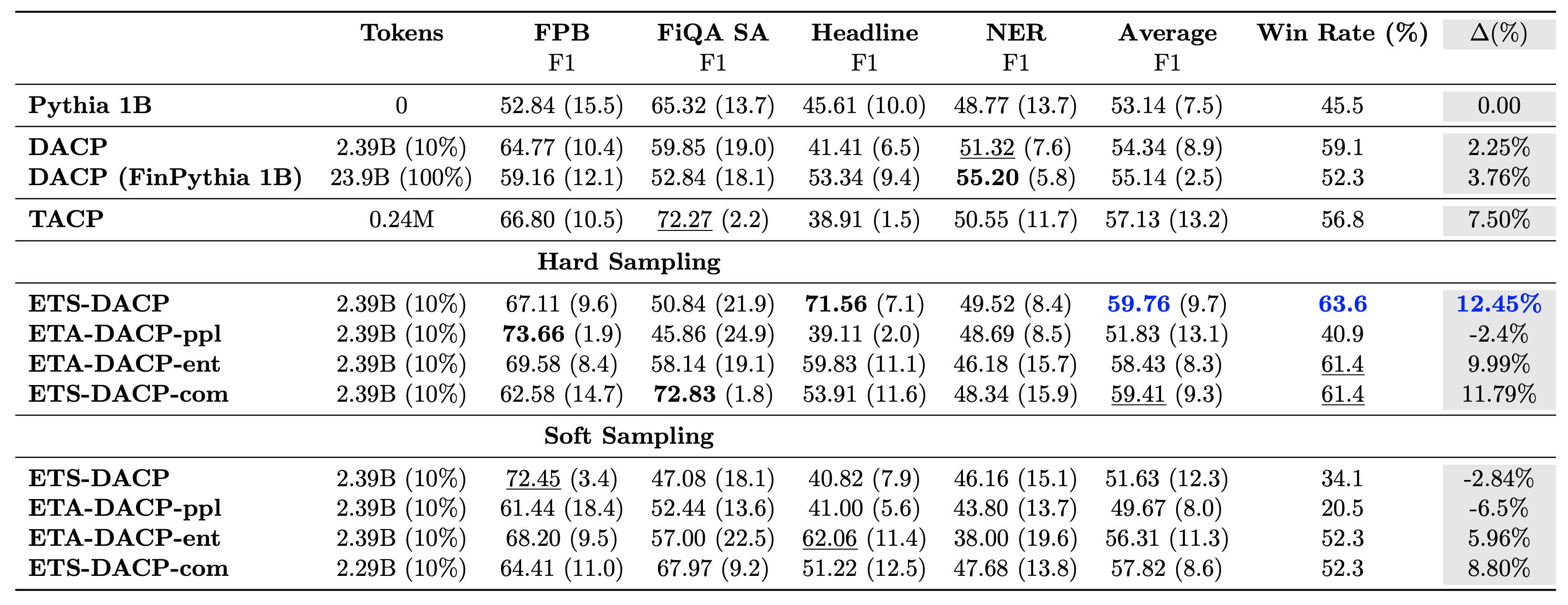

Tabel berikut membandingkan berbagai pendekatan pra-pelatihan berkelanjutan yang efisien. ETA-DACP-ppl adalah ETA-DACP berdasarkan kebingungan (kebaruan), dan ETA-DACP-ent didasarkan pada entropi (keanekaragaman). ETS-DACP-com mirip dengan DACP dengan pemilihan data dengan rata-rata ketiga metrik. Berikut adalah beberapa kesimpulan dari hasilnya:

- Metode pemilihan data efisien – Mereka melampaui standar pra-pelatihan berkelanjutan dengan hanya 10% data pelatihan. Pra-pelatihan berkelanjutan yang efisien termasuk Task-Similar DACP (ETS-DACP), Task-Agnostic DACP berdasarkan entropi (ESA-DACP-ent) dan Task-Similar DACP berdasarkan ketiga metrik (ETS-DACP-com) mengungguli DACP standar rata-rata meskipun faktanya mereka hanya dilatih pada 10% korpus keuangan.

- Pemilihan data yang sadar akan tugas bekerja paling baik sejalan dengan penelitian model bahasa kecil – ETS-DACP mencatat kinerja rata-rata terbaik di antara semua metode dan, berdasarkan ketiga metrik, mencatat kinerja tugas terbaik kedua. Hal ini menunjukkan bahwa penggunaan data tugas yang tidak berlabel masih merupakan pendekatan yang efektif untuk meningkatkan kinerja tugas dalam kasus LLM.

- Pemilihan data tanpa tugas berada di urutan kedua – ESA-DACP-ent mengikuti kinerja pendekatan pemilihan data sadar tugas, yang menyiratkan bahwa kami masih dapat meningkatkan kinerja tugas dengan secara aktif memilih sampel berkualitas tinggi yang tidak terikat pada tugas tertentu. Hal ini membuka jalan untuk membangun LLM keuangan untuk seluruh domain sekaligus mencapai kinerja tugas yang unggul.

Salah satu pertanyaan penting mengenai pra-pelatihan berkelanjutan adalah apakah hal itu berdampak negatif terhadap kinerja tugas-tugas non-domain. Penulis juga mengevaluasi model yang telah dilatih sebelumnya secara terus-menerus pada empat tugas umum yang banyak digunakan: ARC, MMLU, TruthQA, dan HellaSwag, yang mengukur kemampuan menjawab pertanyaan, penalaran, dan penyelesaian. Para penulis menemukan bahwa pra-pelatihan yang berkelanjutan tidak berdampak buruk terhadap kinerja non-domain. Untuk lebih jelasnya, lihat Pra-pelatihan Berkelanjutan yang Efisien untuk Membangun Model Bahasa Besar Khusus Domain.

Kesimpulan

Posting ini menawarkan wawasan tentang pengumpulan data dan strategi pra-pelatihan berkelanjutan untuk pelatihan LLM untuk domain keuangan. Anda dapat mulai melatih LLM Anda sendiri untuk tugas keuangan menggunakan Pelatihan Amazon SageMaker or Batuan Dasar Amazon hari ini.

Tentang Penulis

Yong Xie adalah ilmuwan terapan di Amazon FinTech. Dia berfokus pada pengembangan model bahasa besar dan aplikasi AI Generatif untuk keuangan.

Yong Xie adalah ilmuwan terapan di Amazon FinTech. Dia berfokus pada pengembangan model bahasa besar dan aplikasi AI Generatif untuk keuangan.

Karan Aggarwal adalah Ilmuwan Terapan Senior di Amazon FinTech dengan fokus pada AI Generatif untuk kasus penggunaan keuangan. Karan memiliki pengalaman luas dalam analisis deret waktu dan NLP, dengan minat khusus untuk belajar dari data berlabel terbatas

Karan Aggarwal adalah Ilmuwan Terapan Senior di Amazon FinTech dengan fokus pada AI Generatif untuk kasus penggunaan keuangan. Karan memiliki pengalaman luas dalam analisis deret waktu dan NLP, dengan minat khusus untuk belajar dari data berlabel terbatas

Aitzaz Ahmad adalah Manajer Sains Terapan di Amazon yang memimpin tim ilmuwan yang membangun berbagai aplikasi Pembelajaran Mesin dan AI Generatif di bidang Keuangan. Minat penelitiannya adalah pada NLP, Generative AI, dan LLM Agents. Ia menerima gelar PhD di bidang Teknik Elektro dari Texas A&M University.

Aitzaz Ahmad adalah Manajer Sains Terapan di Amazon yang memimpin tim ilmuwan yang membangun berbagai aplikasi Pembelajaran Mesin dan AI Generatif di bidang Keuangan. Minat penelitiannya adalah pada NLP, Generative AI, dan LLM Agents. Ia menerima gelar PhD di bidang Teknik Elektro dari Texas A&M University.

Qing Wei Li adalah Spesialis Pembelajaran Mesin di Amazon Web Services. Ia menerima gelar Ph.D. dalam Riset Operasi setelah dia merusak rekening hibah penelitian penasihatnya dan gagal memberikan Hadiah Nobel yang dia janjikan. Saat ini dia membantu pelanggan di bidang layanan keuangan membangun solusi pembelajaran mesin di AWS.

Qing Wei Li adalah Spesialis Pembelajaran Mesin di Amazon Web Services. Ia menerima gelar Ph.D. dalam Riset Operasi setelah dia merusak rekening hibah penelitian penasihatnya dan gagal memberikan Hadiah Nobel yang dia janjikan. Saat ini dia membantu pelanggan di bidang layanan keuangan membangun solusi pembelajaran mesin di AWS.

Raghvender Arni memimpin Tim Akselerasi Pelanggan (CAT) dalam AWS Industries. CAT adalah tim lintas fungsi global yang terdiri dari arsitek cloud, insinyur perangkat lunak, ilmuwan data, serta pakar dan desainer AI/ML yang melayani pelanggan dan mendorong inovasi melalui pembuatan prototipe tingkat lanjut, dan mendorong keunggulan operasional cloud melalui keahlian teknis khusus.

Raghvender Arni memimpin Tim Akselerasi Pelanggan (CAT) dalam AWS Industries. CAT adalah tim lintas fungsi global yang terdiri dari arsitek cloud, insinyur perangkat lunak, ilmuwan data, serta pakar dan desainer AI/ML yang melayani pelanggan dan mendorong inovasi melalui pembuatan prototipe tingkat lanjut, dan mendorong keunggulan operasional cloud melalui keahlian teknis khusus.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/efficient-continual-pre-training-llms-for-financial-domains/