Perlombaan untuk mendapatkan model kecerdasan buatan yang lebih besar telah menjadi ciri kemajuan terkini. Namun, Microsoft mengubah segalanya dengan Phi-3 Mini, model AI yang menawarkan kemampuan mengesankan meskipun ukurannya kompak.

Secara tradisional, keberhasilan dalam model bahasa besar (LLM) dikaitkan dengan sejumlah parameter – yang pada dasarnya merupakan elemen penyusun yang menginformasikan pemahaman model terhadap bahasa.

Dengan mempertimbangkan biaya komputasi dan ketersediaan untuk semua orang, Microsoft Phi-3 hadir untuk mengubah pendekatan “tradisional” ini.

Microsoft Phi-3 Mini sangat cocok untuk dimasukkan ke dalam saku Anda

GPT-3.5, yang terdepan dalam perlombaan LLM saat ini, menawarkan 175 miliar parameter yang mengejutkan. Jumlah yang sangat besar ini memungkinkan GPT-3.5 memproses data teks dalam jumlah besar, sehingga memberikan pemahaman bahasa yang luas dan beragam. Namun, kompleksitas ini juga memerlukan biaya. Menjalankan model dengan jumlah parameter yang tinggi memerlukan sumber daya komputasi yang besar, sehingga mahal dan boros daya.

Model mini Microsoft, sebaliknya, mengambil pendekatan yang berbeda. Dengan memanfaatkan serangkaian parameter yang jauh lebih kecil – hanya 3.8 miliar – Phi-3 Mini beroperasi dengan tingkat efisiensi yang jauh lebih besar dibandingkan dengan parameter yang lebih besar. Pengurangan ukuran ini menghasilkan beberapa keuntungan.

Semua ini membuat Microsoft Phi-3:

- Jauh lebih murah untuk dijalankan

- Potensi pembangkit tenaga listrik untuk aplikasi AI pada perangkat

Regimen pelatihan Phi-3 Mini

Aspek menarik lainnya dari Phi-3 Mini adalah metode pelatihannya.

Tidak seperti rekan-rekannya yang lebih besar yang dilatih dengan kumpulan data teks dan kode yang sangat besar, pendidikan Phi-3 Mini melibatkan seleksi yang lebih terkurasi. Para peneliti memilih kurikulum yang terinspirasi oleh cara anak-anak belajar – dengan menggunakan buku anak-anak sebagai landasan.

Pendekatan ini tampaknya membuahkan hasil positif, dengan Phi-3 Mini menunjukkan kinerja yang menyaingi GPT-3.5 pada beberapa tolak ukur.

Diukur untuk sukses

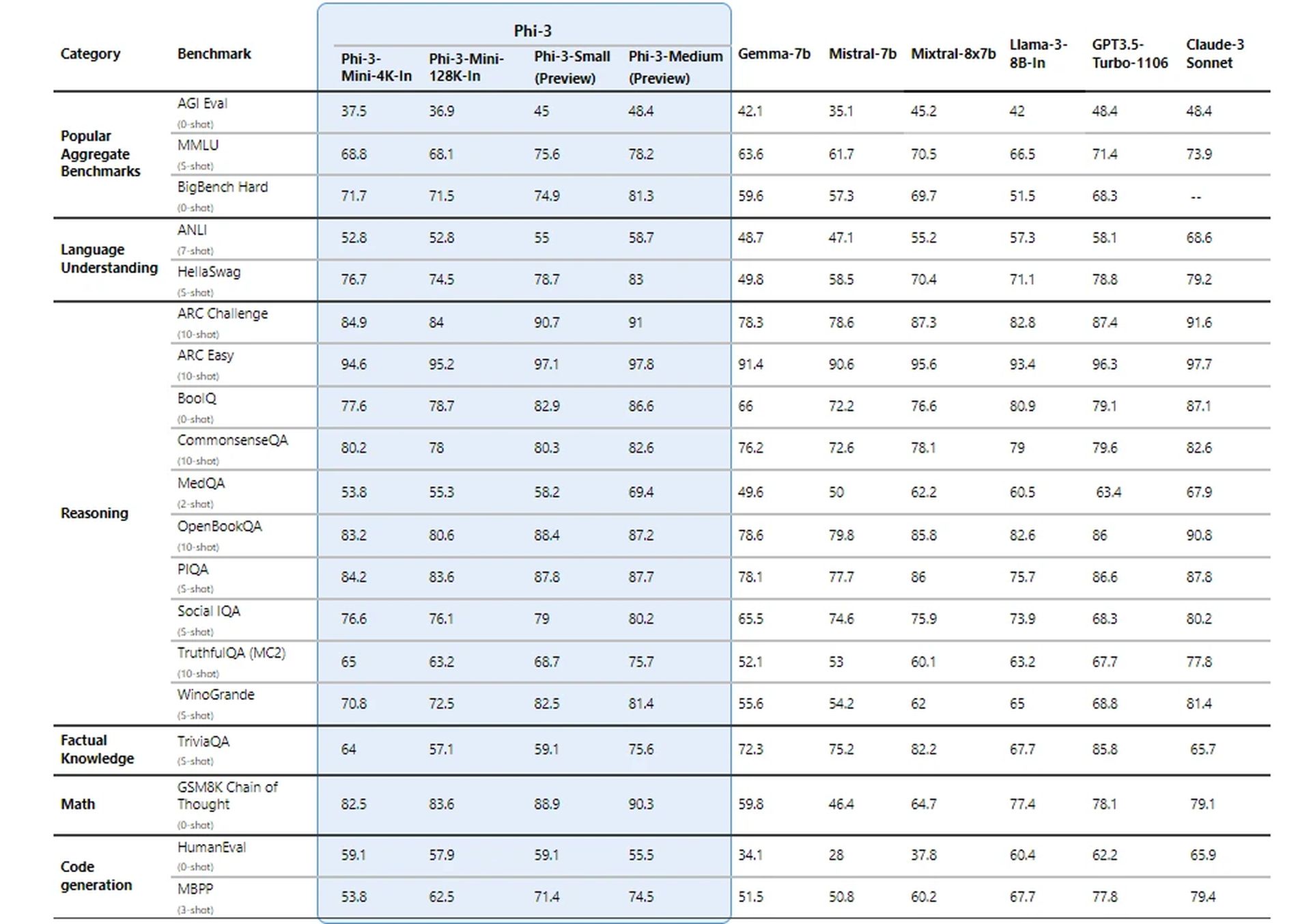

Peneliti Microsoft menguji model barunya dengan menggunakan tolok ukur yang telah ditetapkan untuk LLM. Model ini mencapai skor yang mengesankan pada metrik seperti MMLU (ukuran kemampuan model untuk memahami hubungan kompleks dalam bahasa) dan MT-bench (tes untuk kemampuan terjemahan mesin).

Hasil ini menunjukkan bahwa Phi-3 Mini, meskipun berukuran besar, dapat bersaing dengan nama-nama besar di game LLM.

Bagaimana cara mencapai hasil yang mengesankan?

Detail teknis Phi-3 Mini mengungkapkan pendekatan menarik untuk mencapai hasil yang mengesankan dengan ukuran model yang sangat kecil. Berikut rincian aspek-aspek utamanya:

Arsitektur dekoder transformator

Phi-3 Mini menggunakan arsitektur decoder transformator, pilihan desain umum untuk model bahasa yang efektif. Arsitektur ini unggul dalam memproses data berurutan seperti teks, memungkinkan model memahami hubungan antar kata dalam sebuah kalimat.

Panjang konteks

Phi-3 Mini standar beroperasi dengan panjang konteks 4,000 token. Ini menentukan jumlah maksimum token (kata atau bagian kata) yang dipertimbangkan model saat membuat teks. Konteks yang lebih panjang memungkinkan pemahaman yang lebih mendalam tentang percakapan sebelumnya, namun juga memerlukan kekuatan pemrosesan yang lebih besar.

Versi konteks panjang (Phi-3-Mini-128K)

Untuk tugas yang memerlukan konteks lebih luas, tersedia varian yang disebut Phi-3-Mini-128K. Versi ini memperluas panjang konteks hingga 128,000 token, memungkinkannya menangani rangkaian informasi yang lebih kompleks.

Kompatibilitas dengan alat yang ada

Untuk memberi manfaat bagi komunitas pengembang, Phi-3 Mini memiliki struktur dan ukuran kosakata yang serupa (320,641) dengan keluarga model Llama-2. Kompatibilitas ini memungkinkan pengembang untuk memanfaatkan alat dan perpustakaan yang dirancang untuk Llama-2 saat bekerja dengan Phi-3 Mini.

Parameter model

Di sinilah Phi-3 Mini benar-benar bersinar. Dengan hanya 3.072 miliar parameter, ia beroperasi jauh di bawah angka mengejutkan yang terlihat pada model yang lebih besar seperti GPT-3.5 (175 miliar parameter).

Pengurangan parameter yang signifikan ini menghasilkan efisiensi luar biasa dalam hal daya pemrosesan dan penggunaan memori.

Saif Naik dari Microsoft menjelaskan:

“Tujuan kami dengan kopilot Krishi Mitra adalah untuk meningkatkan efisiensi sekaligus menjaga keakuratan model bahasa besar. Kami sangat antusias untuk bermitra dengan Microsoft dalam menggunakan versi Phi-3 yang telah disempurnakan untuk memenuhi tujuan kami—efisiensi dan akurasi!”

– Saif Naik, Kepala Teknologi, ITCMAARS

Metodologi pelatihan

Pelatihan Phi-3 Mini mengambil inspirasi dari pendekatan “Hanya Buku Teks yang Anda Butuhkan”. Metode ini menekankan data pelatihan berkualitas tinggi daripada sekadar meningkatkan ukuran model. Data pelatihan dikurasi dengan cermat, dengan fokus pada sumber web dengan “tingkat pendidikan” tertentu dan data sintetis yang dihasilkan oleh LLM lain.

Strategi ini memungkinkan Phi-3 Mini mencapai hasil yang mengesankan meskipun ukurannya kompak.

Pemfilteran data untuk pembelajaran optimal

Tidak seperti pendekatan tradisional yang memprioritaskan sumber daya komputasi atau pelatihan berlebihan, Phi-3 Mini berfokus pada “rezim data optimal” untuk ukurannya. Hal ini melibatkan pemfilteran data web secara cermat untuk memastikan data tersebut berisi tingkat “pengetahuan” yang tepat dan meningkatkan keterampilan penalaran.

Misalnya, data olahraga umum mungkin dikecualikan untuk memprioritaskan informasi yang meningkatkan kemampuan berpikir model.

Penyempurnaan pasca pelatihan

Setelah proses pelatihan inti, model baru ini mengalami penyempurnaan tambahan melalui penyempurnaan terawasi (SFT) dan optimalisasi preferensi langsung (DPO). SFT memaparkan model pada data yang dikurasi di berbagai domain, termasuk matematika, pengkodean, dan prinsip keselamatan. DPO membantu menjauhkan model dari perilaku yang tidak diinginkan dengan mengidentifikasi dan mengecualikan keluaran yang tidak diinginkan.

Fase pasca-pelatihan ini mengubah Phi-3 Mini dari model bahasa menjadi asisten AI yang serbaguna dan aman.

Performa pada perangkat yang efisien

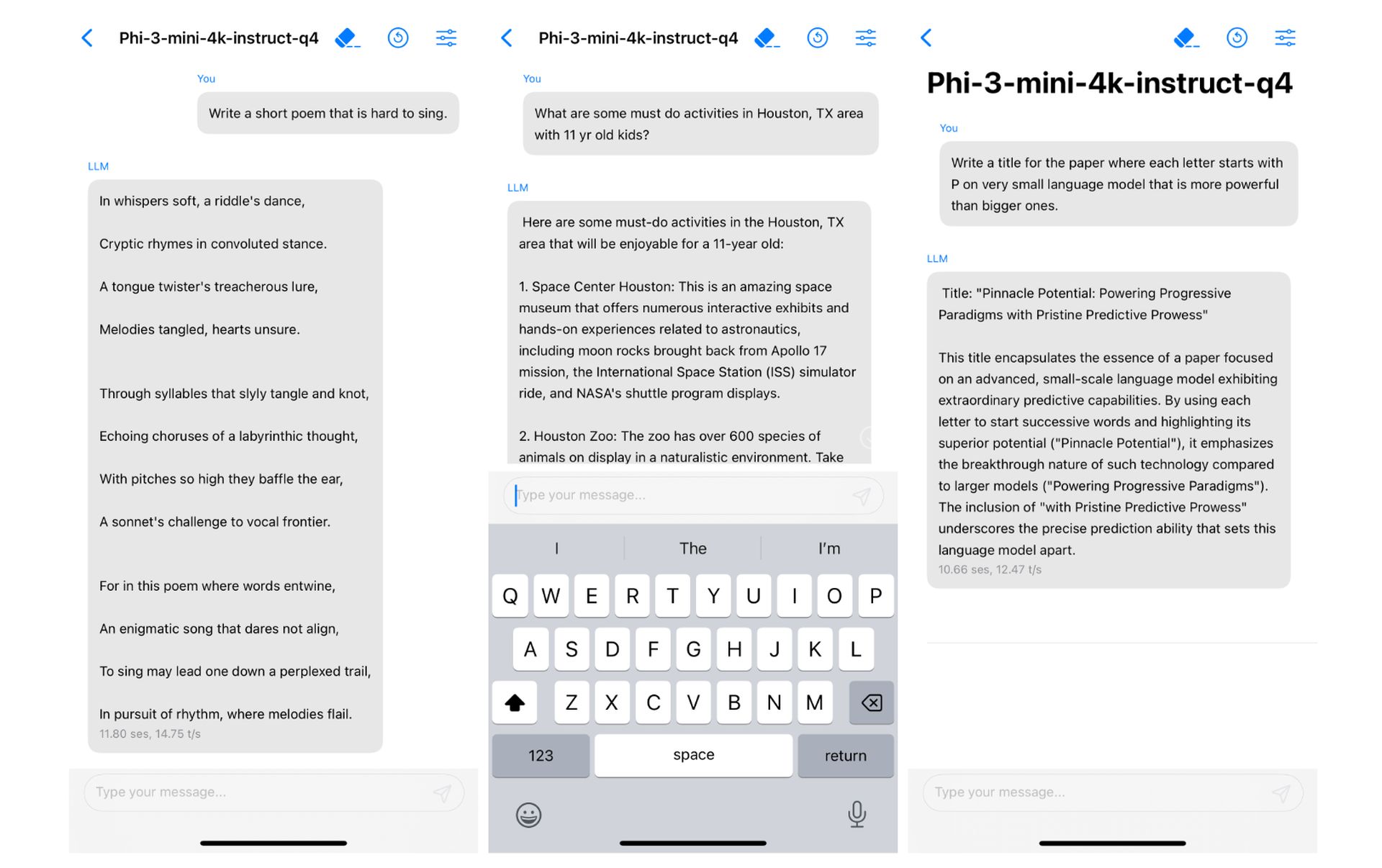

Ukuran kecil Phi-3 Mini berarti kinerja pada perangkat yang luar biasa. Dengan mengkuantisasi model menjadi 4 bit, model ini hanya menempati memori 1.8 gigabyte.

Pertandingan yang dibuat di surga

Apakah Anda ingat upaya ponsel cerdas Microsoft yang gagal? Bagaimana dengan Kesepakatan integrasi Google Gemini yang gagal dari Apple dalam beberapa bulan terakhir? Atau pernahkah Anda mengikuti berita tentang Apple yang vokal dalam mengintegrasikan LLM di perangkat dengan iOS 18 selama beberapa minggu terakhir?

Apakah itu mengingatkan pada sesuatu?

Potensi penerapan Phi-3 Mini sangat luas. Efisiensinya membuatnya ideal untuk diintegrasikan ke dalam perangkat seluler, berpotensi mengaktifkan fitur seperti asisten virtual yang lebih cerdas dan terjemahan bahasa secara real-time. Selain itu, efektivitas biayanya dapat membuka pintu bagi adopsi yang lebih luas oleh pengembang yang mengerjakan berbagai proyek bertenaga AI.

Dan itulah yang dicari Apple. Tentu saja, klaim ini tidak lebih dari sekadar tebakan untuk saat ini, namun tidak salah jika dikatakan bahwa ini adalah “jodoh yang dibuat di surga”. Selain itu, dalam makalah penelitian, proyek baru Microsoft telah dijalankan di iPhone dengan chip A16 Bionic secara native.

Keberhasilan Phi-3 Mini bergantung pada kombinasi beberapa faktor – arsitektur yang sesuai, penggunaan panjang konteks yang efisien, kompatibilitas dengan alat yang ada, fokus pada data pelatihan berkualitas tinggi, dan teknik pengoptimalan. Pendekatan unik ini membuka jalan bagi model AI yang kuat dan efisien yang dapat beroperasi dengan lancar di perangkat pribadi.

Kredit gambar unggulan: vecstock/Freepik

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://dataconomy.com/2024/04/24/microsoft-phi-3/