Découvrez Mixtral 8x7B de Mistral AI. Il est très intelligent pour gérer le Big Data et peut aider dans des tâches telles que la traduction de langues et la génération de code. Les développeurs du monde entier sont enthousiasmés par sa capacité à rationaliser leurs projets et à améliorer leur efficacité. Avec sa conception conviviale et ses capacités impressionnantes, Mixtral 8x7B devient rapidement un outil incontournable pour le développement de l'IA.

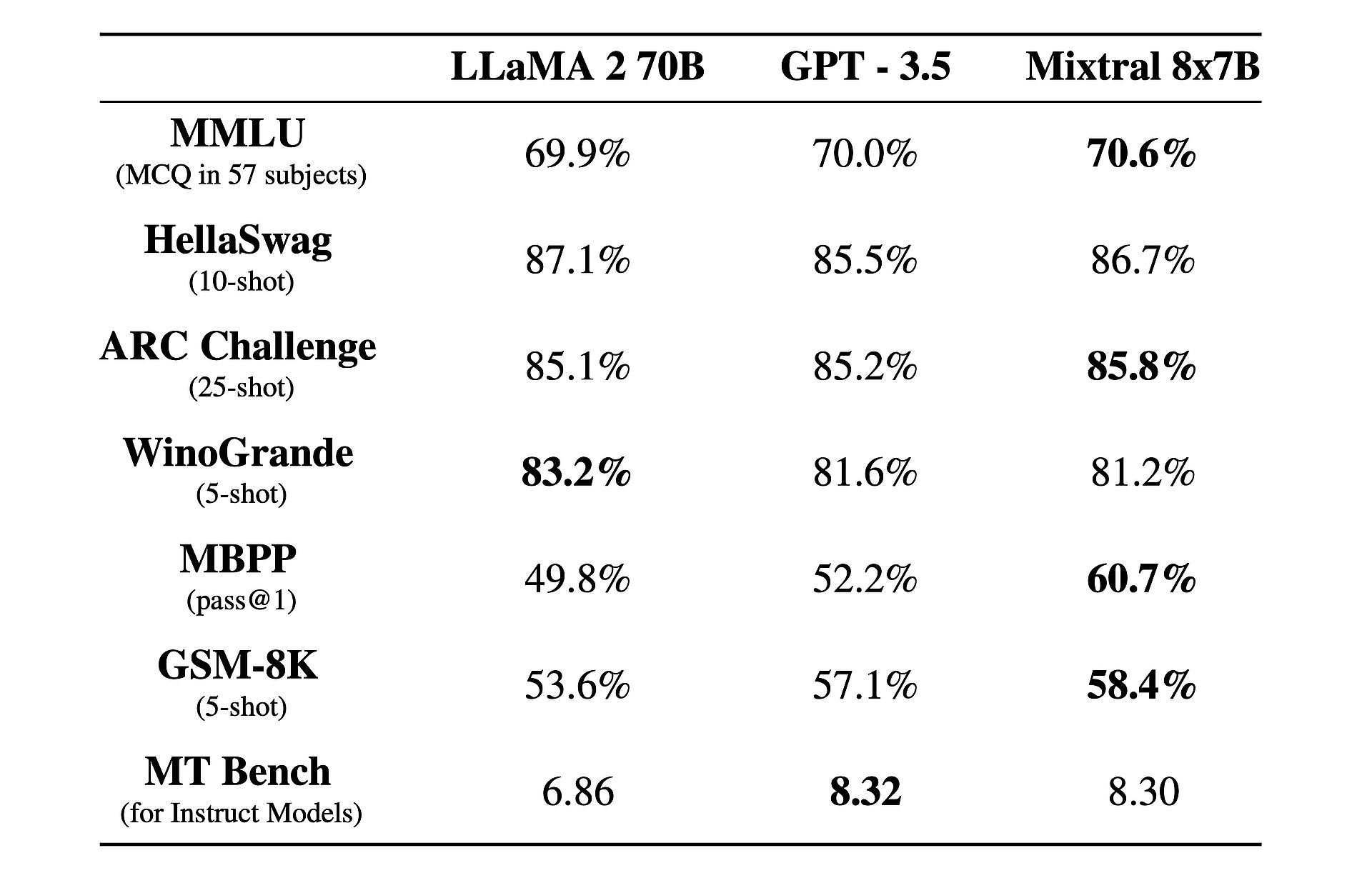

Il y a aussi un fait intéressant à ce sujet : il est plus performant que GPT-3.5 ainsi que Llama 2!

Qu’est-ce que Mixtral 8x7B ?

Mistral 8x7B est un modèle d'intelligence artificielle avancé développé par Mistral AI. Il utilise une architecture unique appelée Sparse Mix-of-Experts (SMoE) pour traiter efficacement de grandes quantités de données. Malgré sa complexité, Mixtral est conçu pour être facile à utiliser et adaptable à diverses tâches telles que la traduction linguistique et la génération de code. Il surpasse les autres modèles en termes de vitesse et de précision, ce qui en fait un outil précieux pour les développeurs. De plus, il est disponible sous la licence Apache 2.0, permettant à quiconque de l'utiliser et de le modifier librement.

Vous voulez en savoir plus ? À la base, Mixtral 8x7B fonctionne comme un modèle de décodeur uniquement, exploitant une approche unique dans laquelle un bloc de rétroaction sélectionne parmi huit groupes distincts de paramètres, appelés « experts ». Ces experts sont choisis dynamiquement par un réseau de routeurs pour traiter chaque jeton, améliorant ainsi l'efficacité et les performances tout en minimisant les frais de calcul.

L'un des principaux atouts de Mixtral réside dans son adaptabilité et son évolutivité. Capable peut gérer des contextes allant jusqu'à 32,000 XNUMX jetons et prendre en charge plusieurs langues, dont l'anglais, le français, l'italien, l'allemand et l'espagnol. Mixtral permet aux développeurs d'aborder un large éventail de tâches avec facilité et précision.

Ce qui distingue vraiment Mixtral, c'est son rapport performance/coût. Avec un total stupéfiant de 46.7 milliards de paramètres, Mixtral atteint une efficacité remarquable en utilisant seulement une fraction de ces paramètres par jeton, ce qui se traduit par des temps d'inférence plus rapides et des dépenses de calcul réduites.

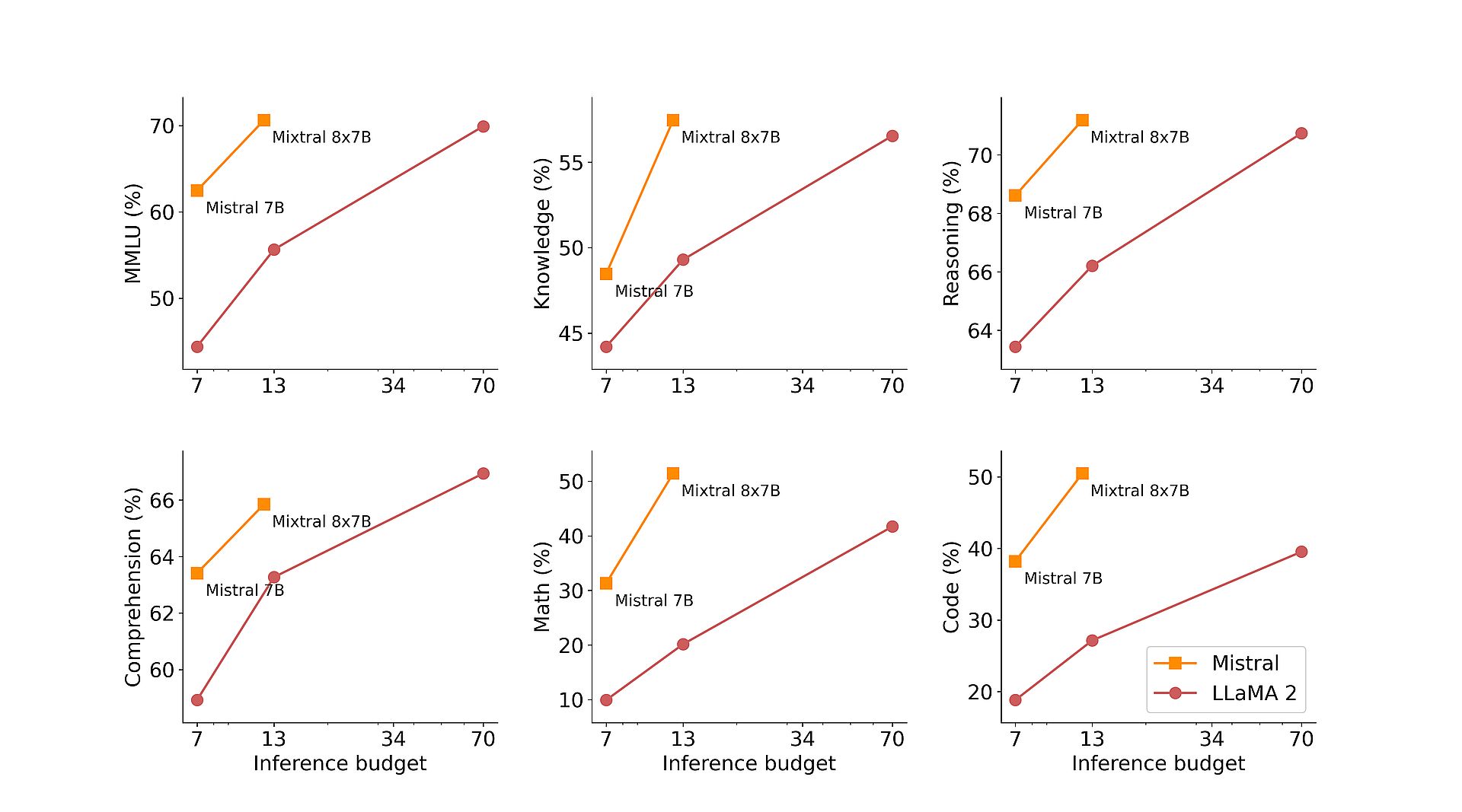

De plus, la pré-formation de Mixtral sur de nombreux ensembles de données extraits du Web ouvert garantit robustesse et polyvalence dans les applications du monde réel. Qu'il s'agisse de génération de code, de traduction linguistique ou d'analyse de sentiments, Mixtral fournit des résultats exceptionnels dans divers benchmarks, surpassant les modèles traditionnels comme Llama 2 et surpassant même GPT3.5 dans de nombreux cas.

Pour améliorer encore ses capacités, Mistral AI a introduit Mixtral 8x7B Instruct, une variante spécialisée optimisée pour les tâches de suivi d'instructions. Atteignant un score impressionnant de 8.30 sur le MT-Bench, Mixtral 8x7B Instruct consolide sa position de modèle open source leader pour le réglage fin supervisé et l'optimisation des préférences.

En plus de ses prouesses techniques, Mistral AI s'engage à démocratiser l'accès à Mixtral en contribuant au projet vLLM, permettant une intégration et un déploiement transparents avec des outils open source. Cela permet aux développeurs d'exploiter la puissance de Mixtral sur un large éventail d'applications et de plates-formes, favorisant ainsi l'innovation et les progrès dans le domaine de l'intelligence artificielle.

IA Groq, pas Grok, rôtit Elon Musk avec son « LLM le plus rapide »

Comment utiliser Mixtral 8x7B

Mistral 8x7B est accessible via le point final mistral-small de Mistral, qui se trouve dans le phases de tests bêtae. Si vous souhaitez obtenir un accès anticipé à tous les points de terminaison génératifs et intégrés de Mistral, vous pouvez vous inscrire maintenant. En vous inscrivant, vous serez parmi les premiers à découvrir toutes les capacités de Mixtral 8x7B et à explorer ses solutions innovantes.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://dataconomy.com/2024/02/21/mistral-ai-mixtral-8x7b/