Introduction

Dans le domaine de l'IA, deux défis distincts sont apparus : le déploiement de grands modèles dans des environnements cloud, ce qui entraîne d'énormes coûts de calcul qui entravent l'évolutivité et la rentabilité, et l'adaptation aux appareils périphériques aux ressources limitées qui ont du mal à prendre en charge des modèles complexes. Le fil conducteur de ces défis est la nécessité impérative de réduire la taille des modèles sans compromettre la précision. La quantification de modèle, une technique populaire, offre une solution potentielle mais soulève des inquiétudes quant aux compromis potentiels en matière de précision.

La formation prenant en compte la quantification apparaît comme une réponse convaincante. Il intègre de manière transparente la quantification dans le processus de formation du modèle, permettant des réductions significatives de la taille du modèle, parfois de deux à quatre fois ou plus, tout en préservant une précision critique. Cet article approfondit la quantification, en comparant la quantification post-formation (PTQ) et la formation prenant en compte la quantification (QAT). De plus, nous fournissons des informations pratiques démontrant comment les deux méthodes peuvent être mises en œuvre efficacement à l'aide de SuperGradients, une bibliothèque de formation open source développée par Deci.

De plus, nous explorons l’optimisation de Réseaux de neurones convolutionnels (CNN) pour les plates-formes mobiles et embarquées, répondant aux défis uniques de taille et de demandes de calcul. Nous nous concentrons sur la quantification, en examinant le rôle de la représentation des nombres dans l'optimisation des modèles pour les plateformes mobiles et embarquées.

Objectifs d'apprentissage

- Comprendre le concept de quantification de modèle en IA.

- Découvrez les niveaux de quantification typiques et leurs compromis.

- Faites la différence entre la formation basée sur la quantification (QAT) et la quantification post-formation (PTQ).

- Découvrez les avantages de la quantification de modèles, notamment l'efficacité de la mémoire et les économies d'énergie.

- Découvrez comment la quantification de modèles permet un déploiement plus large de modèles d'IA.

Cet article a été publié dans le cadre du Blogathon sur la science des données.

Table des matières

Comprendre le besoin de quantification du modèle

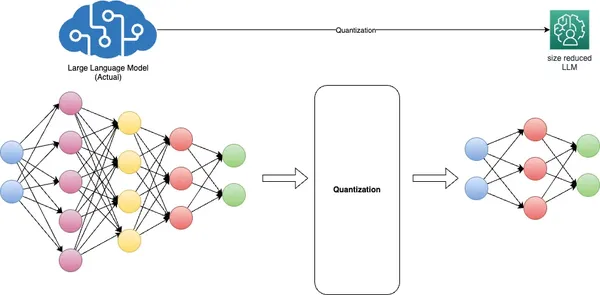

La quantification de modèle, une technique fondamentale de l'apprentissage profond, vise à relever les défis critiques liés à la taille du modèle, à la vitesse d'inférence et à l'efficacité de la mémoire. Pour ce faire, il convertit les poids du modèle à partir de représentations à virgule flottante de haute précision, généralement 32 bits (FP32), vers des formats à virgule flottante (FP) ou entiers (INT) de moindre précision, tels que 16 bits ou 8 bits. .

Les avantages de la quantification sont doubles. Premièrement, cela réduit considérablement l'empreinte mémoire du modèle et améliore la vitesse d'inférence sans entraîner une dégradation substantielle de la précision. Deuxièmement, il optimise les performances du modèle en réduisant les besoins en bande passante mémoire et en améliorant l'utilisation du cache.

La représentation INT8 est souvent appelée familièrement « quantifiée » dans le contexte des réseaux de neurones profonds, mais d'autres formats comme UINT8 et INT16 sont également utilisés, en fonction de l'architecture matérielle. Différents modèles nécessitent des approches de quantification distinctes, exigeant souvent des connaissances préalables et un réglage minutieux pour équilibrer la précision et la réduction de la taille du modèle.

La quantification présente des défis, en particulier avec les formats entiers de faible précision tels que INT8, en raison de leur plage dynamique limitée. Réduire la vaste plage dynamique du FP32 à seulement 255 valeurs de INT8 peut entraîner une perte de précision. Pour atténuer ce défi, la mise à l'échelle par canal ou par couche ajuste les valeurs d'échelle et de point zéro des tenseurs de poids et d'activation pour mieux s'adapter au format quantifié.

De plus, la formation prenant en compte la quantification simule le processus de quantification pendant la formation du modèle, permettant au modèle de s'adapter gracieusement à une précision inférieure. La compression, ou estimation de plage, est un aspect essentiel de ce processus, réalisé grâce à l'étalonnage.

Essentiellement, la quantification des modèles est indispensable au déploiement de modèles d’IA efficaces, établissant un équilibre délicat entre précision et efficacité des ressources, en particulier sur les appareils de pointe dotés de ressources informatiques limitées.

Techniques de quantification de modèle

Niveau de quantification

La quantification convertit les poids et activations à virgule flottante de haute précision d'un modèle en valeurs à virgule fixe de moindre précision. Le « niveau de quantification » fait référence au nombre de bits représentant ces valeurs à virgule fixe. Les niveaux de quantification typiques sont la quantification 8 bits, 16 bits et même binaire (1 bit). Le choix d'un niveau de quantification approprié dépend du compromis entre la précision du modèle et l'efficacité de la mémoire, du stockage et du calcul.

Formation basée sur la quantification (QAT) en détail

La formation sensible à la quantification (QAT) est une technique utilisée lors de la formation des réseaux de neurones pour les préparer à la quantification. Cela aide le modèle à apprendre à fonctionner efficacement avec des données de moindre précision. Voici comment fonctionne QAT :

- Pendant QAT, le modèle est entraîné avec des contraintes de quantification. Ces contraintes incluent la simulation de types de données de moindre précision (par exemple, des entiers de 8 bits) lors des passages aller et retour.

- Une fonction de perte prenant en compte la quantification est utilisée, qui prend en compte l'erreur de quantification pour pénaliser les écarts par rapport au comportement du modèle pleine précision.

- QAT aide le modèle à apprendre à faire face à la perte de précision induite par la quantification en ajustant ses poids et ses activations en conséquence.

Quantification post-formation (PTQ) vs formation basée sur la quantification (QAT)

PTQ et QAT sont deux approches distinctes de la quantification de modèles, chacune avec ses avantages et ses implications.

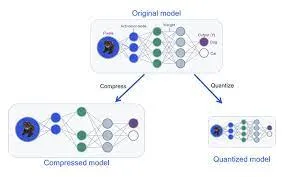

Quantification post-formation (PTQ)

PTQ est une technique de quantification appliquée après qu'un modèle a subi un entraînement complet avec une précision standard, généralement en représentation à virgule flottante. Dans PTQ, les poids et les activations du modèle sont quantifiés dans des formats de moindre précision, tels que des entiers de 8 bits ou des flottants de 16 bits, afin de réduire l'utilisation de la mémoire et d'améliorer la vitesse d'inférence. Bien que PTQ offre simplicité et compatibilité avec les modèles préexistants, il peut entraîner une perte modérée de précision en raison de la conversion post-formation.

Formation basée sur la quantification (QAT)

QAT, en revanche, est une approche plus nuancée de la quantification. Cela implique d’affiner le modèle PTQ en gardant à l’esprit la quantification. Pendant QAT, le processus de quantification, englobant la mise à l'échelle, l'écrêtage et l'arrondi, est parfaitement intégré au processus de formation. Cela permet au modèle d'être entraîné explicitement pour conserver sa précision même après la quantification. QAT optimise les pondérations du modèle pour émuler avec précision la quantification du temps d'inférence. Pendant la formation, il utilise de « faux » modules de quantification pour imiter le comportement de la phase de test ou d’inférence, où les poids sont arrondis ou limités à des représentations de faible précision. Cette approche conduit à une plus grande précision lors de l'inférence du monde réel, car le modèle est conscient de la quantification dès le départ.

Algorithmes de quantification

Il existe différents algorithmes et méthodes pour quantifier les réseaux neuronaux. Certaines techniques de quantification standard incluent :

- Quantification du poids implique de quantifier les poids du modèle en valeurs de précision inférieure (par exemple, des entiers de 8 bits). La quantification du poids peut réduire considérablement l'empreinte mémoire du modèle.

- Quantification d'activation : Outre la quantification des poids, les activations peuvent être quantifiées lors de l'inférence. Cela réduit davantage les besoins de calcul et l’utilisation de la mémoire.

- Quantification dynamique : Au lieu d'utiliser une échelle de quantification fixe, la quantification dynamique permet une mise à l'échelle dynamique des plages de quantification pendant l'inférence, contribuant ainsi à atténuer la perte de précision.

- Formation basée sur la quantification (QAT) : Comme mentionné précédemment, QAT est une méthode de formation qui intègre des contraintes de quantification et permet au modèle d'apprendre à fonctionner avec des données de moindre précision.

- Quantification à précision mixte : Cette technique combine différentes quantifications de précision pour les poids et les activations, optimisant ainsi la précision et l'efficacité.

- Quantification post-formation avec calibrage : Dans la quantification post-formation, l'étalonnage est utilisé pour déterminer les plages de quantification des poids et des activations afin de minimiser la perte de précision.

En résumé, le choix entre la quantification post-formation et la formation basée sur la quantification (QAT) dépend des besoins spécifiques de déploiement et de l'équilibre entre performances et efficacité du modèle. PTQ propose une approche plus simple pour réduire la taille du modèle. Néanmoins, il peut souffrir d’une perte de précision en raison de l’inadéquation inhérente entre le modèle original de pleine précision et son homologue quantifié. D’autre part, QAT intègre les contraintes de quantification directement dans le processus de formation, garantissant ainsi que le modèle apprend dès le départ à fonctionner efficacement avec des données de moindre précision.

Cela se traduit par une meilleure conservation de la précision et un contrôle plus fin du processus de quantification. Lorsque le maintien d’une grande précision est primordial, QAT est souvent le choix privilégié. Il permet aux modèles d'apprentissage profond de trouver l'équilibre délicat entre performances optimales et utilisation efficace des ressources matérielles. Il est particulièrement adapté au déploiement sur des appareils aux ressources limitées où la précision ne peut être compromise.

Avantages de la quantification du modèle

- Inférence plus rapide : Les modèles quantifiés sont plus rapides à déployer et à exécuter, ce qui les rend idéaux pour les applications en temps réel telles que la reconnaissance vocale, le traitement d'images et les véhicules autonomes. Une précision réduite permet des calculs plus rapides, conduisant à une latence plus faible.

- Coûts de déploiement réduits : Des modèles de plus petite taille se traduisent par une réduction des besoins en stockage et en mémoire, ce qui réduit considérablement le coût de déploiement des solutions d'IA, en particulier dans les services basés sur le cloud où les coûts de stockage et de calcul sont des considérations importantes.

- Accessibilité accrue: La quantification permet de déployer l'IA sur des appareils aux ressources limitées comme les smartphones, les appareils IoT et les plates-formes informatiques de pointe. Cela étend la portée de l’IA à un public plus large et ouvre de nouvelles opportunités d’applications dans des zones reculées ou sous-développées.

- Confidentialité et sécurité améliorées : En réduisant la taille des modèles, la quantification peut faciliter le traitement de l'IA sur l'appareil, réduisant ainsi le besoin d'envoyer des données sensibles à des serveurs centralisés. Cela améliore la confidentialité et la sécurité en minimisant l’exposition des données aux menaces externes.

- Impact environnemental: Des modèles de plus petite taille entraînent une réduction de la consommation d’énergie, rendant les centres de données et l’infrastructure cloud plus économes en énergie. Cela permet d’atténuer l’impact environnemental des déploiements d’IA à grande échelle.

- Évolutivité: Les modèles quantifiés sont plus accessibles à distribuer et à déployer, ce qui permet une mise à l'échelle efficace des services d'IA pour répondre aux demandes et au trafic croissants des utilisateurs sans investissements importants dans l'infrastructure.

- Compatibilité: Les modèles quantifiés sont souvent plus compatibles avec une gamme plus large de matériel, ce qui rend le déploiement de solutions d'IA sur divers appareils et plates-formes plus accessible.

- Applications en temps réel : La taille réduite du modèle et l'inférence plus rapide rendent les modèles quantifiés adaptés aux applications en temps réel telles que la réalité augmentée, la réalité virtuelle et les jeux, où une faible latence est cruciale pour une expérience utilisateur fluide.

Ces avantages font collectivement de la quantification du modèle une technique essentielle pour l'optimisation AI déploiements, garantissant à la fois l’efficacité et l’accessibilité sur une large gamme d’applications et d’appareils.

Exemples concrets

- Système de santé: Dans le secteur de la santé, la quantification des modèles a permis de déployer des solutions d'imagerie médicale basées sur l'IA sur des appareils de pointe. Les appareils à ultrasons portables et les applications pour smartphones utilisent désormais des modèles quantifiés pour diagnostiquer les maladies cardiaques et détecter les tumeurs. Cela réduit le besoin d’équipements spécialisés coûteux et permet aux professionnels de la santé de fournir des diagnostics rapides et précis dans des contextes éloignés ou aux ressources limitées.

- Véhicules autonomes: Les modèles quantifiés jouent un rôle crucial dans les véhicules autonomes, où la prise de décision en temps réel est impérative. Les voitures autonomes peuvent fonctionner efficacement sur du matériel embarqué en réduisant la taille des modèles d'apprentissage profond pour les tâches de perception et de contrôle. Cela améliore la sécurité, la réactivité et la capacité à naviguer dans des environnements complexes, faisant ainsi de la conduite autonome une réalité.

- Traitement du langage naturel (PNL): Dans le domaine de la PNL, les modèles quantifiés ont permis le déploiement de modèles de langage sur des locuteurs intelligents, des chatbots et des appareils mobiles. Cela permet une compréhension et une génération de langues en temps réel, rendant les assistants vocaux et les applications de traduction plus accessibles et plus réactifs aux requêtes des utilisateurs.

- Automation Industriel : L'automatisation industrielle exploite des modèles quantifiés pour la maintenance prédictive et le contrôle qualité. Les appareils Edge équipés de modèles quantifiés peuvent surveiller l’état des machines et détecter les défauts en temps réel, minimisant ainsi les temps d’arrêt et améliorant l’efficacité de la production dans les usines de fabrication.

- Commerce de détail et e-commerce: Les détaillants utilisent des modèles quantifiés pour la gestion des stocks et l'engagement client. Les modèles de reconnaissance d'images en temps réel déployés sur les caméras en magasin peuvent suivre la disponibilité des produits et optimiser l'agencement des magasins. De même, les systèmes de recommandation quantifiée offrent des expériences d'achat personnalisées sur les plateformes de commerce électronique, améliorant ainsi la satisfaction des clients et les ventes.

Ces exemples concrets illustrent la polyvalence et l'impact de la quantification de modèles dans divers secteurs, rendant les solutions d'IA plus accessibles, efficaces et rentables.

Défis et considérations

Dans la quantification des modèles, plusieurs défis et considérations critiques façonnent le paysage des déploiements efficaces de l’IA. Un défi fondamental consiste à trouver l’équilibre délicat entre précision et efficacité. Une quantification agressive, tout en améliorant l'efficacité des ressources, peut entraîner une perte de précision significative, ce qui rend impératif d'adapter l'approche de quantification aux exigences spécifiques de l'application.

De plus, tous les modèles d’IA ne se prêtent pas également à la quantification, la complexité des modèles jouant un rôle central dans leur sensibilité aux réductions de précision lors de la quantification. Cela nécessite d’évaluer soigneusement si la quantification convient à un modèle et à un cas d’utilisation donnés. Le choix entre la quantification post-formation (PTQ) et la formation sensible à la quantification (QAT) est tout aussi critique. Cette décision a un impact significatif sur la précision, la complexité du modèle et les délais de développement, soulignant la nécessité pour les développeurs de faire des choix éclairés qui correspondent aux exigences de déploiement de leur projet et aux ressources disponibles. Ces considérations soulignent collectivement l’importance d’une planification et d’une évaluation méticuleuses lors de la mise en œuvre de la quantification des modèles, car elles influencent directement les compromis complexes entre la précision du modèle et l’efficacité des ressources dans les applications d’IA.

Compromis en matière de précision

- Un examen détaillé des compromis entre la précision du modèle et la quantification : cette section se penche sur l'équilibre complexe entre le maintien de la précision du modèle et l'efficacité des ressources grâce à la quantification. Il explore comment une quantification agressive peut entraîner une perte de précision et les considérations nécessaires pour prendre des décisions éclairées concernant le niveau de quantification adapté à des applications spécifiques.

Défis de formation tenant compte de la quantification

- Défis courants rencontrés lors de la mise en œuvre de QAT et stratégies pour les surmonter : nous abordons les obstacles rencontrés par les développeurs lors de l'intégration de la formation basée sur la quantification (QAT) dans le processus de formation des modèles. Nous fournissons également des informations sur les stratégies et les meilleures pratiques pour surmonter ces défis, garantissant ainsi une mise en œuvre réussie du QAT.

Limitations matérielles

- Discuter du rôle des accélérateurs matériels dans le déploiement de modèles quantifiés : cette section explore le rôle des accélérateurs matériels, tels que les GPU, les TPU et le matériel d'IA dédié, dans le déploiement de modèles quantifiés. Il souligne l'importance de la compatibilité et de l'optimisation matérielles pour obtenir une inférence efficace et hautes performances avec des modèles quantifiés.

Détection d'objets en temps réel sur un Raspberry Pi à l'aide de Quantized MobileNetV2

1 : Configuration du matériel

- Présentez votre modèle Raspberry Pi (par exemple, Raspberry Pi 4).

- Module caméra Raspberry Pi (ou webcam USB pour les anciens modèles)

- Source d'alimentation

- Carte MicroSD avec système d'exploitation Raspberry Pi

- Câble HDMI, moniteur, clavier et souris (pour la configuration initiale)

- Insistez sur la nécessité de déployer un modèle léger sur le Raspberry Pi en raison de ses contraintes de ressources.

2 : Installation du logiciel

- Configurez le Raspberry Pi avec Raspberry Pi OS (anciennement Raspbian).

- Installez Python et les bibliothèques requises :

sudo apt update

sudo apt install python3-pip

pip3 install opencv-python-headless

pip3 install opencv-python

pip3 install numpy

pip3 install tensorflow==2.73 : Collecte et prétraitement des données

- Collectez ou accédez à un ensemble de données pour la détection d'objets (par exemple, un ensemble de données COCO).

- Étiqueter les objets d'intérêt dans les images à l'aide d'outils tels que LabelImg.

- Conversion des annotations au format requis (par exemple, TFRecord) pour TensorFlow.

4 : Importer les bibliothèques nécessaires

import argparse # For command-line argument parsing

import cv2 # OpenCV library for computer vision tasks

import imutils # Utility functions for working with images and video

import numpy as np # NumPy for numerical operations

import tensorflow as tf # TensorFlow for machine learning and deep learning5 : Quantification du modèle

- Quantifiez un modèle MobileNetV2 pré-entraîné à l'aide de TensorFlow :

import tensorflow as tf # Load the pre-trained model

model = tf.keras.applications.MobileNetV2(weights='imagenet', input_shape=(224, 224, 3)) # Quantize the model

converter = tf.lite.TFLiteConverter.from_keras_model(model)

converter.optimizations = [tf.lite.Optimize.DEFAULT]

tflite_quantized_model = converter.convert() # Save the quantized model

with open('quantized_mobilenetv2.tflite', 'wb') as f: f.write(tflite_quantized_model)Step 5: Deployment and Real-time Inference6 : Analyse des arguments

- « argparse » est utilisé pour analyser les arguments de ligne de commande. Ici, il est configuré pour accepter le chemin d’accès au modèle personnalisé, au fichier d’étiquettes et à un seuil de confiance.

# Parse command-line arguments

ap = argparse.ArgumentParser()

ap.add_argument("-m", "--model", required=True, help="path to your custom trained model")

ap.add_argument("-l", "--labels", required=True, help="path to your class labels file")

ap.add_argument("-c", "--confidence", type=float, default=0.2, help="minimum probability to filter weak detections")

args = vars(ap.parse_args())

7 : Chargement du modèle et chargement des étiquettes

- Le code charge le modèle de détection d'objets personnalisé et les étiquettes de classe.

# Load your custom-trained model and labels

print("[INFO] loading model...")

model = tf.saved_model.load(args["model"]) # Load the custom-trained TensorFlow model

with open(args["labels"], "r") as f: CLASSES = f.read().strip().split("n") # Load class labels from a file

8 : Initialisation du flux vidéo

- Il configure le flux vidéo, qui capture les images de la caméra par défaut.

# Initialize video stream

print("[INFO] starting video stream...")

cap = cv2.VideoCapture(0) # Initialize the video stream (0 for the default camera)

fps = cv2.getTickFrequency()

start_time = cv2.getTickCount()

9 : Boucle de détection d’objets en temps réel

- La boucle principale capture les images du flux vidéo, effectue la détection des objets à l'aide du modèle personnalisé et affiche les résultats sur l'image.

- Les objets détectés sont dessinés sous forme de cadres de délimitation avec des étiquettes et des scores de confiance.

while True: # Read a frame from the video stream ret, frame = cap.read() frame = imutils.resize(frame, width=800) # Resize the frame for better processing speed # Perform object detection using the custom model detections = model(frame) # Loop over detected objects for detection in detections['detection_boxes']: # Extract bounding box coordinates startY, startX, endY, endX = detection[0], detection[1], detection[2], detection[3] # Draw bounding box and label on the frame label = CLASSES[0] # Replace with your class label logic confidence = 1.0 # Replace with your confidence score logic color = (0, 255, 0) # Green color for bounding box (you can change this) cv2.rectangle(frame, (startX, startY), (endX, endY), color, 2) text = "{}: {:.2f}%".format(label, confidence * 100) cv2.putText(frame, text, (startX, startY - 10), cv2.FONT_HERSHEY_SIMPLEX, 0.5, color, 2) # Display the frame with object detection results cv2.imshow("Custom Object Detection", frame) key = cv2.waitKey(1) & 0xFF if key == ord("q"): break # Break the loop if 'q' key is pressed # Clean up

cap.release() # Release the video stream

cv2.destroyAllWindows() # Close OpenCV windows

10 : Évaluation des performances

- Mesurez la vitesse d'inférence et l'utilisation des ressources sur le Raspberry Pi à l'aide d'outils de surveillance du temps et du système (htop).

- Discutez de tout compromis entre précision et efficacité observé au cours du projet.

11 : Conclusion et aperçus

- Résumez les résultats essentiels et soulignez comment la quantification du modèle a permis la détection d'objets en temps réel sur un appareil aux ressources limitées comme le Raspberry Pi.

- Mettez en valeur le caractère pratique de ce projet et ses applications concrètes, telles que le déploiement de la détection d'objets dans des caméras de sécurité ou la robotique.

En suivant ces étapes et en utilisant le code Python fourni, les apprenants peuvent créer un système de détection d'objets en temps réel sur un Raspberry Pi, démontrant les avantages de la quantification de modèle pour des applications d'IA efficaces sur les appareils de pointe.

Conclusion

La quantification des modèles est une technique essentielle qui influence profondément le paysage du déploiement de l’IA. Il permet aux appareils mobiles et de périphérie aux ressources limitées d'exécuter efficacement des applications d'IA et améliore l'évolutivité et la rentabilité des services d'IA basés sur le cloud. L’impact de la quantification se répercute sur l’ensemble de l’écosystème de l’IA, la rendant plus accessible, plus réactive et plus respectueuse de l’environnement.

De plus, la quantification s’aligne sur les tendances émergentes de l’IA, comme l’apprentissage fédéré et l’IA de pointe, ouvrant ainsi de nouvelles frontières de l’innovation. Alors que nous assistons à l’évolution continue de l’IA, la quantification des modèles constitue un outil essentiel, garantissant que l’IA peut atteindre un public plus large, fournir des informations en temps réel et s’adapter aux demandes changeantes de divers secteurs. Dans ce paysage dynamique, la quantification des modèles sert de pont entre la puissance de l'IA et la praticité de son déploiement, ouvrant la voie à des solutions d'IA plus efficaces, accessibles et durables.

Faits marquants

- La quantification des modèles est vitale pour déployer de grands modèles d’IA sur des appareils aux ressources limitées.

- Les niveaux de quantification, comme 8 bits ou 16 bits, réduisent la taille du modèle et améliorent l'efficacité.

- Presser QAT (Quantization-Aware Training) La formation basée sur la quantification quantifie la formation pendant la formation.

- La quantification post-entraînement (PTQ) simplifie mais peut réduire la précision, nécessitant un réglage fin.

- Le choix dépend des besoins de déploiement spécifiques et de l'équilibre entre précision et efficacité, ce qui est crucial pour les appareils aux ressources limitées.

Foire aux Questions

R : La quantification de modèle en IA est une technique qui consiste à réduire la précision des poids et des activations d'un modèle de réseau neuronal. Il convertit les valeurs à virgule flottante de haute précision en représentations à virgule fixe ou entières de moindre précision, ce qui rend le modèle plus efficace en termes de mémoire et plus rapide à exécuter.

R : Les niveaux de quantification courants incluent la quantification 8 bits, 16 bits et binaire (1 bit). Le choix du niveau de quantification dépend de l'équilibre entre la précision du modèle et l'efficacité de la mémoire/stockage/calcul requise pour une application spécifique.

R : QAT intègre des contraintes de quantification lors de la formation, permettant au modèle de s'adapter à des calculs de moindre précision. PTQ, quant à lui, quantifie un modèle pré-entraîné après un entraînement standard, ce qui nécessite potentiellement un réglage fin pour retrouver la précision perdue.

R : La quantification de modèle offre des avantages tels qu'une empreinte mémoire réduite, une vitesse d'inférence améliorée, une efficacité énergétique, un déploiement plus large sur des appareils aux ressources limitées, des économies de coûts, ainsi qu'une confidentialité et une sécurité améliorées grâce à des modèles plus petits.

R : Choisir QAT pour maintenir la précision du modèle est une priorité. QAT garantit une meilleure conservation de la précision en intégrant des contraintes de quantification pendant l'entraînement, ce qui le rend idéal lorsque la précision est primordiale. PTQ est plus simple mais peut nécessiter des réglages supplémentaires pour retrouver la précision. Le choix dépend des besoins spécifiques du déploiement.

Les médias présentés dans cet article n'appartiennent pas à Analytics Vidhya et sont utilisés à la discrétion de l'auteur.

Services Connexes

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.analyticsvidhya.com/blog/2023/11/model-quantization-for-large-scale-deployment/