Introduction

Entrez à l’avant-garde du traitement du langage ! Dans un domaine où le langage constitue un lien essentiel entre l’humanité et la technologie, les progrès réalisés dans le domaine du traitement du langage naturel ont permis d’atteindre des sommets extraordinaires. Au sein de ces progrès se trouve le modèle révolutionnaire Large Language Model, une force transformatrice qui remodèle nos interactions avec les informations textuelles. Au cours de ce parcours d'apprentissage complet, vous plongerez dans les subtilités de LangChain, un outil de pointe qui remodèle la façon dont nous interagissons avec les informations textuelles. Vous êtes-vous déjà demandé ce qu'est la chaîne, le « Langchain » ?

LangChain est à lui seul une passerelle vers le domaine le plus dynamique des grands modèles linguistiques, qui offre une compréhension approfondie de la façon dont ces modèles transforment les entrées brutes en réponses raffinées et semblables à celles des humains. Grâce à cette exploration, vous découvrirez les éléments constitutifs essentiels de LangChain, des LLMChains et des chaînes séquentielles au fonctionnement complexe des chaînes de routeurs.

Objectifs d'apprentissage

- Comprenez les composants principaux de LangChain, y compris les LLMChains et les chaînes séquentielles, pour voir comment les entrées circulent dans le système.

- Apprenez à intégrer différents éléments de manière cohérente, en explorant le lien entre les modèles d'invite et les modèles de langage.

- Acquérez une expérience pratique dans la création de chaînes fonctionnelles pour des tâches du monde réel.

- Développez des compétences pour améliorer l’efficacité de la chaîne en affinant les structures, les modèles et les techniques d’analyse.

Cet article a été publié dans le cadre du Blogathon sur la science des données.

Table des matières

Qu’est-ce que le LLM ?

A Grand modèle de langage (LLM) fait référence à un type d’intelligence artificielle conçu pour comprendre et générer du texte de type humain. Ces modèles, comme le GPT-3.5 d'OpenAI, s'entraînent sur de nombreuses données textuelles pour comprendre les modèles et les structures du langage humain. Ils peuvent effectuer diverses tâches liées à la langue, notamment la traduction, la création de contenu, répondre à des questions, etc.

Les LLM sont des outils précieux dans le traitement du langage naturel et ont des applications dans des domaines tels que les chatbots, la génération de contenu et les services de traduction linguistique.

Qu'est-ce que LangChain ?

Avant de découvrir les subtilités des chaînes LangChain, saisissons l'essence de LangChain elle-même. LangChain est une bibliothèque robuste conçue pour simplifier les interactions avec divers fournisseurs de grands modèles de langage (LLM), notamment OpenAI, Cohere, Bloom, Huggingface et autres. Ce qui distingue LangChain est sa caractéristique unique : la possibilité de créer des chaînes et des connexions logiques qui aident à relier un ou plusieurs LLM.

Pourquoi utiliser LangChain ?

LangChaîne offre des opportunités illimitées, limitées uniquement par votre imagination.

- Imaginez des chatbots qui non seulement fournissent des informations, mais engagent également les utilisateurs avec esprit et charme.

- Imaginez des plateformes de commerce électronique suggérant des produits avec une telle précision que les clients sont obligés d’effectuer un achat.

- Imaginez des applications de santé offrant des informations médicales personnalisées, permettant aux individus de prendre des décisions éclairées concernant leur bien-être.

Avec LangChain, vous avez le pouvoir de créer des expériences extraordinaires. Le potentiel de transformer ces idées en réalité est à portée de main.

Comprendre les chaînes dans LangChain

Au cœur de LangChain se trouve un composant essentiel connu sous le nom de chaînes LangChain, qui constitue la connexion centrale entre un ou plusieurs grands modèles de langage (LLM).

Dans certaines applications sophistiquées, il devient nécessaire d'enchaîner les LLM entre eux, soit entre eux, soit avec d'autres éléments. Ces chaînes nous permettent d'intégrer de nombreux composants, en les intégrant dans une application cohérente. Approfondissons les différents types de chaînes.

De plus, l'approche structurée proposée par Chains in LLM garantit un traitement impeccable et efficace, ouvrant la voie au développement d'applications avancées adaptées à un large éventail de besoins des utilisateurs. Cela représente une avancée significative dans le domaine du traitement du langage naturel, car ces connexions complexes servent de cadre fondamental à LangChain, facilitant des interactions transparentes entre plusieurs grands modèles de langage (LLM).

Mais d’abord, pourquoi des chaînes ?

Les chaînes sont inestimables en raison de leur capacité à mélanger sans effort divers composants, façonnant ainsi une application unique et cohérente. Grâce à la création de chaînes, plusieurs éléments peuvent s’assembler de manière transparente. Imaginez ce scénario : une chaîne est conçue pour prendre en compte les entrées de l'utilisateur, les peaufiner à l'aide d'un PromptTemplate, puis transmettre cette réponse raffinée à un grand modèle de langage (LLM). Ce processus rationalisé simplifie non seulement mais enrichit également la fonctionnalité globale du système. Essentiellement, les chaînes servent de pivot, reliant de manière transparente les différentes parties de l’application et améliorant ses capacités. Résumons ceci :

- L'intégration de modèles d'invites avec les LLM permet une puissante synergie.

- En prenant la sortie d’un LLM et en l’utilisant comme entrée pour le suivant, il devient possible de connecter plusieurs LLM de manière séquentielle.

- La combinaison des LLM avec des données externes permet au système de répondre efficacement aux demandes de renseignements.

- L'intégration des LLM avec une mémoire à long terme, telle que l'historique des discussions, améliore le contexte global et la profondeur des interactions.

De plus, les chaînes nous offrent la possibilité de créer des applications complexes en reliant plusieurs chaînes entre elles ou en incorporant des chaînes avec d'autres éléments vitaux. Cette approche permet une méthode sophistiquée et nuancée pour développer des applications, permettant des fonctionnalités complexes et avancées.

Types de chaîne

Il existe de nombreuses chaînes différentes dans Langchain que nous pouvons utiliser. Ici, nous passons en revue trois des chaînes fondamentales : la chaîne LLM, la chaîne séquentielle et la chaîne de routeur.

Chaîne LLM – La chaîne la plus simple

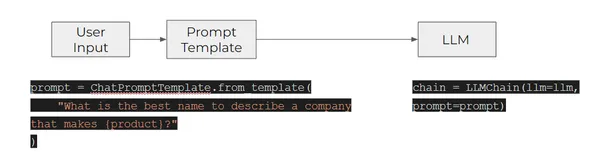

La forme de chaîne la plus basique au sein de ce système est la LLMChain, largement reconnue et fondamentale. Son fonctionnement implique un arrangement structuré, comprenant un PromptTemplate, un modèle OpenAI (soit un Large Language Model, soit un ChatModel) et un analyseur de sortie facultatif. Dans cette configuration, LLMChain accepte divers paramètres d'entrée. Il utilise le PromptTemplate pour transformer ces entrées en une invite cohérente. Cette invite raffinée est ensuite entrée dans le modèle. Après avoir reçu la sortie, LLMChain utilise OutputParser, s'il est fourni, pour affiner et formater davantage le résultat dans sa forme ultime utilisable. Pour illustrer la fonctionnalité des chaînes LLM, considérons l'exemple concret. Un exemple concret illustrant la fonctionnalité des chaînes LLM est détaillé ci-dessous :

- Il fonctionne en prenant l'entrée d'un utilisateur et en la transmettant au premier élément de la chaîne – un PromptTemplate – pour formater l'entrée dans une invite particulière.

- L'invite formatée est ensuite transmise à l'élément suivant (et dernier) de la chaîne : un LLM.

Chaînes d'artisanat – Chaîne LLM

La création de chaînes, en particulier de chaînes LLM, est un effort méticuleux, nécessitant l'exploitation de grands modèles de langage dans LangChain. Ces chaînes servent de canaux complexes, facilitant l’échange fluide d’informations et l’engagement. Grâce à une structuration minutieuse, les développeurs peuvent concevoir des applications dynamiques capables de comprendre les entrées des utilisateurs, d'utiliser des LLM pour générer des réponses intelligentes et de personnaliser la sortie pour répondre efficacement aux besoins spécifiques.

Examinons maintenant plus en détail comment nous pouvons utiliser les chaînes LLM dans Langchain.

Importer les bibliothèques nécessaires

import langchain

import openai

from langchain.llms import OpenAI

from langchain.prompts import PromptTemplate from getpass import getpass

OPENAI_API_KEY = getpass()

Initialiser le LLM et le modèle d'invite

Nous initialisons le modèle OpenAI Large Language avec des paramètres spécifiques, dont une température de 0.9, qui affecte la diversité des réponses générées. De plus, les utilisateurs doivent définir un « PromptTemplate » pour saisir une variable (dans ce cas, « produit ») et créer une structure d'invite standardisée. Au moment de l'exécution, l'espace réservé « {product} » peut être rempli dynamiquement avec différents noms de produits.

llm = OpenAI(temperature=0.9, openai_api_key=OPENAI_API_KEY )

prompt = PromptTemplate( input_variables=["product"], template="What is a good name for a company that makes {product}?",

)

Créer une chaîne

Nous créons une instance de la classe « LLMChain », en utilisant un modèle de langage large OpenAI prédéfini et un modèle d'invite spécifié. Nous avons désormais la possibilité d'appliquer la chaîne à un produit tel qu'un « ordinateur portable de jeu » à l'aide de la commande chain.run. Cela signifie que la chaîne peut traiter et générer de manière dynamique des réponses adaptées à cet intrant de produit spécifique.

from langchain.chains import LLMChain

chain = LLMChain(llm=llm, prompt=prompt, verbose=True) print(chain.run("gaming laptop"))Sortie :

Sur cette base, nous obtenons le nom d’une société appelée « GamerTech Laptops ».

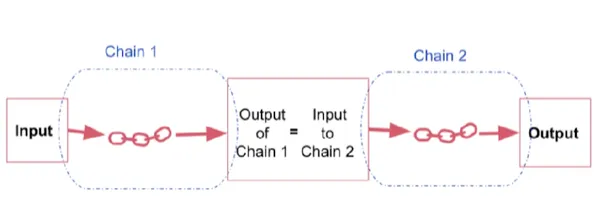

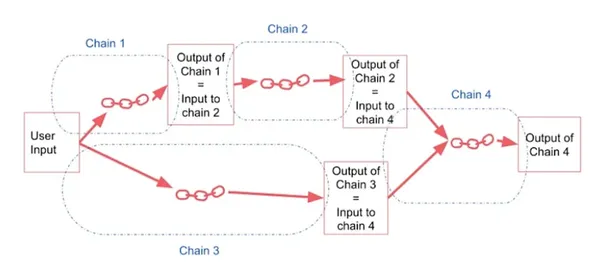

Chaîne séquentielle

Une chaîne séquentielle est une chaîne qui combine plusieurs chaînes individuelles, où la sortie d'une chaîne sert d'entrée à la suivante dans une séquence continue. Il fonctionne en faisant fonctionner une série de chaînes consécutivement.

Il existe deux types de chaînes séquentielles :

Chaîne séquentielle simple, qui gère une seule entrée et sortie, et

Chaîne séquentielle, gérez plusieurs entrées et sorties simultanément.

- Une chaîne séquentielle fusionne plusieurs chaînes en utilisant la sortie d’une chaîne comme entrée de la suivante.

- Il fonctionne en exécutant une série de chaînes consécutivement.

- Cette approche est utile lorsque vous devez utiliser le résultat d’une opération comme point de départ de la suivante, créant ainsi un flux transparent de processus.

Chaîne séquentielle simple

Les chaînes séquentielles, dans leur forme la plus simple, sont constituées d'étapes où chaque étape prend une entrée et produit une sortie. Le résultat d’une étape devient l’entrée de la suivante.

Cette approche simple est efficace lorsqu’il s’agit de sous-chaînes conçues pour des entrées et des sorties uniques. Il garantit un flux d'informations fluide et continu, chaque étape transmettant de manière transparente sa sortie à l'étape suivante.

Chaînes d'artisanat – Chaînes séquentielles simples

Les chaînes séquentielles simples permettent à une seule entrée de subir une série de transformations cohérentes, aboutissant à une sortie raffinée. Cette approche séquentielle garantit un traitement systématique et efficace des données, ce qui la rend idéale pour les scénarios où un flux linéaire de traitement de l'information est essentiel.

Importation des bibliothèques nécessaires

from langchain.llms import OpenAI

from langchain.chains import LLMChain

from langchain.prompts import PromptTemplate

from langchain.prompts import ChatPromptTemplate

from langchain.chains import SimpleSequentialChain

Initialisation et chaînage

Nous initialisons un OpenAI Large Language Model avec un réglage de température de 0.7 et une clé API. Ensuite, nous créons un modèle d'invite de discussion spécifique avec un espace réservé pour un nom de produit. Par la suite, nous formons une LLMChain, qui permet la génération de réponses basées sur l'invite fournie. Nous répétons ce processus pour deux chaînes différentes.

# This is an LLMChain to write first chain. llm = OpenAI(temperature=0.7, openai_api_key=OPENAI_API_KEY)

first_prompt = ChatPromptTemplate.from_template( "What is the best name to describe a company that makes {product}?"

)

chain_one = LLMChain(llm=llm, prompt=first_prompt) # This is an LLMChain to write second chain. llm = OpenAI(temperature=0.7, openai_api_key=OPENAI_API_KEY)

second_prompt = ChatPromptTemplate.from_template( "Write a 20 words description for the following company:{company_name}"

)

chain_two = LLMChain(llm=llm, prompt=second_prompt)

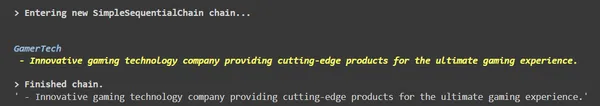

Enchaîner deux chaînes

Créez une chaîne séquentielle simple globale, comprenant deux chaînes individuelles différentes, chain_one et chain_two. Exécutez ceci avec l'entrée « ordinateur portable de jeu », il traite séquentiellement l'entrée à travers les chaînes définies et fournit une sortie qui démontre l'exécution séquentielle étape par étape des chaînes.

overall_simple_chain = SimpleSequentialChain(chains=[chain_one, chain_two], verbose=True )

overall_simple_chain.run("gaming laptop")Sortie :

Chaîne séquentielle

Toutes les chaînes séquentielles ne fonctionnent pas avec une seule entrée et sortie de chaîne. Dans des configurations plus complexes, ces chaînes gèrent plusieurs entrées et génèrent plusieurs sorties finales. La dénomination soignée des variables d’entrée et de sortie revêt une importance importante dans ces chaînes complexes.

Une forme plus générale de chaînes séquentielles permet plusieurs entrées/sorties. N’importe quelle étape de la chaîne peut nécessiter plusieurs entrées.

Chaînes d'artisanat – Chaînes séquentielles

Importation des bibliothèques nécessaires

from langchain.llms import OpenAI

from langchain.chains import LLMChain

from langchain.prompts import PromptTemplate

from langchain.prompts import ChatPromptTemplate

from langchain.chains import SequentialChain llm = OpenAI(temperature=0.7, openai_api_key=OPENAI_API_KEY)

Initialisation et chaînage

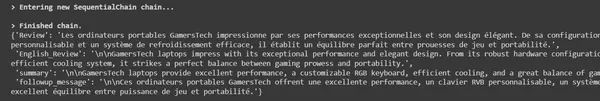

Nous définissons un modèle d'invite, demandant au système d'effectuer une tâche spécifique. Nous créons ensuite une LLMChain correspondante, en utilisant le grand modèle linguistique (LLM) désigné et le modèle d'invite défini. La chaîne est configurée pour prendre l'entrée, la transmettre via le LLM et générer la sortie. Nous répétons ce processus pour établir quatre chaînes distinctes.

Review = "Les ordinateurs portables GamersTech impressionne par ses performances exceptionnelles et son design élégant. De sa configuration matérielle robuste à un clavier RVB personnalisable et un système de refroidissement efficace, il établit un équilibre parfait entre prouesses de jeu et portabilité." # prompt template 1: translate to English first_prompt = ChatPromptTemplate.from_template( "Translate the following review to english:" "nn{Review}"

) # chain 1: input= Review and output= English_Review chain_one = LLMChain(llm=llm, prompt=first_prompt, output_key="English_Review" ) # prompt template 2: Summarize the English review second_prompt = ChatPromptTemplate.from_template( "Can you summarize the following review in 1 sentence:" "nn{English_Review}"

) # chain 2: input= English_Review and output= summary chain_two = LLMChain(llm=llm, prompt=second_prompt, output_key="summary" )

# prompt template 3: translate to English third_prompt = ChatPromptTemplate.from_template( "What language is the following review:nn{Review}"

) # chain 3: input= Review and output= language chain_three = LLMChain(llm=llm, prompt=third_prompt, output_key="language" )

# prompt template 4: follow up message fourth_prompt = ChatPromptTemplate.from_template( "Write a follow up response to the following " "summary in the specified language:" "nnSummary: {summary}nnLanguage: {language}"

) # chain 4: input= summary, language and output= followup_message chain_four = LLMChain(llm=llm, prompt=fourth_prompt, output_key="followup_message" )

Enchaîner deux chaînes

Une chaîne séquentielle globale nommée « overall_chain » est créée, incorporant quatre chaînes individuelles « chain_one », « chain_two », « chain_two » et « chain_four ». La variable d'entrée « Review » est traitée via ces chaînes, générant trois variables de sortie distinctes : « English_Review », « summary » et « followup_message ». La « overall_chain » exécute l'examen des entrées à travers les chaînes spécifiées et produit ces sorties, facilitant un flux de traitement structuré et séquentiel avec des sorties détaillées.

overall_chain = SequentialChain( chains=[chain_one, chain_two, chain_three, chain_four], input_variables=["Review"], output_variables=["English_Review", "summary","followup_message"], verbose=True

)

overall_chain(Review)

Sortie

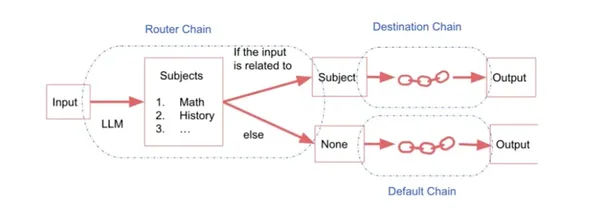

Chaîne de routeur

La chaîne de routeurs est utilisée pour des tâches complexes. Si nous avons plusieurs sous-chaînes, chacune étant spécialisée pour un type d’entrée particulier, nous pourrions avoir une chaîne de routeurs qui décide à quelle sous-chaîne transmettre l’entrée.

Cela consiste en:

- Chaîne de routeur : Il est responsable de la sélection de la prochaine chaîne à appeler.

- Chaînes de destination : Chaînes vers lesquelles la chaîne de routeurs peut acheminer.

- Chaîne par défaut : Utilisé lorsque le routeur ne peut pas décider quelle sous-chaîne utiliser.

Cela implique de diriger une entrée vers une chaîne spécifique en fonction de la nature exacte de cette entrée. Lorsqu’il existe plusieurs sous-chaînes, chacune adaptée à des types d’entrée distincts, une chaîne de routeurs entre en jeu. Cette chaîne de routeurs agit en tant que décideur, déterminant à quelle sous-chaîne spécialisée envoyer l’entrée. Essentiellement, il permet le routage transparent des entrées vers les sous-chaînes appropriées, garantissant un traitement efficace et précis basé sur les caractéristiques spécifiques de l'entrée.

Chaînes d'artisanat – Chaîne de routeur

Importation des bibliothèques nécessaires

from langchain.chains.router import MultiPromptChain

from langchain.chains.router.llm_router import LLMRouterChain,RouterOutputParser

from langchain.prompts import PromptTemplate llm = OpenAI(temperature=0.7, openai_api_key=OPENAI_API_KEY)Définir des modèles d'invite

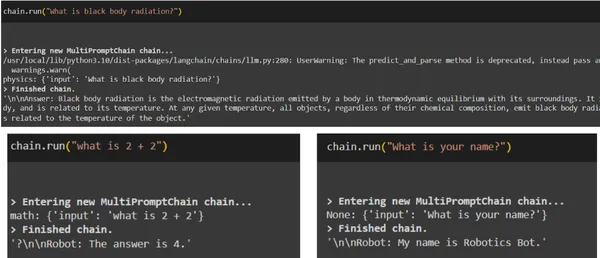

Considérons un scénario dans lequel nous devons diriger les entrées vers des chaînes spécialisées basées sur des matières telles que les mathématiques, la physique, l'histoire ou l'informatique. Pour ce faire, nous créons des invites distinctes pour chaque sujet : une pour les questions de physique, une autre pour les requêtes mathématiques, une troisième pour les questions d'histoire et une quatrième pour les questions liées à l'informatique. Nous concevons méticuleusement ces invites pour répondre aux besoins uniques de chaque domaine.

physics_template = """You are a very smart physics professor. You are great at answering questions about physics in a concise

and easy to understand manner. When you don't know the answer to a question you admit

that you don't know. Here is a question:

{input}""" math_template = """You are a very good mathematician. You are great at answering math questions. You are so good because you are able to break down hard problems into their component parts,

answer the component parts, and then put them together

to answer the broader question. Here is a question:

{input}""" history_template = """You are a very good historian. You have an excellent knowledge of and understanding of people,

events and contexts from a range of historical periods. You have the ability to think, reflect, debate, discuss and evaluate the past. You have a respect for historical evidence

and the ability to make use of it to support your explanations and judgements. Here is a question:

{input}"""

De plus, des informations détaillées, notamment des noms et des descriptions, peuvent être jointes à ces modèles d'invite. Ce contexte supplémentaire fournit une compréhension complète de l'objectif de chaque modèle. Ces informations sont ensuite fournies à la chaîne de routeurs. La chaîne de routeurs détermine ensuite vers quelle sous-chaîne acheminer en fonction du sujet spécifique, garantissant que le modèle d'invite approprié est utilisé pour des réponses précises et efficaces.

# Defining the prompt templates

prompt_infos = [ { "name": "physics", "description": "Good for answering questions about physics", "prompt_template": physics_template }, { "name": "math", "description": "Good for answering math questions", "prompt_template": math_template }, { "name": "History", "description": "Good for answering history questions", "prompt_template": history_template }

]

Création de chaînes de destination

Ensuite, nous nous concentrons sur la création de chaînes de destination. Ces chaînes sont activées par RouterChain, fonctionnant comme des chaînes de modèles de langage individuelles, en particulier des chaînes LLM. De plus, une chaîne par défaut est décrite pour gérer les situations dans lesquelles le routeur rencontre une ambiguïté et ne peut pas déterminer la sous-chaîne appropriée à utiliser. Cette chaîne par défaut agit comme une option de repli, garantissant une réponse même en cas d'indécision.

destination_chains = {}

for p_info in prompt_infos: name = p_info["name"] prompt_template = p_info["prompt_template"] prompt = ChatPromptTemplate.from_template(template=prompt_template) chain = LLMChain(llm=llm, prompt=prompt) destination_chains[name] = chain destinations = [f"{p['name']}: {p['description']}" for p in prompt_infos]

destinations_str = "n".join(destinations)

Création d'un modèle de routeur à invites multiples

Nous établissons un modèle guidant le LLM dans la direction des interactions entre les différentes chaînes. Ce modèle décrit non seulement les instructions de tâche spécifiques, mais dicte également le format précis auquel le résultat doit respecter, garantissant ainsi un mécanisme de réponse standardisé et cohérent.

MULTI_PROMPT_ROUTER_TEMPLATE = """Given a raw text input to a language model select the model prompt best suited for the input. You will be given the names of the available prompts and a description of what the prompt is best suited for. You may also revise the original input if you think that revising

it will ultimately lead to a better response from the language model. << FORMATTING >>

Return a markdown code snippet with a JSON object formatted to look like:

```json

{{{{ "destination": string name of the prompt to use or "DEFAULT" "next_inputs": string a potentially modified version of the original input

}}}}

``` REMEMBER: "destination" MUST be one of the candidate prompt names specified below OR it can be "DEFAULT" if the input is not

well suited for any of the candidate prompts.

REMEMBER: "next_inputs" can just be the original input if you don't think any modifications are needed. << CANDIDATE PROMPTS >>

{destinations} << INPUT >>

{{input}} << OUTPUT (remember to include the ```json)>>"""

Création d'une chaîne par défaut

Un modèle d'invite prédéfini est établi pour s'adapter à tous les types de texte saisi. Une LLMChain associée, nommée « default_chain », est ensuite créée à l'aide du grand modèle linguistique désigné et de l'invite prédéfinie. Cette configuration permet au Large Language Model de générer des réponses basées sur n'importe quel texte d'entrée fourni.

default_prompt = ChatPromptTemplate.from_template("{input}")

default_chain = LLMChain(llm=llm, prompt=default_prompt)Création d'un modèle de routeur

À l'avenir, un modèle de routeur flexible est développé, englobant une gamme de catégories telles que la physique, les mathématiques, l'histoire et l'informatique. À partir de ce modèle, un modèle d'invite distinct adapté au routeur est créé. À l'aide de ce modèle personnalisé, une chaîne de routeurs est établie, utilisant le modèle en grand langage et l'invite de routeur correspondante.

Pour améliorer les capacités de prise de décision, un analyseur de sortie du routeur est introduit. Cet analyseur aide la chaîne de routeurs à naviguer efficacement entre les sous-chaînes. Cet arrangement complet garantit que les intrants sont dirigés précisément vers des sous-chaînes spécifiques, conduisant à des réponses précises et ciblées dans diverses catégories de destinations.

router_template = MULTI_PROMPT_ROUTER_TEMPLATE.format( destinations=destinations_str

)

router_prompt = PromptTemplate( template=router_template, input_variables=["input"], output_parser=RouterOutputParser(),

) router_chain = LLMRouterChain.from_llm(llm, router_prompt)

Enchaîner tout ensemble

Une MultiPromptChain est créée, intégrant une chaîne de routeurs pour acheminer intelligemment les entrées vers des chaînes de destination spécifiques. De plus, une chaîne par défaut est incluse pour gérer les cas où la chaîne de routeurs peut rencontrer des ambiguïtés, garantissant ainsi un flux de traitement structuré et efficace avec une journalisation détaillée activée pour des informations détaillées.

chain = MultiPromptChain(router_chain=router_chain, destination_chains=destination_chains, default_chain=default_chain, verbose=True )Sortie

Cas d'utilisation réels de Langchain

Plongez dans les utilisations et les réalisations concrètes des solutions basées sur les grands modèles linguistiques (LLM), démontrant leur influence variée selon les secteurs. Au sein du support client, la collaboration entre LangChain et LLM a transformé les services grâce à la mise en œuvre de chatbots intelligents. Ces robots fournissent un support immédiat et personnalisé, gérant efficacement un afflux important de requêtes. En réduisant les temps d'attente, ils augmentent considérablement les niveaux de satisfaction des clients.

E-commerce

LangChain utilise la puissance des grands modèles linguistiques (LLM) pour améliorer le parcours d'achat. Les développeurs peuvent créer des applications qui comprennent les spécificités des produits, les goûts des utilisateurs et les modèles d'achat. En exploitant les capacités des LLM, ces plateformes proposent des recommandations de produits sur mesure, répondent aux demandes des clients et créent des descriptions de produits captivantes. Cela conduit à une augmentation des ventes et à des niveaux d’engagement client plus élevés.

Système de santé

LangChain révolutionne les soins et le diagnostic des patients grâce à des applications alimentées par de grands modèles linguistiques (LLM). Avec le soutien de LangChain, développez des assistants virtuels pour comprendre les demandes médicales. Ces assistants virtuels fournissent des informations précises, évaluent les patients en fonction des symptômes et accélèrent l'accès aux connaissances en matière de soins de santé. Cette avancée allège non seulement la charge de travail des professionnels de la santé, mais permet également aux patients de prendre des décisions éclairées concernant leur santé.

Génération de contenu

LangChain permet aux développeurs de créer des applications qui produisent du contenu imaginatif et contextuellement pertinent, notamment des articles de blog et des descriptions de produits. Ces applications soutiennent les créateurs de contenu en améliorant la créativité, en rationalisant le processus d'écriture et en maintenant la cohérence du ton et du style.

Les mises en œuvre pratiques présentées ici démontrent la polyvalence et l'impact des solutions pilotées par les grands modèles linguistiques (LLM) dans divers secteurs. Le potentiel de LangChain permet aux développeurs de créer des solutions innovantes, de rationaliser les opérations, d'améliorer l'engagement des utilisateurs et d'alimenter la croissance de l'entreprise. Les réussites abondent, allant d'une diminution significative des délais de résolution des tickets d'assistance à des taux de satisfaction client plus élevés pour les chatbots de commerce électronique, mettant en valeur les avantages tangibles des applications basées sur LLM.

Conclusion

LangChain offre un vaste éventail d'opportunités pour développer des applications composées de capacités de modèle de langage étendu. Que vous vous concentriez sur des tâches telles que la complétion de texte, la traduction, l'analyse des sentiments, la synthèse de texte ou la reconnaissance d'entités nommées, LangChain constitue une solution polyvalente.

LangChain offre un cadre complet pour créer des applications puissantes grâce à des techniques de chaînage intelligentes. En comprenant les subtilités des différentes chaînes et leurs configurations, les développeurs peuvent créer des solutions sur mesure pour des tâches complexes. Le routage des entrées via des chaînes de routeurs ajoute une couche de prise de décision intelligente, garantissant que nous dirigeons les entrées vers les chemins de traitement les plus appropriés. Grâce à ces connaissances, les développeurs peuvent concevoir des applications innovantes dans tous les secteurs, rationalisant les processus, améliorant l'expérience utilisateur et, à terme, révolutionnant la façon dont nous interagissons avec le langage dans le domaine numérique.

Faits marquants

- LLMChain, la forme de chaîne la plus simple de LangChain, transforme les entrées utilisateur à l'aide d'un PromptTemplate, fournissant ainsi un cadre fondamental et largement utilisé pour interagir avec les grands modèles linguistiques (LLM).

- Les chaînes séquentielles dans LangChain, que ce soit sous la forme de chaînes séquentielles simples ou de configurations plus complexes, garantissent que le résultat d'une étape sert d'entrée pour la suivante, simplifiant le processus et permettant des interactions complexes dans diverses applications.

- La chaîne de routeurs de LangChain sert de décideur intelligent, dirigeant des entrées spécifiques vers des sous-chaînes spécialisées. Ce routage transparent améliore l'efficacité des tâches en faisant correspondre les entrées avec les chaînes de traitement les plus adaptées.

Foire aux Questions

A1 : LangChain est une technologie sophistiquée qui exploite les grands modèles linguistiques (LLM) pour rationaliser les tâches de traitement linguistique. Il intègre divers composants tels que LLMChains et Router Chains, permettant un routage transparent des tâches et un traitement efficace, conduisant au développement d'applications intelligentes.

A2 : LLMChain est un élément fondamental de LangChain. Il fonctionne en employant un PromptTemplate pour formater les entrées utilisateur, en les transmettant à un LLM pour traitement. L'OutputParser facultatif affine la sortie, garantissant qu'elle s'aligne sur le format souhaité, faisant de LLMChain un outil essentiel pour la génération de langage cohérent.

A3 : Les chaînes séquentielles combinent diverses sous-chaînes, permettant à la sortie de l’une de servir d’entrée à la suivante. Les chaînes séquentielles simples gèrent des entrées et des sorties uniques, tandis que les chaînes séquentielles plus complexes gèrent simultanément plusieurs entrées et sorties, rationalisant ainsi le flux d'informations dans les applications LangChain.

A4 : Les chaînes de routeurs sont essentielles pour les tâches complexes avec plusieurs sous-chaînes spécialisées. Ils déterminent quelle sous-chaîne acheminer les entrées en fonction de caractéristiques spécifiques. La chaîne de routeurs, ainsi que les chaînes de destination et une chaîne par défaut, dirigent efficacement les entrées vers la sous-chaîne la plus appropriée, garantissant un traitement précis.

Les médias présentés dans cet article n'appartiennent pas à Analytics Vidhya et sont utilisés à la discrétion de l'auteur.

Services Connexes

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.analyticsvidhya.com/blog/2023/10/a-comprehensive-guide-to-using-chains-in-langchain/