Cet article est rédigé en collaboration avec Balaji Chandrasekaran, Jennifer Cwagenberg, Andrew Sansom et Eiman Ebrahimi de Protopia AI.

De nouveaux et puissants modèles de langage étendus (LLM) font évoluer rapidement les entreprises, améliorant ainsi l'efficience et l'efficacité pour une variété de cas d'utilisation en entreprise. La rapidité est essentielle, et l'adoption des technologies LLM peut faire ou défaire l'avantage concurrentiel d'une entreprise. AWS est particulièrement bien adapté pour fournir aux entreprises les outils nécessaires au déploiement de LLM à grande échelle afin de permettre une prise de décision critique.

Dans leur mise en œuvre de la technologie d’IA générative, les entreprises ont de réelles préoccupations quant à l’exposition des données et à la propriété des informations confidentielles susceptibles d’être envoyées aux LLM. Ces préoccupations en matière de confidentialité et de protection des données peuvent ralentir ou limiter l'utilisation des LLM dans les organisations. Les entreprises ont besoin d'un moyen responsable et plus sûr pour envoyer des informations sensibles aux modèles sans avoir à assumer les frais généraux souvent prohibitifs du DevOps sur site.

L'article décrit comment vous pouvez surmonter les défis liés à la conservation de la propriété des données et à la préservation de la confidentialité des données tout en utilisant les LLM en déployant Stained Glass Transform de Protopia AI pour protéger vos données. Protopie IA s'est associé à AWS pour fournir le composant essentiel de la protection et de la propriété des données pour une adoption sécurisée et efficace par l'entreprise de l'IA générative. Cet article présente la solution et montre comment elle peut être utilisée dans AWS pour des cas d'utilisation courants en entreprise tels que Récupération Génération Augmentée (RAG) et avec des LLM de pointe comme Llama 2.

Présentation de la transformation du vitrail

Les organisations cherchent à conserver la pleine propriété et le contrôle de leurs données sensibles. Il s’agit d’un pilier d’une IA responsable et d’une exigence émergente en matière de protection des données et de confidentialité qui va au-delà de la sécurité de base et des garanties juridiques des fournisseurs de LLM.

Bien que les unités commerciales de l'entreprise souhaitent utiliser les LLM pour diverses tâches, elles sont également préoccupées par les secrets commerciaux, la propriété intellectuelle et d'autres informations exclusives qui fuient via les données envoyées à ces modèles. Dans le même temps, les services de sécurité, de conformité, de gestion des données et d’information des entreprises craignent d’exposer ou de divulguer des informations client en texte brut ou d’autres données réglementées en dehors de l’entreprise. AWS et Protopia AI s'associent pour fournir le composant critique qui répond à ce besoin commun des entreprises clientes.

Stained Glass Transform (SGT) de Protopia AI résout ces défis en convertissant les données d'entreprise non protégées en une re-représentation aléatoire, appelée données RmoRed, comme le montre la figure suivante. Cette représentation est une intégration stochastique des données d'origine, préservant les informations dont le LLM cible a besoin pour fonctionner sans exposer d'invites ou de requêtes sensibles, de contexte ou de données de réglage fin. Cette re-représentation est une transformation à sens unique qui ne peut être inversée, garantissant la confidentialité globale des données de l'entreprise et la protection contre la fuite d'informations sensibles en texte brut vers les LLM. L'applicabilité de SGT ne se limite pas aux modèles de langage. Des re-représentations aléatoires peuvent également être générées pour des données visuelles et structurées. Le nom Stained Glass Transform est ancré dans l'apparence visuelle de re-représentations aléatoires de données visuelles qui peuvent ressembler à la visualisation des données à travers un vitrail, comme le démontre ce document. Cas d'utilisation de l'US Navy.

SGT fonctionne avec des LLM de pointe tels que Llama 2. La figure suivante montre un exemple d'application de SGT à un modèle Llama 2 pour le suivi des instructions tout en ajoutant une couche de protection à l'instruction et au contexte. Le côté gauche de la figure montre un exemple de document financier comme contexte, avec l'instruction demandant au modèle de résumer le document. En bas à gauche, la réponse générée par Llama 2 lors de l'utilisation de l'invite brute est affichée. Lors de l'utilisation de SGT, les intégrations associées à cette invite sont transformées côté client en intégrations stochastiques, comme décrit plus en détail plus loin dans cet article. L'image en bas à droite montre que Llama 2 peut toujours générer une réponse correcte si les données RmoRed (intégrations post-transformation) sont envoyées à la place des intégrations non protégées. L'angle supérieur droit montre qu'en cas de fuite des données RmoRed, une reconstruction de l'invite d'origine entraînerait un texte inintelligible.

Pour créer un SGT pour un modèle donné tel que Llama 2, Protopia AI fournit une bibliothèque légère appelée Stained Glass SDK, qui est une extension de PyTorch. Comme le montre la figure suivante, une fois un SGT créé, il peut être intégré aux pipelines de déploiement de plusieurs manières. La transformation créée à partir du SDK peut être déployée localement, dans une configuration hybride ou entièrement sur le cloud. Cela est possible car SGT est conçu pour être un processus léger nécessitant très peu de ressources de calcul et, en tant que tel, a un impact minimal sur le chemin critique d'inférence. Une autre évaluation clé est la conservation de la précision du modèle à l’aide de données rereprésentées. Nous observons que, pour différents types de données et variations de modèle, la précision est conservée dans les limites de tolérance souhaitables lors de l'utilisation de données rereprésentées.

Ces options de déploiement et de maintien de la précision permettent une adoption en toute confiance de SGT par toutes les parties prenantes au sein d'une organisation d'entreprise. Pour protéger davantage la sortie du LLM, Protopia AI peut coder les sorties de requête dans une représentation dont le décodeur n'est disponible que pour le propriétaire des données de l'entreprise.

Vue d'ensemble de la solution

La section précédente décrit comment utiliser Stained Glass Transform dans diverses architectures. La figure suivante détaille les étapes impliquées dans la création, le déploiement et l'utilisation de SGT for LLM :

- Création SGT – L'équipe qui forme le modèle de base LLM de base (fournisseurs de LLM propriétaires, fournisseur de services cloud ou équipes ML d'entreprise créant leurs propres LLM) exécute le logiciel Stained Glass SDK de Protopia AI sans modifier leurs pratiques existantes de formation et de déploiement du LLM. Une fois la formation du modèle de base terminée, le SDK s'exécute comme une passe d'optimisation sur le modèle de langage pour calculer le SGT. Cette passe d'optimisation est fournie via une extension de PyTorch. Le SDK enveloppe le modèle de base et découvre mathématiquement une transformation de vitrail unique pour ce LLM. De plus amples détails sur les mathématiques sous-jacentes peuvent être trouvés dans le livre blanc d'accompagnement. Notez que, étant donné que l'équipe qui forme le LLM elle-même exécute également le SDK Stained Glass, aucune exposition ni envoi de poids de modèle n'est nécessaire pour que cette étape soit terminée.

- Publication et déploiement du SGT – Le SGT issu de l'étape d'optimisation précédente est déployé dans le cadre du pipeline de données qui alimente le LLM formé. Comme décrit dans la section précédente, le SGT siège du côté des entreprises clientes.

- Utilisation du SGT – Le SGT s'exécute sur les invites créées par l'entreprise et génère des invites protégées, qui sont envoyées au LLM déployé. Cela permet à l’entreprise de conserver la propriété de ses requêtes et de son contexte sensibles. Grâce à Protopia AI Stained Glass, les données sensibles non protégées ne quittent pas le site ou la zone de confiance de l'entreprise.

Vous pouvez utiliser le SDK Stained Glass pour créer un SGT de plusieurs manières. Par exemple, vous pouvez utiliser le SDK Stained Glass dans des environnements d'apprentissage automatique (ML) autogérés avec Service Amazon Elastic Kubernetes (Amazon EKS) pour la formation et l'inférence ou dans Cloud de calcul élastique Amazon (Amazon EC2) directement. Une autre option est qu'il peut s'exécuter dans Amazon Sage Maker pour créer un SGT pour un modèle entraîné donné. La transformation de l'entrée pour le déploiement lors de l'inférence du client est indépendante de l'implémentation de déploiement choisie.

La figure suivante illustre une implémentation possible dans un environnement ML autogéré où la formation d'une transformation Stained Glass est effectuée sur Amazon EKS.

Dans ce workflow, un conteneur est créé à l'aide du SDK Stained Glass et déployé sur Registre des conteneurs élastiques Amazon (AmazonECR). Ce conteneur est ensuite déployé sur Amazon EKS pour former un SGT enregistré dans Service de stockage simple Amazon (Amazon S3). Si vous utilisez Amazon EC2, vous pouvez entraîner une transformation directement sur votre instance dans le cadre de votre configuration ML. Le SDK Stained Glass peut s'exécuter sur différents types d'instances, notamment les familles d'instances Amazon P5, P4 ou G5, en fonction de vos exigences LLM de base. Une fois le LLM déployé pour être utilisé à des fins d'inférence, l'application client utilise le SGT créé, qui est une opération légère, pour transformer les invites et le contexte avant de les envoyer au LLM. Ce faisant, seules les données transformées sont exposées au LLM et la propriété de l'entrée d'origine est conservée côté client.

La figure suivante montre comment entraîner une transformation et exécuter une inférence sur SageMaker.

La création du SGT suit un chemin similaire à celui de la configuration d'Amazon EKS en ingérant les données de formation d'Amazon S3, en entraînant un SGT sur un conteneur et en l'enregistrant sur Amazon S3. Vous pouvez utiliser le SDK Stained Glass dans votre configuration SageMaker existante avec Amazon SageMakerStudio, Carnets SageMakerEt un Emploi de formation SageMaker. Le LLM est hébergé en tant que point de terminaison SageMaker accessible par l'application client. L'inférence pour l'application client est également identique à la configuration Amazon EKS, à l'exception de ce qui sert le modèle.

Re-représentations aléatoires pour protéger les invites LLM et affiner les données

Cette section couvre une variété de cas d'utilisation démontrant comment la rereprésentation aléatoire protège les invites LLM. Les exemples illustrent les implications majeures pour les efforts d'IA générative des entreprises : ouvrir de nouvelles portes aux cas d'utilisation de l'IA, accélérer la mise sur le marché tout en protégeant correctement les données de l'entreprise et conserver la propriété des données sensibles requises pour une utilisation dans les invites LLM.

Cas d'utilisation de RAG

Un cas d’utilisation populaire des LLM en entreprise est la génération augmentée de récupération (RAG). La figure suivante montre un exemple illustratif dans lequel les invites et les sources sont protégées à l'aide de Vitrail. Le côté gauche de la figure montre les invites et les informations sources non protégées. Dans une implémentation de RAG en entreprise, les sources peuvent inclure des informations sensibles telles que des secrets commerciaux d'entreprise, des propriétés intellectuelles ou des informations financières. Le côté droit montre la meilleure reconstruction possible dans un texte lisible par l'homme à partir des invites RmoRed créées par le SGT.

Nous pouvons observer que même dans la meilleure reconstruction possible, l’information est complètement obscurcie. Cependant, la réponse du modèle avec et sans transformation est la même, avec des pointeurs vers les documents sources d'origine, préservant ainsi l'exactitude de la question et des documents sources tout en exécutant ce cas d'utilisation populaire en entreprise.

Large applicabilité dans tous les LLM et langues

L'un des points forts du SDK Stained Glass est qu'il est très résilient aux avancées de la modélisation et adaptable aux modèles de pointe tels que Llama 2. La figure suivante montre un SGT créé sur un Llama 2 LLM précédemment optimisé pour travailler avec du texte japonais. Cet exemple illustre en outre que les SGT peuvent être créés et appliqués pour n'importe quelle langue et que même les entrées de modèles affinés peuvent être transformées. L'applicabilité générale de SGT repose sur la base robuste du SDK Stained Glass, indépendant du modèle et des données.

Protection des données de réglage fin ainsi que des invites

Stained Glass Transform ne se limite pas uniquement à la protection des données au moment de l'inférence ; il peut également protéger les données utilisées pour affiner un modèle de fondation. Le processus de création de la transformation pour affiner les ensembles de données est le même que celui expliqué dans la section Architecture de la solution plus haut dans cet article. La transformation est créée pour affiner le modèle de base sans accéder aux données de réglage fin. Une fois que le SGT a été créé et formé pour le modèle de fondation, l'ensemble de données de réglage fin est transformé en rereprésentations aléatoires qui seront ensuite utilisées pour affiner le modèle de fondation. Ce processus est expliqué plus en détail dans le livre blanc d'accompagnement.

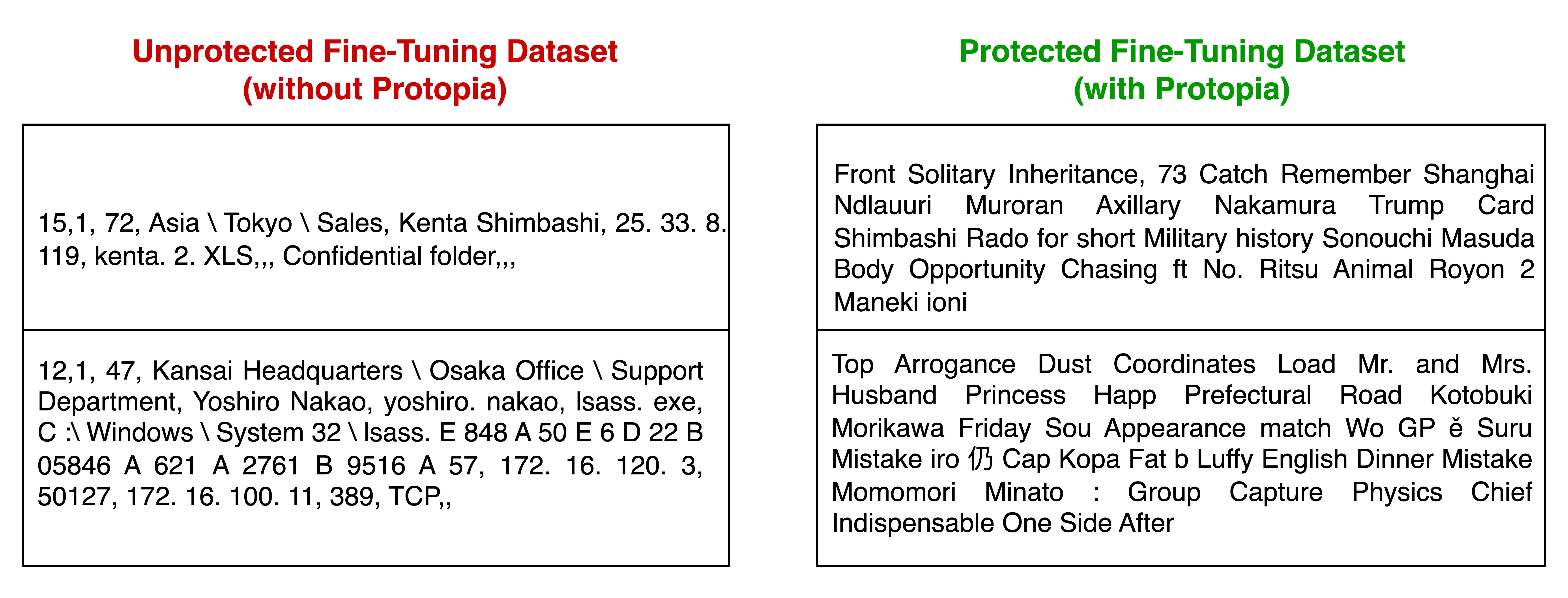

Dans l’exemple suivant, une entreprise cliente avait besoin d’affiner un modèle existant pour la détection des anomalies des journaux réseau. Ils ont utilisé Stained Glass pour transformer l'ensemble de données de réglage fin sensible en intégrations aléatoires, qui ont été utilisées pour affiner leur modèle de base. Ils ont constaté que le modèle de détection affiné sur les représentations transformées fonctionnait avec une précision presque identique par rapport au scénario hypothétique d’ajustement fin du modèle de base sur l’ensemble de données de réglage fin non protégé. Le tableau suivant présente deux exemples d'enregistrements de données en texte brut provenant de l'ensemble de données de réglage fin et une reconstruction en texte de ces mêmes enregistrements de données de l'ensemble de données de réglage fin.

Sous le capot de Stained Glass Transform pour les LLM

Lorsqu'il est appliqué à la vision par ordinateur, SGT fonctionne sur les caractéristiques des pixels d'entrée et pour les LLM, il fonctionne au niveau de l'intégration. Pour mettre en évidence le fonctionnement de Stained Glass Transform, imaginez les incorporations d'invites sous forme de matrice, comme illustré à gauche de la figure suivante. Dans chaque entrée, il y a une valeur déterministe. Cette valeur peut être mappée aux données d'origine, exposant ainsi l'invite non protégée. Stained Glass Transform convertit cette matrice de valeurs déterministes en une matrice dont les éléments sont un nuage de possibilités.

L'invite transformée est rendue en échantillonnant le bruit à partir de distributions de probabilité définies par le SGT et en ajoutant le bruit échantillonné aux incorporations déterministes, ce qui rend aléatoire les valeurs d'invite d'origine de manière irréversible. Le modèle comprend toujours l'invite re-représentée aléatoirement au niveau mathématique et peut effectuer sa tâche avec précision.

Conclusion

Cet article explique comment Stained Glass Transform de Protopia AI dissocie la propriété et la protection des données brutes du processus d'opérations de ML, permettant aux entreprises de conserver la propriété et de préserver la confidentialité des informations sensibles dans les invites LLM et d'affiner les données. En utilisant cette protection des données de pointe pour l'utilisation du LLM, les entreprises peuvent accélérer l'adoption des modèles de base et des LLM en se souciant moins de l'exposition des informations sensibles. En libérant en toute sécurité la valeur des données réelles de l'entreprise, les organisations peuvent réaliser les gains d'efficacité et les résultats commerciaux promis par les LLM plus efficacement et plus rapidement. Pour en savoir plus sur cette technologie, vous pouvez trouver des lectures complémentaires dans le livre blanc d'accompagnement ainsi que connectez-vous avec Protopia AI pour y accéder et l'essayer sur les données de votre entreprise.

À propos de Protopia AI

Protopia AI est un leader en matière de technologies d'IA/ML de protection des données et de préservation de la confidentialité, basé à Austin, au Texas, et se spécialise dans la manière de permettre aux algorithmes d'IA et aux plates-formes logicielles de fonctionner sans avoir besoin d'accéder à des informations en texte brut. Au cours des deux dernières années, Protopia AI a démontré avec succès son produit phare Stained Glass Transform dans une variété de cas d'utilisation et de types de données de ML auprès de l'US Navy, des principaux services financiers et des fournisseurs de technologie mondiaux.

Protopia AI travaille avec des entreprises, des fournisseurs d'IA générative et de LLM et des fournisseurs de services cloud (CSP) pour permettre de maintenir la propriété et la confidentialité des données d'entreprise tout en utilisant des solutions d'IA/ML. Protopia AI s'est associé à AWS pour fournir un élément essentiel de protection et de propriété des données pour l'adoption par les entreprises de l'IA générative, et a été l'une des 21 startups sélectionnées pour la première édition. Accélérateur d'IA générative AWS en 2023.

À propos des auteurs

Balaji Chandrasekaran est vice-président de la commercialisation et de l'assistance client chez Protopia AI, travaille en étroite collaboration avec les clients pour tirer parti de l'IA dans leur entreprise tout en donnant la priorité à la protection des données et à la confidentialité. Avant de rejoindre Protopia AI, Balaji était chef de produit pour les solutions d'IA chez Infor, développant des produits axés sur la valeur tout en agissant en tant que partenaire de confiance pour les entreprises clientes de divers secteurs. En dehors du travail, il aime la musique, la randonnée et les voyages en famille.

Balaji Chandrasekaran est vice-président de la commercialisation et de l'assistance client chez Protopia AI, travaille en étroite collaboration avec les clients pour tirer parti de l'IA dans leur entreprise tout en donnant la priorité à la protection des données et à la confidentialité. Avant de rejoindre Protopia AI, Balaji était chef de produit pour les solutions d'IA chez Infor, développant des produits axés sur la valeur tout en agissant en tant que partenaire de confiance pour les entreprises clientes de divers secteurs. En dehors du travail, il aime la musique, la randonnée et les voyages en famille.

Jennifer Cwagenberg dirige l'équipe d'ingénierie de Protopia AI et veille à ce que la technologie Stained Glass réponde aux besoins de ses clients en matière de protection de leurs données. Jennifer a une expérience préalable en matière de sécurité en travaillant chez Toyota au sein de leur groupe de cybersécurité des produits, en gérant les charges de travail cloud chez N-able et en étant responsable des données chez Match.com.

Jennifer Cwagenberg dirige l'équipe d'ingénierie de Protopia AI et veille à ce que la technologie Stained Glass réponde aux besoins de ses clients en matière de protection de leurs données. Jennifer a une expérience préalable en matière de sécurité en travaillant chez Toyota au sein de leur groupe de cybersécurité des produits, en gérant les charges de travail cloud chez N-able et en étant responsable des données chez Match.com.

Andrew Sansom est ingénieur en solutions IA chez Protopia AI où il aide les entreprises à utiliser l'IA tout en préservant les informations privées et sensibles dans leurs données. Avant de rejoindre Protopia AI, il a travaillé en tant que consultant technique axé sur la mise en place de solutions d'IA pour des clients de nombreux secteurs, notamment la finance, la fabrication, la santé et l'éducation. Il a également enseigné l'informatique et les mathématiques à des étudiants du secondaire, de l'université et des professionnels.

Andrew Sansom est ingénieur en solutions IA chez Protopia AI où il aide les entreprises à utiliser l'IA tout en préservant les informations privées et sensibles dans leurs données. Avant de rejoindre Protopia AI, il a travaillé en tant que consultant technique axé sur la mise en place de solutions d'IA pour des clients de nombreux secteurs, notamment la finance, la fabrication, la santé et l'éducation. Il a également enseigné l'informatique et les mathématiques à des étudiants du secondaire, de l'université et des professionnels.

Eiman Ebrahimi, PhD, est co-fondateur et président-directeur général de Protopia AI. Le Dr Ebrahimi est passionné par l’idée de permettre à l’IA d’enrichir l’expérience humaine dans différents secteurs verticaux sociétaux et industriels. Protopia AI est une vision visant à améliorer la lentille à travers laquelle l'IA observe les données nécessaires et de qualité dont elle a besoin tout en créant de nouvelles capacités de protection des informations sensibles. Avant de rejoindre Protopia AI, il a été chercheur scientifique principal chez NVIDIA pendant 9 ans. Son travail au sein de NVIDIA Research visait à résoudre les problèmes d’accès à des ensembles de données massifs en ML/AI. Il a également co-écrit des publications évaluées par des pairs sur la manière d'utiliser la puissance de milliers de GPU pour rendre possible la formation de grands modèles de langage.

Eiman Ebrahimi, PhD, est co-fondateur et président-directeur général de Protopia AI. Le Dr Ebrahimi est passionné par l’idée de permettre à l’IA d’enrichir l’expérience humaine dans différents secteurs verticaux sociétaux et industriels. Protopia AI est une vision visant à améliorer la lentille à travers laquelle l'IA observe les données nécessaires et de qualité dont elle a besoin tout en créant de nouvelles capacités de protection des informations sensibles. Avant de rejoindre Protopia AI, il a été chercheur scientifique principal chez NVIDIA pendant 9 ans. Son travail au sein de NVIDIA Research visait à résoudre les problèmes d’accès à des ensembles de données massifs en ML/AI. Il a également co-écrit des publications évaluées par des pairs sur la manière d'utiliser la puissance de milliers de GPU pour rendre possible la formation de grands modèles de langage.

Rohit Talluri est un spécialiste Generative AI GTM chez Amazon Web Services (AWS). Il s'associe aux meilleurs créateurs de modèles d'IA générative, à des clients stratégiques, à des partenaires clés en IA/ML et aux équipes de service AWS pour permettre la prochaine génération d'intelligence artificielle, d'apprentissage automatique et de calcul accéléré sur AWS. Il était auparavant architecte de solutions d'entreprise et responsable des solutions mondiales pour AWS Mergers & Acquisitions Advisory.

Rohit Talluri est un spécialiste Generative AI GTM chez Amazon Web Services (AWS). Il s'associe aux meilleurs créateurs de modèles d'IA générative, à des clients stratégiques, à des partenaires clés en IA/ML et aux équipes de service AWS pour permettre la prochaine génération d'intelligence artificielle, d'apprentissage automatique et de calcul accéléré sur AWS. Il était auparavant architecte de solutions d'entreprise et responsable des solutions mondiales pour AWS Mergers & Acquisitions Advisory.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/foundational-data-protection-for-enterprise-llm-acceleration-with-protopia-ai/