Marley Stevens a posté une vidéo sur TikTok le semestre dernier, qu'elle a décrit comme un message d'intérêt public destiné à tout étudiant. Son message : n'utilisez pas de logiciel de vérification grammaticale si votre professeur risque de faire passer votre article via un système de détection d'IA.

Stevens est étudiante à l'Université de Géorgie du Nord et elle a été inhabituellement publique à propos de ce qu'elle appelle une « débâcle », dans laquelle elle a été accusée d'avoir utilisé l'IA pour rédiger un article qu'elle dit avoir rédigé elle-même, en utilisant une grammaire standard. et les fonctionnalités de vérification orthographique de Grammarly, qu'elle a installées en tant qu'extension sur son navigateur Web.

La première vidéo d'avertissement qu'elle a publiée a été visionnée plus de 5.5 millions de fois et elle a depuis réalisé plus de 25 vidéos de suivi répondant aux commentaires de ses abonnés et documentant sa bataille avec l'université sur ce problème, notamment en partageant des photos d'e-mails qui lui ont été envoyés. des doyens d'université et des images de ses travaux d'étudiants pour tenter de prouver son cas – pour sensibiliser à ce qu'elle considère comme des outils de détection d'IA défectueux qui sont de plus en plus sanctionnés par les collèges et utilisés par les professeurs.

Stevens dit qu'un professeur d'un cours de justice pénale qu'elle a suivi l'année dernière lui a donné un zéro sur un devoir parce qu'il a déclaré que le système de détection de l'IA de Turnitin l'avait signalé comme étant écrit par un robot. Stevens insiste sur le fait que le travail lui appartient entièrement et qu'elle n'a pas utilisé ChatGPT ou tout autre chatbot pour rédiger une quelconque partie de son article.

@m.stevens03 #granmerly #ai #intelligence artificielle #fyp #psa ♬ son original – Marley Stevens

En raison du zéro sur l'épreuve, dit-elle, sa note finale dans la classe est tombée à un niveau suffisamment bas pour l'empêcher de se qualifier pour un Bourse HOPE, qui oblige les étudiants à maintenir une moyenne cumulative de 3.0. Et elle dit que l'université l'a placée en probation académique pour avoir violé ses politiques en matière de mauvaise conduite académique, et qu'elle a dû payer 105 $ pour assister à un séminaire sur la tricherie.

L'université a refusé les demandes répétées d'EdSurge de parler de ses politiques d'utilisation de la détection par l'IA. Les responsables ont plutôt envoyé une déclaration disant que les lois fédérales sur la vie privée des étudiants les empêchent de commenter tout incident de triche individuel et que : « Notre faculté communique des directives spécifiques concernant l'utilisation de l'IA pour divers cours, et ces directives sont incluses dans les programmes de cours. L’utilisation inappropriée de l’IA est également abordée dans notre Code de conduite des étudiants. »

La section de ce code de conduite étudiant définit le plagiat comme : « Utilisation des idées ou des expressions d'une autre personne ou agence (y compris l'intelligence artificielle) sans en reconnaître la source. Les thèmes, essais, travaux de session, tests et autres exigences similaires doivent être l'œuvre de l'étudiant qui les soumet. Lorsque des citations directes ou des paraphrases sont utilisées, elles doivent être indiquées, et lorsque les idées d'autrui sont incorporées dans le document, elles doivent être reconnues de manière appropriée. Tout travail d'un étudiant doit être original ou cité selon les exigences de l'instructeur, sinon il est considéré comme du plagiat. Le plagiat comprend, sans toutefois s'y limiter, l'utilisation, par paraphrase ou citation directe, de l'œuvre publiée ou non publiée d'une autre personne sans une reconnaissance complète et claire. Cela inclut également l’utilisation non reconnue de documents préparés par une autre personne ou agence dans la vente de travaux de session ou d’autres documents académiques.

L’incident soulève des questions complexes quant à savoir où tracer les limites concernant les nouveaux outils d’IA. Quand aident-ils simplement de manière acceptable, et quand leur utilisation entraîne-t-elle une mauvaise conduite académique ? Après tout, de nombreuses personnes utilisent les fonctionnalités de correction automatique de grammaire et d’orthographe dans des systèmes tels que Google Docs et d’autres programmes qui suggèrent un mot ou une expression lors de la saisie des utilisateurs. Est-ce de la triche ?

Et comme ces fonctionnalités grammaticales deviennent plus robustes à mesure que les outils d’IA générative deviennent plus courants, les outils de détection de l’IA peuvent-ils éventuellement faire la différence entre une utilisation acceptable de l’IA et la triche ?

"Des professeurs de cette même université m'ont recommandé d'utiliser [Grammarly] pour mes devoirs", a déclaré Stevens dans une autre vidéo. « Alors, essaient-ils de nous dire que nous ne pouvons pas utiliser la correction automatique, le correcteur orthographique ou quoi que ce soit ? Que veulent-ils que nous fassions, que nous le saisissions dans une application Notes et que nous le transformions de cette façon ? »

Dans une interview avec EdSurge, l'étudiant l'a exprimé ainsi :

«Tout ce que je pense, c'est que les détecteurs d'IA sont des déchets et que nous, étudiants, ne pouvons pas faire grand-chose à ce sujet», dit-elle. "Et ce n'est pas juste parce que nous faisons tout ce travail et payons tout cet argent pour aller à l'université, et ensuite un détecteur d'IA peut gâcher toute votre carrière universitaire."

Rebondissements

En cours de route, l'histoire de cet étudiant de l'Université de Géorgie du Nord a pris des tournures surprenantes.

D’une part, l’université a envoyé un e-mail à tous les étudiants sur l’IA peu de temps après que Stevens ait publié sa première vidéo virale.

Cet e-mail rappelait aux étudiants de suivre le code de conduite académique de l'université, et contenait également un avertissement inhabituel : « Veuillez noter que certains outils en ligne utilisés pour aider les étudiants avec la grammaire, la ponctuation, la structure des phrases, etc., utilisent l'intelligence artificielle générative (IA). ); qui peut être signalé par Turnitin. L’un des sites Web d’IA générative les plus couramment signalés par Turnitin.com est Grammarly. Veuillez faire preuve de prudence lorsque vous examinez ces sites Web.

Le professeur a ensuite dit à l'étudiante qu'il avait également vérifié son article avec un autre outil, Copyleaks, et que celui-ci avait également signalé son article comme étant écrit par un robot. Et elle dit que lorsqu'elle a récemment publié son article sur Copyleaks, celui-ci a considéré que le travail avait été écrit par des humains. Elle a envoyé à ce journaliste une capture d’écran de ce processus, dans laquelle l’outil conclut, en texte vert : « Ceci est un texte humain ».

"Si je l'examine maintenant et que j'obtiens un résultat différent, cela montre simplement que ces choses ne sont pas toujours exactes", dit-elle à propos des détecteurs d'IA.

Les responsables de Copyleaks n'ont pas répondu aux demandes de commentaires. Stevens a refusé de partager le texte intégral de son article, expliquant qu'elle ne voulait pas qu'il se retrouve sur Internet où d'autres étudiants pourraient le copier et éventuellement lui causer davantage de problèmes avec son université. « Je suis déjà en probation académique », dit-elle.

Stevens dit avoir entendu des étudiants de tout le pays dire qu'ils avaient également été faussement accusés de tricherie à cause d'un logiciel de détection d'IA.

"Une étudiante a dit qu'elle voulait devenir médecin, mais elle a été accusée, et aucune école n'a voulu l'accepter à cause de son accusation de mauvaise conduite", explique Stevens.

Stevens dit qu'elle a été surprise par le soutien qu'elle a reçu de la part des personnes qui regardent ses vidéos. Ses abonnés sur les réseaux sociaux l'ont encouragée à créer un Campagne GoFundMe, ce qu'elle a fait pour couvrir la perte de sa bourse et pour payer les services d'un avocat afin d'éventuellement intenter une action en justice contre l'université. Jusqu’à présent, elle a récolté plus de 6,100 90 $ auprès de plus de XNUMX personnes.

Elle a également été surprise d'être contactée par des responsables de Grammarly, qui lui ont donné 4,000 XNUMX $ sur GoFundMe et l'ont embauchée comme étudiante ambassadrice. En conséquence, Stevens prévoit désormais de réaliser trois vidéos promotionnelles pour Grammarly, pour lesquelles elle recevra une somme modique pour chacune.

« À ce stade, nous essayons de travailler ensemble pour amener les collèges à repenser leurs politiques en matière d'IA », explique Stevens.

Pour Grammarly, il semble clair que l'objectif est de changer le récit de cette première vidéo de Stevens, dans laquelle elle disait : « Si vous avez un article, un essai, un article de discussion, tout ce qui est soumis à TurnItIn, désinstallez Grammarly dès maintenant. .»

La responsable de l'éducation de Grammarly, Jenny Maxwell, dit qu'elle espère faire passer le message sur l'inexactitude des détecteurs d'IA.

« De nombreux établissements universitaires ignorent à quelle fréquence ces services de détection de l’IA sont erronés », dit-elle. « Nous voulons nous assurer que les institutions sont conscientes du danger que représente le fait d’avoir ces détecteurs d’IA comme source unique de vérité. »

De tels défauts ont été bien documenté, et plusieurs chercheurs ont déclaré que les professeurs ne devraient pas utiliser ces outils. Même Turnitin a déclaré publiquement que son outil de détection d'IA n'est pas toujours fiable.

Annie Chechitelli, directrice des produits chez Turnitin, affirme que ses outils de détection d'IA ont un taux de faux positifs d'environ 1 % selon les tests de l'entreprise, et qu'elle s'efforce de réduire ce taux le plus bas possible.

«Nous avons probablement laissé passer environ 15 pour cent [du texte écrit par un robot] sans être signalé», dit-elle. « Nous préférons diminuer notre précision plutôt que d’augmenter notre taux de faux positifs. »

Chechitelli souligne que les enseignants devraient utiliser le système de détection de Turnitin comme point de départ pour une conversation avec un étudiant, et non comme une décision finale sur l'intégrité académique du travail de l'étudiant. Et elle dit que c'est également le conseil de l'entreprise pour son système de détection de plagiat.

« Nous avons vraiment dû expliquer aux enseignants que cela ne constitue pas une preuve que l'élève a triché », dit-elle. "Nous avons toujours dit que c'était à l'enseignant de prendre une décision."

L’IA place cependant les éducateurs dans une position plus difficile pour cette conversation, reconnaît Chechitelli. Dans les cas où l'outil de Turnitin détecte un plagiat, le système pointe vers le matériel source que l'étudiant a pu copier. Dans le cas de la détection de l'IA, il n'y a pas de source claire à consulter, car des outils comme ChatGPT crachent des réponses différentes à chaque fois qu'un utilisateur saisit une invite, ce qui rend beaucoup plus difficile la preuve qu'un bot est la source.

Le responsable de Turnitin affirme que lors des tests internes de l'entreprise, les outils traditionnels de vérification grammaticale ne déclenchent pas ses alarmes.

Maxwell, de Grammarly, souligne que même si un système de détection par l'IA a raison dans 98 % des cas, cela signifie qu'il signale à tort, disons, 2 % des articles. Et comme une seule université peut rendre 50,000 1,000 devoirs d’étudiants chaque année, cela signifie que si tous les professeurs utilisaient un système de détection par IA, XNUMX XNUMX devoirs seraient faussement qualifiés de cas de tricherie.

Maxwell craint-elle que les universités découragent l’utilisation de son produit ? Après tout, l'Université de Géorgie du Nord a récemment supprimé Grammarly d'une liste de ressources recommandées après que les vidéos TikTok de Stevens soient devenues virales, bien qu'elles l'aient ensuite rajoutée.

"Nous avons rencontré des représentants de l'Université de Géorgie du Nord et ils ont dit que cela n'avait rien à voir avec Grammarly", explique Maxwell. « Nous sommes ravis de constater que de plus en plus de professeurs et d'étudiants penchent dans la direction opposée et disent : « Nous sommes dans le nouveau monde du travail et nous devons trouver l'utilisation appropriée de ces outils. » Vous ne pouvez pas remettre le dentifrice dans le tube.

Pour Tricia Bertram Gallant, directrice du Bureau d'intégrité académique de l'Université de Californie à San Diego et experte nationale en matière de tricherie, le problème le plus important dans le cas de cet étudiant ne concerne pas la technologie. Selon elle, la plus grande question est de savoir si les collèges disposent de systèmes efficaces pour traiter les accusations de mauvaise conduite académique.

"Je doute fort qu'un étudiant soit accusé de tricherie simplement à cause d'un vérificateur de grammaire et d'orthographe", dit-elle, "mais si c'est vrai, les chatbots IA ne sont pas le problème, le problème est la politique et le processus."

« Si un professeur peut utiliser un outil, accuser un étudiant et lui donner un zéro et que c'est fait, c'est un problème », dit-elle. "Ce n'est pas un problème d'outil."

Elle dit que sur le plan conceptuel, les outils d'IA ne sont pas différents des autres façons dont les étudiants trichent depuis des années, comme embaucher d'autres étudiants pour rédiger leurs devoirs à leur place.

« Cela me semble étrange que les collèges élaborent une politique entièrement distincte pour l'utilisation de l'IA », dit-elle. « Tout ce que nous avons fait dans notre politique, c'est d'ajouter le mot « machine » », ajoute-t-elle, soulignant que désormais la politique d'intégrité académique interdit explicitement l'utilisation d'une machine pour effectuer un travail censé être effectué par l'étudiant.

Elle suggère que les étudiants veillent à conserver une trace de la manière dont ils utilisent les outils qui les aident, même si un professeur autorise l'utilisation de l'IA dans le cadre du travail. "Ils doivent s'assurer qu'ils conservent leur historique de discussion" dans ChatGPT, dit-elle, "afin qu'une conversation puisse avoir lieu sur leur processus" si des questions sont soulevées ultérieurement.

Un paysage en évolution rapide

Bien que les vérificateurs de grammaire et d'orthographe existent depuis des années, nombre d'entre eux ajoutent désormais de nouvelles fonctionnalités d'IA qui compliquent les choses pour les professeurs qui tentent de comprendre si les étudiants ont réfléchi de manière pertinente au travail qu'ils rendent.

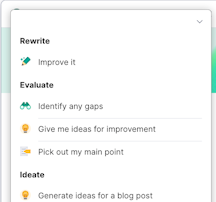

Par exemple, Grammarly propose désormais de nouvelles options, la plupart dans une version payante à laquelle Stevens n'est pas abonné, qui utilisent l'IA générative pour faire des choses comme « aider à réfléchir à des sujets pour un devoir » ou « élaborer un plan de recherche », comme un récent communiqué de presse de l'entreprise l'a dit.

Maxwell, de Grammarly, affirme que l'entreprise essaie de déployer ces nouvelles fonctionnalités avec soin et essaie d'intégrer des mesures de protection pour empêcher les étudiants de simplement demander au robot de faire leur travail à leur place. Et elle dit que lorsque les écoles adoptent son outil, elles peuvent désactiver les fonctionnalités d’IA générative. « Je suis parent d'un enfant de 14 ans », dit-elle, ajoutant que les élèves plus jeunes qui apprennent encore les bases ont des besoins différents de ceux des apprenants plus âgés.

Chechitelli, de Turnitin, dit que le fait que Grammarly et d'autres outils de productivité intègrent désormais ChatGPT et fasse bien plus que simplement corriger la syntaxe d'écriture est un problème pour les étudiants. En effet, selon elle, les étudiants ne comprennent peut-être pas les nouvelles fonctionnalités et leurs implications.

« Un jour, ils se connectent et ils ont de nouveaux choix et des choix différents », dit-elle. "Je pense que c'est déroutant."

Pour le leader de Turnitin, le message le plus important adressé aux éducateurs aujourd’hui est la transparence sur l’aide apportée, le cas échéant, par l’IA.

« Mon conseil serait de réfléchir aux outils que vous utilisez et de vous assurer que vous pouvez montrer aux enseignants l'évolution de vos devoirs ou être en mesure de répondre aux questions », dit-elle.

Gallant, l'expert national en intégrité académique, affirme que les professeurs doivent être conscients du nombre croissant d'outils d'IA générative auxquels les étudiants ont accès.

« La grammaire va bien au-delà de la grammaire et de la vérification orthographique », dit-elle. « La grammaire est comme n’importe quel autre outil : elle peut être utilisée de manière éthique ou contraire à l’éthique. Il s'agit de la manière dont ils sont utilisés ou de la façon dont leurs utilisations sont obscurcies.

Gallant affirme que même les professeurs se heurtent à ces limites éthiques dans leurs propres écrits et publications dans des revues universitaires. Elle dit avoir entendu parler de professeurs qui utilisent ChatGPT pour rédiger des articles de revues, puis « oublient de retirer les parties où l’IA suggère des idées ».

Il y a quelque chose de séduisant dans la facilité avec laquelle ces nouveaux outils d'IA générative peuvent cracher des textes bien formatés, ajoute-t-elle, et cela peut donner l'impression aux gens qu'ils font un travail alors qu'ils ne font que mettre une invite dans une machine.

« Il y a ce manque d'autorégulation – pour tous les humains, mais particulièrement pour les novices et les jeunes – entre le moment où il m'aide et le moment où il fait le travail à ma place », explique Gallant.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.edsurge.com/news/2024-04-04-can-using-a-grammar-checker-set-off-ai-detection-software