Les Fabs commencent à déployer des modèles d'apprentissage automatique pour approfondir des processus complexes, en tirant parti à la fois d'une vaste puissance de calcul et d'avancées significatives en matière de ML. Tout cela est nécessaire à mesure que les dimensions diminuent et que la complexité augmente avec de nouveaux matériaux, structures, processus et options d'emballage, et que la demande de fiabilité augmente.

La création de modèles robustes nécessite la formation des algorithmes, et un déploiement réussi nécessite de surveiller l'application et l'efficacité de ces modèles. Mais ce n’est pas aussi simple que d’appuyer sur un bouton et c’est parti. Cela nécessite une formation/recyclage/formation croisée de différentes disciplines d'ingénierie (ingénieurs de fabrication, ingénieurs d'équipement et ingénieurs de procédés) pour utiliser ces modèles pour la recherche de recettes, la montée en puissance des processus, l'optimisation des dimensions critiques, l'amélioration du rendement des plaquettes et l'outil à outil. et l'appariement de chambre à chambre.

« L'expertise du domaine est absolument essentielle pour une utilisation productive des approches IA/ML », a déclaré Regina Freed, vice-présidente des solutions AIx chez Applied Materials. "En fait, l'expertise en matière de matériel et de processus, associée à des modèles hybrides basés sur le ML et la physique, sera la seule voie pour une mise en œuvre réussie du ML."

Travailler en tandem avec des modèles formés au ML nécessite de comprendre comment utiliser ces modèles, ainsi que d'être capable d'évaluer leur efficacité et leur robustesse.

« Les ingénieurs doivent croire que cela va fonctionner, et ils doivent comprendre ce que le ML peut et ne peut pas faire », a déclaré Jon Herlocker, PDG de Tignis. « Elle ne va pas se transformer en machine et décider de reprendre la fab. Les ingénieurs peuvent définir des contrôles sur ces modèles pour développer la confiance. Ils utilisent les mêmes méthodes statistiques robustes pour qualifier les modèles formés en ML qu'ils utiliseraient pour qualifier un système de contrôle de processus traditionnel. Ils créent des plans d’échantillonnage spécifiques pour mesurer la variabilité au sein de ces plans.

Le ML ouvre également la porte à l’exploration de relations plus complexes entre les données tout au long du flux de fabrication. Mais il y a quelques mises en garde.

"Ce qui est vraiment étonnant dans l'évolution du machine learning par le deep learning (DL), c'est l'utilisation de cette incroyable puissance de calcul, en particulier dans les GPU", a observé Ajay Baranwal, directeur du Center for Deep Learning in Electronics Manufacturing (CDLe). « Dans la formation DL, un nombre incroyable de paramètres et de combinaisons de paramètres peuvent être explorés en utilisant cette vaste puissance de calcul. D’une certaine manière, ce qui s’est produit, c’est que le calcul par force brute peut l’emporter de nos jours parce qu’une grande puissance de calcul est désormais disponible. Mais il existe un compromis entre l’exploration de grands paramètres pour effectuer une analyse complexe et la limitation à des modèles plus simples. Le surapprentissage, le biais et l’interprétabilité sont quelques inconvénients du maintien d’un plus grand nombre de paramètres.

Une fois qualifié, un modèle ML utilisé pour le contrôle de la fabrication doit être surveillé pour tenir compte de la dérive et des autres changements de processus qui pourraient affecter les relations entre les données d'entrée et de sortie.

L’application efficace d’un modèle basé sur le ML pour le contrôle des équipements et des processus nécessite plus qu’une simple formation sur le modèle. Cela nécessite également une validation, une surveillance et une maintenance.

Données fiables et expertise du domaine

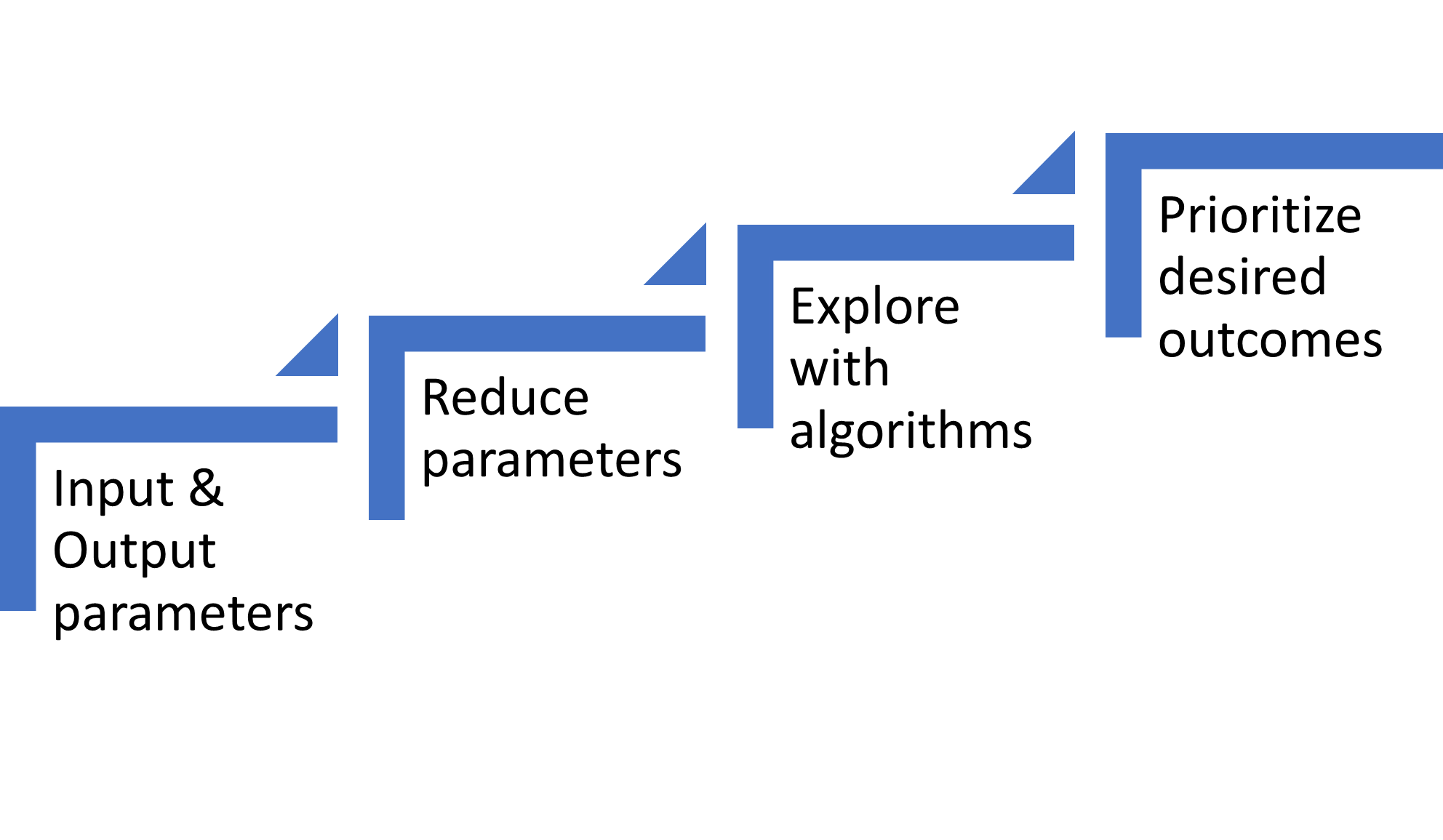

Les modèles réussis formés au ML reposent sur une base de données fiables et d’expertise dans le domaine. Ensuite, réduire les paramètres d’entrée des centaines à des milliers disponibles à ceux qui comptent vraiment nécessite une exploration des relations, souvent à l’aide de modèles basés sur la physique. De tels modèles sont particulièrement importants pour le développement de recettes de procédés. La vérification des résultats par rapport à des modèles basés sur la physique et aux connaissances en ingénierie garantit une orientation appropriée du développement du ML. D'autres considérations concernent les compromis lors de l'optimisation de plusieurs spécifications de résultats.

Fig. 1 : Composants nécessaires pour former un modèle ML pour les processus de fabrication. Source : A. Meixner/Ingénierie des semi-conducteurs

Que les ingénieurs appliquent la vision par ordinateur, des modèles statistiques ou des modèles d'apprentissage profond, la création de modèles commence toujours par des données. Ces données doivent être propres, c’est-à-dire sans erreurs et complètes. Pour l'optimisation de plusieurs étapes de processus de fabrication ou d'applications de rétroaction, la fusion de données provenant de plusieurs sources nécessite une traçabilité au niveau des tranches et/ou des puces. Comme l’ont souligné plusieurs experts du secteur, le plus gros du travail réside dans la gestion des données. Cela est vrai pour la construction initiale du modèle et pour le déploiement en usine.

Parallèlement à un flux constant de données fiables, les ingénieurs de procédés de fabrication doivent orienter le modèle dans la bonne direction. Ce besoin n'est pas différent de tout autre domaine dans lequel des modèles dérivés du ML sont créés.

« Dès les premiers stades, avoir des experts en la matière est très utile pour accélérer le ML dans les usines de fabrication, en particulier dans les applications de développement de processus », a déclaré Anjaneya Thakar, directrice principale de la gestion des lignes de produits chez Synopsys. « Comme le modèle est construit à l'aide d'une quantité limitée de données, vous pourriez optimiser autour d'un mauvais point optimal, car ils ont vu le problème avant qu'un expert en la matière puisse le guider rapidement. Une fois que votre modèle est réglé et que vous maîtrisez votre variabilité, vous avez moins besoin de faire appel à des experts en la matière pour l’exécuter quotidiennement.

Laisser simplement un algorithme former un modèle sans direction, c'est comme avoir une nouvelle recrue dans l'usine.

"À certains égards, l'apprentissage automatique ressemble à l'apprentissage humain", a déclaré Herlocker de Tignis. « Si vous avez un ingénieur de procédés junior, il ne peut pas faire grand-chose. Mais à mesure que l’ingénieur apprend, il peut résoudre des problèmes plus complexes. La même chose s’applique avec ML. Plus le modèle ML est formé, meilleur il devient. La formation du modèle ML est la connaissance du domaine. Le défi à l’avenir est de savoir comment exploiter toutes ces connaissances du domaine et les transformer afin qu’elles puissent être consommées par le ML en tant que « formation ». En fin de compte, nous devons associer l’intuition et les connaissances humaines au ML pour obtenir les meilleurs résultats.

Lam Research a exploré cette association optimale entre l’intuition/les connaissances de l’ingénieur et les résultats du ML dans une expérience de simulation. [1] « Il existe un adage parmi les ingénieurs selon lequel la science des données sans connaissance du domaine ne vaut pas grand-chose », a déclaré Keren Kanarik, directrice générale technique chez Recherche Lam. « De même, la connaissance du domaine sans la science des données ne vous permettra pas d’innover assez rapidement dans le monde concurrentiel des semi-conducteurs. Lam a récemment testé cette idée en créant un jeu virtuel comparant les humains à l’IA dans le développement d’un processus semi-conducteur au coût le plus bas (c’est-à-dire le plus petit nombre d’expériences). Les résultats ont fourni une approche prescriptive sur la manière de combiner l’expertise du domaine avec la science des données.

Réduire et prioriser

Le grand attrait des modèles basés sur le ML réside dans leur capacité à connecter plusieurs paramètres d’entrée dans des relations non linéaires avec plusieurs paramètres de résultat. Pourtant, pour les modèles actuels, la plupart des experts s'accordent sur le fait que le nombre de paramètres d'entrée significatifs est souvent de l'ordre de 10. Cette limite s'explique par plusieurs raisons, notamment l'optimisation en cas de résultats erronés, l'explication du modèle entraîné et l'observation des relations.

Fig. 2 : Pipeline de construction d'apprentissage automatique pour créer un modèle. Source : A. Meixner/Ingénierie des semi-conducteurs

« La clé de la mise en œuvre réussie d’algorithmes complexes est la visualisation. Vous devez fournir une représentation visuelle puissante qui aide les utilisateurs à interpréter et à comprendre instantanément les résultats – et leurs limites – des algorithmes. Lorsque l'image visuelle frappe le spectateur juste entre les yeux, les ingénieurs de rendement peuvent passer à l'action », a déclaré Dieter Rathei, PDG de Rendement DR.

Les algorithmes de formation ML peuvent explorer plus facilement davantage de paramètres ; cependant, la réduction des paramètres représente une étape essentielle dans le processus de développement du modèle.

« En raison de la nature de boîte noire de la plupart des modèles ML, on craint parfois que les utilisateurs se retrouvent à corréler les performances des processus avec le jour de la semaine », a déclaré Meghali Chopra, PDG de Sandbox Semiconductor. « Le ML est conçu pour éclairer les relations entre les données clés, mais les déchets entrants équivaut à des déchets sortants. Une bonne approche de modèle ML et un bon pipeline sont conçus pour distinguer le signal du bruit. Nous utilisons une IA basée sur la physique pour limiter l'espace des paramètres. Nous investissons également massivement dans les techniques de prétraitement des données et de réduction de la dimensionnalité pour garantir que les paramètres les plus importants soient éclaircis pour nos utilisateurs.

La mise en lumière des paramètres importants pour les ingénieurs peut être fournie de manière échelonnée, d'abord un paramètre, puis deux, et éventuellement trois.

"Nous avons deux niveaux dans notre outil", a déclaré Jeff David, vice-président des solutions d'IA chez Solutions PDF. « La première est la prédiction univariée. Nous commençons par univariant car c'est facile à comprendre et à visualiser. Par exemple, si le paramètre A est d'environ 2.7 et que je vois plus d'échecs lorsqu'il est inférieur à 2.7, alors à l'étape suivante, nous avons une interaction entre deux paramètres. Ensuite, nous montrons les détails de l'interaction pour ces deux paramètres. Mais nous nous arrêtons à deux, car une fois qu’on passe à trois et quatre, il devient très difficile de visualiser et d’explorer.

L’autre mise en garde concernant le nombre de paramètres utilisés concerne les corrélations incorrectes.

"Pour ce type d'application (développement de recettes de gravure), les processus sont si complexes que l'analyse des causes profondes peut montrer pourquoi la modélisation de cette complexité est vraiment importante", a déclaré Chopra de Sandbox Semiconductor. « Le danger de modéliser autant de paramètres est que vous pouvez trouver de fausses corrélations, c'est-à-dire le résultat du processus avec le jour de la semaine. C’est ce que vous voulez éviter. Nous investissons massivement dans la réduction de la dimensionnalité. Et puis nous utilisons notre modèle d’ancrage basé sur la physique, nous n’avons donc jamais trop peur de trop complexifier le problème, car un bon pipeline de modélisation trouvera essentiellement tous les paramètres de processus importants pour vous.

D'autres s'accordent sur la nécessité d'un pipeline de modélisation qui réduit les paramètres et trouve des relations significatives.

"Il y a définitivement une limite dans le nombre de paramètres", a déclaré David de PDF. «Mais vous ne savez pas pour un cas d'utilisation donné tant que vous n'avez pas entraîné un modèle avec les données dont vous disposez et que vous ne l'avez pas validé. Notre plateforme permet automatiquement à nos clients de le faire avec notre pipeline de formation. Notre pipeline de formation évolue pour permettre à nos clients de voir les métriques dont ils ont besoin sur leurs modèles entraînés en quelques heures, de l'ingestion de données jusqu'aux modèles entraînés. Ensuite, si les modèles formés présentent de la valeur, l'utilisateur peut automatiquement déployer les modèles avec notre plateforme ModelOps.

Il existe également des compromis à faire pour équilibrer plusieurs résultats.

"Fondamentalement, il est vrai qu'il est impossible de construire ces contrôleurs sans la participation d'un ingénieur de processus, car des décisions concernant des compromis doivent être prises", a déclaré Herlocker. « Vous essayez d’optimiser plusieurs choses à la fois. Par exemple, vous essayez d’optimiser le CD, mais vous essayez également de minimiser la quantité d’énergie que vous utilisez. Il existe des décisions humaines inhérentes que prennent les ingénieurs : « Dans quelle mesure est-ce que je me soucie de la qualité des processus par rapport à la consommation d'énergie par rapport à la consommation de produits chimiques par rapport aux émissions de produits chimiques ? » Mais la formation en ML ne sait pas laquelle est la plus importante. Seuls les ingénieurs le font, ils doivent donc être là.

Déployer et maintenir

Une fois développé, le ML doit être validé et déployé dans un environnement de production, et il doit être maintenu. Ceci est mieux exécuté avec un processus systématique et fiable dans les usines de semi-conducteurs, et cela nécessite une plate-forme de processus/méthodes d’opérations d’apprentissage automatique (ML Ops). Cela est devenu la norme dans les applications ML dans d’autres secteurs, et cela vient tout juste de se produire dans l’industrie des semi-conducteurs.

Les ingénieurs développent des modèles ML de manière isolée. La transition de l'environnement de développement à l'environnement de production implique un ensemble de pratiques similaires au DevOps pour le déploiement de systèmes logiciels. Lorsque le modèle est lancé en production, une plateforme ML Ops permet une augmentation de l'automatisation du déploiement et une amélioration de la qualité du modèle. [2] Ainsi, cela s'applique à l'ensemble du cycle de vie du modèle ML.

"Au cours de la dernière décennie, il y a eu beaucoup d'enthousiasme autour de la manière dont le ML peut apporter de la valeur à la fabrication de semi-conducteurs dans de nombreux cas d'utilisation", a déclaré David de PDF. « Mais quand vient le temps de le mettre en œuvre en production, les gens ont du mal. Par exemple, comment contrôler si votre modèle entraîné fait ce qu’il est censé faire ? Si non, quel est le recours ? Que se passe-t-il si vient le temps de faire des prédictions et que vos données ne sont pas là ? Cela arrive plus souvent que nous le souhaiterions. Comment détecter une dérive dans les données d’entrée sur lesquelles s’appuie votre modèle entraîné ? Quelles actions entreprenez-vous à ce sujet ? Que fais-tu? ML Ops consiste essentiellement à mettre en œuvre tous ces éléments en production afin que vous puissiez réellement les utiliser.

De plus, les modèles devraient avoir une capacité de recyclage. « De nombreuses avancées ont été réalisées dans les nouveaux algorithmes de ML, dont beaucoup sont liés au deep learning. L'apprentissage profond est un domaine d'investissement important et, en tant qu'industrie, nous sommes capables de réaliser de nombreuses choses qui n'étaient pas possibles auparavant, notamment lorsqu'il s'agit de travailler avec de grands modèles. De nombreuses améliorations dans le domaine de l'automatisation du recyclage des modèles s'avèrent essentielles pour le large déploiement de modèles ML dans des environnements de fabrication à haut volume », a déclaré Herlocker de Tignis.

Un autre aspect de ML Ops est le déploiement plus rapide de modèles pour des prédictions similaires, mais sur des produits différents. En raison des caractéristiques du produit, les mêmes paramètres d'entrée peuvent donner lieu à des données de sortie différentes. Cela peut également signifier qu’une approche de formation différente correspond mieux à un ensemble de données. Et c'est là que le pipeline ML et ML Ops entrent en jeu.

"Vous souhaitez former un modèle différent par produit A, B et C et vous souhaitez le faire de manière automatisée, ainsi que déployer rapidement chacun d'entre eux", a déclaré David de PDF. « Peut-être que la forêt aléatoire n’est pas la meilleure pour cet ensemble de données. Avec ML Ops, vous prenez votre ensemble de données, vous le découpez en morceaux et vous déployez différents types d'approches algorithmiques. Ce sont des hyper-paramètres de cet ensemble de données qui peuvent être validés dans ce qu’on appelle la validation croisée. [3] Ensuite, vous construisez le modèle en utilisant votre meilleure approche algorithmique, qui est ensuite intégrée au modèle, puis vous le déployez pour la production. Cela peut être différent d’une puce à l’autre. ML Ops est cruellement nécessaire dans l'industrie, et j'entends même des clients dire qu'ils souhaitent cette plate-forme ML OPS plus que la possibilité de former un modèle avec un algorithme. La raison, en fin de compte, est qu’ils souhaitent réellement déployer le ML en production. Sans une plateforme pour le faire, rien d’autre n’a d’importance.

Conclusion

Face aux pressions en matière d'économie, d'efficacité et d'efficience, les équipes d'ingénierie de fabrication de semi-conducteurs devront utiliser des modèles ML pour soutenir leur travail. Le ML est apparu comme un moyen d'accélérer le développement de recettes, d'augmenter le débit et de gagner quelques points de pourcentage de rendement. Grâce à la capacité du ML à traiter des interactions complexes qui dépendent des propriétés spatiales et des états temporels, les futurs modèles de ML seront co-optimisés à travers les étapes du processus, accélérant ainsi la compréhension de nouveaux mécanismes chimiques et bien plus encore.

Mais comme pour tout outil de leur boîte à outils, les ingénieurs doivent comprendre les limites du ML. Pour y parvenir efficacement, ils ont besoin d'un pipeline de modèle ML robuste qui développe, valide, déploie et surveille. Et les ingénieurs de procédés sont toujours nécessaires pour diriger et faciliter l’application.

"L'une des choses que nous avons constatées est que les solutions ML d'aujourd'hui nécessitent un ingénieur de processus, un ingénieur logiciel, des data scientists et un informaticien", a déclaré Herlocker. « Dans le cadre de notre vision, la personne critique est l'ingénieur de procédés. Nous pouvons créer un logiciel qui permet à l'ingénieur de processus de faire cela sans que personne d'autre ne le fasse. Nous sommes sur le point d’atteindre cet objectif et de permettre ainsi à l’ingénieur de processus d’utiliser efficacement le ML.

Bibliographie

- Kanarik, K., et coll. « Collaboration homme-machine pour améliorer le développement des processus de semi-conducteurs », Nature 616, 707-711 (2023). https://doi.org/10.1038/s41586-023-05773-7

- https://en.wikipedia.org/wiki/MLOps

- https://en.wikipedia.org/wiki/Hyperparameter_(machine_learning)

LIRE EGALEMENT

Quand et où implémenter l'IA/ML dans Fabs

Des outils plus intelligents peuvent améliorer le contrôle des processus, identifier les causes des écarts et accélérer le développement de recettes.

Utilisation du ML pour améliorer la planification des fabrications

Les chercheurs utilisent les réseaux de neurones pour améliorer l’efficacité du traitement des plaquettes en identifiant des modèles dans de vastes collections de données.

Application du ML dans l'analyse des échecs

Quand et où utiliser au mieux l’apprentissage automatique et comment choisir le bon modèle.

Les problèmes de données augmentent dans la fabrication de puces

Les pratiques en matière de données de référence permettent aux ingénieurs produit et aux ingénieurs informatiques d'usine de gérer une variété de types et de qualité de données.

Équilibrer l’expertise en IA et en ingénierie dans la fabrique

Les résultats montrent de grandes améliorations lorsque les deux sont déployés pour le développement de nouveaux processus.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://semiengineering.com/fabs-begin-ramping-up-machine-learning/