01 nov.2023 (Actualités Nanowerk) Dans un laps de temps étonnamment court, intelligence artificielle est passé d’une entreprise académique à un outil pratique. Les modèles visuels tels que DALL·E peuvent créer des images dans n'importe quel style souhaité, tandis que les grands modèles de langage (LLM) comme Chat GPT peuvent générer des essais, écrire du code informatique et suggérer des itinéraires de voyage. Lorsqu’ils y sont invités, ils peuvent même corriger leurs propres erreurs.

Le chercheur Fabian Offert explore les capacités et les limites des grands modèles de langage comme Chat GPT, remettant en question l'idée selon laquelle ils possèdent un « modèle mondial » de calcul complet.

Bien que Chat GPT puisse coder une chaîne de Markov fonctionnelle et simuler sa sortie au niveau du mot, il a du mal à simuler la sortie lettre par lettre, ce qui indique des lacunes dans sa compréhension.

Offert soutient que l’exploration des capacités de l’IA relève davantage d’un « entretien qualitatif » que d’une expérience contrôlée en raison de la nature évolutive de ces modèles.

Le chercheur souligne le rôle croissant des sciences humaines et sociales dans la compréhension de l’IA, alors que les questions autour de ces technologies deviennent de plus en plus philosophiques.

L’IA ayant un impact sur divers domaines allant de la rédaction d’essais à l’astronomie, Offert insiste sur le fait que comprendre les mécanismes derrière ces modèles est essentiel pour des raisons épistémologiques et pratiques.

Ce qu’une intelligence artificielle affiche à l’écran reflète sa représentation interne du monde, qui peut être bien différente de la nôtre. (Une illustration de Midjourney avec l'invite : « Un ordinateur avec des nuages d'équations et de symboles) « Les gens ont affirmé que les grands modèles de langage, et Chat GPT en particulier, ont un soi-disant « modèle mondial » de certaines choses, y compris calcul », a déclaré Offert, professeur adjoint d’humanités numériques. Autrement dit, il ne s’agit pas seulement d’une connaissance superficielle selon laquelle les mots codés apparaissent souvent ensemble, mais d’une compréhension plus complète du calcul lui-même.

Même un programme informatique de base peut produire un texte convaincant avec une chaîne de Markov, un algorithme simple qui utilise la probabilité pour prédire le jeton suivant dans une séquence en fonction de ce qui précède. La nature de la sortie dépend du texte de référence et de la taille du jeton (par exemple une lettre, un mot ou une phrase). Avec les paramètres et la source de formation appropriés, cela peut produire un texte naturel imitant le style de l'échantillon de formation.

Mais les LLM affichent des capacités auxquelles on ne s'attendrait pas s'ils prédisaient simplement le mot suivant dans une séquence. Par exemple, ils peuvent produire un nouveau code informatique fonctionnel. Les langages formels, comme les langages informatiques, sont beaucoup plus rigides et bien définis que les langues naturelles que nous parlons. Cela rend plus difficile leur navigation de manière globale, car le code doit être complètement correct pour pouvoir être analysé ; il n'y a pas de marge de manœuvre. Les LLM semblent avoir une mémoire contextuelle, contrairement aux simples chaînes de Markov et aux algorithmes prédictifs. Et cette mémoire donne naissance à certains de leurs nouveaux comportements, notamment leur capacité à écrire du code.

Offert a décidé de choisir le cerveau de Chat GPT en lui demandant d'effectuer quelques tâches. Tout d’abord, il lui a demandé de coder une chaîne de Markov qui générerait un texte basé sur le roman « Eugène Onéguine » d’Alexandre Pouchkine. Après quelques faux départs et un peu de cajolerie, l'IA a produit un code Python fonctionnel pour une approximation en chaîne de Markov au niveau des mots du livre.

Ensuite, il lui a demandé de simplement simuler la sortie d’une chaîne de Markov. Si Chat GPT disposait réellement d'un modèle de calcul allant au-delà de la simple prédiction statistique, Offert pensait qu'il devrait être capable d'estimer le résultat d'un programme sans l'exécuter. Il a découvert que l’IA pouvait simuler une chaîne de Markov au niveau des mots et des phrases. Cependant, il ne pouvait pas estimer le résultat d’une chaîne de Markov lettre par lettre. « Vous devriez obtenir une salade de lettres quelque peu cohérente, mais ce n'est pas le cas », a-t-il déclaré.

Ce résultat parut plutôt étrange à Offert. Chat GPT possédait clairement une compréhension plus nuancée de la programmation car il a réussi à coder une chaîne de Markov lors de la première tâche. Cependant, s’il possédait réellement un concept de calcul, alors prédire une chaîne de Markov au niveau des lettres devrait lui être assez facile. Cela nécessite beaucoup moins de calculs, de mémoire et d’efforts que de prédire le résultat au niveau des mots, ce qu’il a pu faire. Cela dit, il existe d'autres moyens de réaliser la prédiction au niveau des mots simplement parce que les LLM sont, de par leur conception, efficaces pour générer des mots.

"Sur la base de ce résultat, je dirais que Chat GPT n'a pas de modèle mondial de calcul", a déclaré Offert. "Il ne s'agit pas de simuler une bonne vieille machine de Turing avec accès à toutes les capacités de calcul." L'objectif d'Offert dans cet article était simplement de soulever des questions, mais pas d'y répondre. Il discutait simplement avec le programme, ce qui n'est pas une méthodologie appropriée pour une enquête scientifique. C'est subjectif, incontrôlé, non reproductible et le programme peut s'actualiser du jour au lendemain. « Il s'agit en réalité plus d'un entretien qualitatif que d'une expérience contrôlée », a-t-il expliqué. Je sonde juste la boîte noire, si vous voulez.

Offert souhaite développer une meilleure compréhension de ces nouvelles entités apparues ces dernières années. « Mon intérêt est vraiment épistémologique », a-t-il déclaré. « Que pouvons-nous savoir de ces choses ? Et que pouvons-nous savoir de ces choses ? Bien entendu, ces deux questions sont inextricablement liées.

Ces sujets ont commencé à susciter également l’intérêt des ingénieurs et des informaticiens. « De plus en plus, les questions que les chercheurs techniques posent à propos de l’IA sont essentiellement des questions de sciences humaines », a déclaré Offert. «Ils portent sur des idées philosophiques fondamentales, comme ce que signifie avoir une connaissance du monde et comment nous représentons la connaissance du monde.» C’est pourquoi Offert estime que les sciences humaines et sociales ont un rôle plus actif à jouer dans le développement de l’IA. Leur rôle pourrait être élargi pour éclairer la manière dont ces systèmes sont développés, comment ils sont utilisés et comment le public s'y engage.

Les différences entre les intelligences artificielles et humaines sont peut-être encore plus intrigantes que les similitudes. "Le caractère extraterrestre de ces systèmes est en fait ce qui les rend intéressants", a déclaré Offert. Par exemple, dans un article précédent, il a révélé que la façon dont l’IA catégorise et reconnaît les images peut être assez étrange de notre point de vue.

Ce qu’une intelligence artificielle affiche à l’écran reflète sa représentation interne du monde, qui peut être bien différente de la nôtre. (Une illustration de Midjourney avec l'invite : « Un ordinateur avec des nuages d'équations et de symboles) « Les gens ont affirmé que les grands modèles de langage, et Chat GPT en particulier, ont un soi-disant « modèle mondial » de certaines choses, y compris calcul », a déclaré Offert, professeur adjoint d’humanités numériques. Autrement dit, il ne s’agit pas seulement d’une connaissance superficielle selon laquelle les mots codés apparaissent souvent ensemble, mais d’une compréhension plus complète du calcul lui-même.

Même un programme informatique de base peut produire un texte convaincant avec une chaîne de Markov, un algorithme simple qui utilise la probabilité pour prédire le jeton suivant dans une séquence en fonction de ce qui précède. La nature de la sortie dépend du texte de référence et de la taille du jeton (par exemple une lettre, un mot ou une phrase). Avec les paramètres et la source de formation appropriés, cela peut produire un texte naturel imitant le style de l'échantillon de formation.

Mais les LLM affichent des capacités auxquelles on ne s'attendrait pas s'ils prédisaient simplement le mot suivant dans une séquence. Par exemple, ils peuvent produire un nouveau code informatique fonctionnel. Les langages formels, comme les langages informatiques, sont beaucoup plus rigides et bien définis que les langues naturelles que nous parlons. Cela rend plus difficile leur navigation de manière globale, car le code doit être complètement correct pour pouvoir être analysé ; il n'y a pas de marge de manœuvre. Les LLM semblent avoir une mémoire contextuelle, contrairement aux simples chaînes de Markov et aux algorithmes prédictifs. Et cette mémoire donne naissance à certains de leurs nouveaux comportements, notamment leur capacité à écrire du code.

Offert a décidé de choisir le cerveau de Chat GPT en lui demandant d'effectuer quelques tâches. Tout d’abord, il lui a demandé de coder une chaîne de Markov qui générerait un texte basé sur le roman « Eugène Onéguine » d’Alexandre Pouchkine. Après quelques faux départs et un peu de cajolerie, l'IA a produit un code Python fonctionnel pour une approximation en chaîne de Markov au niveau des mots du livre.

Ensuite, il lui a demandé de simplement simuler la sortie d’une chaîne de Markov. Si Chat GPT disposait réellement d'un modèle de calcul allant au-delà de la simple prédiction statistique, Offert pensait qu'il devrait être capable d'estimer le résultat d'un programme sans l'exécuter. Il a découvert que l’IA pouvait simuler une chaîne de Markov au niveau des mots et des phrases. Cependant, il ne pouvait pas estimer le résultat d’une chaîne de Markov lettre par lettre. « Vous devriez obtenir une salade de lettres quelque peu cohérente, mais ce n'est pas le cas », a-t-il déclaré.

Ce résultat parut plutôt étrange à Offert. Chat GPT possédait clairement une compréhension plus nuancée de la programmation car il a réussi à coder une chaîne de Markov lors de la première tâche. Cependant, s’il possédait réellement un concept de calcul, alors prédire une chaîne de Markov au niveau des lettres devrait lui être assez facile. Cela nécessite beaucoup moins de calculs, de mémoire et d’efforts que de prédire le résultat au niveau des mots, ce qu’il a pu faire. Cela dit, il existe d'autres moyens de réaliser la prédiction au niveau des mots simplement parce que les LLM sont, de par leur conception, efficaces pour générer des mots.

"Sur la base de ce résultat, je dirais que Chat GPT n'a pas de modèle mondial de calcul", a déclaré Offert. "Il ne s'agit pas de simuler une bonne vieille machine de Turing avec accès à toutes les capacités de calcul." L'objectif d'Offert dans cet article était simplement de soulever des questions, mais pas d'y répondre. Il discutait simplement avec le programme, ce qui n'est pas une méthodologie appropriée pour une enquête scientifique. C'est subjectif, incontrôlé, non reproductible et le programme peut s'actualiser du jour au lendemain. « Il s'agit en réalité plus d'un entretien qualitatif que d'une expérience contrôlée », a-t-il expliqué. Je sonde juste la boîte noire, si vous voulez.

Offert souhaite développer une meilleure compréhension de ces nouvelles entités apparues ces dernières années. « Mon intérêt est vraiment épistémologique », a-t-il déclaré. « Que pouvons-nous savoir de ces choses ? Et que pouvons-nous savoir de ces choses ? Bien entendu, ces deux questions sont inextricablement liées.

Ces sujets ont commencé à susciter également l’intérêt des ingénieurs et des informaticiens. « De plus en plus, les questions que les chercheurs techniques posent à propos de l’IA sont essentiellement des questions de sciences humaines », a déclaré Offert. «Ils portent sur des idées philosophiques fondamentales, comme ce que signifie avoir une connaissance du monde et comment nous représentons la connaissance du monde.» C’est pourquoi Offert estime que les sciences humaines et sociales ont un rôle plus actif à jouer dans le développement de l’IA. Leur rôle pourrait être élargi pour éclairer la manière dont ces systèmes sont développés, comment ils sont utilisés et comment le public s'y engage.

Les différences entre les intelligences artificielles et humaines sont peut-être encore plus intrigantes que les similitudes. "Le caractère extraterrestre de ces systèmes est en fait ce qui les rend intéressants", a déclaré Offert. Par exemple, dans un article précédent, il a révélé que la façon dont l’IA catégorise et reconnaît les images peut être assez étrange de notre point de vue.

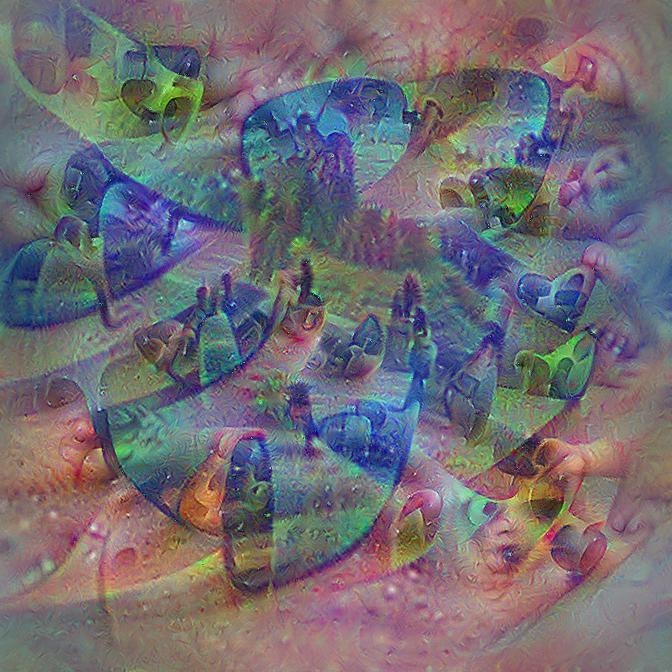

Dans une étude précédente, Offert a regardé derrière le rideau d’un modèle visuel. Cette photo se rapproche de sa conception des lunettes de soleil. (Image : Fabian Offert) Offert essaie en fin de compte de comprendre comment ces modèles représentent le monde et prennent des décisions. Parce qu’ils ont des connaissances sur le monde, nous assure-t-il – des connexions glanées à partir de leurs données de formation. Au-delà de l’intérêt épistémologique, le sujet revêt également une importance pratique pour aligner les motivations de l’IA sur celles de ses utilisateurs humains. À mesure que des outils tels que Chat GPT sont de plus en plus utilisés, ils rapprochent des disciplines auparavant indépendantes. Par exemple, la rédaction d’essais et la suppression du bruit en astronomie sont désormais toutes deux connectées à la même technologie sous-jacente. Selon Offert, cela signifie que nous devons commencer à examiner la technologie elle-même plus en détail en tant que manière fondamentalement nouvelle de générer des connaissances. Bénéficiant d’une subvention de trois ans de la Fondation Volkswagen sur le thème de la criminalistique de l’IA, Offert explore actuellement la culture visuelle des machines. Les modèles d'images sont devenus si volumineux et ont vu tellement de données, a-t-il expliqué, qu'ils ont développé des particularités basées sur leur matériel de formation. À mesure que ces outils se généraliseront, leurs bizarreries commenceront à se répercuter sur la culture humaine. En conséquence, Offert estime qu’il est important de comprendre ce qui se passe sous le capot de ces modèles d’IA. « C'est une période passionnante pour faire ce travail », a-t-il déclaré. "Je n'aurais pas imaginé cela il y a à peine cinq ans."

Dans une étude précédente, Offert a regardé derrière le rideau d’un modèle visuel. Cette photo se rapproche de sa conception des lunettes de soleil. (Image : Fabian Offert) Offert essaie en fin de compte de comprendre comment ces modèles représentent le monde et prennent des décisions. Parce qu’ils ont des connaissances sur le monde, nous assure-t-il – des connexions glanées à partir de leurs données de formation. Au-delà de l’intérêt épistémologique, le sujet revêt également une importance pratique pour aligner les motivations de l’IA sur celles de ses utilisateurs humains. À mesure que des outils tels que Chat GPT sont de plus en plus utilisés, ils rapprochent des disciplines auparavant indépendantes. Par exemple, la rédaction d’essais et la suppression du bruit en astronomie sont désormais toutes deux connectées à la même technologie sous-jacente. Selon Offert, cela signifie que nous devons commencer à examiner la technologie elle-même plus en détail en tant que manière fondamentalement nouvelle de générer des connaissances. Bénéficiant d’une subvention de trois ans de la Fondation Volkswagen sur le thème de la criminalistique de l’IA, Offert explore actuellement la culture visuelle des machines. Les modèles d'images sont devenus si volumineux et ont vu tellement de données, a-t-il expliqué, qu'ils ont développé des particularités basées sur leur matériel de formation. À mesure que ces outils se généraliseront, leurs bizarreries commenceront à se répercuter sur la culture humaine. En conséquence, Offert estime qu’il est important de comprendre ce qui se passe sous le capot de ces modèles d’IA. « C'est une période passionnante pour faire ce travail », a-t-il déclaré. "Je n'aurais pas imaginé cela il y a à peine cinq ans."

Faits marquants

La recherche

Alors que les modèles d’IA deviennent de plus en plus sophistiqués et omniprésents, il est crucial de comprendre exactement ce que sont ces entités, ce qu’elles peuvent faire et comment elles pensent. Ces modèles deviennent très semblables aux humains, et pourtant ils sont tellement différents de nous. Cette combinaison unique rend l’IA fascinante à contempler. Par exemple, les grands modèles d’IA sont formés sur d’immenses quantités d’informations. Mais il n’est pas clair dans quelle mesure ils comprennent ces données comme un système cohérent de connaissances. Fabian Offert de l'UC Santa Barbara explore cette idée dans un court article présenté dans l'anthologie ChatGPT et autres machines à sous – conversations avec l'IA. Ce qu’une intelligence artificielle affiche à l’écran reflète sa représentation interne du monde, qui peut être bien différente de la nôtre. (Une illustration de Midjourney avec l'invite : « Un ordinateur avec des nuages d'équations et de symboles) « Les gens ont affirmé que les grands modèles de langage, et Chat GPT en particulier, ont un soi-disant « modèle mondial » de certaines choses, y compris calcul », a déclaré Offert, professeur adjoint d’humanités numériques. Autrement dit, il ne s’agit pas seulement d’une connaissance superficielle selon laquelle les mots codés apparaissent souvent ensemble, mais d’une compréhension plus complète du calcul lui-même.

Même un programme informatique de base peut produire un texte convaincant avec une chaîne de Markov, un algorithme simple qui utilise la probabilité pour prédire le jeton suivant dans une séquence en fonction de ce qui précède. La nature de la sortie dépend du texte de référence et de la taille du jeton (par exemple une lettre, un mot ou une phrase). Avec les paramètres et la source de formation appropriés, cela peut produire un texte naturel imitant le style de l'échantillon de formation.

Mais les LLM affichent des capacités auxquelles on ne s'attendrait pas s'ils prédisaient simplement le mot suivant dans une séquence. Par exemple, ils peuvent produire un nouveau code informatique fonctionnel. Les langages formels, comme les langages informatiques, sont beaucoup plus rigides et bien définis que les langues naturelles que nous parlons. Cela rend plus difficile leur navigation de manière globale, car le code doit être complètement correct pour pouvoir être analysé ; il n'y a pas de marge de manœuvre. Les LLM semblent avoir une mémoire contextuelle, contrairement aux simples chaînes de Markov et aux algorithmes prédictifs. Et cette mémoire donne naissance à certains de leurs nouveaux comportements, notamment leur capacité à écrire du code.

Offert a décidé de choisir le cerveau de Chat GPT en lui demandant d'effectuer quelques tâches. Tout d’abord, il lui a demandé de coder une chaîne de Markov qui générerait un texte basé sur le roman « Eugène Onéguine » d’Alexandre Pouchkine. Après quelques faux départs et un peu de cajolerie, l'IA a produit un code Python fonctionnel pour une approximation en chaîne de Markov au niveau des mots du livre.

Ensuite, il lui a demandé de simplement simuler la sortie d’une chaîne de Markov. Si Chat GPT disposait réellement d'un modèle de calcul allant au-delà de la simple prédiction statistique, Offert pensait qu'il devrait être capable d'estimer le résultat d'un programme sans l'exécuter. Il a découvert que l’IA pouvait simuler une chaîne de Markov au niveau des mots et des phrases. Cependant, il ne pouvait pas estimer le résultat d’une chaîne de Markov lettre par lettre. « Vous devriez obtenir une salade de lettres quelque peu cohérente, mais ce n'est pas le cas », a-t-il déclaré.

Ce résultat parut plutôt étrange à Offert. Chat GPT possédait clairement une compréhension plus nuancée de la programmation car il a réussi à coder une chaîne de Markov lors de la première tâche. Cependant, s’il possédait réellement un concept de calcul, alors prédire une chaîne de Markov au niveau des lettres devrait lui être assez facile. Cela nécessite beaucoup moins de calculs, de mémoire et d’efforts que de prédire le résultat au niveau des mots, ce qu’il a pu faire. Cela dit, il existe d'autres moyens de réaliser la prédiction au niveau des mots simplement parce que les LLM sont, de par leur conception, efficaces pour générer des mots.

"Sur la base de ce résultat, je dirais que Chat GPT n'a pas de modèle mondial de calcul", a déclaré Offert. "Il ne s'agit pas de simuler une bonne vieille machine de Turing avec accès à toutes les capacités de calcul." L'objectif d'Offert dans cet article était simplement de soulever des questions, mais pas d'y répondre. Il discutait simplement avec le programme, ce qui n'est pas une méthodologie appropriée pour une enquête scientifique. C'est subjectif, incontrôlé, non reproductible et le programme peut s'actualiser du jour au lendemain. « Il s'agit en réalité plus d'un entretien qualitatif que d'une expérience contrôlée », a-t-il expliqué. Je sonde juste la boîte noire, si vous voulez.

Offert souhaite développer une meilleure compréhension de ces nouvelles entités apparues ces dernières années. « Mon intérêt est vraiment épistémologique », a-t-il déclaré. « Que pouvons-nous savoir de ces choses ? Et que pouvons-nous savoir de ces choses ? Bien entendu, ces deux questions sont inextricablement liées.

Ces sujets ont commencé à susciter également l’intérêt des ingénieurs et des informaticiens. « De plus en plus, les questions que les chercheurs techniques posent à propos de l’IA sont essentiellement des questions de sciences humaines », a déclaré Offert. «Ils portent sur des idées philosophiques fondamentales, comme ce que signifie avoir une connaissance du monde et comment nous représentons la connaissance du monde.» C’est pourquoi Offert estime que les sciences humaines et sociales ont un rôle plus actif à jouer dans le développement de l’IA. Leur rôle pourrait être élargi pour éclairer la manière dont ces systèmes sont développés, comment ils sont utilisés et comment le public s'y engage.

Les différences entre les intelligences artificielles et humaines sont peut-être encore plus intrigantes que les similitudes. "Le caractère extraterrestre de ces systèmes est en fait ce qui les rend intéressants", a déclaré Offert. Par exemple, dans un article précédent, il a révélé que la façon dont l’IA catégorise et reconnaît les images peut être assez étrange de notre point de vue.

Ce qu’une intelligence artificielle affiche à l’écran reflète sa représentation interne du monde, qui peut être bien différente de la nôtre. (Une illustration de Midjourney avec l'invite : « Un ordinateur avec des nuages d'équations et de symboles) « Les gens ont affirmé que les grands modèles de langage, et Chat GPT en particulier, ont un soi-disant « modèle mondial » de certaines choses, y compris calcul », a déclaré Offert, professeur adjoint d’humanités numériques. Autrement dit, il ne s’agit pas seulement d’une connaissance superficielle selon laquelle les mots codés apparaissent souvent ensemble, mais d’une compréhension plus complète du calcul lui-même.

Même un programme informatique de base peut produire un texte convaincant avec une chaîne de Markov, un algorithme simple qui utilise la probabilité pour prédire le jeton suivant dans une séquence en fonction de ce qui précède. La nature de la sortie dépend du texte de référence et de la taille du jeton (par exemple une lettre, un mot ou une phrase). Avec les paramètres et la source de formation appropriés, cela peut produire un texte naturel imitant le style de l'échantillon de formation.

Mais les LLM affichent des capacités auxquelles on ne s'attendrait pas s'ils prédisaient simplement le mot suivant dans une séquence. Par exemple, ils peuvent produire un nouveau code informatique fonctionnel. Les langages formels, comme les langages informatiques, sont beaucoup plus rigides et bien définis que les langues naturelles que nous parlons. Cela rend plus difficile leur navigation de manière globale, car le code doit être complètement correct pour pouvoir être analysé ; il n'y a pas de marge de manœuvre. Les LLM semblent avoir une mémoire contextuelle, contrairement aux simples chaînes de Markov et aux algorithmes prédictifs. Et cette mémoire donne naissance à certains de leurs nouveaux comportements, notamment leur capacité à écrire du code.

Offert a décidé de choisir le cerveau de Chat GPT en lui demandant d'effectuer quelques tâches. Tout d’abord, il lui a demandé de coder une chaîne de Markov qui générerait un texte basé sur le roman « Eugène Onéguine » d’Alexandre Pouchkine. Après quelques faux départs et un peu de cajolerie, l'IA a produit un code Python fonctionnel pour une approximation en chaîne de Markov au niveau des mots du livre.

Ensuite, il lui a demandé de simplement simuler la sortie d’une chaîne de Markov. Si Chat GPT disposait réellement d'un modèle de calcul allant au-delà de la simple prédiction statistique, Offert pensait qu'il devrait être capable d'estimer le résultat d'un programme sans l'exécuter. Il a découvert que l’IA pouvait simuler une chaîne de Markov au niveau des mots et des phrases. Cependant, il ne pouvait pas estimer le résultat d’une chaîne de Markov lettre par lettre. « Vous devriez obtenir une salade de lettres quelque peu cohérente, mais ce n'est pas le cas », a-t-il déclaré.

Ce résultat parut plutôt étrange à Offert. Chat GPT possédait clairement une compréhension plus nuancée de la programmation car il a réussi à coder une chaîne de Markov lors de la première tâche. Cependant, s’il possédait réellement un concept de calcul, alors prédire une chaîne de Markov au niveau des lettres devrait lui être assez facile. Cela nécessite beaucoup moins de calculs, de mémoire et d’efforts que de prédire le résultat au niveau des mots, ce qu’il a pu faire. Cela dit, il existe d'autres moyens de réaliser la prédiction au niveau des mots simplement parce que les LLM sont, de par leur conception, efficaces pour générer des mots.

"Sur la base de ce résultat, je dirais que Chat GPT n'a pas de modèle mondial de calcul", a déclaré Offert. "Il ne s'agit pas de simuler une bonne vieille machine de Turing avec accès à toutes les capacités de calcul." L'objectif d'Offert dans cet article était simplement de soulever des questions, mais pas d'y répondre. Il discutait simplement avec le programme, ce qui n'est pas une méthodologie appropriée pour une enquête scientifique. C'est subjectif, incontrôlé, non reproductible et le programme peut s'actualiser du jour au lendemain. « Il s'agit en réalité plus d'un entretien qualitatif que d'une expérience contrôlée », a-t-il expliqué. Je sonde juste la boîte noire, si vous voulez.

Offert souhaite développer une meilleure compréhension de ces nouvelles entités apparues ces dernières années. « Mon intérêt est vraiment épistémologique », a-t-il déclaré. « Que pouvons-nous savoir de ces choses ? Et que pouvons-nous savoir de ces choses ? Bien entendu, ces deux questions sont inextricablement liées.

Ces sujets ont commencé à susciter également l’intérêt des ingénieurs et des informaticiens. « De plus en plus, les questions que les chercheurs techniques posent à propos de l’IA sont essentiellement des questions de sciences humaines », a déclaré Offert. «Ils portent sur des idées philosophiques fondamentales, comme ce que signifie avoir une connaissance du monde et comment nous représentons la connaissance du monde.» C’est pourquoi Offert estime que les sciences humaines et sociales ont un rôle plus actif à jouer dans le développement de l’IA. Leur rôle pourrait être élargi pour éclairer la manière dont ces systèmes sont développés, comment ils sont utilisés et comment le public s'y engage.

Les différences entre les intelligences artificielles et humaines sont peut-être encore plus intrigantes que les similitudes. "Le caractère extraterrestre de ces systèmes est en fait ce qui les rend intéressants", a déclaré Offert. Par exemple, dans un article précédent, il a révélé que la façon dont l’IA catégorise et reconnaît les images peut être assez étrange de notre point de vue.

Dans une étude précédente, Offert a regardé derrière le rideau d’un modèle visuel. Cette photo se rapproche de sa conception des lunettes de soleil. (Image : Fabian Offert) Offert essaie en fin de compte de comprendre comment ces modèles représentent le monde et prennent des décisions. Parce qu’ils ont des connaissances sur le monde, nous assure-t-il – des connexions glanées à partir de leurs données de formation. Au-delà de l’intérêt épistémologique, le sujet revêt également une importance pratique pour aligner les motivations de l’IA sur celles de ses utilisateurs humains. À mesure que des outils tels que Chat GPT sont de plus en plus utilisés, ils rapprochent des disciplines auparavant indépendantes. Par exemple, la rédaction d’essais et la suppression du bruit en astronomie sont désormais toutes deux connectées à la même technologie sous-jacente. Selon Offert, cela signifie que nous devons commencer à examiner la technologie elle-même plus en détail en tant que manière fondamentalement nouvelle de générer des connaissances. Bénéficiant d’une subvention de trois ans de la Fondation Volkswagen sur le thème de la criminalistique de l’IA, Offert explore actuellement la culture visuelle des machines. Les modèles d'images sont devenus si volumineux et ont vu tellement de données, a-t-il expliqué, qu'ils ont développé des particularités basées sur leur matériel de formation. À mesure que ces outils se généraliseront, leurs bizarreries commenceront à se répercuter sur la culture humaine. En conséquence, Offert estime qu’il est important de comprendre ce qui se passe sous le capot de ces modèles d’IA. « C'est une période passionnante pour faire ce travail », a-t-il déclaré. "Je n'aurais pas imaginé cela il y a à peine cinq ans."

Dans une étude précédente, Offert a regardé derrière le rideau d’un modèle visuel. Cette photo se rapproche de sa conception des lunettes de soleil. (Image : Fabian Offert) Offert essaie en fin de compte de comprendre comment ces modèles représentent le monde et prennent des décisions. Parce qu’ils ont des connaissances sur le monde, nous assure-t-il – des connexions glanées à partir de leurs données de formation. Au-delà de l’intérêt épistémologique, le sujet revêt également une importance pratique pour aligner les motivations de l’IA sur celles de ses utilisateurs humains. À mesure que des outils tels que Chat GPT sont de plus en plus utilisés, ils rapprochent des disciplines auparavant indépendantes. Par exemple, la rédaction d’essais et la suppression du bruit en astronomie sont désormais toutes deux connectées à la même technologie sous-jacente. Selon Offert, cela signifie que nous devons commencer à examiner la technologie elle-même plus en détail en tant que manière fondamentalement nouvelle de générer des connaissances. Bénéficiant d’une subvention de trois ans de la Fondation Volkswagen sur le thème de la criminalistique de l’IA, Offert explore actuellement la culture visuelle des machines. Les modèles d'images sont devenus si volumineux et ont vu tellement de données, a-t-il expliqué, qu'ils ont développé des particularités basées sur leur matériel de formation. À mesure que ces outils se généraliseront, leurs bizarreries commenceront à se répercuter sur la culture humaine. En conséquence, Offert estime qu’il est important de comprendre ce qui se passe sous le capot de ces modèles d’IA. « C'est une période passionnante pour faire ce travail », a-t-il déclaré. "Je n'aurais pas imaginé cela il y a à peine cinq ans."

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.nanowerk.com/news2/robotics/newsid=63981.php