Aujourd'hui, nous lançons le support Terraform pour Ingestion d'Amazon OpenSearch. Terraform est un outil d'infrastructure en tant que code (IaC) qui vous aide à créer, déployer et gérer efficacement les ressources cloud. OpenSearch Ingestion est un collecteur de données sans serveur entièrement géré qui fournit des données de journal, de métrique et de trace en temps réel à Service Amazon OpenSearch domaines et Amazon OpenSearch sans serveur collections. Dans cet article, nous expliquons comment vous pouvez utiliser Terraform pour déployer des pipelines d'ingestion OpenSearch. A titre d'exemple, nous utilisons une source HTTP en entrée et un Service Amazon OpenSearch domaine (Index) en sortie.

Vue d'ensemble de la solution

Les étapes de cet article déploient un pipeline d'ingestion OpenSearch accessible au public avec Terraform, ainsi que d'autres ressources de prise en charge nécessaires au pipeline pour ingérer des données dans Amazon OpenSearch. Nous avons mis en œuvre le Didacticiel : Ingestion de données dans un domaine à l'aide d'Amazon OpenSearch Ingestion, en utilisant Terraform.

Nous créons les ressources suivantes avec Terraform :

Le pipeline que vous créez expose une source HTTP en entrée et un récepteur Amazon OpenSearch pour enregistrer des lots d'événements.

Pré-requis

Pour suivre les étapes de cet article, vous avez besoin des éléments suivants :

- Un compte AWS actif.

- Terraform installé sur votre machine locale. Pour plus d'informations, voir Installer Terraform.

- Les autorisations IAM nécessaires requises pour créer les ressources AWS à l'aide de Terraform.

- awscurl pour envoyer des requêtes HTTPS via la ligne de commande avec AWSSigv4 authentification. Pour obtenir des instructions sur l'installation de cet outil, consultez le GitHub repo.

Créer un annuaire

Dans Terraform, l'infrastructure est gérée sous forme de code, appelé Projet. Un projet Terraform contient divers fichiers de configuration Terraform, tels que main.tf, provider.tf, variables.tfet output.df . Créons un répertoire sur le serveur ou la machine que nous pouvons utiliser pour nous connecter aux services AWS à l'aide du Interface de ligne de commande AWS (AWS CLI) :

Accédez au répertoire.

Créer la configuration Terraform

Créez un fichier pour définir les ressources AWS.

Entrez la configuration suivante dans main.tf et sauvegardez votre fichier :

Créer les ressources

Initialisez le répertoire :

Examinez le plan pour voir quelles ressources seront créées :

Appliquer la configuration et répondre yes pour exécuter le plan :

Le processus peut prendre environ 7 à 10 minutes.

Tester le pipeline

Après avoir créé les ressources, vous devriez voir le ingest_endpoint_url sortie affichée. Copiez cette valeur et exportez-la dans votre variable d'environnement :

Envoyez un exemple de journal avec awscurl. Remplacez le profil par votre profil AWS approprié pour les informations d'identification :

Vous devriez recevoir un 200 OK en réponse.

Pour vérifier que les données ont été ingérées dans le pipeline d'ingestion OpenSearch et enregistrées dans OpenSearch, accédez à OpenSearch et obtenez son point de terminaison de domaine. Remplace le <OPENSEARCH ENDPOINT URL> dans l'extrait ci-dessous et exécutez-le.

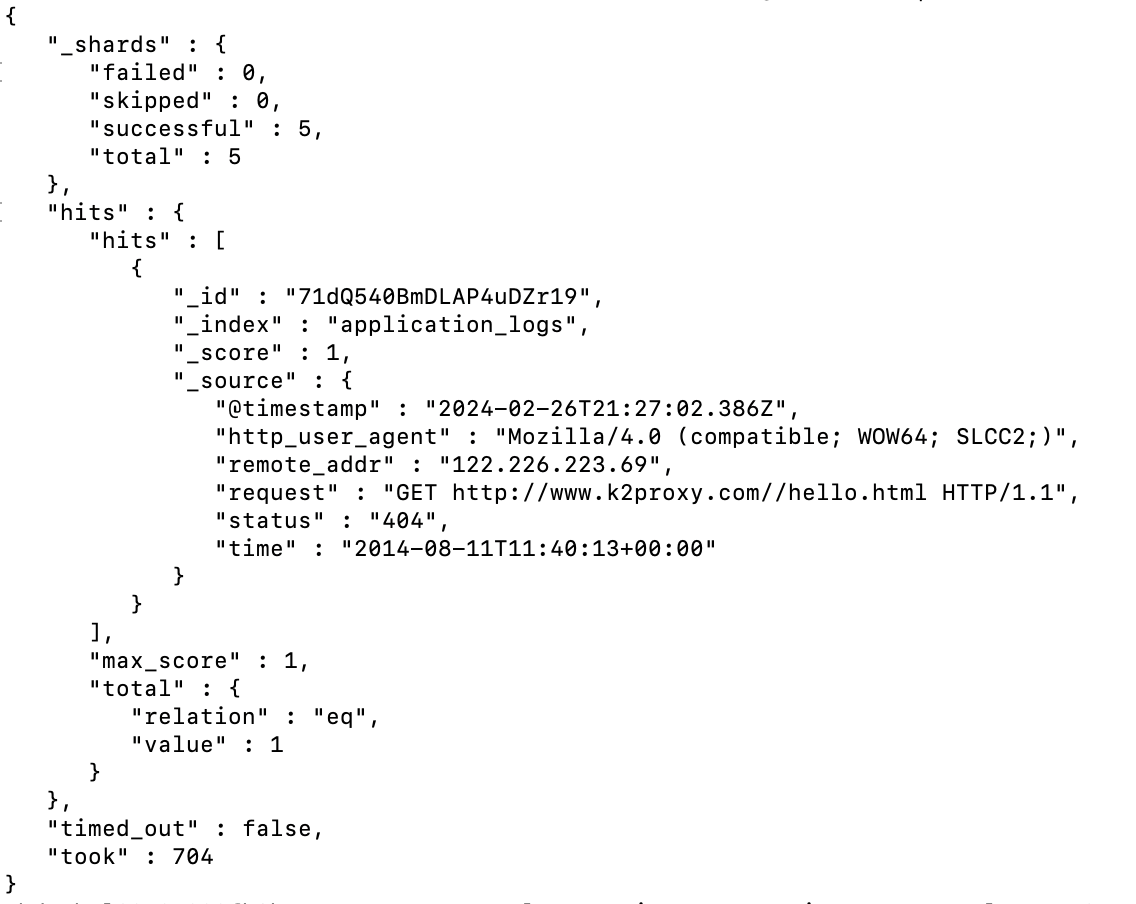

Vous devriez voir le résultat comme ci-dessous :

Nettoyer

Pour détruire les ressources que vous avez créées, exécutez la commande suivante et répondez yes lorsque vous y êtes invité :

Le processus peut prendre environ 30 à 35 minutes.

Conclusion

Dans cet article, nous avons montré comment utiliser Terraform pour déployer des pipelines d'ingestion OpenSearch. AWS propose divers NUMÉRIQUES pour que vous puissiez rapidement commencer à créer des pipelines à l'aide d'OpenSearch Ingestion et utiliser Terraform pour les déployer. Vous pouvez utiliser divers intégrations de pipelines pour ingérer rapidement des données de Amazon DynamoDB, Amazon Managed Streaming pour Apache Kafka (AmazonMSK), Lac de sécurité Amazon, Fluent Bit et bien d’autres. L'ingestion OpenSearch suivante blueprints vous permettent de créer des pipelines de données avec un minimum de modifications de configuration et de les gérer facilement à l'aide de Terraform. Pour en savoir plus, consultez le Documentation Terraform pour l'ingestion Amazon OpenSearch.

À propos des auteurs

Rahul Sharma est responsable de compte technique chez Amazon Web Services. Il est passionné par les technologies de données qui permettent d'exploiter les données en tant qu'actif stratégique et est basé à New York, New York.

Rahul Sharma est responsable de compte technique chez Amazon Web Services. Il est passionné par les technologies de données qui permettent d'exploiter les données en tant qu'actif stratégique et est basé à New York, New York.

Farhan Angullia est architecte d'applications cloud chez AWS Professional Services, basé à Singapour. Il se concentre principalement sur les applications modernes avec des modèles logiciels de microservices et préconise la mise en œuvre de pratiques CI/CD robustes afin d'optimiser le cycle de vie de livraison de logiciels pour les clients. Il aime contribuer à l’écosystème open source Terraform pendant son temps libre.

Farhan Angullia est architecte d'applications cloud chez AWS Professional Services, basé à Singapour. Il se concentre principalement sur les applications modernes avec des modèles logiciels de microservices et préconise la mise en œuvre de pratiques CI/CD robustes afin d'optimiser le cycle de vie de livraison de logiciels pour les clients. Il aime contribuer à l’écosystème open source Terraform pendant son temps libre.

Arjun Nambiar est chef de produit chez Amazon OpenSearch Service. Il se concentre sur les technologies d'ingestion qui permettent d'ingérer des données provenant d'une grande variété de sources dans Amazon OpenSearch Service à grande échelle. Arjun s'intéresse aux systèmes distribués à grande échelle et aux technologies cloud natives et est basé à Seattle, Washington.

Arjun Nambiar est chef de produit chez Amazon OpenSearch Service. Il se concentre sur les technologies d'ingestion qui permettent d'ingérer des données provenant d'une grande variété de sources dans Amazon OpenSearch Service à grande échelle. Arjun s'intéresse aux systèmes distribués à grande échelle et aux technologies cloud natives et est basé à Seattle, Washington.

Muthu Pitchamani est un spécialiste de la recherche avec Amazon OpenSearch Service. Il construit des applications et des solutions de recherche à grande échelle. Muthu s'intéresse aux sujets de la mise en réseau et de la sécurité et est basé à Austin, au Texas.

Muthu Pitchamani est un spécialiste de la recherche avec Amazon OpenSearch Service. Il construit des applications et des solutions de recherche à grande échelle. Muthu s'intéresse aux sujets de la mise en réseau et de la sécurité et est basé à Austin, au Texas.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/big-data/introducing-terraform-support-for-amazon-opensearch-ingestion/