En outre, une considération cruciale est de savoir comment ces technologies d’IA peuvent s’adapter et révolutionner les écosystèmes existants au sein d’infrastructures de grande valeur et à forte demande, telles que les aéroports, les avions et divers systèmes de mobilité avancés.

Utilisant des technologies d'IA innovantes et tirant parti des avantages de la plate-forme de l'Université de Cranfield, le Cours MSc Intelligence Artificielle Appliquée vise à former les futurs leaders de l’IA appliquée dans divers domaines d’ingénierie. Son objectif principal est d’accélérer le développement et le déploiement de technologies d’IA fiables pour les applications critiques pour la sécurité dans le monde entier.

Le projet de conception de groupe (GDP) est un module d'apprentissage basé sur des problèmes, et l'objectif du GDP est de permettre aux étudiants de concevoir, mettre en œuvre, valider et tester des systèmes basés sur l'IA en temps réel pour résoudre des problèmes du monde réel. Le GDP vise également à offrir aux étudiants l'expérience de travailler sur un projet d'ingénierie collaborative, en satisfaisant les exigences d'un client potentiel et en respectant les délais.

En 2022 et 2023, les étudiants inscrits à notre MSc en Intelligence Artificielle Appliquée se sont vu confier un projet de conception de groupe stimulant et exigeant. L’objectif était de tirer parti des connaissances appliquées en IA acquises lors de leurs cours pour développer des produits aéroportuaires innovants et plus sûrs. Travaillant en petites équipes de six personnes, les étudiants ont été chargés de concevoir des solutions englobant l'architecture logicielle et matérielle, le développement et les tests de modèles d'IA, ainsi que les aspects d'engagement dans le monde réel.

Le sujet du projet était intentionnellement large, exigeant que les étudiants collaborent au sein de leurs groupes pour explorer et affiner des domaines d'intérêt spécifiques en fonction de leur expertise et de leurs intérêts collectifs. Cette approche a favorisé la créativité, le travail d’équipe et une compréhension plus approfondie de l’application pratique des technologies d’IA dans des scénarios du monde réel.

Chaque groupe a été invité à développer des solutions d'IA en temps réel pour les aéroports intelligents afin d'atteindre les fonctionnalités suivantes :

- Le système doit être capable de détecter les utilisateurs humains et d'estimer leurs poses et leurs comportements sur la base d'une détection et d'un suivi précis des poses.

- Le système doit être capable de classer différents comportements de foule et de clarifier les raisons, l'importance et la faisabilité.

- Le modèle d'IA doit être validé de manière croisée avec différentes mesures de précision, de calcul et d'inférence.

- Le modèle d'IA devrait pouvoir être mis en œuvre en temps réel pour informer sur les avantages et les inconvénients des technologies d'IA actuelles dans ces applications critiques pour la sécurité.

- Le système peut s'appuyer sur différentes sources de capteurs comme entrée pour permettre la fusion de capteurs pour des performances robustes. Toutefois, des solutions très peu coûteuses mais efficaces sont également les bienvenues.

Étude de cas 1 : Détection de chute dans un environnement de maintenance aéronautique.

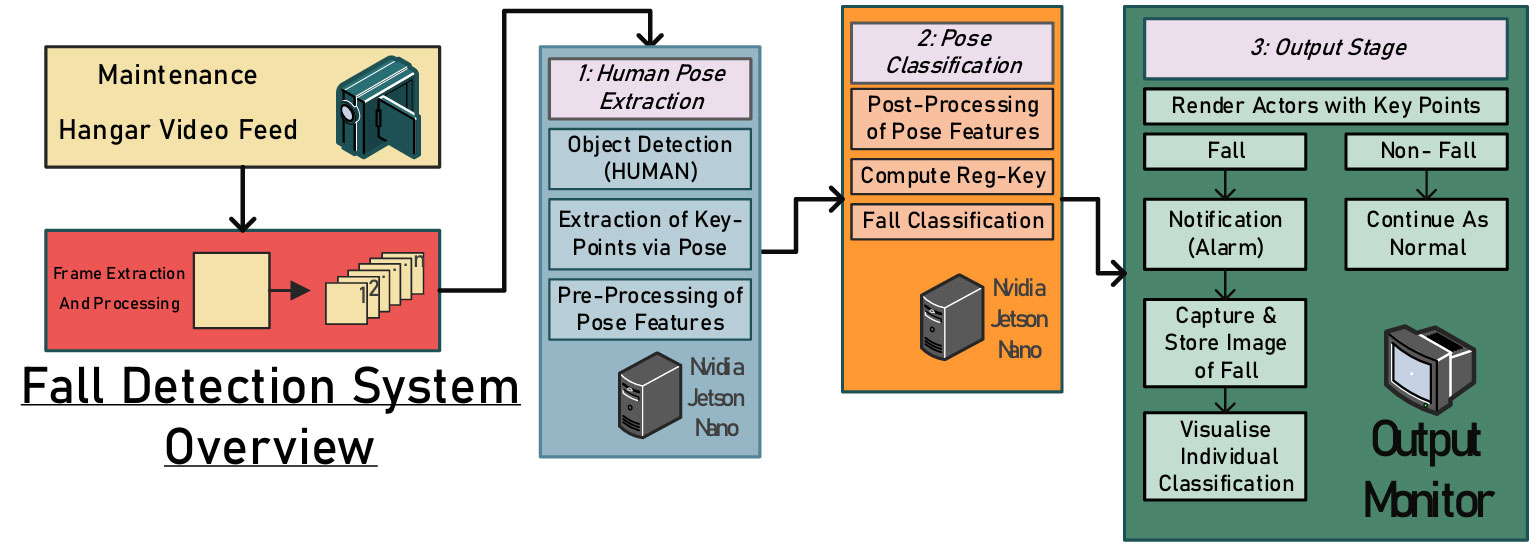

Les environnements de maintenance présentent des dangers importants, notamment des machines sans surveillance, des clôtures ou des protections physiques inadéquates à proximité des zones dangereuses et des espaces de travail encombrés. Parmi ces risques, les chutes mortelles sont extrêmement fréquentes. Détecter et signaler rapidement les incidents non mortels pourrait prévenir d’autres préjudices ou décès. Par conséquent, ce travail propose un système intégré basé sur la vision pour surveiller les employés pendant les activités de maintenance des avions, améliorant ainsi la sécurité et prévenant les accidents (voir la figure ci-dessous).

.fusion-gallery-1 .fusion-gallery-image {border:0px solid #e2e2e2;}

D’après les résultats initiaux de formation et de validation du modèle conçu, l’absence apparente d’un ensemble de données prêts à l’emploi sur la maintenance des hangars d’aéroport présente une possibilité de biais en faveur d’images provenant de vidéos capturées sous des angles de caméra perpendiculaires prises à proximité du sujet. Tirant parti des avantages de Cranfield, le hangar de maintenance de l'Université de Cranfield a été choisi et utilisé pour la collecte de données dans le cadre de ce projet.

Au total, environ 50 courtes vidéos (de deux à cinq minutes) d'activités de maintenance simulées ont été enregistrées, certaines avec des chutes et d'autres sans. Les vidéos capturées ont été découpées en images et annotées à l'aide de la bibliothèque du logiciel d'estimation de pose MoveNet et des cartes vectorielles des positions articulaires clés du sujet ont été générées. La figure ci-dessous montre quelques instantanés des données expérimentales.

.fusion-gallery-2 .fusion-gallery-image {border:0px solid #e2e2e2;}

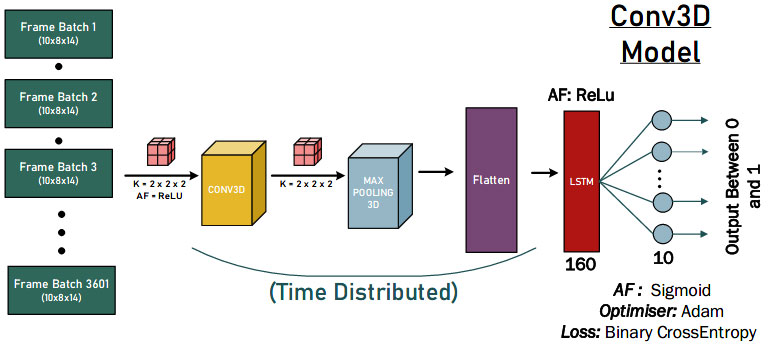

Nos étudiants ont testé les approches de réseaux neuronaux convolutifs 1D, 2D et 3D pour évaluer quantitativement la conception du modèle d'IA le plus puissant. La figure ci-dessous est une démonstration des solutions de convolution 3D.

.fusion-gallery-3 .fusion-gallery-image {border:0px solid #e2e2e2;}

Enfin, les solutions d'IA proposées ont obtenu de bons résultats de détection du comportement de chute, comme le montre la figure ci-dessous. Quelques conclusions peuvent être tirées. Premièrement, le modèle n’avait aucune classification FP, ce qui suggère que le modèle ne classe pas mal une chute. Deuxièmement, il y a 0 vrais négatifs pour chaque modèle, cela pourrait probablement être dû au fait que chaque donnée de test contient une partie de non-chutes (classée 940) avant que l'acteur ne tombe.

.fusion-gallery-4 .fusion-gallery-image {border:0px solid #e2e2e2;}

Étude de cas 2 : Détection des signes vitaux de l'infarctus du myocarde à l'aide de la vision par ordinateur et de l'IA de pointe

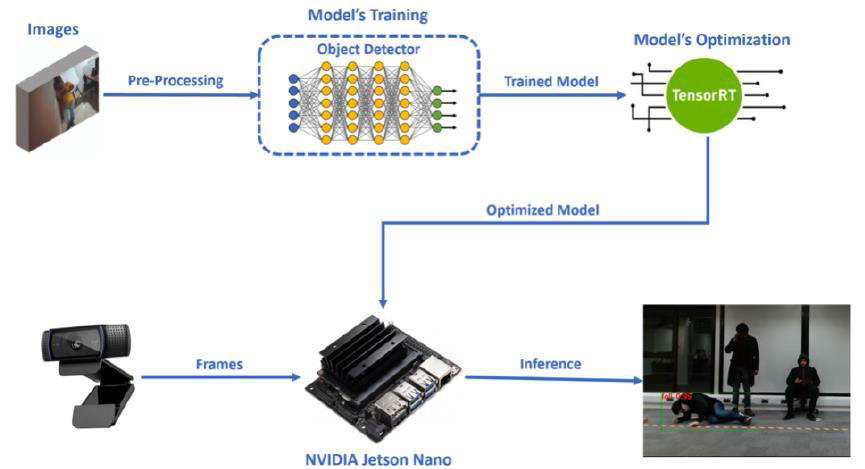

Edge AI fait référence au déploiement d’applications d’intelligence artificielle dans des appareils situés dans l’environnement physique. Le prix abordable et la facilité d’utilisation sont des facteurs clés dans l’adoption d’algorithmes d’IA dans des situations où les utilisateurs finaux sont confrontés à des défis réels. Dans ce projet, notre étudiant a proposé un modèle léger et peu coûteux de détection des crises cardiaques pour une intervention et un sauvetage rapides à l'aéroport. Le processus est composé de quatre étapes principales, comme le montre la figure ci-dessous.

.fusion-gallery-5 .fusion-gallery-image {border:0px solid #e2e2e2;}

La première étape constitue la sélection et la préparation appropriées d'un ensemble de données d'images, ainsi que les annotations nécessaires pour les boîtes englobantes des classes (douleur thoracique, chute).

De plus, dans une deuxième étape, vient la formation de notre modèle de détecteur d’objets via l’apprentissage par transfert. L'étape spécifique a été réalisée dans Google Colab, à l'aide de PyTorch. Par la suite, une fois la phase de formation terminée, le modèle a été inséré dans le Jetson Nano de NVIDIA, qui était notre périphérique embarqué choisi pour être utilisé pour notre application de vision par ordinateur Edge AI.

La troisième étape de la conception de notre système a été la conversion et l'optimisation appropriées du modèle, afin qu'il fonctionne plus efficacement sur Jetson Nano. L'optimisation de notre modèle a été réalisée à l'aide du moteur d'inférence TensorRT de NVIDIA et le processus spécifique a été exécuté dans Jetson Nano (comme le montre la figure ci-dessous).

.fusion-gallery-6 .fusion-gallery-image {border:0px solid #e2e2e2;}

La dernière étape est l'exécution du modèle optimisé sur Jetson Nano, en utilisant comme entrées les images qu'il reçoit d'une webcam, pour effectuer le processus de détection d'objets en temps réel et détecter nos classes (douleur thoracique, chute). Parallèlement à ce processus, dans le code d'inférence qui s'exécute sur Jetson Nano, il existe deux scénarios spécifiques. Les résultats finaux de l'inférence sont présentés dans la figure ci-dessous.

.fusion-gallery-7 .fusion-gallery-image {border:0px solid #e2e2e2;}

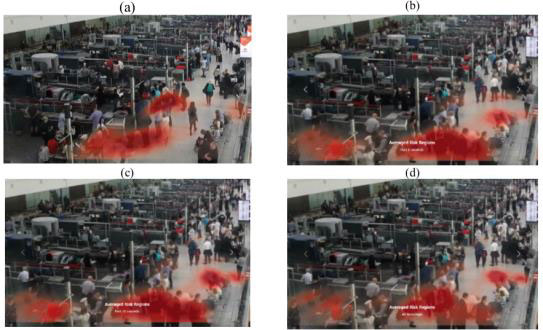

Étude de cas 3 : Surveillance des foules et analyse de la distance sociale

Les aéroports connaissent chaque jour d’énormes flux de passagers et, à l’instar d’autres lieux et organisations très fréquentés, ils doivent assurer la sécurité publique et veiller à ce que des mesures adéquates soient mises en œuvre pour atténuer les risques en cas de pandémie. Dans ce projet, nos étudiants ont proposé un système intégré basé sur la vision par ordinateur qui fournit une surveillance et une analyse multifonctionnelle des foules dans tous les aéroports. Les résultats du système sont destinés à bénéficier aussi bien au personnel de gestion de l'aéroport qu'aux passagers, en fournissant des analyses et des renseignements basés sur la foule.

Le système consiste en une plateforme intégrée (voir la figure ci-dessous) pour analyser et surveiller les foules dans les lieux publics à l'aide de flux de vidéosurveillance. L’accent est spécifiquement mis sur les aéroports intelligents, mais le cadre de base est adaptable à tout contexte public où l’analyse et le suivi des caractéristiques des foules sont utiles.

.fusion-gallery-8 .fusion-gallery-image {border:0px solid #e2e2e2;}

Les fonctionnalités de pose extraites d'une scène sont utilisées par les modèles en aval du système pour effectuer des tâches uniques. Cela comprend le comptage de personnes, l'estimation de la distance interpersonnelle, la détection d'objets masqués, la classification des statuts (assis, debout, marchant, couché, etc.) et le regroupement social. Les résultats sont ensuite combinés pour former le tableau de bord intégré et le système de surveillance. À l'exception de l'utilisation courante des fonctionnalités de pose, ces tâches représentent des défis uniques avec différentes approches de modélisation. Heureusement, grâce à la conception modulaire du système, il a été possible d’abstraire chaque tâche et de la laisser développer par différents membres de l’équipe.

.fusion-gallery-9 .fusion-gallery-image {border:0px solid #e2e2e2;}

Enfin, une interface interactive est conçue pour intégrer toutes les sorties en aval dans une seule fenêtre (voir la figure ci-dessous). L'application télécharge les fichiers de données créés par les modèles en aval sur le tableau de bord en temps réel afin qu'une analyse de l'état actuel de la scène puisse être effectuée. À tout moment, les images originales de la scène peuvent être visionnées, ainsi que les caractéristiques de pose extraites de chaque personne sur un lecteur vidéo adjacent. Le décideur peut basculer entre une vue en boîte à moustaches et une vue en carte thermique, puis modifier la séquence sur laquelle les données sont reçues à partir de deux menus déroulants. Les statistiques concernant la scène sont affichées tout à droite de la fenêtre. Ces statistiques sont le statut total du masque de la personne, le profil de risque total, le statut total des personnes posées, le nombre total de personnes, les proportions de distance sociale et les proportions en boîte à moustaches.

.fusion-gallery-10 .fusion-gallery-image {border:0px solid #e2e2e2;}

Étude de cas 4 : Détection de la violence à l'aéroport

Enfin, l'un de nos groupes vise à développer un cadre de détection de la violence qui estime les poses humaines et classe les comportements violents dans les images de surveillance (comme le montre la figure ci-dessous). Au lieu d'extraire directement les caractéristiques des images vidéo, ce framework utilise ViTPose pour détecter les poses humaines dans chaque image, puis prétraite et extrait les caractéristiques des informations sur les points clés.

.fusion-gallery-11 .fusion-gallery-image {border:0px solid #e2e2e2;}

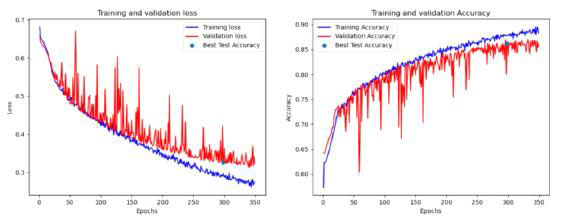

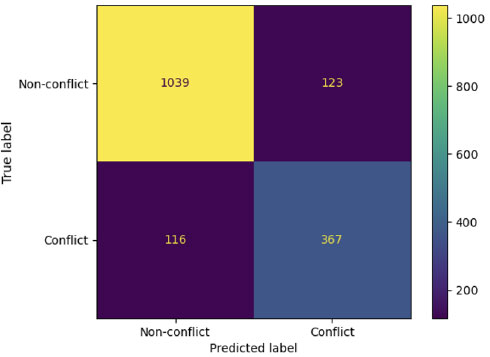

Grâce à une analyse complète de divers modèles utilisant plusieurs ensembles de données (séquences basées sur l'angle, basées sur la distance, 1 seconde et 2 secondes) avec un total de 162 combinaisons d'hyperparamètres, l'équipe a finalement identifié plusieurs modèles prometteurs qui répondent à des critères d'évaluation spécifiques. On peut conclure que les modèles peuvent extraire des informations précieuses sur les comportements violents en utilisant les caractéristiques de distance des points clés du corps, comme le montre la figure ci-dessous.

.fusion-gallery-12 .fusion-gallery-image {border:0px solid #e2e2e2;}

Enfin, en collaborant avec Saab UK, nos étudiants peuvent développer et intégrer leurs modèles d'IA avec la plateforme de niveau industriel (SAFE), une puissante plateforme de connaissance de la situation largement utilisée dans de nombreux commissariats de police britanniques à des fins de surveillance. La passerelle KAFKA est appliquée en suivant le moteur d'IA et transmise au terminal client pour un affichage et des alertes supplémentaires. S'il y a de la violence détectée dans la vidéo interceptée avec des cadres de délimitation, cela déclenchera l'alarme que nous avons configurée spécifiquement pour notre modèle montrant la vidéo interceptée dans la mise en page du client SAFE, cela nous donnera le message d'alerte avec des détails. En fin de compte, nos étudiants ont déployé avec succès le modèle d'IA de notre centre DARTeC et ont communiqué avec le système Saab SAFE pour augmenter la connaissance de la situation humaine.

.fusion-gallery-13 .fusion-gallery-image {border:0px solid #e2e2e2;}

Créer les ingénieurs en IA appliquée du futur

Ce ne sont là que quelques exemples sélectionnés de projets GDP intéressants du cours MSc AAI. Récemment, nos étudiants actuels ont entrepris des projets GDP plus ambitieux en matière d'interface explicable avec l'IA, de raisonnement causal pour la planification de mouvements autonomes, d'IA basée sur la physique pour les véhicules autonomes et de gestion future de l'espace aérien. Nous pensons que des recherches plus passionnantes seront bientôt menées par nos étudiants en maîtrise.

Consultez les publications de recherche suivantes de nos étudiants pendant le PIB pour voir à quel point les solutions et les résultats finaux sont intéressants :

- Osigbesan, Adeyemi, Solene Barrat, Harkeerat Singh, Dongzi Xia, Siddharth Singh, Yang Xing, Weisi Guo et Antonios Tsourdos. « Détection de chute basée sur la vision dans un environnement de maintenance d'aéronefs avec estimation de la pose. » En 2022, conférence internationale de l'IEEE sur la fusion et l'intégration multicapteurs pour les systèmes intelligents (MFI), pp. IEEE, 1.

- Fraser, Benjamin, Brendan Copp, Gurpreet Singh, Orhan Keyvan, Tongfei Bian, Valentin Sonntag, Yang Xing, Weisi Guo et Antonios Tsourdos. « Réduire la transmission virale grâce à la surveillance des foules et à l'analyse de la distance sociale basées sur l'IA. » En 2022, conférence internationale de l'IEEE sur la fusion et l'intégration multicapteurs pour les systèmes intelligents (MFI), pp. IEEE, 1.

- Üstek, İ., Desai, J., Torrecillas, IL, Abadou, S., Wang, J., Fever, Q., Kasthuri, SR, Xing, Y., Guo, W. et Tsourdos, A., 2023, Août. Détection de la violence en deux étapes à l'aide de modèles ViTPose et de classification dans les aéroports intelligents. Au Congrès IEEE Smart World (SWC) 2023 (pp. 797-802). IEEE.

- Benoit, Paul, Marc Bresson, Yang Xing, Weisi Guo et Antonios Tsourdos. "Détection d'actions violentes basée sur la vision en temps réel grâce à des caméras de vidéosurveillance avec estimation de la pose." Dans le Congrès IEEE Smart World Congress (SWC) 2023, pp. IEEE, 844.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://blogs.cranfield.ac.uk/aerospace/exploring-safer-and-smarter-airports-with-the-applied-artificial-intelligence-msc-group-design-project/