Image par auteur

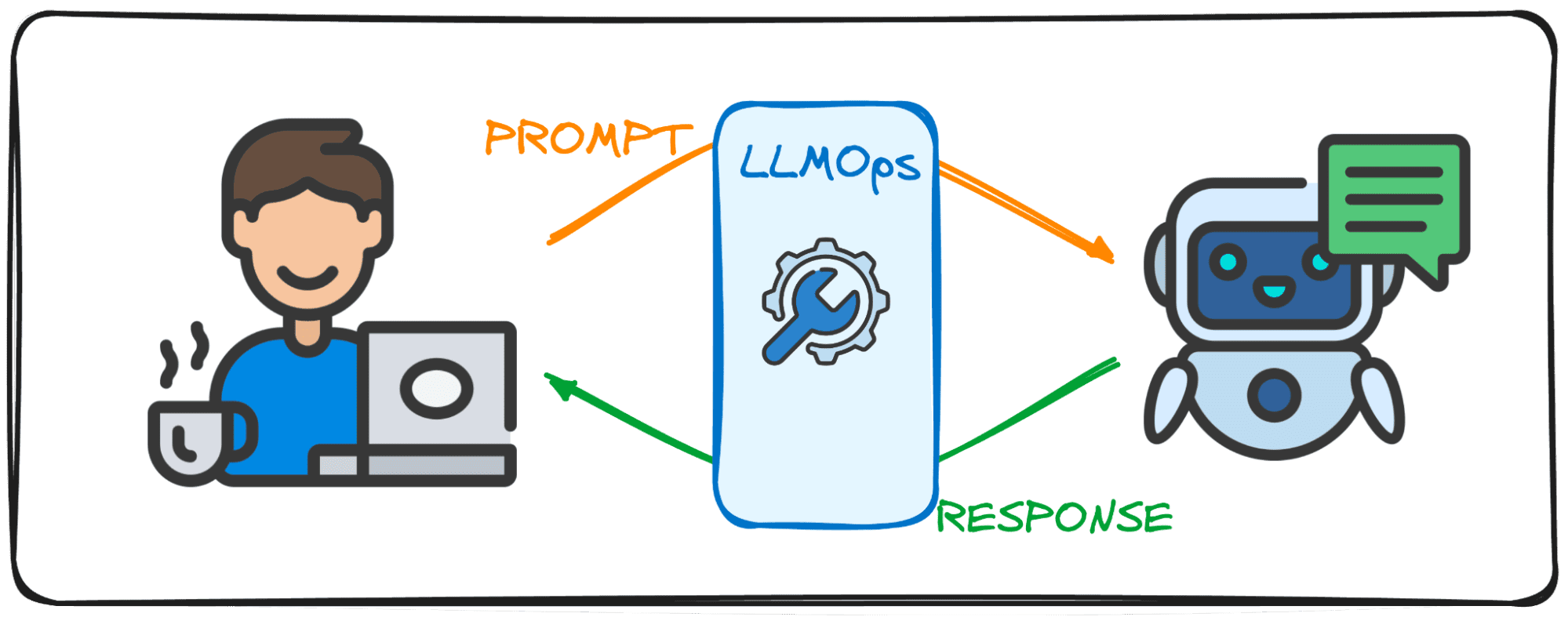

Les grands modèles linguistiques (LLM) sont un nouveau type d'intelligence artificielle formé sur d'énormes quantités de données textuelles. Leur principale capacité est de générer un texte de type humain en réponse à un large éventail d'invites et de demandes.

Je parie que vous avez déjà une certaine expérience avec les solutions LLM populaires comme ChatGPT ou Google Gemini.

Mais vous êtes-vous déjà demandé comment ces modèles puissants offrent des réponses aussi rapides comme l'éclair ?

La réponse réside dans un domaine spécialisé appelé LLMOps.

Avant de plonger dans le vif du sujet, essayons de visualiser l’importance de ce domaine.

Imaginez que vous avez une conversation avec un ami. La chose normale à laquelle vous vous attendez, c'est que lorsque vous posez une question, ils vous donnent immédiatement une réponse et que le dialogue se déroule sans effort.

Droite?

Cet échange fluide est également ce à quoi les utilisateurs s'attendent lorsqu'ils interagissent avec des modèles linguistiques étendus (LLM). Imaginez discuter avec ChatGPT et devoir attendre quelques minutes à chaque fois que nous envoyons une invite, personne ne l'utiliserait du tout, du moins je ne le ferais pas avec certitude.

C'est pourquoi les LLM visent à atteindre ce flux de conversation et cette efficacité dans leurs solutions numériques avec le domaine LLMOps. Ce guide a pour objectif de vous accompagner dans vos premiers pas dans ce tout nouveau domaine.

LLMOps, abréviation de Large Language Model Operations, est la magie en coulisses qui garantit le fonctionnement efficace et fiable des LLM. Il représente une avancée par rapport aux MLOps familiers, spécialement conçus pour relever les défis uniques posés par les LLM.

Alors que MLOps se concentre sur la gestion du cycle de vie des modèles généraux d'apprentissage automatique, LLMOps s'occupe spécifiquement des exigences spécifiques au LLM.

Lorsque vous utilisez des modèles d'entités comme OpenAI ou Anthropic via des interfaces Web ou des API, les LLMOps travaillent en coulisses, rendant ces modèles accessibles en tant que services. Cependant, lors du déploiement d'un modèle pour une application spécialisée, la responsabilité LLMOps repose sur nous.

Pensez-y donc comme un modérateur qui s'occupe du déroulement d'un débat. Tout comme le modérateur assure le bon déroulement de la conversation et l'aligne sur le sujet du débat, en s'assurant toujours qu'il n'y a pas de gros mots et en essayant d'éviter les fausses nouvelles, LLMOps garantit que les LLM fonctionnent à des performances optimales, offrant des expériences utilisateur transparentes et vérifiant la sécurité du sortir.

La création d'applications avec des modèles de langage étendus (LLM) présente des défis distincts de ceux rencontrés avec l'apprentissage automatique conventionnel. Pour y faire face, des outils et méthodologies de gestion innovants ont été conçus, donnant naissance au cadre LLMOps.

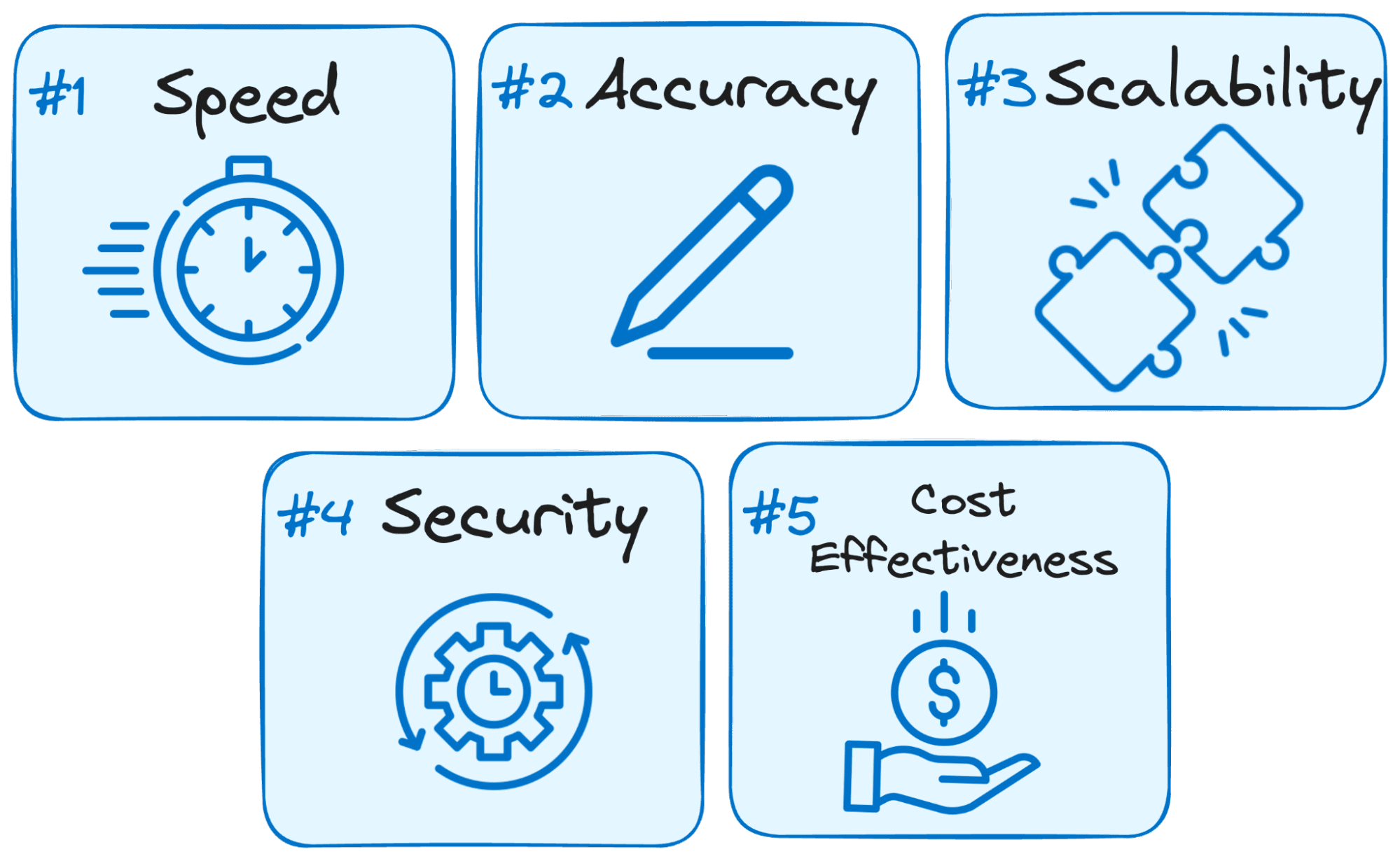

Voici pourquoi LLMOps est crucial pour le succès de toute application basée sur LLM :

Image par auteur

- La vitesse est la clé : Les utilisateurs attendent des réponses immédiates lorsqu'ils interagissent avec les LLM. LLMOps optimise le processus pour minimiser la latence, garantissant ainsi que vous obtenez des réponses dans un délai raisonnable.

- La précision compte : LLMOps met en œuvre diverses vérifications et contrôles pour garantir l'exactitude et la pertinence des réponses du LLM.

- Évolutivité pour la croissance : À mesure que votre application LLM gagne du terrain, LLMOps vous aide à faire évoluer efficacement vos ressources pour gérer la charge croissante des utilisateurs.

- La sécurité est primordiale : LLMOps sauvegarde l'intégrité du système LLM et protège les données sensibles en appliquant des mesures de sécurité robustes.

- Rentabilité: L’exploitation des LLM peut être exigeante financièrement en raison de leurs besoins importants en ressources. LLMOps met en œuvre des méthodes économiques pour maximiser efficacement l'utilisation des ressources, garantissant que les performances maximales ne sont pas sacrifiées.

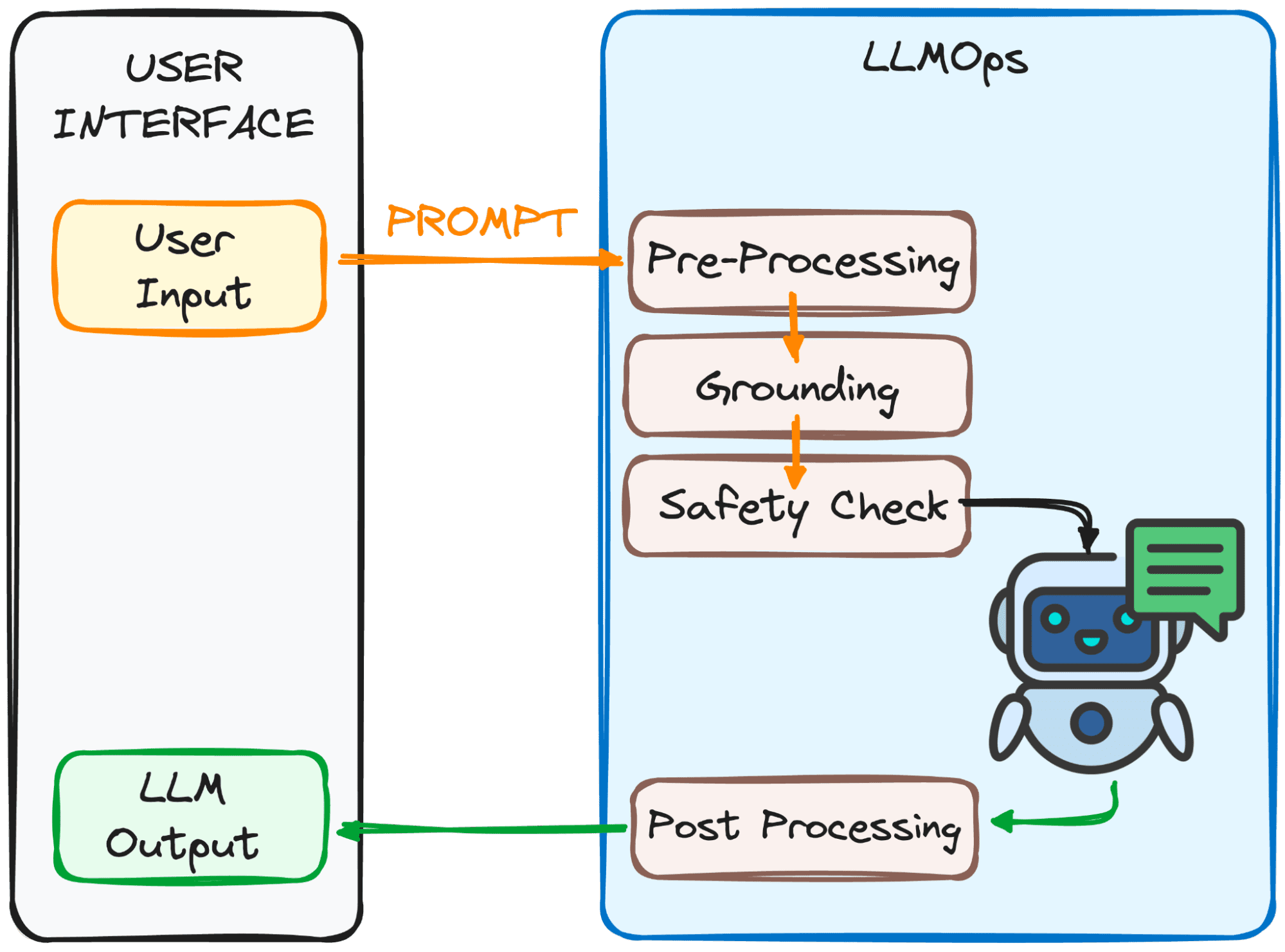

LLMOps s'assure que votre invite est prête pour le LLM et que sa réponse vous revient le plus rapidement possible. Cependant, ce n’est pas du tout facile.

Ce processus comporte plusieurs étapes, principalement 4, que l'on peut observer dans l'image ci-dessous.

Image par auteur

Le but de ces démarches ?

Pour rendre l'invite claire et compréhensible pour le modèle.

Voici un aperçu de ces étapes :

1. Pré-traitement

L'invite passe par une première étape de traitement. Tout d’abord, il est décomposé en morceaux plus petits (jetons). Ensuite, toutes les fautes de frappe ou caractères étranges sont nettoyés et le texte est formaté de manière cohérente.

Enfin, les jetons sont intégrés dans des données numériques afin que le LLM les comprenne.

2. Mise à la terre

Avant que le modèle ne traite notre invite, nous devons nous assurer qu'il comprend la situation dans son ensemble. Cela peut impliquer de faire référence à des conversations antérieures que vous avez eues avec le LLM ou d'utiliser des informations extérieures.

De plus, le système identifie les éléments importants mentionnés dans l'invite (comme les noms ou les lieux) pour rendre la réponse encore plus pertinente.

3. Contrôle de sécurité :

Tout comme pour les règles de sécurité sur le plateau, LLMOps s'assure que l'invite est utilisée de manière appropriée. Le système vérifie des éléments tels que des informations sensibles ou du contenu potentiellement offensant.

Ce n’est qu’après avoir réussi ces contrôles que l’invite est prête pour l’acte principal – le LLM !

Nous avons maintenant notre invite prête à être traitée par le LLM. Cependant, ses résultats doivent également être analysés et traités. Donc, avant de le voir, quelques ajustements supplémentaires sont effectués à la quatrième étape :

3. Post-traitement

Vous vous souvenez du code dans lequel l'invite a été convertie ? La réponse doit être retraduite en texte lisible par l’homme. Ensuite, le système peaufine la réponse en termes de grammaire, de style et de clarté.

Toutes ces étapes se déroulent de manière transparente grâce à LLMOps, le membre d'équipage invisible garantissant une expérience LLM fluide.

Impressionnant, non?

Voici quelques-uns des éléments essentiels d’une configuration LLMOps bien conçue :

- Choisir le bon LLM : Avec une vaste gamme de modèles LLM disponibles, LLMOps vous aide à sélectionner celui qui correspond le mieux à vos besoins et ressources spécifiques.

- Ajustement précis de la spécificité : LLMOps vous permet d'affiner les modèles existants ou de former les vôtres, en les personnalisant pour votre cas d'utilisation unique.

- Ingénierie rapide : LLMOps vous fournit des techniques pour créer des invites efficaces qui guident le LLM vers le résultat souhaité.

- Déploiement et surveillance : LLMOps rationalise le processus de déploiement et surveille en permanence les performances du LLM, garantissant ainsi une fonctionnalité optimale.

- Mesures de sécurité : LLMOps donne la priorité à la sécurité des données en mettant en œuvre des mesures robustes pour protéger les informations sensibles.

À mesure que la technologie LLM continue d'évoluer, LLMOps jouera un rôle essentiel dans les développements technologiques à venir. Une grande partie du succès des dernières solutions populaires telles que ChatGPT ou Google Gemini réside dans leur capacité non seulement à répondre à toutes les demandes, mais également à offrir une bonne expérience utilisateur.

C'est pourquoi, en garantissant un fonctionnement efficace, fiable et sécurisé, LLMOps ouvrira la voie à des applications LLM encore plus innovantes et transformatrices dans divers secteurs qui profiteront à encore plus de personnes.

Avec une solide compréhension des LLMOps, vous êtes bien équipé pour tirer parti de la puissance de ces LLM et créer des applications révolutionnaires.

Joseph Ferrier est un ingénieur analytique de Barcelone. Il est diplômé en ingénierie physique et travaille actuellement dans le domaine de la science des données appliquée à la mobilité humaine. Il est créateur de contenu à temps partiel axé sur la science et la technologie des données. Josep écrit sur tout ce qui concerne l'IA, couvrant l'application de l'explosion en cours dans ce domaine.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://www.kdnuggets.com/getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions?utm_source=rss&utm_medium=rss&utm_campaign=getting-started-with-llmops-the-secret-sauce-behind-seamless-interactions