Un certain nombre d'expériences suggèrent que ChatGPT, le grand modèle de langage populaire (LLM), pourrait être utile pour aider les défenseurs à trier les incidents de sécurité potentiels et à trouver les vulnérabilités de sécurité dans le code, même si le modèle d'intelligence artificielle (IA) n'a pas été spécifiquement formé pour de telles activités. , selon les résultats publiés cette semaine.

Dans une analyse du 15 février de l'utilité de ChatGPT en tant qu'outil de réponse aux incidents, Victor Sergeev, responsable de l'équipe de réponse aux incidents chez Kaspersky, a découvert que ChatGPT pouvait identifier les processus malveillants exécutés sur des systèmes compromis. Sergeev a infecté un système avec les agents Meterpreter et PowerShell Empire, a pris des mesures communes dans le rôle d'un adversaire, puis a exécuté un scanner alimenté par ChatGPT contre le système.

Le LLM a identifié deux processus malveillants en cours d'exécution sur le système et a correctement ignoré 137 processus bénins, réduisant potentiellement les frais généraux de manière significative, a-t-il écrit dans un article de blog décrivant l'expérience.

"ChatGPT a identifié avec succès les installations de service suspectes, sans faux positifs", Sergeev a écrit. "Pour le deuxième service, il a fourni une conclusion sur les raisons pour lesquelles le service devrait être classé comme un indicateur de compromis."

Les chercheurs en sécurité et les pirates informatiques se sont tous intéressés à ChatGPT, sondant les faiblesses du LLM, tandis que d'autres chercheurs, ainsi que des cybercriminels, ont tenté de attirer le LLM du côté obscur, en le définissant sur produire de meilleurs e-mails de phishing or générer des logiciels malveillants.

Pourtant, les chercheurs en sécurité étudient également les performances du modèle de langage généralisé sur des tâches spécifiques liées à la défense. En décembre, la société d'investigation numérique Cado Security a utilisé ChatGPT pour créer une chronologie d'un compromis en utilisant les données JSON d'un incident, ce qui a produit un bon rapport, mais pas totalement précis. Le cabinet de conseil en sécurité NCC Group a expérimenté ChatGPT comme un moyen de trouver des vulnérabilités dans le code, ce qu'il a fait, mais pas toujours avec précision.

La conclusion est que les analystes en sécurité, les développeurs et les rétro-ingénieurs doivent faire preuve de prudence lorsqu'ils utilisent des LLM, en particulier pour des tâches qui ne relèvent pas de leurs capacités, déclare Chris Anley, scientifique en chef du cabinet de conseil en sécurité NCC Group.

"Je pense vraiment que les développeurs professionnels et les autres personnes qui travaillent avec du code devraient explorer ChatGPT et des modèles similaires, mais plus pour l'inspiration que pour des résultats factuels absolument corrects", dit-il, ajoutant que "l'examen du code de sécurité n'est pas quelque chose que nous devrions utiliser ChatGPT, il est donc injuste de s'attendre à ce qu'il soit parfait du premier coup.

Analyser les IoC avec l'IA

L'expérience Kaspersky a commencé par interroger ChatGPT sur plusieurs outils de pirates, tels que Mimikatz et Fast Reverse Proxy. Le modèle d'IA a décrit avec succès ces outils, mais lorsqu'on lui a demandé d'identifier des hachages et des domaines bien connus, il a échoué. Le LLM n'a pas pu identifier un hachage bien connu du malware WannaCry, par exemple.

Le succès relatif de l'identification du code malveillant sur l'hôte a cependant conduit Sergeev de Kasperky à demander à ChatGPT de créer un script PowerShell pour collecter les métadonnées et les indicateurs de compromission d'un système et les soumettre au LLM. Après avoir amélioré le code manuellement, Sergeev a utilisé le script sur le système de test infecté.

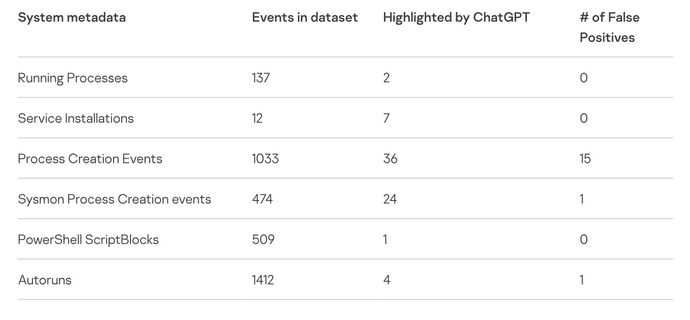

Dans l'ensemble, l'analyste de Kaspersky a utilisé ChatGPT pour analyser les métadonnées de plus de 3,500 74 événements sur le système de test, trouvant 17 indicateurs potentiels de compromission, dont XNUMX étaient de faux positifs. L'expérience suggère que ChatGPT pourrait être utile pour collecter des informations médico-légales pour les entreprises qui n'exécutent pas de système de détection et de réponse aux points de terminaison (EDR), détecter l'obscurcissement du code ou inverser les binaires de code d'ingénierie.

Sergeev a également averti que les inexactitudes sont un problème très réel. "Méfiez-vous des faux positifs et des faux négatifs que cela peut produire", a-t-il écrit. "En fin de compte, il ne s'agit que d'un autre réseau de neurones statistiques susceptible de produire des résultats inattendus."

Dans son analyse, Cado Security a averti que ChatGPT ne qualifie généralement pas la confiance de ses résultats. "C'est une préoccupation commune avec ChatGPT qu'OpenAI [s'est] soulevée - elle peut halluciner, et quand elle hallucine, elle le fait avec confiance", a déclaré l'analyse de Cado.

Les règles d'utilisation équitable et de confidentialité doivent être clarifiées

Les expériences soulèvent également des problèmes critiques concernant les données soumises au système ChatGPT d'OpenAI. Déjà, les entreprises ont commencé à s'opposer à la création d'ensembles de données à partir d'informations sur Internet, avec des entreprises telles que IA Clearview ainsi que IA de stabilité face à des poursuites visant à restreindre leur utilisation de leurs modèles d'apprentissage automatique.

La confidentialité est un autre problème. Les professionnels de la sécurité doivent déterminer si les indicateurs de compromis soumis exposent des données sensibles ou si la soumission de code logiciel pour analyse viole la propriété intellectuelle d'une entreprise, explique Anley du groupe NCC.

"La question de savoir si c'est une bonne idée de soumettre du code à ChatGPT dépend beaucoup des circonstances", dit-il. "Une grande partie du code est propriétaire et est sous diverses protections légales, donc je ne recommanderais pas que les gens soumettent du code à des tiers à moins qu'ils n'aient la permission de le faire."

Sergeev a émis un avertissement similaire : l'utilisation de ChatGPT pour détecter les compromis envoie par nécessité des données sensibles au système, ce qui pourrait constituer une violation de la politique de l'entreprise et présenter un risque commercial.

"En utilisant ces scripts, vous envoyez des données, y compris des données sensibles, à OpenAI", a-t-il déclaré, "donc soyez prudent et consultez le propriétaire du système au préalable."

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- Platoblockchain. Intelligence métaverse Web3. Connaissance Amplifiée. Accéder ici.

- La source: https://www.darkreading.com/analytics/chatgpt-subs-security-analyst-hallucinates-occasionally