Cet article est co-écrit avec Sherwin Chu d'Alida.

Alida aide les plus grandes marques mondiales à créer des communautés de recherche très engagées pour recueillir des commentaires qui alimentent de meilleures expériences client et une innovation produit.

Les clients d'Alida reçoivent des dizaines de milliers de réponses engagées pour une seule enquête. L'équipe d'Alida a donc choisi de tirer parti de l'apprentissage automatique (ML) pour servir ses clients à grande échelle. Cependant, lorsqu’ils ont eu recours à des modèles traditionnels de traitement du langage naturel (NLP), ils ont constaté que ces solutions avaient du mal à comprendre pleinement les commentaires nuancés trouvés dans les réponses aux enquêtes ouvertes. Les modèles ne captaient souvent que des sujets et des sentiments superficiels, et manquaient un contexte crucial qui permettrait d'obtenir des informations plus précises et plus significatives.

Dans cet article, nous apprenons comment le modèle Claude Instant d'Anthropic sur Socle amazonien a permis à l'équipe d'Alida de créer rapidement un service évolutif qui détermine plus précisément le sujet et le sentiment dans les réponses à des enquêtes complexes. Le nouveau service a obtenu une amélioration de 4 à 6 fois de l'assertion de sujet en regroupant étroitement plusieurs dizaines de sujets clés par rapport à des centaines de mots-clés PNL bruyants.

Amazon Bedrock est un service entièrement géré qui offre un choix de modèles de base (FM) hautes performances provenant de grandes sociétés d'IA, telles que AI21 Labs, Anthropic, Cohere, Meta, Stability AI et Amazon via une API unique, ainsi qu'un large éventail de fonctionnalités. ensemble de fonctionnalités dont vous avez besoin pour créer des applications d'IA générative avec sécurité, confidentialité et IA responsable.

L'utilisation d'Amazon Bedrock a permis à Alida de commercialiser son service plus rapidement que si elle avait fait appel à d'autres fournisseurs ou fournisseurs d'apprentissage automatique (ML).

Le défi

Les enquêtes combinant des questions à choix multiples et des questions ouvertes permettent aux chercheurs de marché d'avoir une vision plus globale en capturant des points de données à la fois quantitatifs et qualitatifs.

Les questions à choix multiples sont faciles à analyser à grande échelle, mais manquent de nuances et de profondeur. Définir les options de réponse peut également conduire à biaiser ou à amorcer les réponses des participants.

Les questions ouvertes de l'enquête permettent aux répondants de fournir un contexte et des commentaires imprévus. Ces données qualitatives approfondissent la compréhension des chercheurs au-delà de ce que les questions à choix multiples peuvent à elles seules saisir. Le défi du texte de forme libre est qu’il peut conduire à des réponses complexes et nuancées qui sont difficiles à comprendre pleinement par la PNL traditionnelle. Par exemple:

« J'ai récemment vécu certaines difficultés de la vie et j'étais vraiment déprimé et déçu. Quand je suis entré, le personnel était toujours très gentil avec moi. Cela m'a aidée à traverser des moments difficiles !

Les méthodes traditionnelles de PNL identifieront les sujets comme « difficultés », « déçu », « personnel aimable » et « traverser des moments difficiles ». Il ne peut pas faire la distinction entre les expériences de vie globales négatives actuelles du répondant et les expériences positives spécifiques en magasin.

La solution existante d'Alida traite automatiquement de grands volumes de réponses ouvertes, mais l'entreprise souhaitait que ses clients bénéficient d'une meilleure compréhension contextuelle et d'une inférence thématique de haut niveau.

Socle amazonien

Avant l'introduction des LLM, la voie à suivre pour qu'Alida améliore sa solution de modèle unique existante consistait à travailler en étroite collaboration avec des experts du secteur et à développer, former et affiner de nouveaux modèles spécifiquement pour chacun des secteurs verticaux dans lesquels les clients d'Alida opéraient. Il s’agissait d’une entreprise à la fois longue et coûteuse.

L’une des avancées qui rendent les LLM si puissants est l’utilisation de mécanismes d’attention. Les LLM utilisent des mécanismes d'auto-attention qui analysent les relations entre les mots dans une invite donnée. Cela permet aux LLM de mieux gérer le sujet et le sentiment de l'exemple précédent et présente une nouvelle technologie passionnante qui peut être utilisée pour relever le défi.

Avec Amazon Bedrock, les équipes et les individus peuvent immédiatement commencer à utiliser des modèles de base sans avoir à se soucier du provisionnement de l'infrastructure ou de l'installation et de la configuration des frameworks ML. Vous pouvez commencer en suivant les étapes suivantes :

- Vérifiez que votre utilisateur ou votre rôle est autorisé à créer ou à modifier des ressources Amazon Bedrock. Pour plus de détails, voir Exemples de politiques basées sur l'identité pour Amazon Bedrock

- Connectez-vous à Socle amazonien console.

- Sur le Accès au modèle page, consultez le CLUF et activez les FM que vous souhaitez dans votre compte.

- Commencez à interagir avec les FM via les méthodes suivantes :

L'équipe de direction d'Alida était impatiente d'être l'un des premiers à adopter Amazon Bedrock, car elle reconnaissait sa capacité à aider ses équipes à commercialiser plus rapidement de nouvelles solutions génératives basées sur l'IA.

Vincy William, directeur principal de l'ingénierie chez Alida qui dirige l'équipe responsable de la création du service d'analyse des sujets et des sentiments, déclare :

«Les LLM constituent un grand pas en avant dans l'analyse qualitative et permettent de réaliser des choses (à une échelle qui sont) humainement impossibles à faire. Amazon Bedrock change la donne, il nous permet de tirer parti des LLM sans la complexité.

L'équipe d'ingénierie a constaté la facilité immédiate de démarrage avec Amazon Bedrock. Ils pourraient choisir parmi différents modèles de base et commencer à se concentrer sur une ingénierie rapide au lieu de consacrer du temps au dimensionnement, au provisionnement, au déploiement et à la configuration des ressources pour exécuter les modèles.

Vue d'ensemble de la solution

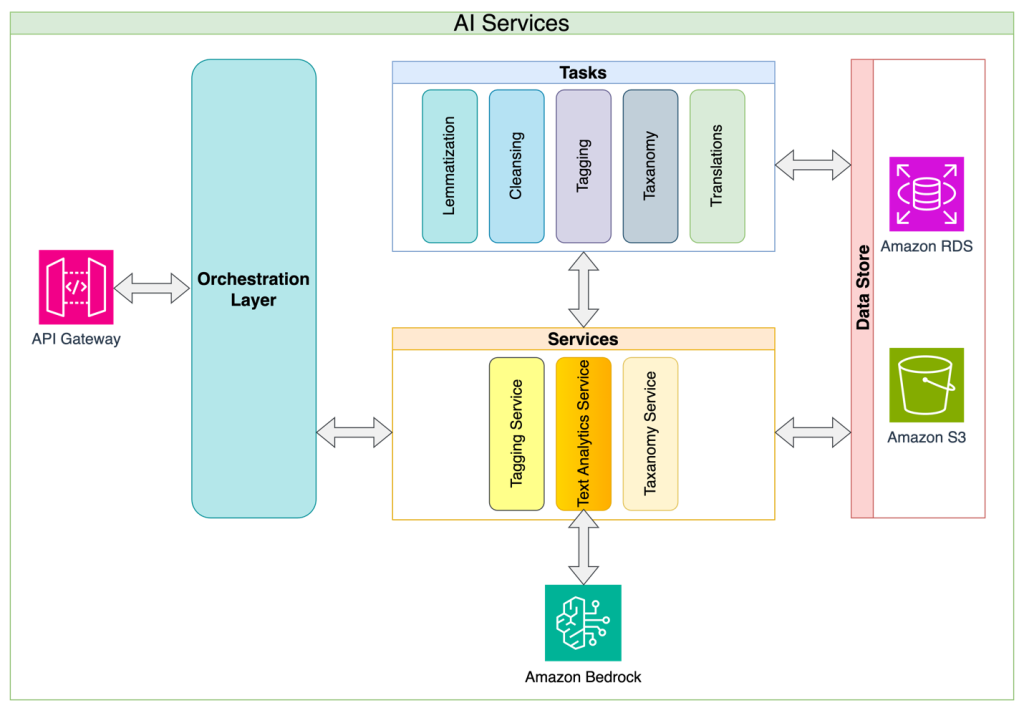

Sherwin Chu, architecte en chef d'Alida, a partagé l'approche architecturale des microservices d'Alida. Alida a construit la classification des sujets et des sentiments en tant que service avec l'analyse des réponses à l'enquête comme première application. Grâce à cette approche, les défis courants de mise en œuvre du LLM, tels que la complexité de la gestion des invites, des limites de jetons, des contraintes de requête et des nouvelles tentatives, sont éliminés, et la solution permet aux applications consommatrices de disposer d'une API simple et stable avec laquelle travailler. Cette approche de couche d'abstraction permet également aux propriétaires de services d'améliorer continuellement les détails de mise en œuvre interne et de minimiser les modifications pouvant interrompre l'API. Enfin, l’approche de service permet de mettre en œuvre à partir d’un point unique toutes les politiques de gouvernance et de sécurité des données qui évoluent à mesure que la gouvernance de l’IA évolue au sein de l’organisation.

Le diagramme suivant illustre l’architecture et le flux de la solution.

Alida a évalué les LLM de divers fournisseurs et a trouvé que Claude Instant d'Anthropic représentait le bon équilibre entre coût et performance. Travaillant en étroite collaboration avec l'équipe d'ingénierie rapide, Chu a préconisé la mise en œuvre d'une stratégie de chaînage rapide plutôt qu'une approche rapide monolithique.

Le chaînage d'invites vous permet d'effectuer les opérations suivantes :

- Décomposez votre objectif en étapes plus petites et logiques

- Créez une invite pour chaque étape

- Fournissez les invites de manière séquentielle au LLM

Cela crée des points d'inspection supplémentaires, ce qui présente les avantages suivants :

- Il est simple d'évaluer systématiquement les modifications que vous apportez à l'invite de saisie

- Vous pouvez mettre en œuvre un suivi et une surveillance plus détaillés de la précision et des performances à chaque étape

Les considérations clés de cette stratégie incluent l'augmentation du nombre de demandes adressées au LLM et l'augmentation qui en résulte du temps global nécessaire pour atteindre l'objectif. Pour le cas d'utilisation d'Alida, ils ont choisi de regrouper une collection de réponses ouvertes dans une seule invite du LLM pour compenser ces effets.

PNL vs LLM

La solution PNL existante d'Alida s'appuie sur des algorithmes de clustering et une classification statistique pour analyser les réponses à des enquêtes ouvertes. Lorsqu'il a été appliqué à des exemples de commentaires pour l'application mobile d'un café, il a extrait des sujets basés sur des modèles de mots, mais manquait d'une véritable compréhension. Le tableau suivant comprend quelques exemples comparant les réponses PNL aux réponses LLM.

| Réponse à l'enquête | PNL traditionnelle existante | Fond rocheux amazonien avec Claude Instant | |

| Sujet | Sujet | Sentiment | |

| Je commande presque exclusivement mes boissons via l'application car c'est pratique et c'est moins gênant de commander des boissons super personnalisées mdr. Et j'adore gagner des récompenses ! | ['app bc commodité', 'boisson', 'récompense'] | Commodité de commande mobile | positif |

| L'application fonctionne plutôt bien, le seul reproche que j'ai à faire est que je ne peux pas ajouter le montant que je souhaite à ma carte-cadeau. Pourquoi faut-il spécifiquement que le rechargement coûte 10 $ ? | ['plainte', 'application', 'carte-cadeau', 'argent numérique'] | Vitesse d'exécution des commandes mobiles | négatif |

Les exemples de résultats montrent comment la solution existante a pu extraire des mots-clés pertinents, mais n'est pas en mesure de réaliser une attribution de groupe de sujets plus généralisée.

En revanche, en utilisant Amazon Bedrock et Anthropic Claude Instant, le LLM avec formation en contexte est capable d'attribuer les réponses à des sujets prédéfinis et d'attribuer des sentiments.

En plus de fournir de meilleures réponses aux clients d'Alida, pour ce cas d'utilisation particulier, la recherche d'une solution utilisant un LLM plutôt que les méthodes traditionnelles de PNL a permis d'économiser beaucoup de temps et d'efforts dans la formation et la maintenance d'un modèle approprié. Le tableau suivant compare la formation d'un modèle PNL traditionnel à la formation en contexte d'un LLM.

| . | Exigence de données | Processus de formation | Adaptabilité du modèle |

| Formation d'un modèle PNL traditionnel | Des milliers d'exemples étiquetés par des humains |

Combinaison d'ingénierie de fonctionnalités automatisée et manuelle. Cycles itératifs de formation et d’évaluation. |

Délai d’exécution plus lent en raison de la nécessité de recycler le modèle |

| Formation en contexte de LLM | Plusieurs exemples |

Formé à la volée dans l'invite. Limité par la taille de la fenêtre contextuelle. |

Itérations plus rapides en modifiant l'invite. Rétention limitée en raison de la taille de la fenêtre contextuelle. |

Conclusion

L'utilisation par Alida du modèle Claude Instant d'Anthropic sur Amazon Bedrock démontre les puissantes capacités des LLM pour analyser les réponses aux enquêtes ouvertes. Alida a pu créer un service de qualité supérieure, 4 à 6 fois plus précis en termes d'analyse de sujet que son service basé sur la PNL. De plus, l'utilisation de l'ingénierie contextuelle pour les LLM a considérablement réduit le temps de développement, car ils n'ont pas eu besoin de gérer des milliers de points de données étiquetés par l'homme pour entraîner un modèle NLP traditionnel. Cela permet finalement à Alida de fournir plus rapidement à ses clients des informations plus riches !

Si vous êtes prêt à commencer à créer votre propre innovation de modèle de base avec Amazon Bedrock, consultez ce lien vers Configurer Amazon Bedrock. Si vous souhaitez en savoir plus sur d'autres applications Amazon Bedrock intrigantes, consultez la section spécifique à Amazon Bedrock du blog AWS Machine Learning.

À propos des auteurs

Kinman Lam est un architecte de solutions ISV/DNB pour AWS. Il possède 17 ans d'expérience dans la création et la croissance d'entreprises technologiques dans le domaine des smartphones, de la géolocalisation, de l'IoT et des logiciels open source. Chez AWS, il utilise son expérience pour aider les entreprises à construire une infrastructure robuste afin de répondre aux demandes croissantes des entreprises en croissance, de lancer de nouveaux produits et services, de pénétrer de nouveaux marchés et de ravir leurs clients.

Kinman Lam est un architecte de solutions ISV/DNB pour AWS. Il possède 17 ans d'expérience dans la création et la croissance d'entreprises technologiques dans le domaine des smartphones, de la géolocalisation, de l'IoT et des logiciels open source. Chez AWS, il utilise son expérience pour aider les entreprises à construire une infrastructure robuste afin de répondre aux demandes croissantes des entreprises en croissance, de lancer de nouveaux produits et services, de pénétrer de nouveaux marchés et de ravir leurs clients.

Sherwin Chu est l'architecte en chef chez Alida, aidant les équipes de produits dans la direction architecturale, le choix technologique et la résolution de problèmes complexes. Il est un ingénieur logiciel, un architecte et un leader expérimenté avec plus de 20 ans d'expérience dans le domaine SaaS pour diverses industries. Il a construit et géré de nombreux systèmes B2B et B2C sur AWS et GCP.

Sherwin Chu est l'architecte en chef chez Alida, aidant les équipes de produits dans la direction architecturale, le choix technologique et la résolution de problèmes complexes. Il est un ingénieur logiciel, un architecte et un leader expérimenté avec plus de 20 ans d'expérience dans le domaine SaaS pour diverses industries. Il a construit et géré de nombreux systèmes B2B et B2C sur AWS et GCP.

Marc Roy est un architecte principal d'apprentissage automatique pour AWS, aidant les clients à concevoir et à créer des solutions d'IA/ML et d'IA générative. Depuis début 2023, il s'est concentré sur la direction des efforts d'architecture de solutions pour le lancement d'Amazon Bedrock, l'offre phare d'IA générative d'AWS destinée aux constructeurs. Le travail de Mark couvre un large éventail de cas d'utilisation, avec un intérêt principal pour l'IA générative, les agents et la mise à l'échelle du ML dans l'ensemble de l'entreprise. Il a aidé des entreprises dans les domaines de l'assurance, des services financiers, des médias et du divertissement, de la santé, des services publics et de l'industrie manufacturière. Avant de rejoindre AWS, Mark a été architecte, développeur et leader technologique pendant plus de 25 ans, dont 19 ans dans les services financiers. Mark détient six certifications AWS, dont la certification ML Specialty.

Marc Roy est un architecte principal d'apprentissage automatique pour AWS, aidant les clients à concevoir et à créer des solutions d'IA/ML et d'IA générative. Depuis début 2023, il s'est concentré sur la direction des efforts d'architecture de solutions pour le lancement d'Amazon Bedrock, l'offre phare d'IA générative d'AWS destinée aux constructeurs. Le travail de Mark couvre un large éventail de cas d'utilisation, avec un intérêt principal pour l'IA générative, les agents et la mise à l'échelle du ML dans l'ensemble de l'entreprise. Il a aidé des entreprises dans les domaines de l'assurance, des services financiers, des médias et du divertissement, de la santé, des services publics et de l'industrie manufacturière. Avant de rejoindre AWS, Mark a été architecte, développeur et leader technologique pendant plus de 25 ans, dont 19 ans dans les services financiers. Mark détient six certifications AWS, dont la certification ML Specialty.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/alida-gains-deeper-understanding-of-customer-feedback-with-amazon-bedrock/