Les applications d'intelligence artificielle (IA) générative construites autour de grands modèles de langage (LLM) ont démontré leur potentiel de création et d'accélération de la valeur économique pour les entreprises. Des exemples d'applications incluent recherche conversationnelle, assistance d'un agent de support client, analyses du support client, assistants virtuels en libre-service, Chatbots, génération de médias riches, modération du contenu, des compagnons de codage pour accélérer le développement de logiciels sécurisés et performants, des informations plus approfondies à partir de sources de contenu multimodales, accélération des enquêtes de sécurité et des mesures d'atténuation de votre organisation, et beaucoup plus. De nombreux clients recherchent des conseils sur la manière de gérer la sécurité, la confidentialité et la conformité lorsqu'ils développent des applications d'IA générative. Comprendre et traiter les vulnérabilités, les menaces et les risques du LLM pendant les phases de conception et d'architecture aide les équipes à se concentrer sur la maximisation des avantages économiques et de productivité que l'IA générative peut apporter. Être conscient des risques favorise la transparence et la confiance dans les applications d'IA générative, encourage une observabilité accrue, aide à répondre aux exigences de conformité et facilite la prise de décision éclairée par les dirigeants.

L'objectif de cet article est de permettre aux ingénieurs d'IA et d'apprentissage automatique (ML), aux scientifiques des données, aux architectes de solutions, aux équipes de sécurité et aux autres parties prenantes de disposer d'un modèle et d'un cadre mentaux communs pour appliquer les meilleures pratiques de sécurité, permettant ainsi aux équipes d'IA/ML d'évoluer. rapide sans sacrifier la sécurité pour la vitesse. Plus précisément, cet article vise à aider les scientifiques de l'IA/ML et des données qui n'ont peut-être pas été exposés auparavant aux principes de sécurité à comprendre les meilleures pratiques de base en matière de sécurité et de confidentialité dans le contexte du développement d'applications d'IA génératives à l'aide de LLM. Nous discutons également des problèmes de sécurité courants qui peuvent miner la confiance dans l'IA, tels qu'identifiés par le Open Worldwide Application Security Project (OWASP) Top 10 pour les applications LLM, et montrez comment vous pouvez utiliser AWS pour améliorer votre posture de sécurité et votre confiance tout en innovant avec l'IA générative.

Cet article propose trois étapes guidées pour concevoir des stratégies de gestion des risques tout en développant des applications d'IA générative à l'aide de LLM. Nous examinons d'abord les vulnérabilités, les menaces et les risques liés à la mise en œuvre, au déploiement et à l'utilisation de solutions LLM, et fournissons des conseils sur la façon de commencer à innover en gardant la sécurité à l'esprit. Nous discutons ensuite de la manière dont il est essentiel de s’appuyer sur une base sécurisée pour l’IA générative. Enfin, nous les connectons avec un exemple de charge de travail LLM pour décrire une approche d'architecture avec une sécurité de défense en profondeur au-delà des limites de confiance.

À la fin de cet article, Les ingénieurs IA/ML, les data scientists et les technologues soucieux de la sécurité seront en mesure d'identifier des stratégies pour concevoir des défenses en couches pour leurs applications d'IA générative, comprendre comment mapper le Top 10 OWASP pour les problèmes de sécurité des LLM à certains contrôles correspondants et acquérir des connaissances fondamentales pour répondre aux principaux thèmes de questions des clients AWS suivants pour leurs applications :

- Quels sont les risques courants en matière de sécurité et de confidentialité liés à l’utilisation de l’IA générative basée sur les LLM dans mes applications sur lesquels je peux avoir le plus d’impact grâce à ces conseils ?

- Quels sont les moyens de mettre en œuvre des contrôles de sécurité et de confidentialité dans le cycle de vie de développement des applications génératives AI LLM sur AWS ?

- Quelles bonnes pratiques opérationnelles et techniques puis-je intégrer dans la manière dont mon organisation crée des applications LLM d'IA générative pour gérer les risques et accroître la confiance dans les applications d'IA générative utilisant les LLM ?

Améliorer les résultats en matière de sécurité tout en développant l’IA générative

L'innovation avec l'IA générative utilisant les LLM nécessite de commencer par avoir la sécurité à l'esprit pour développer la résilience organisationnelle, s'appuyer sur une base sécurisée et intégrer la sécurité avec une approche de sécurité de défense en profondeur. La sécurité est un responsabilité partagée entre AWS et les clients AWS. Tous les principes du modèle de responsabilité partagée AWS sont applicables aux solutions d'IA générative. Actualisez votre compréhension du modèle de responsabilité partagée AWS tel qu'il s'applique à l'infrastructure, aux services et aux données lorsque vous créez des solutions LLM.

Commencez par penser à la sécurité pour développer la résilience organisationnelle

Commencez par garder la sécurité à l’esprit pour développer la résilience organisationnelle afin de développer des applications d’IA générative qui répondent à vos objectifs de sécurité et de conformité. La résilience organisationnelle s’appuie sur et étend définition de la résilience dans le cadre AWS Well-Architected pour inclure et préparer la capacité d’une organisation à se remettre des perturbations. Tenez compte de votre posture de sécurité, de votre gouvernance et de votre excellence opérationnelle lorsque vous évaluez votre état de préparation globale à développer une IA générative avec des LLM, ainsi que la résilience de votre organisation à tout impact potentiel. À mesure que votre organisation progresse dans l’utilisation des technologies émergentes telles que l’IA générative et les LLM, la résilience organisationnelle globale doit être considérée comme la pierre angulaire d’une stratégie défensive à plusieurs niveaux visant à protéger les actifs et les secteurs d’activité des conséquences imprévues.

La résilience organisationnelle est essentielle pour les candidatures LLM

Même si tous les programmes de gestion des risques peuvent bénéficier de la résilience, la résilience organisationnelle est essentielle pour l’IA générative. Cinq des 10 principaux risques identifiés par l'OWASP pour les applications LLM reposent sur la définition de contrôles architecturaux et opérationnels et sur leur application à l'échelle organisationnelle afin de gérer les risques. Ces cinq risques sont la gestion non sécurisée des produits, les vulnérabilités de la chaîne d'approvisionnement, la divulgation d'informations sensibles, l'agence excessive et la dépendance excessive. Commencez à accroître la résilience organisationnelle en socialisant vos équipes pour qu'elles considèrent la sécurité de l'IA, du ML et de l'IA générative comme une exigence commerciale essentielle et une priorité absolue tout au long du cycle de vie du produit, de la conception de l'idée à la recherche, en passant par le développement, le déploiement et l'application de l'application. utiliser. En plus de la sensibilisation, vos équipes doivent prendre des mesures pour prendre en compte l'IA générative dans les pratiques de gouvernance, d'assurance et de validation de la conformité.

Développer la résilience organisationnelle autour de l’IA générative

Les organisations peuvent commencer à adopter des moyens de renforcer leurs capacités et capacités en matière de sécurité de l’IA/ML et de l’IA générative au sein de leur organisation. Vous devez commencer par étendre vos programmes de sécurité, d’assurance, de conformité et de développement existants pour tenir compte de l’IA générative.

Voici les cinq domaines d’intérêt clés pour la sécurité de l’IA organisationnelle, du ML et de l’IA générative :

- Comprendre le paysage de la sécurité IA/ML

- Inclure diverses perspectives dans les stratégies de sécurité

- Agir de manière proactive pour sécuriser les activités de recherche et développement

- Aligner les incitations sur les résultats organisationnels

- Préparez-vous à des scénarios de sécurité réalistes dans l’IA/ML et l’IA générative

Développez un modèle de menace tout au long de votre cycle de vie d’IA générative

Les organisations qui construisent avec l’IA générative devraient se concentrer sur la gestion des risques, et non sur leur élimination, et inclure modélisation des menaces dans et planification de la continuité des activités la planification, le développement et l’exploitation de charges de travail d’IA générative. Travaillez en arrière depuis l'utilisation en production de l'IA générative en développant un modèle de menace pour chaque application en utilisant les risques de sécurité traditionnels ainsi que les risques spécifiques à l'IA générative. Certains risques peuvent être acceptables pour votre entreprise, et un exercice de modélisation des menaces peut aider votre entreprise à identifier votre appétit pour le risque acceptable. Par exemple, votre entreprise n'exigera peut-être pas une disponibilité de 99.999 % sur une application d'IA générative, donc le temps de récupération supplémentaire associé à la récupération à l'aide de Sauvegarde AWS comprenant Glacier Amazon S3 peut être un risque acceptable. À l’inverse, les données de votre modèle peuvent être extrêmement sensibles et hautement réglementées. Service de gestion des clés AWS (KMS AWS) clé gérée par le client (CMK) rotation et utilisation de Pare-feu réseau AWS Contribuer à appliquer la sécurité de la couche de transport (TLS) pour le trafic d'entrée et de sortie afin de se protéger contre l'exfiltration de données peut constituer un risque inacceptable.

Évaluez les risques (inhérents ou résiduels) liés à l'utilisation de l'application d'IA générative dans un environnement de production pour identifier les bons contrôles fondamentaux et au niveau de l'application. Planifiez la restauration et la récupération suite aux événements de sécurité de production et aux interruptions de service, telles que l'injection rapide, l'empoisonnement des données de formation, le déni de service du modèle et le vol de modèle, et définissez dès le début les mesures d'atténuation que vous utiliserez lors de la définition des exigences de l'application. Connaître les risques et les contrôles qui doivent être mis en place aidera à définir la meilleure approche de mise en œuvre pour créer une application d'IA générative et fournira aux parties prenantes et aux décideurs des informations pour prendre des décisions commerciales éclairées sur les risques. Si vous n'êtes pas familier avec le flux de travail global de l'IA et du ML, commencez par examiner 7 façons d'améliorer la sécurité de vos charges de travail d'apprentissage automatique pour accroître la familiarité avec les contrôles de sécurité nécessaires aux systèmes AI/ML traditionnels.

Tout comme la création de n’importe quelle application ML, la création d’une application d’IA générative implique de passer par un ensemble d’étapes du cycle de vie de recherche et développement. Vous voudrez peut-être revoir le Matrice de portée de la sécurité de l'IA générative AWS pour aider à construire un modèle mental permettant de comprendre les disciplines de sécurité clés que vous devez prendre en compte en fonction de la solution d'IA générative que vous sélectionnez.

Les applications d'IA générative utilisant des LLM sont généralement développées et exploitées selon des étapes ordonnées :

- Conditions d'application – Identifier les objectifs commerciaux, les exigences et les critères de réussite des cas d’utilisation

- Sélection du modèle – Sélectionnez un modèle de base qui correspond aux exigences du cas d’utilisation

- Adaptation et mise au point du modèle – Préparer les données, les invites de l’ingénieur et affiner le modèle

- Évaluation du modèle – Évaluer les modèles de fondation avec des métriques spécifiques au cas d’utilisation et sélectionner le modèle le plus performant

- Déploiement et intégration – Déployez le modèle de base sélectionné sur votre infrastructure optimisée et intégrez-le à votre application d’IA générative

- Surveillance de l'application – Surveiller les performances des applications et des modèles pour permettre l’analyse des causes profondes

Assurez-vous que les équipes comprennent la nature critique de la sécurité dans le cadre des phases de conception et d'architecture du cycle de vie de développement de vos logiciels dès le premier jour. Cela signifie discuter de la sécurité à chaque couche de votre pile et de votre cycle de vie, et positionner la sécurité et la confidentialité comme des outils permettant d'atteindre les objectifs commerciaux. Concevez des contrôles contre les menaces avant de lancer votre application LLM et déterminez si les données et les informations que vous utiliserez pour l'adaptation et le réglage du modèle justifient la mise en œuvre de contrôles dans les environnements de recherche, de développement et de formation. Dans le cadre des tests d'assurance qualité, introduisez des menaces de sécurité synthétiques (telles que la tentative d'empoisonnement des données de formation ou la tentative d'extraction de données sensibles via une ingénierie d'invite malveillante) pour tester régulièrement vos défenses et votre posture de sécurité.

De plus, les parties prenantes doivent établir une cadence d'examen cohérente pour les charges de travail d'IA de production, de ML et d'IA générative et définir la priorité organisationnelle sur la compréhension des compromis entre le contrôle humain et machine et les erreurs avant le lancement. Valider et garantir que ces compromis sont respectés dans les applications LLM déployées augmentera la probabilité de réussite de l’atténuation des risques.

Créez des applications d'IA génératives sur des bases cloud sécurisées

Chez AWS, la sécurité est notre priorité absolue. AWS est conçu pour être l'infrastructure cloud mondiale la plus sécurisée sur laquelle créer, migrer et gérer des applications et des charges de travail. Ceci s'appuie sur notre ensemble complet de plus de 300 outils de sécurité cloud et sur la confiance de nos millions de clients, y compris les organisations les plus sensibles à la sécurité comme le gouvernement, les soins de santé et les services financiers. Lorsque vous créez des applications d'IA générative à l'aide de LLM sur AWS, vous bénéficiez des avantages en matière de sécurité grâce à environnement informatique cloud AWS sécurisé, fiable et flexible.

Utilisez une infrastructure mondiale AWS pour la sécurité, la confidentialité et la conformité

Lorsque vous développez des applications gourmandes en données sur AWS, vous pouvez bénéficier d'une infrastructure régionale AWS mondiale, conçue pour fournir des fonctionnalités permettant de répondre à vos principales exigences de sécurité et de conformité. Ceci est renforcé par notre Engagement de souveraineté numérique AWS, notre engagement à vous offrir l'ensemble de contrôles et de fonctionnalités de souveraineté le plus avancé disponible dans le cloud. Nous nous engageons à étendre nos capacités pour vous permettre de répondre à vos souveraineté numérique besoins, sans compromettre les performances, l'innovation, la sécurité ou l'évolutivité du cloud AWS. Pour simplifier la mise en œuvre des meilleures pratiques en matière de sécurité et de confidentialité, envisagez d'utiliser des conceptions et des infrastructures de référence comme ressources de code telles que le Architecture de référence de sécurité AWS (AWS SRA) et par Architecture de référence de confidentialité AWS (AWS PRA). En savoir plus sur concevoir des solutions de confidentialité, la souveraineté dès la conceptionet conformité sur AWS et utiliser des services tels que Configuration AWS, Artefact AWSet Gestionnaire d'audit AWS pour répondre à vos besoins en matière de confidentialité, de conformité, d’audit et d’observabilité.

Comprendre votre posture de sécurité à l'aide des frameworks AWS Well-Architected et Cloud Adoption

AWS propose des conseils sur les meilleures pratiques développés à partir d'années d'expérience dans l'accompagnement des clients dans l'architecture de leurs environnements cloud avec le Framework AWS Well-Architected et en évoluant pour tirer la valeur commerciale des technologies cloud avec le Cadre d'adoption du cloud AWS (AWS CAF). Comprenez l'état de sécurité de vos charges de travail d'IA, de ML et d'IA générative en effectuant un examen du cadre bien architecturé. Les examens peuvent être effectués à l'aide d'outils tels que Outil AWS bien architecturé, ou avec l'aide de votre équipe AWS via Prise en charge des entreprises AWS. L'outil AWS bien architecturé intègre automatiquement les informations de Conseiller de confiance AWS pour évaluer quelles sont les meilleures pratiques en place et quelles opportunités existent pour améliorer la fonctionnalité et l'optimisation des coûts. L'outil AWS Well-Architected propose également des objectifs personnalisés avec les meilleures pratiques spécifiques telles que Lentille d'apprentissage automatique pour vous permettre de mesurer régulièrement vos architectures par rapport aux meilleures pratiques et d'identifier les domaines à améliorer. Vérifiez votre parcours sur la voie de la réalisation de valeur et de la maturité du cloud en comprenant comment les clients AWS adoptent des stratégies pour développer les capacités organisationnelles dans le domaine. Cadre d'adoption du cloud AWS pour l'intelligence artificielle, l'apprentissage automatique et l'IA générative. Vous pourriez également avoir intérêt à comprendre votre préparation globale au cloud en participant à un Évaluation de l'état de préparation du cloud AWS. AWS offre des opportunités d'engagement supplémentaires : demandez à votre équipe de compte AWS pour plus d'informations sur la façon de démarrer avec le Centre d'innovation en IA générative.

Accélérez votre apprentissage en matière de sécurité et d'IA/ML grâce à des conseils, des formations et des certifications sur les meilleures pratiques.

AWS organise également les recommandations de Meilleures pratiques en matière de sécurité, d'identité et de conformité ainsi que Documentation de sécurité AWS pour vous aider à identifier les moyens de sécuriser vos environnements de formation, de développement, de test et opérationnels. Si vous débutez, approfondissez la formation et la certification en matière de sécurité, envisagez de commencer par Principes fondamentaux de la sécurité AWS et par Plan de formation sur la sécurité AWS. Vous pouvez également utiliser le Modèle de maturité de sécurité AWS pour vous aider à trouver et à prioriser les meilleures activités à différentes phases de maturité sur AWS, en commençant par des gains rapides, en passant par les étapes fondamentales, efficaces et optimisées. Une fois que vous et vos équipes avez acquis une compréhension de base de la sécurité sur AWS, nous vous recommandons fortement de consulter Comment aborder la modélisation des menaces puis mener un exercice de modélisation des menaces avec vos équipes en commençant par Atelier de modélisation des menaces pour les constructeurs programme de formation. Il y en a bien d'autres Ressources de formation et de certification sur la sécurité AWS disponible.

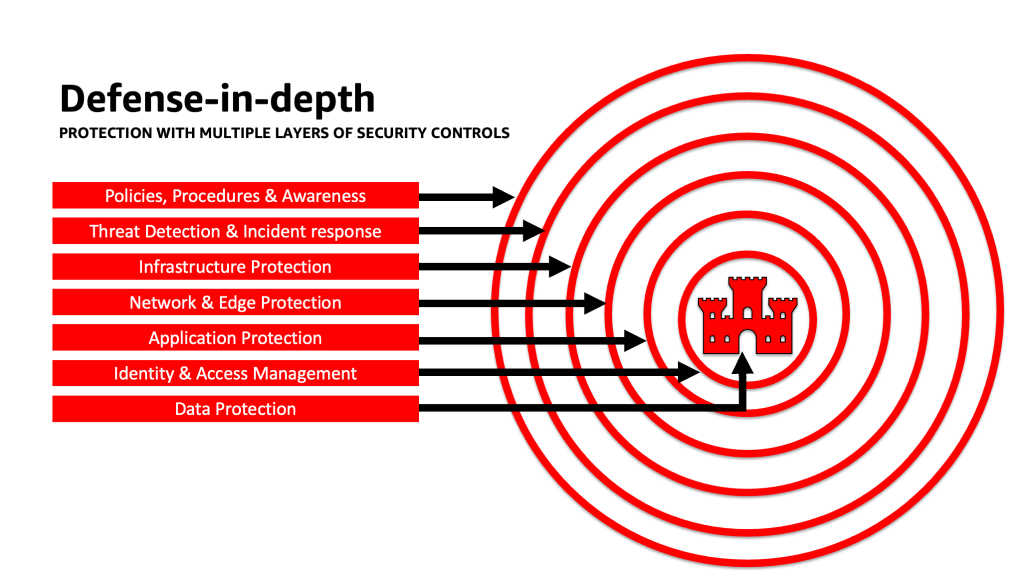

Appliquer une approche de défense en profondeur pour sécuriser les applications LLM

L’application d’une approche de sécurité de défense en profondeur à vos charges de travail, données et informations d’IA générative peut vous aider à créer les meilleures conditions pour atteindre vos objectifs commerciaux. Les meilleures pratiques de sécurité en matière de défense en profondeur atténuent bon nombre des risques courants auxquels toute charge de travail est confrontée, vous aidant ainsi, vous et vos équipes, à accélérer votre innovation en matière d'IA générative. Une stratégie de sécurité de défense en profondeur utilise plusieurs défenses redondantes pour protéger vos comptes, charges de travail, données et actifs AWS. Il permet de garantir que si un contrôle de sécurité est compromis ou échoue, des couches supplémentaires existent pour aider à isoler les menaces et à prévenir, détecter, répondre et récupérer des événements de sécurité. Vous pouvez utiliser une combinaison de stratégies, notamment les services et solutions AWS, à chaque couche pour améliorer la sécurité et la résilience de vos charges de travail d'IA générative.

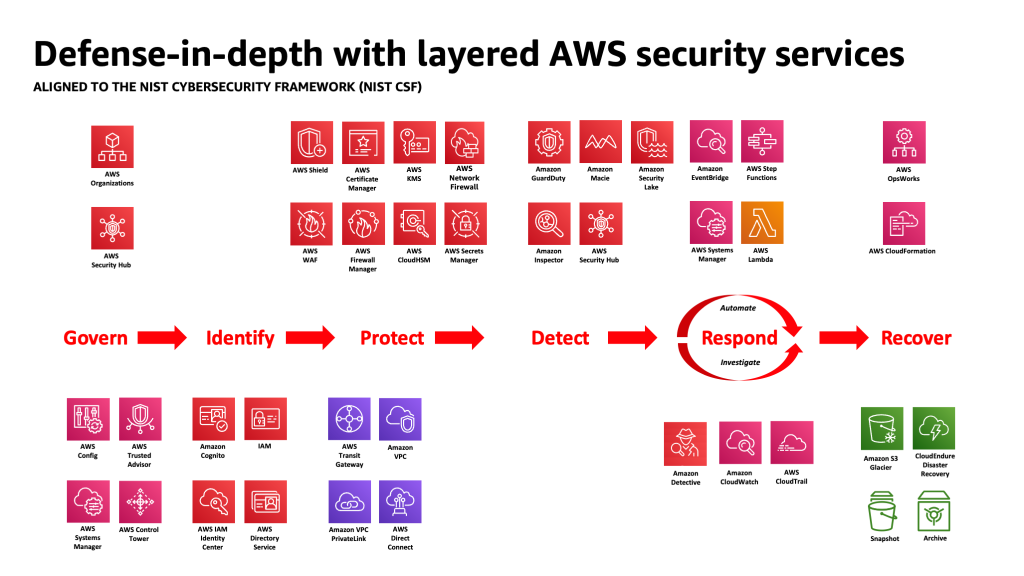

De nombreux clients AWS s'alignent sur les cadres standards de l'industrie, tels que le Cadre de cybersécurité du NIST. Ce cadre permet de garantir que vos défenses de sécurité bénéficient d'une protection sur les piliers Identifier, Protéger, Détecter, Répondre, Récupérer et, plus récemment, Gouverner. Ce cadre peut ensuite facilement être mappé aux services de sécurité AWS et à ceux de tiers intégrés pour vous aider à valider une couverture et des politiques adéquates pour tout événement de sécurité rencontré par votre organisation.

Défense en profondeur : sécurisez votre environnement, puis ajoutez des fonctionnalités améliorées de sécurité et de confidentialité spécifiques à l'IA/ML

Une stratégie de défense en profondeur doit commencer par protéger vos comptes et votre organisation, puis s'appuyer sur les fonctionnalités supplémentaires intégrées de sécurité et de confidentialité améliorées de services tels que Socle amazonien ainsi que Amazon Sage Maker. Amazon propose plus de 30 services dans le portefeuille de sécurité, d'identité et de conformité qui sont intégrés aux services AWS AI/ML et peuvent être utilisés ensemble pour vous aider à sécuriser vos charges de travail, vos comptes et votre organisation. Pour se défendre correctement contre le Top 10 OWASP pour LLM, ceux-ci doivent être utilisés avec les services AWS AI/ML.

Commencez par mettre en œuvre une politique du moindre privilège, en utilisant des services comme Analyseur d'accès IAM à recherchez des comptes, des rôles et des ressources trop permissifs pour restreindre l'accès à l'aide d'informations d'identification à court terme. Ensuite, assurez-vous que toutes les données au repos sont chiffrées avec AWS KMS, y compris en tenant compte de l'utilisation de CMK, et que toutes les données et tous les modèles sont versionnés et sauvegardés à l'aide de Service de stockage simple Amazon (Amazon S3) gestion des versions et application de l'immuabilité au niveau de l'objet avec Verrouillage d'objet Amazon S3. Protégez toutes les données en transit entre les services en utilisant Gestionnaire de certificats AWS (facultatif) Autorité de certification privée AWS, et conservez-le dans les VPC en utilisant Lien privé AWS. Définissez des règles strictes d'entrée et de sortie de données pour vous protéger contre la manipulation et l'exfiltration à l'aide de VPC avec Pare-feu réseau AWS Stratégies. Pensez à insérer Pare-feu d'applications Web AWS (AWS WAF) devant protéger les applications Web et les API de robots malveillants, Attaques par injection SQL, cross-site scripting (XSS), et rachats de comptes avec Contrôle de la fraude. Connexion avec AWS CloudTrail, Cloud privé virtuel Amazon (Amazon VPC), les journaux de flux, et Service Amazon Elastic Kubernetes (Amazon EKS) les journaux d'audit aideront à fournir un examen médico-légal de chaque transaction disponible pour des services tels que Détective d'Amazon. Vous pouvez utiliser Inspecteur Amazon pour automatiser la découverte et la gestion des vulnérabilités pour Cloud de calcul élastique Amazon (Amazon EC2), les instances, les conteneurs, AWS Lambda fonctions, et identifier l'accessibilité réseau de vos charges de travail. Protégez vos données et modèles contre les activités suspectes en utilisant Service de garde AmazonLes modèles de menaces et les flux de renseignements basés sur le ML, et l'activation de ses fonctionnalités supplémentaires pour la protection EKS, la protection ECS, la protection S3, la protection RDS, la protection contre les logiciels malveillants, la protection Lambda, etc. Vous pouvez utiliser des services comme Centre de sécurité AWS pour centraliser et automatiser vos contrôles de sécurité afin de détecter les écarts par rapport aux meilleures pratiques de sécurité, d'accélérer les enquêtes et d'automatiser la correction des résultats de sécurité avec des playbooks. Vous pouvez également envisager de mettre en place un confiance zéro sur AWS pour augmenter encore les contrôles précis d'authentification et d'autorisation pour ce à quoi les utilisateurs humains ou les processus machine à machine peuvent accéder sur une base par demande. Pensez également à utiliser Lac de sécurité Amazon pour centraliser automatiquement les données de sécurité des environnements AWS, des fournisseurs SaaS, sur site et des sources cloud dans un lac de données spécialement conçu et stocké dans votre compte. Avec Security Lake, vous pouvez obtenir une compréhension plus complète de vos données de sécurité dans l’ensemble de votre organisation.

Une fois votre environnement de charge de travail d'IA générative sécurisé, vous pouvez superposer des fonctionnalités spécifiques à l'IA/ML, telles que Gestionnaire de données Amazon SageMaker identifier les biais potentiels lors de la préparation des données et Amazon SageMaker Clarifier pour détecter les biais dans les données et les modèles ML. Vous pouvez aussi utiliser Moniteur de modèle Amazon SageMaker pour évaluer la qualité des modèles SageMaker ML en production et vous avertir en cas de dérive dans la qualité des données, la qualité du modèle et l'attribution des fonctionnalités. Ces services AWS AI/ML travaillant ensemble (y compris SageMaker travaillant avec Amazon Bedrock) avec les services de sécurité AWS peuvent vous aider à identifier les sources potentielles de biais naturels et à vous protéger contre la falsification malveillante des données. Répétez ce processus pour chacune des 10 vulnérabilités OWASP pour LLM afin de vous assurer que vous maximisez la valeur des services AWS afin de mettre en œuvre une défense en profondeur pour protéger vos données et vos charges de travail.

Comme l'a écrit Clarke Rodgers, stratège d'entreprise AWS, dans son article de blog « CISO Insight : chaque service AWS est un service de sécurité », « Je dirais que pratiquement tous les services du cloud AWS permettent d'obtenir un résultat en matière de sécurité par eux-mêmes ou peuvent être utilisés (seuls ou en conjonction avec un ou plusieurs services) par les clients pour atteindre un objectif de sécurité, de risque ou de conformité. Et « les responsables de la sécurité de l'information (RSSI) des clients (ou leurs équipes respectives) voudront peut-être prendre le temps de s'assurer qu'ils connaissent bien tous les services AWS, car il peut y avoir un objectif de sécurité, de risque ou de conformité qui peut être atteint. même si un service n'entre pas dans la catégorie « Sécurité, identité et conformité ».

Couches de défense aux limites de confiance dans les applications LLM

Lorsque vous développez des systèmes et des applications basés sur l'IA générative, vous devez prendre en compte les mêmes préoccupations que pour toute autre application de ML, comme mentionné dans le Matrice des menaces liées à l'apprentissage automatique de MITRE ATLAS, comme être attentif aux origines des logiciels et des composants de données (comme effectuer un audit de logiciel open source, examiner la nomenclature logicielle (SBOM) et analyser les flux de travail de données et les intégrations d'API) et mettre en œuvre les protections nécessaires contre les menaces de la chaîne d'approvisionnement LLM. Incluez des informations issues des cadres de l'industrie et soyez conscient des façons d'utiliser plusieurs sources de renseignements sur les menaces et d'informations sur les risques pour ajuster et étendre vos défenses de sécurité afin de prendre en compte les risques de sécurité liés à l'IA, au ML et à l'IA générative qui sont émergents et non inclus dans les cadres traditionnels. Recherchez des informations complémentaires sur les risques spécifiques à l’IA auprès de sources industrielles, de défense, gouvernementales, internationales et universitaires, car de nouvelles menaces émergent et évoluent régulièrement dans cet espace et les cadres et guides complémentaires sont fréquemment mis à jour. Par exemple, lors de l'utilisation d'un modèle RAG (Retrieval Augmented Generation), si le modèle n'inclut pas les données dont il a besoin, il peut les demander à une source de données externe pour les utiliser lors de l'inférence et du réglage fin. La source interrogée peut être hors de votre contrôle et constituer une source potentielle de compromission dans votre chaîne d’approvisionnement. Une approche de défense en profondeur doit être étendue aux sources externes pour établir la confiance, l’authentification, l’autorisation, l’accès, la sécurité, la confidentialité et l’exactitude des données auxquelles elles accèdent. Pour approfondir, lisez «Créez une application d'entreprise sécurisée avec Generative AI et RAG à l'aide d'Amazon SageMaker JumpStart »

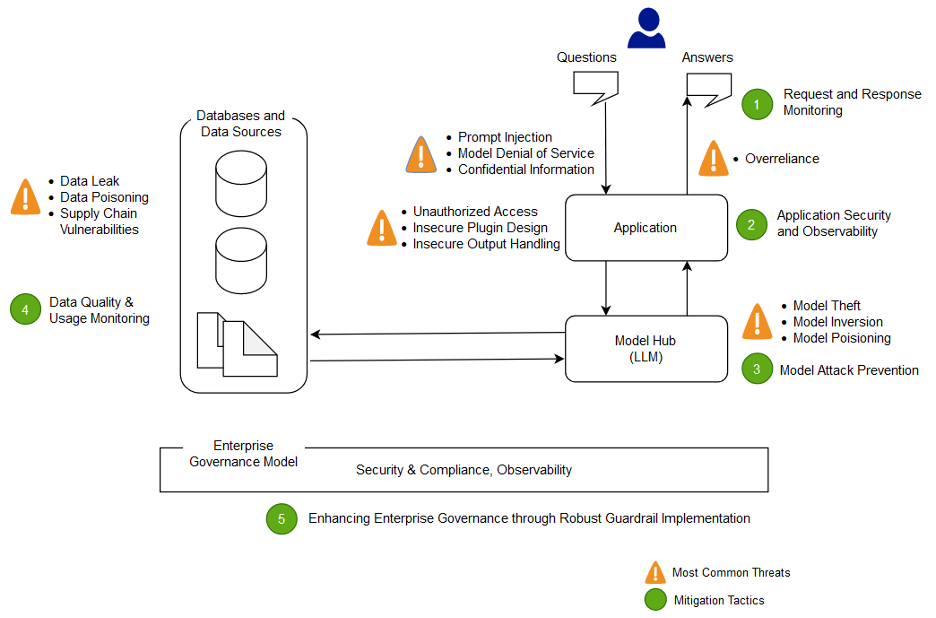

Analysez et atténuez les risques dans vos applications LLM

Dans cette section, nous analysons et discutons de certaines techniques d'atténuation des risques basées sur des limites et des interactions de confiance, ou sur des zones distinctes de la charge de travail avec une portée de contrôles et un profil de risque appropriés similaires. Dans cet exemple d'architecture d'application chatbot, il existe cinq limites de confiance où les contrôles sont démontrés, en fonction de la manière dont les clients AWS créent généralement leurs applications LLM. Votre application LLM peut avoir plus ou moins de limites de confiance définissables. Dans l'exemple d'architecture suivant, ces limites de confiance sont définies comme :

- Interactions avec l'interface utilisateur (demande et réponse)

- Interactions avec les applications

- Interactions de modèle

- Interactions avec les données

- Interactions organisationnelles et utilisation

Interactions avec l'interface utilisateur : développer la surveillance des demandes et des réponses

Détectez et répondez aux cyber-incidents liés à l’IA générative en temps opportun en évaluant une stratégie pour gérer les risques liés aux entrées et aux sorties de l’application d’IA générative. Par exemple, une surveillance supplémentaire des comportements et des sorties de données peut devoir être instrumentée pour détecter la divulgation d'informations sensibles en dehors de votre domaine ou de votre organisation, dans le cas où elles sont utilisées dans l'application LLM.

Les applications d'IA générative doivent toujours respecter les meilleures pratiques de sécurité standard en matière de protection des données. Établir un périmètre de données sécurisé ainsi que sécuriser les magasins de données sensibles. Chiffrez les données et les informations utilisées pour les applications LLM au repos et en transit. Protégez les données utilisées pour entraîner votre modèle contre l'empoisonnement des données d'entraînement en comprenant et en contrôlant quels utilisateurs, processus et rôles sont autorisés à contribuer aux magasins de données, ainsi que la façon dont les données circulent dans l'application, en surveillant les écarts de biais et en utilisant la gestion des versions et stockage immuable dans les services de stockage tels qu'Amazon S3. Établissez des contrôles stricts d'entrée et de sortie de données à l'aide de services tels qu'AWS Network Firewall et AWS VPC pour vous protéger contre les entrées suspectes et le potentiel d'exfiltration de données.

Pendant le processus de formation, de recyclage ou de réglage fin, vous devez être conscient de toutes les données sensibles utilisées. Une fois les données utilisées au cours de l'un de ces processus, vous devez planifier un scénario dans lequel tout utilisateur de votre modèle devient soudainement capable d'extraire les données ou les informations en utilisant des techniques d'injection rapide. Comprenez les risques et les avantages liés à l’utilisation de données sensibles dans vos modèles et inférences. Implémentez des mécanismes d'authentification et d'autorisation robustes pour établir et gérer des autorisations d'accès précises, qui ne reposent pas sur la logique d'application LLM pour empêcher la divulgation. Il a été démontré que l'entrée contrôlée par l'utilisateur dans une application d'IA générative est capable, sous certaines conditions, de fournir un vecteur permettant d'extraire des informations du modèle ou de toute partie non contrôlée de l'utilisateur de l'entrée. Cela peut se produire via une injection rapide, où l'utilisateur fournit une entrée qui fait s'écarter la sortie du modèle des garde-fous attendus de l'application LLM, notamment en fournissant des indices sur les ensembles de données sur lesquels le modèle a été initialement formé.

Implémentez des quotas d'accès au niveau des utilisateurs pour les utilisateurs fournissant des entrées et recevant des sorties d'un modèle. Vous devez envisager des approches qui n'autorisent pas l'accès anonyme dans des conditions où les données et informations d'entraînement du modèle sont sensibles, ou lorsqu'il existe un risque qu'un adversaire entraîne un fac-similé de votre modèle en fonction de son entrée et de la sortie de votre modèle aligné. En général, si une partie de l'entrée d'un modèle consiste en un texte arbitraire fourni par l'utilisateur, considérez que la sortie est susceptible d'être injectée rapidement et assurez-vous par conséquent que l'utilisation des sorties inclut des contre-mesures techniques et organisationnelles mises en œuvre pour atténuer la gestion non sécurisée des sorties, l'agence excessive. , et une dépendance excessive. Dans l'exemple précédent relatif au filtrage des entrées malveillantes à l'aide d'AWS WAF, envisagez de créer un filtre devant votre application pour une telle utilisation abusive potentielle des invites, et développez une politique sur la manière de les gérer et de les faire évoluer à mesure que votre modèle et vos données se développent. Envisagez également un examen filtré du résultat avant qu'il ne soit renvoyé à l'utilisateur pour garantir qu'il répond aux normes de qualité, d'exactitude ou de modération du contenu. Vous souhaiterez peut-être personnaliser davantage cela en fonction des besoins de votre organisation avec une couche de contrôle supplémentaire sur les entrées et les sorties devant vos modèles afin d'atténuer les modèles de trafic suspects.

Interactions avec les applications : sécurité et observabilité des applications

Examinez votre application LLM en prêtant attention à la manière dont un utilisateur pourrait utiliser votre modèle pour contourner l'autorisation standard d'un outil ou d'une chaîne d'outils en aval auquel il n'a pas l'autorisation d'accéder ou d'utiliser. Une autre préoccupation à ce niveau concerne l'accès aux magasins de données externes en utilisant un modèle comme mécanisme d'attaque utilisant des risques LLM techniques ou organisationnels non atténués. Par exemple, si votre modèle est entraîné pour accéder à certains magasins de données susceptibles de contenir des données sensibles, vous devez vous assurer que vous disposez de contrôles d'autorisation appropriés entre votre modèle et les magasins de données. Utilisez des attributs immuables sur les utilisateurs qui ne proviennent pas du modèle lors des vérifications d'autorisation. Une gestion non sécurisée des résultats, une conception de plug-in non sécurisée et une agence excessive peuvent créer des conditions dans lesquelles un acteur malveillant peut utiliser un modèle pour tromper le système d'autorisation afin qu'il augmente les privilèges effectifs, ce qui amène un composant en aval à croire que l'utilisateur est autorisé à récupérer des données ou à prendre un accès spécifique. action.

Lors de la mise en œuvre d'un plugin ou d'un outil d'IA générative, il est impératif d'examiner et de comprendre le niveau d'accès accordé, ainsi que d'examiner les contrôles d'accès qui ont été configurés. L’utilisation de plug-ins d’IA générative non atténués et non atténués peut rendre votre système vulnérable aux vulnérabilités et aux menaces de la chaîne d’approvisionnement, conduisant potentiellement à des actions malveillantes, notamment l’exécution de code à distance.

Interactions de modèle : prévention des attaques de modèle

Vous devez connaître l'origine de tous les modèles, plugins, outils ou données que vous utilisez, afin d'évaluer et d'atténuer les vulnérabilités de la chaîne d'approvisionnement. Par exemple, certains formats de modèles courants permettent l'intégration de code exécutable arbitraire dans les modèles eux-mêmes. Utilisez des miroirs de packages, des analyses et des inspections supplémentaires en fonction des objectifs de sécurité de votre organisation.

Les ensembles de données sur lesquels vous entraînez et affinez vos modèles doivent également être revus. Si vous affinez automatiquement un modèle en fonction des commentaires des utilisateurs (ou d'autres informations contrôlables par l'utilisateur final), vous devez vous demander si un acteur malveillant malveillant pourrait modifier le modèle arbitrairement en fonction de la manipulation de ses réponses et provoquer un empoisonnement des données de formation.

Interactions avec les données : surveiller la qualité et l'utilisation des données

Les modèles d’IA générative tels que les LLM fonctionnent généralement bien car ils ont été formés sur une grande quantité de données. Bien que ces données aident les LLM à accomplir des tâches complexes, elles peuvent également exposer votre système à un risque d'empoisonnement des données d'entraînement, qui se produit lorsque des données inappropriées sont incluses ou omises dans un ensemble de données d'entraînement pouvant modifier le comportement d'un modèle. Pour atténuer ce risque, vous devez examiner votre chaîne d'approvisionnement et comprendre le processus d'examen des données de votre système avant de l'utiliser dans votre modèle. Bien que le pipeline de formation soit une source majeure d'empoisonnement des données, vous devez également examiner comment votre modèle obtient les données, par exemple dans un modèle RAG ou un lac de données, et si la source de ces données est fiable et protégée. Utilisez les services de sécurité AWS tels qu'AWS Security Hub, Amazon GuardDuty et Amazon Inspector pour surveiller en permanence les activités suspectes dans Amazon EC2, Amazon EKS, Amazon S3, Service de base de données relationnelle Amazon (Amazon RDS) et l'accès au réseau qui peuvent être des indicateurs de menaces émergentes, et utilisez Detective pour visualiser les enquêtes de sécurité. Pensez également à utiliser des services tels que Lac de sécurité Amazon pour accélérer les enquêtes de sécurité en créant un lac de données spécialement conçu pour centraliser automatiquement les données de sécurité des environnements AWS, des fournisseurs SaaS, sur site et des sources cloud qui contribuent à vos charges de travail IA/ML.

Interactions organisationnelles : mettre en œuvre des garde-fous de gouvernance d'entreprise pour l'IA générative

Identifiez les risques associés à l’utilisation de l’IA générative pour vos entreprises. Vous devez élaborer la taxonomie des risques de votre organisation et effectuer des évaluations des risques pour prendre des décisions éclairées lors du déploiement de solutions d'IA générative. Développer une plan de continuité des activités (PCA) qui inclut des charges de travail d'IA, de ML et d'IA générative et qui peut être mis en œuvre rapidement pour remplacer la fonctionnalité perdue d'une application LLM impactée ou hors ligne afin de respecter vos SLA.

Identifiez les lacunes, les inefficacités et les incohérences en matière de processus et de ressources, et améliorez la sensibilisation et l’appropriation au sein de votre entreprise. Modèle de menace toutes les charges de travail d'IA générative pour identifier et atténuer les menaces de sécurité potentielles susceptibles d'avoir un impact sur l'entreprise, notamment l'accès non autorisé aux données, le déni de service et l'utilisation abusive des ressources. Profitez du nouveau Outil de modélisation AWS Thrat Composer pour aider à réduire le délai de rentabilisation lors de la modélisation des menaces. Plus tard dans vos cycles de développement, envisagez d'inclure l'introduction ingénierie du chaos de sécurité des expériences d'injection de fautes pour créer des conditions réelles afin de comprendre comment votre système réagira aux inconnues et renforcer la confiance dans la résilience et la sécurité du système.

Incluez diverses perspectives dans l’élaboration de stratégies de sécurité et de mécanismes de gestion des risques afin de garantir le respect et la couverture de l’IA/ML et de la sécurité générative dans tous les rôles et fonctions. Apportez un état d’esprit de sécurité dès la création et la recherche de toute application d’IA générative pour vous aligner sur les exigences. Si vous avez besoin d'une assistance supplémentaire de la part d'AWS, demandez à votre responsable de compte AWS de vous assurer qu'il existe une assistance égale en demandant aux architectes de solutions AWS d'AWS Security et AI/ML de vous aider en tandem.

Assurez-vous que votre organisation de sécurité prend régulièrement des mesures pour favoriser la communication autour de la sensibilisation aux risques et de la compréhension de la gestion des risques parmi les parties prenantes de l'IA générative telles que les chefs de produit, les développeurs de logiciels, les scientifiques des données et les dirigeants, permettant aux informations sur les menaces et aux conseils en matière de contrôle d'atteindre les équipes qui peuvent être impacté. Les organisations de sécurité peuvent soutenir une culture de divulgation responsable et d’amélioration itérative en participant aux discussions et en apportant de nouvelles idées et informations aux parties prenantes de l’IA générative en rapport avec leurs objectifs commerciaux. En savoir plus sur notre engagement pour une IA Responsable et supplémentaire ressources IA responsables pour aider nos clients.

Bénéficiez d’un avantage en permettant une meilleure posture organisationnelle pour l’IA générative en libérant du temps de rentabilisation dans les processus de sécurité existants de votre organisation. Évaluez de manière proactive les domaines dans lesquels votre organisation peut avoir besoin de processus trop lourds compte tenu du contexte de sécurité de l'IA générative et affinez-les pour fournir aux développeurs et aux scientifiques une voie claire à suivre avec les contrôles appropriés en place.

Évaluez les possibilités d’aligner les incitations, de réduire les risques et de fournir une vision claire des résultats souhaités. Mettez à jour les directives et les défenses en matière de contrôles pour répondre aux besoins changeants du développement d’applications d’IA/ML et d’IA générative afin de réduire la confusion et l’incertitude qui peuvent coûter du temps de développement, augmenter les risques et accroître l’impact.

Assurez-vous que les parties prenantes qui ne sont pas des experts en sécurité sont capables à la fois de comprendre comment la gouvernance organisationnelle, les politiques et les étapes de gestion des risques s'appliquent à leurs charges de travail, ainsi que d'appliquer les mécanismes de gestion des risques. Préparez votre organisation à répondre à des événements et des scénarios réalistes qui peuvent survenir avec les applications d'IA générative, et assurez-vous que les rôles de constructeur d'IA générative et les équipes d'intervention sont conscients des chemins et des actions d'escalade en cas de préoccupation concernant une activité suspecte.

Conclusion

Pour commercialiser avec succès l'innovation avec toute technologie nouvelle et émergente, il faut commencer par un état d'esprit axé sur la sécurité, s'appuyer sur une infrastructure sécurisée et réfléchir à la manière d'intégrer davantage la sécurité à chaque niveau de la pile technologique dès le début avec une sécurité de défense en profondeur. approche. Cela inclut les interactions à plusieurs niveaux de votre pile technologique et les points d'intégration au sein de votre chaîne d'approvisionnement numérique, pour garantir la résilience organisationnelle. Bien que l’IA générative présente de nouveaux défis en matière de sécurité et de confidentialité, si vous suivez les meilleures pratiques fondamentales en matière de sécurité, telles que l’utilisation d’une défense en profondeur avec des services de sécurité en couches, vous pouvez contribuer à protéger votre organisation contre de nombreux problèmes courants et menaces évolutives. Vous devez mettre en œuvre des services de sécurité AWS en couches sur vos charges de travail d'IA générative et dans votre organisation plus large, et vous concentrer sur les points d'intégration dans vos chaînes d'approvisionnement numériques pour sécuriser vos environnements cloud. Vous pouvez ensuite utiliser les fonctionnalités améliorées de sécurité et de confidentialité des services AWS AI/ML tels qu'Amazon SageMaker et Amazon Bedrock pour ajouter des couches supplémentaires de contrôles améliorés de sécurité et de confidentialité à vos applications d'IA générative. L’intégration de la sécurité dès le départ permettra d’innover plus rapidement, plus facilement et de manière plus rentable grâce à l’IA générative, tout en simplifiant la conformité. Cela vous aidera à accroître les contrôles, la confiance et l'observabilité de vos applications d'IA générative pour vos employés, clients, partenaires, régulateurs et autres parties prenantes concernées.

Références supplémentaires

- Cadres standards de l’industrie pour la gestion des risques et la sécurité spécifiques à l’IA/ML :

À propos des auteurs

Christophe Rae est l'un des principaux spécialistes mondiaux de la sécurité GTM, axé sur le développement et l'exécution d'initiatives stratégiques qui accélèrent et étendent l'adoption des services de sécurité AWS. Il est passionné par l'intersection de la cybersécurité et des technologies émergentes, avec plus de 20 ans d'expérience dans des rôles de direction stratégique mondiale fournissant des solutions de sécurité aux clients des médias, du divertissement et des télécommunications. Il se ressource grâce à la lecture, aux voyages, à la gastronomie et au vin, à la découverte de nouvelles musiques et au conseil aux startups en démarrage.

Christophe Rae est l'un des principaux spécialistes mondiaux de la sécurité GTM, axé sur le développement et l'exécution d'initiatives stratégiques qui accélèrent et étendent l'adoption des services de sécurité AWS. Il est passionné par l'intersection de la cybersécurité et des technologies émergentes, avec plus de 20 ans d'expérience dans des rôles de direction stratégique mondiale fournissant des solutions de sécurité aux clients des médias, du divertissement et des télécommunications. Il se ressource grâce à la lecture, aux voyages, à la gastronomie et au vin, à la découverte de nouvelles musiques et au conseil aux startups en démarrage.

Élie Hiver est un ingénieur de sécurité senior chez Amazon Security, titulaire d'un BS en ingénierie de cybersécurité et imprégné d'un amour pour Harry Potter. Elijah excelle dans l'identification et la résolution des vulnérabilités des systèmes d'IA, alliant expertise technique et touche de magie. Elijah conçoit des protocoles de sécurité sur mesure pour les écosystèmes d’IA, apportant une touche magique aux défenses numériques. Soucieux d'intégrité, Elijah possède une expérience en sécurité dans des organisations des secteurs public et commercial, axée sur la protection de la confiance.

Élie Hiver est un ingénieur de sécurité senior chez Amazon Security, titulaire d'un BS en ingénierie de cybersécurité et imprégné d'un amour pour Harry Potter. Elijah excelle dans l'identification et la résolution des vulnérabilités des systèmes d'IA, alliant expertise technique et touche de magie. Elijah conçoit des protocoles de sécurité sur mesure pour les écosystèmes d’IA, apportant une touche magique aux défenses numériques. Soucieux d'intégrité, Elijah possède une expérience en sécurité dans des organisations des secteurs public et commercial, axée sur la protection de la confiance.

Bélier Vittal est architecte principal de solutions ML chez AWS. Il possède plus de trois décennies d'expérience dans l'architecture et la création d'applications distribuées, hybrides et cloud. Il est passionné par la création de solutions d'IA/ML et de Big Data sécurisées et évolutives pour aider les entreprises clientes dans leur parcours d'adoption et d'optimisation du cloud afin d'améliorer leurs résultats commerciaux. Dans ses temps libres, il roule en moto et se promène avec son Sheepadoodle de 3 ans !

Bélier Vittal est architecte principal de solutions ML chez AWS. Il possède plus de trois décennies d'expérience dans l'architecture et la création d'applications distribuées, hybrides et cloud. Il est passionné par la création de solutions d'IA/ML et de Big Data sécurisées et évolutives pour aider les entreprises clientes dans leur parcours d'adoption et d'optimisation du cloud afin d'améliorer leurs résultats commerciaux. Dans ses temps libres, il roule en moto et se promène avec son Sheepadoodle de 3 ans !

Navneet Tutéja est spécialiste des données chez Amazon Web Services. Avant de rejoindre AWS, Navneet a travaillé en tant que facilitateur pour des organisations cherchant à moderniser leurs architectures de données et à mettre en œuvre des solutions complètes d'IA/ML. Elle est titulaire d'un diplôme d'ingénieur de l'Université Thapar, ainsi que d'une maîtrise en statistiques de l'Université Texas A&M.

Navneet Tutéja est spécialiste des données chez Amazon Web Services. Avant de rejoindre AWS, Navneet a travaillé en tant que facilitateur pour des organisations cherchant à moderniser leurs architectures de données et à mettre en œuvre des solutions complètes d'IA/ML. Elle est titulaire d'un diplôme d'ingénieur de l'Université Thapar, ainsi que d'une maîtrise en statistiques de l'Université Texas A&M.

Emilie Soward est un Data Scientist avec AWS Professional Services. Elle est titulaire d'une maîtrise ès sciences avec distinction en intelligence artificielle de l'Université d'Édimbourg en Écosse, au Royaume-Uni, avec un accent sur le traitement du langage naturel (TAL). Emily a occupé des postes scientifiques et d'ingénierie appliqués axés sur la recherche et le développement de produits basés sur l'IA, l'excellence opérationnelle et la gouvernance des charges de travail d'IA exécutées dans des organisations des secteurs public et privé. Elle contribue à l'orientation des clients en tant que conférencière principale d'AWS et, récemment, en tant qu'auteur pour AWS Well-Architected dans l'objectif d'apprentissage automatique.

Emilie Soward est un Data Scientist avec AWS Professional Services. Elle est titulaire d'une maîtrise ès sciences avec distinction en intelligence artificielle de l'Université d'Édimbourg en Écosse, au Royaume-Uni, avec un accent sur le traitement du langage naturel (TAL). Emily a occupé des postes scientifiques et d'ingénierie appliqués axés sur la recherche et le développement de produits basés sur l'IA, l'excellence opérationnelle et la gouvernance des charges de travail d'IA exécutées dans des organisations des secteurs public et privé. Elle contribue à l'orientation des clients en tant que conférencière principale d'AWS et, récemment, en tant qu'auteur pour AWS Well-Architected dans l'objectif d'apprentissage automatique.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/architect-defense-in-depth-security-for-generative-ai-applications-using-the-owasp-top-10-for-llms/