Muistatko, kun Googlen Bard, nyt nimeltään Gemini, ei osannut vastata kysymykseen James Webbin avaruusteleskooppista aloitusmainoksessaan? Anna minun hölkätä muistiasi tästä kuuluisasta tapauksesta – se on yksi suurimmista näkemistämme tekoälyharhoista.

Mikä meni alas? Mainoksen aikana Google Bard -demossa kysyttiin: "Mitä uusia James Webbin avaruusteleskoopin löytöjä voin jakaa 9-vuotiaalleni?" Lyhyen tauon jälkeen Google Bard -demo antoi kaksi oikeaa vastausta. Lopullinen vastaus oli kuitenkin väärä. Google Bard -demon mukaan kaukoputki oli ottanut ensimmäiset kuvat aurinkokuntamme ulkopuolella sijaitsevasta planeettasta. Todellisuudessa Euroopan eteläisen observatorion Very Large Telescope oli kuitenkin jo ottanut kuvia näistä "eksoplaneetoista", jotka oli tallennettu NASAn arkistoon.

Ei olla ~no, itse asiassa~ ääliö, ja olen varma, että Bard on vaikuttava, mutta tiedoksi: JWST ei ottanut "ensimmäistä kuvaa aurinkokuntamme ulkopuolella olevasta planeettasta".

ensimmäisen kuvan sen sijaan teki Chauvin et al. (2004) VLT/NACO:n kanssa adaptiivista optiikkaa käyttäen. https://t.co/bSBb5TOeUW pic.twitter.com/KnrZ1SSz7h

- Grant Tremblay (@astrogrant) Helmikuu 7, 2023

Miksi Googlen kaltaiset teknologiajättiläiset eivät voi edes estää tällaisia virheitä? Otetaan selvää!

Mikä on AI-hallusinaatio?

Tekoälyn hallusinaatio syntyy, kun tietokoneohjelma, joka toimii tyypillisesti tekoälyllä (AI), tuottaa virheellisiä, järjettömiä tai harhaanjohtavia tuloksia. Tätä termiä käytetään usein kuvaamaan tilanteita, joissa tekoälymallit luovat vastauksia, jotka ovat täysin sivussa tai eivät liity niille annettuun syötteeseen. Se on kuin kysyisit kysymyksen ja saisit vastauksen, jossa ei ole mitään järkeä tai joka ei ole ollenkaan sitä mitä odotit.

Ymmärtää miksi tekoälyn hallusinaatiot tapahtuu, katsotaanpa miten tekoäly toimii. Tekoälymallit, kuten chatbotit tai kuvantunnistusjärjestelmät, on koulutettu suuriin tietokokonaisuuksiin oppimaan malleja ja tekemään ennusteita. Jos harjoitustiedot ovat kuitenkin virheellisiä, epätäydellisiä tai vääristyneitä, tekoälymalli saattaa oppia vääriä kuvioita tai assosiaatioita. Tämä voi johtaa hallusinoituihin ulostuloihin, joissa tekoäly tuottaa vastauksia, jotka perustuvat virheellisiin tai väärinymmärrettyihin tietoihin. Ja sitä tapahtuu paljon, vaikka et ehkä huomannutkaan.

Tekoälyhalusinaatiot voivat ilmetä eri muodoissa, joista jokainen korostaa erilaisia haasteita ja monimutkaisuuksia tekoälyjärjestelmissä. Tässä on joitain yleisiä tekoälyn hallusinaatiotyyppejä:

- Lause AI hallusinaatio:

- Tässä skenaariossa tekoälymalli luo lauseen, joka on ristiriidassa edellisen lauseen kanssa samassa kontekstissa. Esimerkiksi:

- Kehote: "Kuvaile hahmon matkaa kolmen sanan lauseilla."

- Tulos: "Hän käveli hitaasti. Yhtäkkiä hän juoksi. Sitten hän käveli."

- Tässä skenaariossa tekoälymalli luo lauseen, joka on ristiriidassa edellisen lauseen kanssa samassa kontekstissa. Esimerkiksi:

Viimeinen lause on ristiriidassa aikaisemman juoksemisen kanssa, mikä häiritsee kertomuksen johdonmukaisuutta.

- Nopea tekoäly-hallusinaatio:

- Tämä tyyppi ilmenee, kun tekoälyn luoma vastaus on ristiriidassa aiotun kehotteen tai kyselyn kanssa. Esimerkiksi:

- Kehote: "Kirjoita suklaakakun resepti."

- Tulos: "Tässä on runo tähdistä."

- Tämä tyyppi ilmenee, kun tekoälyn luoma vastaus on ristiriidassa aiotun kehotteen tai kyselyn kanssa. Esimerkiksi:

Luotu sisältö ei täytä ruoanlaittoon liittyvää kehotusta, mikä osoittaa kontekstin ymmärtämisen epäonnistumisen.

- Todelliset tekoäly-hallusinaatiot:

- Tosiasialliset ristiriidat syntyvät, kun tekoälymalli esittää väärää tietoa paikkansa pitävänä. Esimerkiksi:

- Kehote: "Luettelo kolme elementtiä jaksollisessa taulukossa."

- Tulos: "Vety, happi, karboniitti."

- Tosiasialliset ristiriidat syntyvät, kun tekoälymalli esittää väärää tietoa paikkansa pitävänä. Esimerkiksi:

"Karboniitti" ei ole elementti, mikä johtaa väärään informaatioon vastauksessa.

- Epäolennaiset tai satunnaiset tekoäly-hallusinaatiot:

- Näihin hallusinaatioihin liittyy epäolennaisen tai järjettömän tiedon tuottaminen, joka ei liity syötteeseen. Esimerkiksi:

- Kehote: "Kuvaile päivä rannalla."

- Tulos: "Hiekka oli lämmintä. Lokit lauloivat jazzia. Pingviinit tanssivat balettia."

- Näihin hallusinaatioihin liittyy epäolennaisen tai järjettömän tiedon tuottaminen, joka ei liity syötteeseen. Esimerkiksi:

Pingviinien ja baletin mainitseminen ei ole linjassa tyypillisen rantakohtauksen kanssa, mikä osoittaa johdonmukaisuuden puutteen syntyneessä kertomuksessa.

Tämäntyyppiset hallusinaatiot korostavat tekoälyjärjestelmien haasteita ymmärtää ja kontekstualisoida tietoja tarkasti. Näiden ongelmien ratkaiseminen edellyttää koulutusdatan laadun parantamista, kielimallien kontekstin ymmärtämisen parantamista ja vankkojen validointimekanismien käyttöönottoa tekoälyn tuottamien tulosten johdonmukaisuuden ja tarkkuuden varmistamiseksi.

Tekoälyhalusinaatioilla voi olla vakavia seurauksia, erityisesti sovelluksissa, joissa tekoälyä käytetään tärkeiden päätösten tekemiseen, kuten lääketieteelliseen diagnoosiin tai talouskauppaan. Jos tekoälyjärjestelmä tekee hallusinaatioita ja antaa epätarkkoja tietoja näissä yhteyksissä, se voi johtaa haitallisiin seurauksiin.

Mitä voit tehdä tekoäly-hallusinaatioille?

Tekoälyhalusinaatioiden vähentäminen sisältää muutaman avainvaiheen tekoälyjärjestelmien tarkkuuden ja luotettavuuden parantamiseksi:

Ensinnäkin on erittäin tärkeää käyttää laadukasta dataa tekoälyn kouluttamiseen. Tämä tarkoittaa, että tieto, josta tekoäly oppii, on monipuolista, tarkkaa ja vapaata.

Tekoälymallien yksinkertaistaminen voi myös auttaa. Monimutkaiset mallit voivat joskus johtaa odottamattomiin virheisiin. Pitämällä asiat yksinkertaisina voimme vähentää virheiden mahdollisuuksia.

Myös selkeät ja helposti ymmärrettävät ohjeet ovat tärkeitä. Kun tekoäly saa selkeät syötteet, se ei todennäköisesti hämmentyi ja tekee virheitä.

Säännöllinen testaus auttaa havaitsemaan virheet varhaisessa vaiheessa. Tarkistamalla, kuinka hyvin tekoäly toimii, voimme korjata mahdolliset ongelmat ja tehdä parannuksia.

Myös tarkistusten lisääminen tekoälyjärjestelmiin voi auttaa. Nämä tarkistukset etsivät virheet ja korjaavat ne ennen kuin ne aiheuttavat ongelmia.

Mikä tärkeintä, inhimillinen valvonta on välttämätöntä. Kun ihmiset tarkistavat tekoälyn tuottamat lähdöt, varmistetaan tarkkuus ja luotettavuus.

Lopuksi tekoälyn kouluttaminen puolustautumaan hyökkäyksiä vastaan voi tehdä siitä kestävämmän. Tämä auttaa tekoälyä tunnistamaan ja käsittelemään yrityksiä manipuloida tai huijata sitä.

Seuraamalla näitä vaiheita voimme tehdä tekoälyjärjestelmistä luotettavampia ja vähentää hallusinoitujen tulosten mahdollisuuksia.

Kuinka saada tekoäly hallusinoitumaan?

Jos haluat hyödyntää tätä puutetta ja pitää hauskaa, voit tehdä muutaman asian:

- Muuta syöttöä: Voit muokata tekoälylle annettuja tietoja. Pienetkin muutokset voivat tehdä siitä outoja tai vääriä vastauksia.

- Huijaa mallia: Luo erityisiä syötteitä, jotka huijaavat tekoälyä antamaan vääriä vastauksia. Nämä temput hyödyntävät mallin heikkouksia luodakseen hallusinoituja tuloksia.

- Sekoillaan datan kanssa: Lisäämällä harhaanjohtavaa tai virheellistä tietoa tekoälyn harjoitustietoihin tai kehotteeseen, voit saada sen oppimaan vääriä asioita ja tuottamaan hallusinaatioita.

- Säädä mallia: Muokkaa tekoälyn asetuksia tai rakennetta virheiden tai harhojen lisäämiseksi. Nämä muutokset voivat aiheuttaa sen, että se tuottaa outoja tai järjettömiä tuloksia.

- Anna hämmentäviä syötteitä: Anna tekoälylle epäselviä tai ristiriitaisia ohjeita. Tämä voi hämmentää tekoälyä ja johtaa vääriin tai järjettömiin reaktioihin.

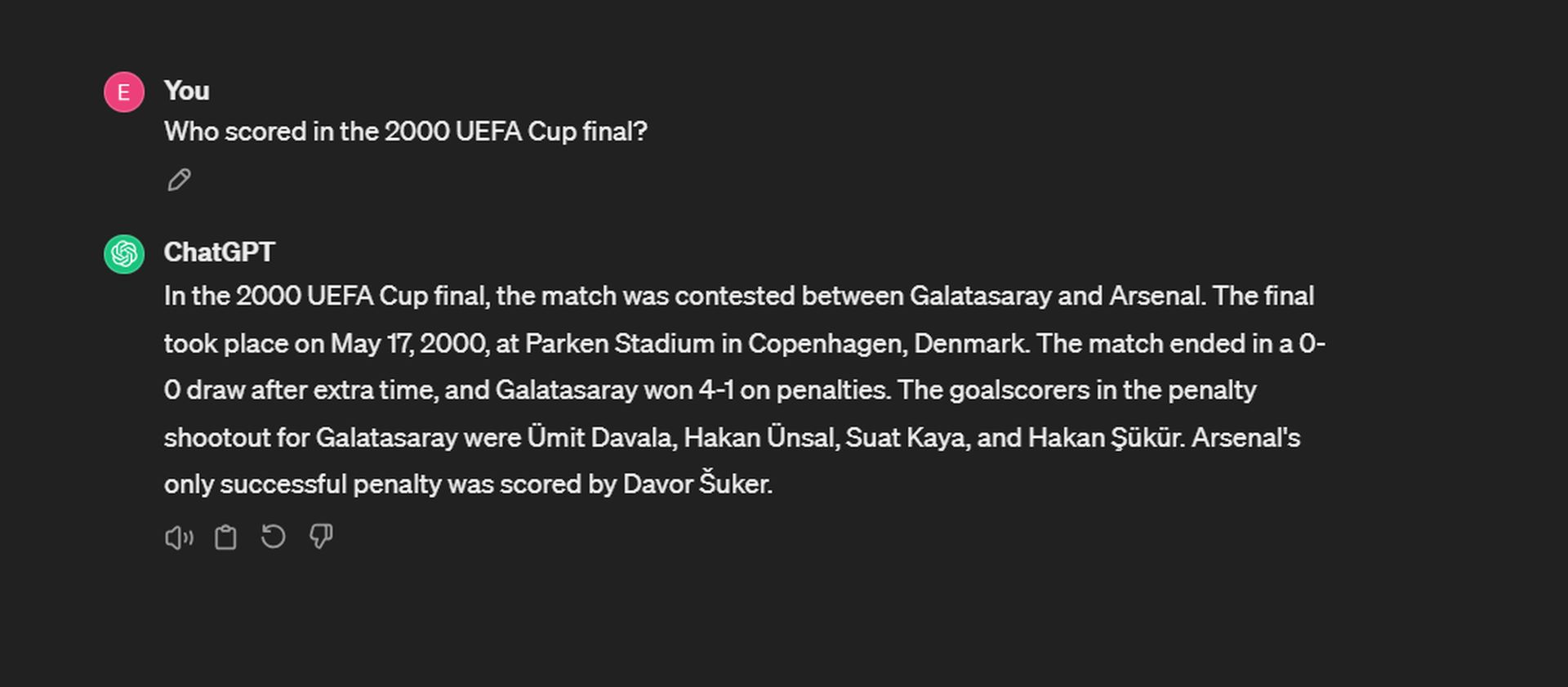

Tai voit vain esittää kysymyksiä ja kokeilla onneasi! Esimerkiksi, yritimme saada ChatGPT:n hallusinoitumaan:

Vaikka ChatGPT muistaa tarkasti päivämäärän ja tuloksen, se horjuu muistaessaan rangaistuspotkukilpailun maalintekijät. Galatasaraylla maalit tekivät Ergün Penbe, Hakan Şükür, Ümit Davala ja Popescu. Arsenalin puolella Ray Parlour oli ainoa onnistunut rangaistuspotkujen tekijä.

Tekoälyharhojen tekeminen voi auttaa meitä ymmärtämään sen rajoitukset, mutta on tärkeää käyttää tätä tietoa vastuullisesti ja varmistaa, että tekoälyjärjestelmät pysyvät luotettavina ja luotettavina.

Hallusinoiko GPT 4 vähemmän?

Kyllä arviointi Palo Altossa toimiva yritys käyttää hallusinaatioiden arviointimalliaan, GPT-4 osoittaa alhaisempaa hallusinaatioiden määrää verrattuna muihin suuriin kielimalleihin, paitsi Intel Neural Chat 7B (97.2 %). GPT-97:n tarkkuus on 3 % ja hallusinaatioaste 4 %, ja sillä on korkea tarkkuustaso ja suhteellisen alhainen taipumus tuoda hallusinaatioita asiakirjoja yhteenvetona. Tämä osoittaa, että GPT-4 on vähemmän altis virheellisten tai järjettömien tulosteiden luomiseen verrattuna muihin arvioinnissa testattuihin malleihin.

Toisaalta muutama vähiten tehokkaista malleista tuli Googlelta. Google Palm 2 osoitti 90 prosentin tarkkuutta ja 10 prosentin hallusinaatioiden määrää. Sen chat-jalostettu vastine suoriutui vielä huonommin, sillä tarkkuus oli vain 84.2 % ja korkein hallusinaatiopisteet tulostaulukon mallista 16.2 %. Tässä on lista:

Yhteenvetona voidaan todeta, että tekoäly-hallusinaatio on tekoälyjärjestelmien tekemä virhe, kun ne tuottavat järjettömiä tai virheellisiä tuloksia harjoitustiedoissa tai tietojen käsittelytavassa esiintyvien virheiden vuoksi. Se on kiehtova, mutta haastava tekoälyn näkökohta, johon tutkijat ja kehittäjät pyrkivät puuttumaan.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://dataconomy.com/2024/04/11/what-exactly-is-an-ai-hallucination-and-why-does-it-matter/