Opera revelado hoy su iniciativa de incorporar soporte experimental para 150 variantes locales del Modelo de Lenguaje Grande (LLM), provenientes de alrededor de 50 familias de modelos diferentes. La característica primero llegará a Opera One en la transmisión de Desarrolladores, trayendo consigo 150 modelos de más de 50 familias entre los que los usuarios pueden elegir.

Estos incluyen el Vicuña y del Llama de Google y Meta, respectivamente. Esto significa que la función llegará a los consumidores a través del programa AI Feature Drops de Opera y brindaría acceso temprano a un par de dichas funciones de IA. Esos modelos se ejecutan en su computadora a través de su navegador y se ejecutan con el marco de código abierto de Ollama. Todos los modelos que se ofrecen por ahora se seleccionan de la biblioteca de Ollama, pero la compañía espera que en el futuro incluya algunos de otras fuentes.

Cada uno de estos necesitará más de 2 GB de espacio en su PC local, según la empresa. Por lo tanto, para evitar quedarse sin espacio, utilice su espacio libre con prudencia. Curiosamente, Opera no intenta guardar los datos si se descargan en forma de modelo.

También puede consultar otros modelos en línea en sitios web como HuggingFace y PoE en Quora, por lo que realmente es para sus necesidades de prueba de modelos locales.

Los modelos de lenguaje grandes ahora admiten el procesamiento de datos directamente en el dispositivo del usuario, lo que permite el uso de IA generativa y al mismo tiempo mantiene la información privada y alejada de servidores externos. Opera ha anunciado planes para introducir este enfoque innovador a los LLM locales a través del canal de desarrolladores Opera One, como parte de su nuevo programa AI Feature Drops. Esta iniciativa ofrece a los primeros usuarios la oportunidad de probar versiones de vanguardia de las funciones de inteligencia artificial del navegador de manera rápida y regular. A partir de hoy, los usuarios de Opera One Developer tendrán la libertad de seleccionar el modelo preferido para procesar sus datos.

¿Cómo probar los LLM integrados en Opera?

Para interactuar con estos modelos, los usuarios deben actualizar a la versión más actual de Opera Developer y ejecutar una serie de pasos para habilitar esta interesante funcionalidad:

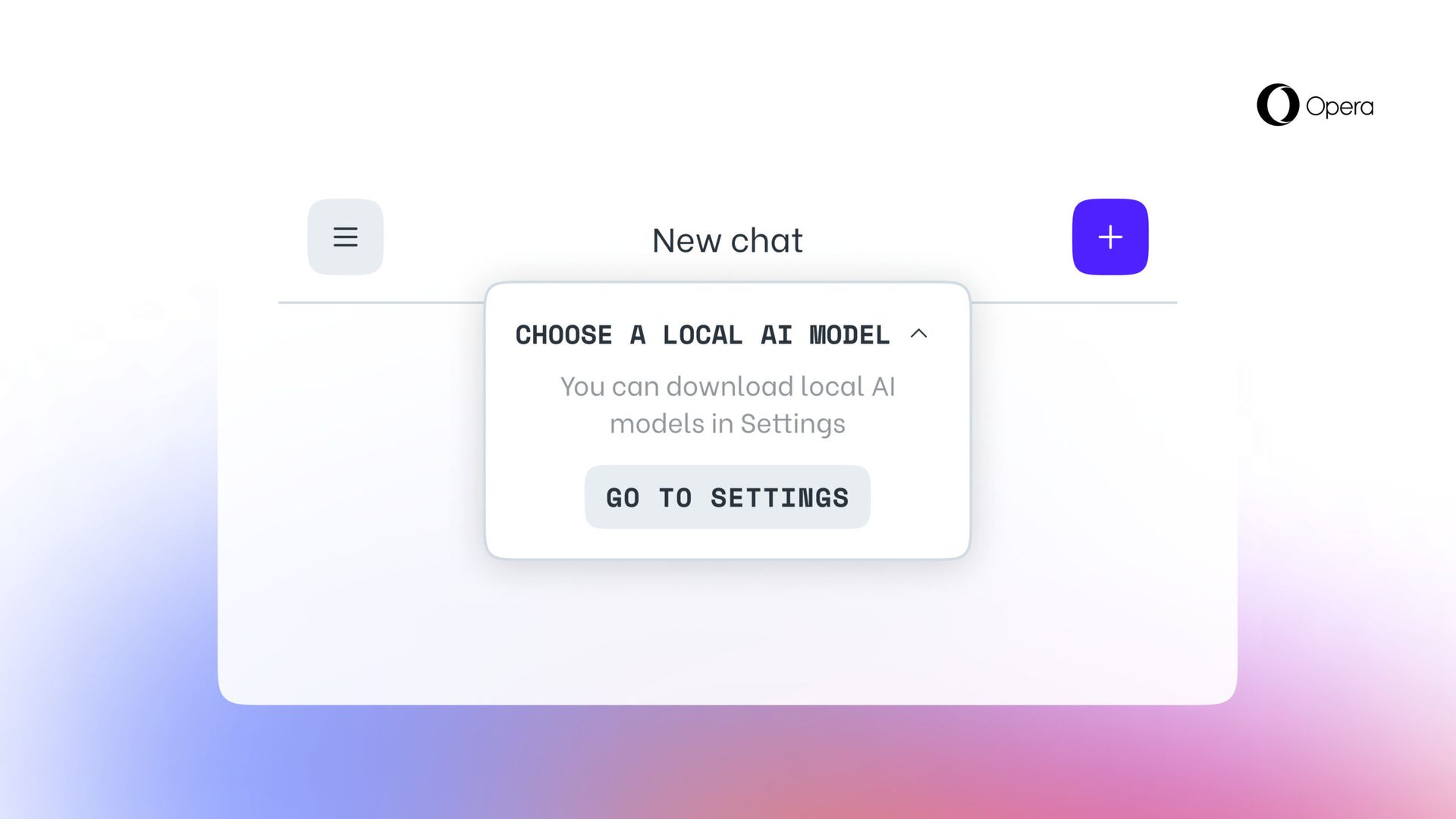

- Accede a la barra lateral de Aria Chat como lo hiciste anteriormente. En la parte superior del chat, hay un menú desplegable con la etiqueta "Elija el modo local."

- Seleccione "Ir a la configuración”de este menú.

- Esta área le permite explore y decida qué modelo(s) desea descargar.

- Para una opción más pequeña y rápida, considere descargar el modelo llamado GEMMA:2B-INSTRUCCIÓN-Q4_K_M haciendo clic en el icono de descarga ubicado a su derecha.

- Una vez finalizada la descarga, haga clic en el botón de menú en la esquina superior izquierda para iniciar una nueva sesión de chat.

- Nuevamente, verás un menú desplegable en la parte superior del chat que dice "Elige el modo local” donde puedes seleccionar el modelo que acabas de instalar.

- Ingresa tu mensaje en el chaty el modelo alojado localmente responderá.

Los participantes seleccionarán un LLM local para descargarlo en su dispositivo. Este enfoque requiere entre 2 a 10 GB de almacenamiento para cada versión, proporcionando una alternativa al uso de Aria, la IA del navegador integrada de Opera. Esta configuración permanece vigente hasta que el usuario inicia una nueva interacción con la IA u opta por reactivar Aria.

Crédito de imagen destacada: Opera

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://dataconomy.com/2024/04/03/opera-unveils-built-in-llms-that-run-locally/