Introducción

En el panorama en constante evolución de la inteligencia artificial, dos actores clave se han unido para abrir nuevos caminos: la IA generativa y el aprendizaje por refuerzo. Estas tecnologías de vanguardia, la IA generativa y el aprendizaje por refuerzo, tienen el potencial de crear sistemas de IA que se mejoran a sí mismos, acercándonos un paso más a hacer realidad el sueño de las máquinas que aprenden y se adaptan de forma autónoma. Estas herramientas están allanando el camino para sistemas de IA que pueden mejorarse a sí mismos, acercándonos a la idea de máquinas que pueden aprender y adaptarse por sí mismas.

La IA ha hecho maravillas notables en los últimos años, desde comprender el lenguaje humano hasta ayudar a las computadoras a ver e interpretar el mundo que las rodea. Los modelos de IA generativa como GPT-3 y los algoritmos de aprendizaje por refuerzo como Deep Q-Networks están a la vanguardia de este progreso. Si bien estas tecnologías han sido transformadoras individualmente, su convergencia abre nuevas dimensiones de las capacidades de la IA y suaviza las fronteras del mundo.

OBJETIVOS DE APRENDIZAJE

- Adquirir el conocimiento profundo y necesario del aprendizaje por refuerzo y sus algoritmos, las estructuras de recompensa, el marco general del aprendizaje por refuerzo y las políticas de acción estatal para comprender cómo los agentes toman decisiones.

- Investigar cómo estas dos ramas pueden combinarse simbióticamente para crear sistemas más adaptativos e inteligentes, particularmente en escenarios de toma de decisiones.

- Estudie y analice varios estudios de casos que demuestran la eficacia y adaptabilidad de integrar la IA generativa con el aprendizaje por refuerzo en campos como la atención sanitaria, los vehículos autónomos y la creación de contenidos.

- Familiarícese con bibliotecas de Python como TensorFlow, PyTorch, OpenAI's Gym y TF-Agents de Google para obtener experiencia práctica en codificación en la implementación de estas tecnologías.

Este artículo fue publicado como parte del Blogatón de ciencia de datos.

Tabla de contenidos.

IA generativa: dar creatividad a las máquinas

IA generativa Los modelos, como el GPT-3 de OpenAI, están diseñados para generar contenido, ya sea lenguaje natural, imágenes o incluso música. Estos modelos operan según el principio de predecir lo que sucederá a continuación en un contexto determinado. Se han utilizado para todo, desde la generación automatizada de contenido hasta chatbots que pueden imitar una conversación humana. El sello distintivo de la IA generativa es su capacidad de crear algo novedoso a partir de los patrones que aprende.

Aprendizaje por refuerzo: enseñar a la IA a tomar decisiones

Aprendizaje reforzado (RL) es otro campo innovador. Es la tecnología que hace que la Inteligencia Artificial aprenda a partir de prueba y error, tal como lo haría un humano. Se ha utilizado para enseñar a la IA a jugar juegos complejos como Dota 2 y Go. Los agentes de RL aprenden recibiendo recompensas o sanciones por sus acciones y utilizan esta retroalimentación para mejorar con el tiempo. En cierto sentido, RL le da a la IA una forma de autonomía, permitiéndole tomar decisiones en entornos dinámicos.

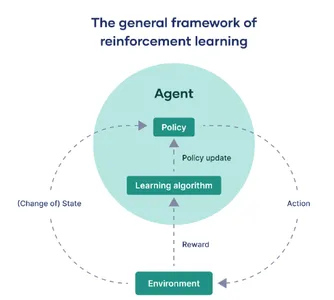

El marco para el aprendizaje por refuerzo

En esta sección, desmitificaremos el marco clave del aprendizaje por refuerzo:

La entidad actuante: el agente

En el ámbito de la inteligencia artificial y el aprendizaje automático, el término "agente" se refiere al modelo computacional encargado de interactuar con un entorno externo designado. Su función principal es tomar decisiones y emprender acciones para lograr un objetivo definido o acumular recompensas máximas a lo largo de una secuencia de pasos.

El mundo que nos rodea: el medio ambiente

El “entorno” significa el contexto o sistema externo donde opera el agente. En esencia, constituye todo factor que está más allá del control del agente, pero que aún es observable. Esto podría variar desde una interfaz de juego virtual hasta un entorno del mundo real, como un robot navegando por un laberinto. El entorno es la "verdad fundamental" contra la cual se evalúa el desempeño del agente.

Navegando por las transiciones: cambios de estado

En la jerga del aprendizaje por refuerzo, "estado" o denotado por "s", describe los diferentes escenarios en los que podría encontrarse el agente mientras interactúa con el entorno. Estas transiciones estatales son fundamentales; informan las observaciones del agente e influyen fuertemente en sus futuros mecanismos de toma de decisiones.

El libro de reglas de decisión: política

El término “política” encapsula la estrategia del agente para seleccionar acciones correspondientes a diferentes estados. Sirve como una función que mapea desde el dominio de los estados a un conjunto de acciones, definiendo el modus operandi del agente en su búsqueda para lograr sus objetivos.

Refinamiento a lo largo del tiempo: actualizaciones de políticas

“Actualización de políticas” se refiere al proceso iterativo de modificar la política existente del agente. Este es un aspecto dinámico del aprendizaje por refuerzo, que permite al agente optimizar su comportamiento en función de recompensas históricas o experiencias recién adquiridas. Se facilita a través de algoritmos especializados que recalibran la estrategia del agente.

El motor de la adaptación: algoritmos de aprendizaje

Los algoritmos de aprendizaje proporcionan el marco matemático que permite al agente perfeccionar su política. Dependiendo del contexto, estos algoritmos se pueden clasificar ampliamente en métodos sin modelos, que aprenden directamente de interacciones del mundo real, y técnicas basadas en modelos que aprovechan un modelo simulado del entorno para el aprendizaje.

La medida del éxito: recompensas

Por último, las “recompensas” son métricas cuantificables, proporcionadas por el entorno, que miden la eficacia inmediata de una acción realizada por el agente. El objetivo general del agente es maximizar la suma de estas recompensas durante un período, lo que efectivamente sirve como métrica de desempeño.

En pocas palabras, el aprendizaje por refuerzo se puede resumir en una interacción continua entre el agente y su entorno. El agente atraviesa distintos estados, toma decisiones basadas en una política específica y recibe recompensas que actúan como retroalimentación. Se implementan algoritmos de aprendizaje para ajustar iterativamente esta política, asegurando que el agente esté siempre en una trayectoria hacia un comportamiento optimizado dentro de las limitaciones de su entorno.

La sinergia: la IA generativa se une al aprendizaje por refuerzo

La verdadera magia ocurre cuando la IA generativa se encuentra con el aprendizaje por refuerzo. Los investigadores de IA han estado experimentando e investigando la combinación de estos dos dominios, IA y aprendizaje por refuerzo, para crear sistemas o dispositivos que no solo puedan generar contenido sino también aprender de los comentarios de los usuarios para mejorar su producción y obtener un mejor contenido de IA.

- Generación de contenido inicial: La IA generativa, como GPT-3, genera contenido en función de una entrada o contexto determinado. Este contenido puede ser cualquier cosa, desde artículos hasta arte.

- Bucle de comentarios del usuario: Una vez que el contenido se genera y se presenta al usuario, cualquier comentario proporcionado se convierte en un activo valioso para entrenar aún más el sistema de IA.

- Mecanismo de aprendizaje por refuerzo (RL): Utilizando los comentarios de estos usuarios, los algoritmos de aprendizaje por refuerzo intervienen para evaluar qué partes del contenido se apreciaron y qué partes necesitan perfeccionarse.

- Generación de contenido adaptativo: Informada por este análisis, la IA generativa adapta sus modelos internos para alinearse mejor con las preferencias del usuario. Refina iterativamente su producción, incorporando lecciones aprendidas de cada interacción.

- Fusión de Tecnologías: La combinación de IA generativa y aprendizaje por refuerzo crea un ecosistema dinámico donde el contenido generado sirve como campo de juego para el agente de RL. Los comentarios de los usuarios funcionan como una señal de recompensa, dirigiendo a la IA sobre cómo mejorar.

Esta combinación de IA generativa y aprendizaje por refuerzo permite un sistema altamente adaptable y también capaz de aprender de la retroalimentación del mundo real, por ejemplo, la retroalimentación humana, lo que permite resultados más efectivos y alineados con el usuario y para obtener mejores resultados que se alineen con las necesidades humanas.

Sinergia de fragmentos de código

Entendamos la sinergia entre la IA generativa y el aprendizaje por refuerzo:

import torch

import torch.nn as nn

import torch.optim as optim # Simulated Generative AI model (e.g., a text generator)

class GenerativeAI(nn.Module): def __init__(self): super(GenerativeAI, self).__init__() # Model layers self.fc = nn.Linear(10, 1) # Example layer def forward(self, input): output = self.fc(input) # Generate content, for this example, a number return output # Simulated User Feedback

def user_feedback(content): return torch.rand(1) # Mock user feedback # Reinforcement Learning Update

def rl_update(model, optimizer, reward): loss = -torch.log(reward) optimizer.zero_grad() loss.backward() optimizer.step() # Initialize model and optimizer

gen_model = GenerativeAI()

optimizer = optim.Adam(gen_model.parameters(), lr=0.001) # Iterative improvement

for epoch in range(100): content = gen_model(torch.randn(1, 10)) # Mock input reward = user_feedback(content) rl_update(gen_model, optimizer, reward)

Explicación del código

- Modelo de IA generativa: Es como una máquina que intenta generar contenido, como un generador de texto. En este caso, está diseñado para recibir algunas entradas y producir una salida.

- Comentarios del usuario: Imagine a los usuarios brindando comentarios sobre el contenido que genera la IA. Esta retroalimentación ayuda a la IA a saber qué es bueno o malo. En este código, utilizamos comentarios aleatorios como ejemplo.

- Actualización del aprendizaje por refuerzo: Después de recibir comentarios, la IA se actualiza para mejorar. Ajusta su configuración interna para mejorar la generación de contenido.

- Mejora iterativa: La IA pasa por muchos ciclos (100 veces en este código) de generación de contenido, obtención de comentarios y aprendizaje de ellos. Con el tiempo, mejora en la creación del contenido deseado.

Este código define un modelo básico de IA generativa y un circuito de retroalimentación. La IA genera contenido, recibe comentarios aleatorios y se ajusta a sí misma en más de 100 iteraciones para mejorar sus capacidades de creación de contenido.

En una aplicación del mundo real, se utilizaría un modelo más sofisticado y comentarios de los usuarios más matizados. Sin embargo, este fragmento de código captura la esencia de cómo la IA generativa y el aprendizaje por refuerzo pueden armonizarse para construir un sistema que no solo genera contenido sino que también aprende a mejorarlo en función de la retroalimentación.

Aplicaciones del mundo real

Las posibilidades que surgen de la sinergia de la IA Generativa y el Aprendizaje por Refuerzo son infinitas. Echemos un vistazo a las aplicaciones del mundo real:

Generación de contenido

El contenido creado por IA puede volverse cada vez más personalizado, alineándose con los gustos y preferencias de los usuarios individuales.

Considere un escenario en el que un agente de RL utiliza GPT-3 para generar un servicio de noticias personalizado. Después de leer cada artículo, el usuario proporciona comentarios. Aquí, imaginemos que la retroalimentación es simplemente "me gusta" o "no me gusta", que se transforman en recompensas numéricas.

from transformers import GPT2LMHeadModel, GPT2Tokenizer

import torch # Initialize GPT-2 model and tokenizer

tokenizer = GPT2Tokenizer.from_pretrained('gpt2')

model = GPT2LMHeadModel.from_pretrained('gpt2') # RL update function

def update_model(reward, optimizer): loss = -torch.log(reward) optimizer.zero_grad() loss.backward() optimizer.step() # Initialize optimizer

optimizer = torch.optim.Adam(model.parameters(), lr=0.001) # Example RL loop

for epoch in range(10): input_text = "Generate news article about technology." input_ids = tokenizer.encode(input_text, return_tensors='pt') with torch.no_grad(): output = model.generate(input_ids) article = tokenizer.decode(output[0]) print(f"Generated Article: {article}") # Get user feedback (1 for like, 0 for dislike) reward = float(input("Did you like the article? (1 for yes, 0 for no): ")) update_model(torch.tensor(reward), optimizer)Arte y música

La IA puede generar arte y música que resuenen con las emociones humanas, evolucionando su estilo en función de los comentarios de la audiencia. Un agente de RL podría optimizar los parámetros de un algoritmo de transferencia de estilo neuronal basado en la retroalimentación para crear arte o música que resuene mejor con las emociones humanas.

# Assuming a function style_transfer(image, style) exists

# RL update function similar to previous example # Loop through style transfers

for epoch in range(10): new_art = style_transfer(content_image, style_image) show_image(new_art) reward = float(input("Did you like the art? (1 for yes, 0 for no): ")) update_model(torch.tensor(reward), optimizer)AI conversacional

Chatbots y los asistentes virtuales pueden entablar conversaciones más naturales y conscientes del contexto, lo que los hace increíblemente útiles en el servicio al cliente. Los chatbots pueden emplear el aprendizaje por refuerzo para optimizar sus modelos conversacionales en función del historial de conversaciones y los comentarios de los usuarios.

# Assuming a function chatbot_response(text, model) exists

# RL update function similar to previous examples for epoch in range(10): user_input = input("You: ") bot_response = chatbot_response(user_input, model) print(f"Bot: {bot_response}") reward = float(input("Was the response helpful? (1 for yes, 0 for no): ")) update_model(torch.tensor(reward), optimizer)Vehículos autónomos

Los sistemas de IA en vehículos autónomos pueden aprender de experiencias de conducción del mundo real, mejorando la seguridad y la eficiencia. Un agente de RL en un vehículo autónomo podría ajustar su trayectoria en tiempo real en función de diversas recompensas, como la eficiencia del combustible, el tiempo o la seguridad.

# Assuming a function drive_car(state, policy) exists

# RL update function similar to previous examples for epoch in range(10): state = get_current_state() # e.g., traffic, fuel, etc. action = drive_car(state, policy) reward = get_reward(state, action) # e.g., fuel saved, time taken, etc. update_model(torch.tensor(reward), optimizer)Estos fragmentos de código son ilustrativos y simplificados. Ayudan a manifestar el concepto de que la IA generativa y la RL pueden colaborar para mejorar la experiencia del usuario en varios dominios. Cada fragmento muestra cómo el agente mejora iterativamente su política en función de las recompensas recibidas, de forma similar a cómo se podría mejorar iterativamente un modelo de aprendizaje profundo como Unet para la segmentación de imágenes de radar.

Casos de Estudio

Optimización del diagnóstico y tratamiento sanitario

- Problema: En la atención sanitaria, el diagnóstico preciso y oportuno es fundamental. A menudo resulta difícil para los médicos mantenerse al día con grandes cantidades de literatura médica y las mejores prácticas en evolución.

- Solución: Los modelos de IA generativa como BERT pueden extraer información de textos médicos. Un agente de RL puede optimizar los planes de tratamiento basándose en datos históricos de pacientes e investigaciones emergentes.

- Casos de éxito: Watson for Oncology de IBM utiliza IA generativa y RL para ayudar a los oncólogos a tomar decisiones de tratamiento analizando los registros médicos de un paciente en comparación con una vasta literatura médica. Esto ha mejorado la precisión de las recomendaciones de tratamiento.

Compras minoristas y personalizadas

- Problema: En el comercio electrónico, personalizar las experiencias de compra de los clientes es fundamental para aumentar las ventas.

- Solución: La IA generativa, como GPT-3, puede generar descripciones, reseñas y recomendaciones de productos. Un agente de RL puede optimizar estas recomendaciones en función de las interacciones y los comentarios de los usuarios.

- Casos de éxito: Amazon utiliza IA generativa para generar descripciones de productos y utiliza RL para optimizar las recomendaciones de productos. Esto ha llevado a un aumento significativo en las ventas y la satisfacción del cliente.

Creación de contenido y marketing

- Problema: Los especialistas en marketing necesitan crear contenido atractivo a escala. Es un desafío saber qué resonará en el público.

- Solución: La IA generativa, como GPT-2, puede generar publicaciones de blogs, contenido de redes sociales y textos publicitarios. RL puede optimizar la generación de contenido en función de métricas de participación.

- Casos de éxito: HubSpot, una plataforma de marketing, utiliza IA generativa para ayudar en la creación de contenido. Emplean RL para perfeccionar las estrategias de contenido basadas en la participación del usuario, lo que da como resultado campañas de marketing más efectivas.

Desarrollo de videojuegos

- Problema: Crear personajes no jugadores (NPC) con comportamientos realistas y entornos de juego que se adapten a las acciones de los jugadores es complejo y requiere mucho tiempo.

- Solución: La IA generativa puede diseñar niveles de juego, personajes y diálogos. Los agentes de RL pueden optimizar el comportamiento de los NPC en función de las interacciones de los jugadores.

- Casos de éxito: En la industria de los videojuegos, estudios como Ubisoft utilizan la IA generativa para la construcción de mundos y la RL para la IA de los NPC. Este enfoque ha dado como resultado experiencias de juego más dinámicas y atractivas.

Comercio financiero

- Problema: En el mundo altamente competitivo del comercio financiero, encontrar estrategias rentables puede resultar un desafío.

- Solución: La IA generativa puede ayudar en el análisis de datos y la generación de estrategias. Los agentes de RL pueden aprender y optimizar estrategias comerciales basadas en datos de mercado y objetivos definidos por el usuario.

- Casos de éxito: Los fondos de cobertura como Renaissance Technologies aprovechan la IA generativa y la RL para descubrir algoritmos comerciales rentables. Esto ha dado lugar a importantes retornos de las inversiones.

Estos estudios de caso demuestran cómo la combinación de IA generativa y aprendizaje por refuerzo está transformando varias industrias al automatizar tareas, personalizar experiencias y optimizar los procesos de toma de decisiones.

Consideraciones éticas

Justicia en la IA

Garantizar la equidad en los sistemas de IA es fundamental para evitar sesgos o discriminación. Los modelos de IA deben entrenarse en conjuntos de datos diversos y representativos. Detectar y mitigar los sesgos en los modelos de IA es un desafío constante. Esto es particularmente importante en ámbitos como los préstamos o la contratación, donde los algoritmos sesgados pueden tener graves consecuencias en el mundo real.

Responsabilidad y responsabilidad

A medida que los sistemas de IA continúan avanzando, la rendición de cuentas y la responsabilidad se vuelven centrales. Los desarrolladores, organizaciones y reguladores deben definir líneas claras de responsabilidad. Es necesario establecer directrices y estándares éticos para responsabilizar a las personas y organizaciones de las decisiones y acciones de los sistemas de IA. En el sector sanitario, por ejemplo, la responsabilidad es primordial para garantizar la seguridad del paciente y la confianza en el diagnóstico asistido por IA.

Transparencia y explicabilidad

La naturaleza de “caja negra” de algunos modelos de IA es motivo de preocupación. Para garantizar una IA ética y responsable, es vital que los procesos de toma de decisiones de la IA sean transparentes y comprensibles. Los investigadores e ingenieros deberían trabajar en el desarrollo de modelos de IA que sean explicables y proporcionen información sobre por qué se tomó una decisión específica. Esto es crucial para áreas como la justicia penal, donde las decisiones tomadas por los sistemas de inteligencia artificial pueden afectar significativamente la vida de las personas.

Privacidad de datos y consentimiento

Respetar la privacidad de los datos es una piedra angular de la IA ética. Los sistemas de inteligencia artificial a menudo dependen de los datos de los usuarios, y es fundamental obtener el consentimiento informado para el uso de los datos. Los usuarios deben tener control sobre sus datos y deben existir mecanismos para salvaguardar la información confidencial. Esta cuestión es particularmente importante en los sistemas de personalización basados en IA, como los motores de recomendación y los asistentes virtuales.

Mitigación de daños

Los sistemas de IA deben diseñarse para evitar la creación de información dañina, engañosa o falsa. Esto es particularmente relevante en el ámbito de la generación de contenidos. Los algoritmos no deben generar contenido que promueva discursos de odio, información errónea o comportamientos dañinos. Unas directrices y un seguimiento más estrictos son esenciales en las plataformas donde prevalece el contenido generado por los usuarios.

Supervisión humana y experiencia ética

La supervisión humana sigue siendo crucial. Incluso a medida que la IA se vuelve más autónoma, los expertos humanos en diversos campos deberían trabajar en conjunto con la IA. Pueden emitir juicios éticos, perfeccionar los sistemas de inteligencia artificial e intervenir cuando sea necesario. Por ejemplo, en los vehículos autónomos, un conductor humano de seguridad debe estar preparado para tomar el control en situaciones complejas o imprevistas.

Estas consideraciones éticas están a la vanguardia del desarrollo y la implementación de la IA, garantizando que las tecnologías de IA beneficien a la sociedad y al mismo tiempo respeten los principios de justicia, responsabilidad y transparencia. Abordar estos problemas es fundamental para la integración responsable y ética de la IA en nuestras vidas.

Conclusión

Estamos siendo testigos de una era apasionante en la que la IA generativa y el aprendizaje por refuerzo están empezando a fusionarse. Esta convergencia está abriendo un camino hacia sistemas de IA automejorados, capaces tanto de creación innovadora como de toma de decisiones efectiva. Sin embargo, un gran poder conlleva una gran responsabilidad. Los rápidos avances en la IA conllevan consideraciones éticas que son cruciales para su implementación responsable. A medida que nos embarcamos en este viaje de crear una IA que no solo comprenda sino que también aprenda y se adapte, abrimos posibilidades ilimitadas para la innovación. No obstante, es vital avanzar con integridad ética, garantizando que la tecnología que creamos sirva como una fuerza para el bien, beneficiando a la humanidad en su conjunto.

Puntos clave

- La IA generativa y el aprendizaje por refuerzo (RL) están convergiendo para crear sistemas de mejora personal, centrándose la primera en la generación de contenidos y el segundo en la toma de decisiones mediante prueba y error.

- En RL, los componentes clave incluyen el agente, que toma decisiones; el entorno con el que interactúa el agente; y recompensas, que sirven como métricas de desempeño. Las políticas y los algoritmos de aprendizaje permiten que el agente mejore con el tiempo.

- La unión de IA generativa y RL permite sistemas que generan contenido y se adaptan en función de los comentarios de los usuarios, mejorando así su rendimiento de forma iterativa.

- Un fragmento de código de Python ilustra esta sinergia al combinar un modelo de IA generativa simulado para la generación de contenido con RL para optimizar en función de los comentarios de los usuarios.

- Las aplicaciones del mundo real son amplias, incluida la generación de contenido personalizado, la creación de arte y música, la IA conversacional e incluso los vehículos autónomos.

- Estas tecnologías combinadas podrían revolucionar la forma en que la IA interactúa y se adapta a las necesidades y preferencias humanas, dando lugar a soluciones más personalizadas y efectivas.

Preguntas frecuentes

R. La combinación de IA generativa y aprendizaje por refuerzo crea sistemas inteligentes que no solo generan nuevos datos sino que también optimizan su efectividad. Esta relación sinérgica amplía el alcance y la eficiencia de las aplicaciones de IA, haciéndolas más versátiles y adaptables.

R. El aprendizaje por refuerzo actúa como núcleo de toma de decisiones del sistema. Al emplear un circuito de retroalimentación centrado en recompensas, evalúa y adapta el contenido generado desde el módulo de IA generativa. Este proceso iterativo optimiza la estrategia de generación de datos a lo largo del tiempo.

R. Las aplicaciones prácticas son de amplio alcance. En el sector sanitario, esta tecnología puede crear y perfeccionar dinámicamente planes de tratamiento utilizando datos de pacientes en tiempo real. Mientras tanto, en el sector automotriz, podría permitir que los vehículos autónomos ajusten su ruta en tiempo real en respuesta a las condiciones fluctuantes de la carretera.

R. Python sigue siendo el lenguaje de referencia debido a su ecosistema integral. Bibliotecas como TensorFlow y PyTorch se utilizan con frecuencia para tareas de IA generativa, mientras que OpenAI's Gym y TF-Agents de Google son opciones típicas para implementaciones de aprendizaje por refuerzo.

Los medios que se muestran en este artículo no son propiedad de Analytics Vidhya y se utilizan a discreción del autor.

Relacionado:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.analyticsvidhya.com/blog/2023/10/generative-ai-and-reinforcement-learning/