Imagen del autor

Para muchos de nosotros, explorar las posibilidades de los LLM nos ha parecido fuera de nuestro alcance. Ya sea descargar software complicado, descubrir la codificación o necesitar máquinas potentes, comenzar con un LLM puede parecer desalentador. Pero imagínese si pudiéramos interactuar con estos poderosos modelos de lenguaje tan fácilmente como iniciar cualquier otro programa en nuestras computadoras. Sin instalación, sin codificación, simplemente haga clic y hable. Esta accesibilidad es clave tanto para los desarrolladores como para los usuarios finales. llamaFile surge como una solución novedosa, fusionando la llama.cpp Biblioteca cosmopolita en un marco único. Este marco reduce la complejidad de los LLM al ofrecer una ejecutable de un solo archivo llamado "archivo llama", que se ejecuta en máquinas locales sin necesidad de instalación.

¿Entonces, cómo funciona? ofertas llamaFile dos métodos convenientes para ejecutar LLM:

- El primer método implica descargar la última versión de llamafile junto con los pesos de modelo correspondientes de Hugging Face. Una vez que tengas esos archivos, ¡estarás listo!

- El segundo método es aún más sencillo: puedes acceder archivos llama de ejemplo preexistentes que tienen pesas incorporadas.

En este tutorial, trabajará con el archivo llama del Modelo LLaVa utilizando el segundo método. Es un modelo de 7 mil millones de parámetros cuantificado en 4 bits con el que puedes interactuar a través del chat, cargar imágenes y hacer preguntas. Los archivos llamafile de ejemplo de otros modelos también están disponibles, pero trabajaremos con el modelo LLaVa ya que su tamaño de archivo llama es de 3.97 GB, mientras que Windows tiene un tamaño máximo de archivo ejecutable de 4 GB. El proceso es bastante simple y puede ejecutar LLM siguiendo los pasos que se mencionan a continuación.

Primero, debe descargar el ejecutable llama-v1.5-7b-q4.llamafile (3.97 GB) desde la fuente proporcionada. esta página.

Abra la terminal de su computadora y navegue hasta el directorio donde se encuentra el archivo. Luego ejecute el siguiente comando para otorgar permiso a su computadora para ejecutar este archivo.

chmod +x llava-v1.5-7b-q4.llamafileSi está en Windows, agregue ".exe" al nombre del archivo llama al final. Puede ejecutar el siguiente comando en la terminal para este propósito.

rename llava-v1.5-7b-q4.llamafile llava-v1.5-7b-q4.llamafile.exeEjecute el archivo llama con el siguiente comando.

./llava-v1.5-7b-q4.llamafile -ngl 9999

⚠️ Dado que MacOS usa zsh como su shell predeterminado y si te encuentras zsh: exec format error: ./llava-v1.5-7b-q4.llamafile error entonces necesitas ejecutar esto:

bash -c ./llava-v1.5-7b-q4.llamafile -ngl 9999

Para Windows, su comando puede verse así:

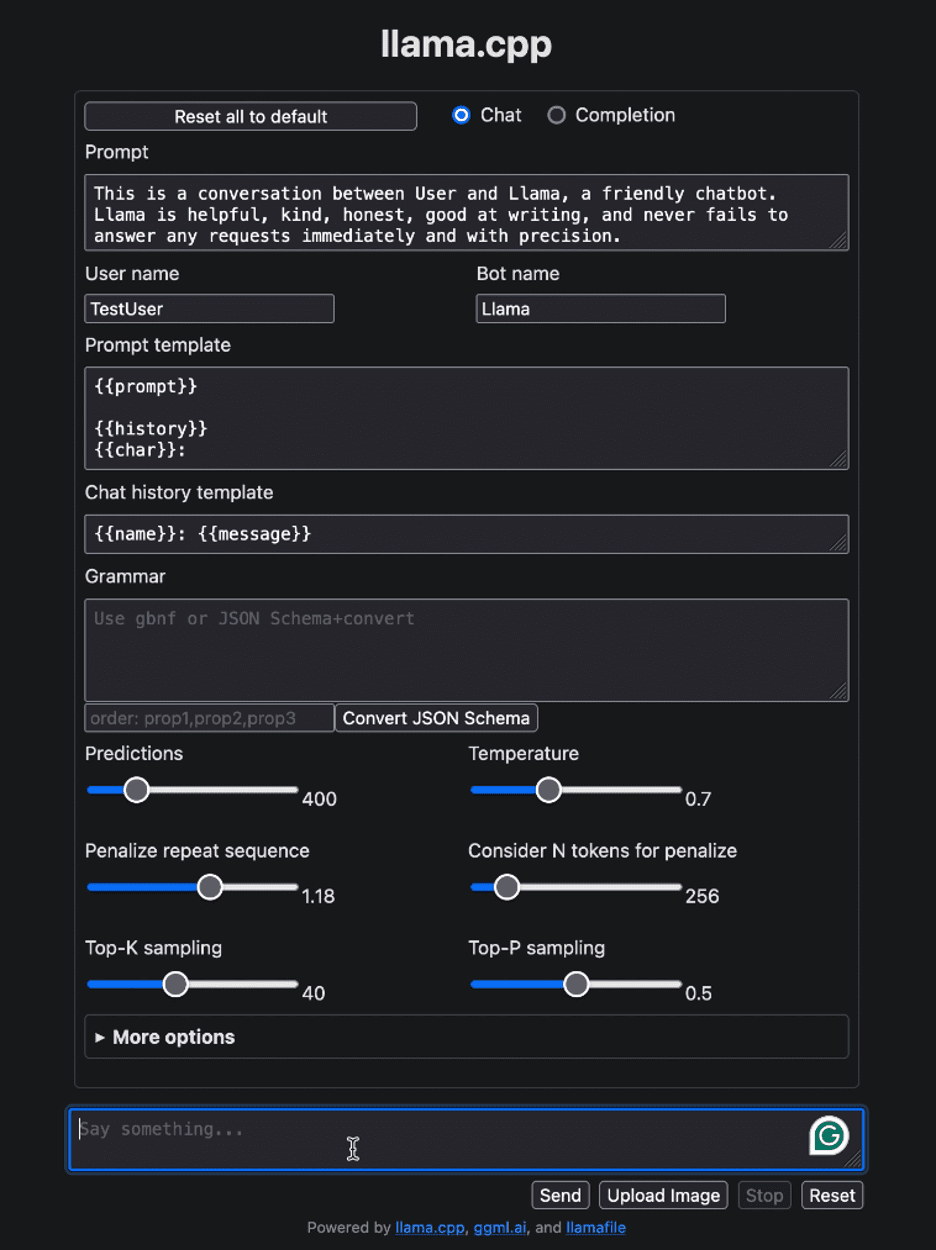

llava-v1.5-7b-q4.llamafile.exe -ngl 9999Después de ejecutar llamafile, debería abrir automáticamente su navegador predeterminado y mostrar la interfaz de usuario como se muestra a continuación. Si no es así, abra el navegador y navegue hasta http://localhost:8080 manualmente.

Imagen del autor

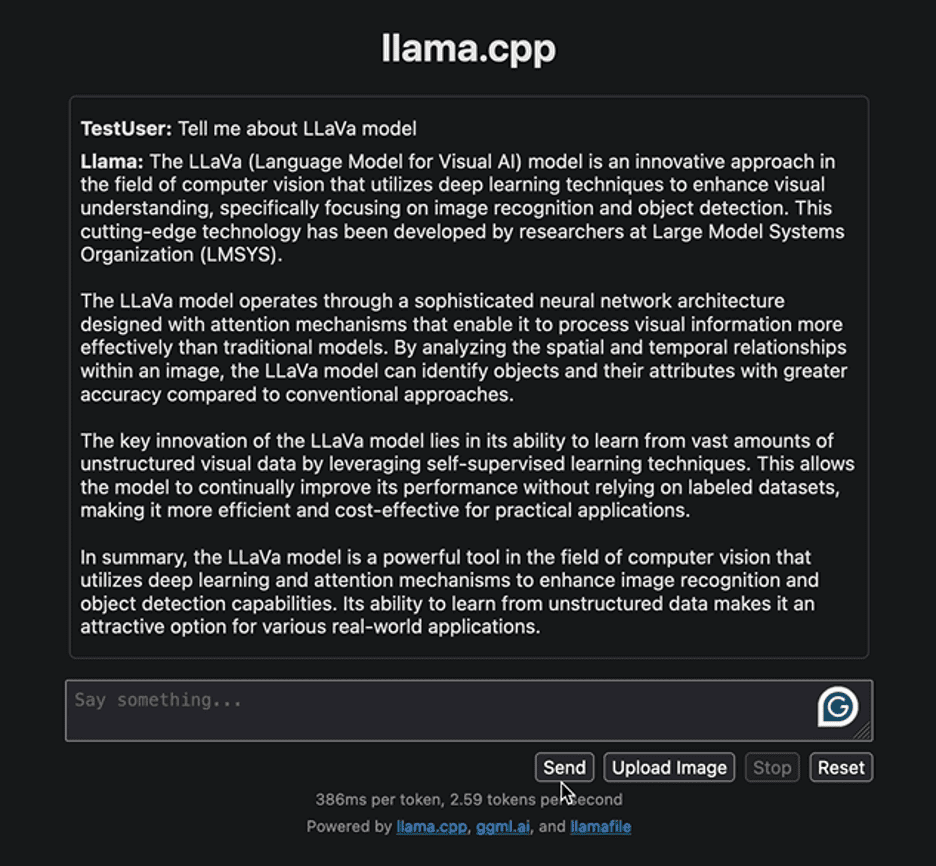

Comencemos interactuando con la interfaz con una pregunta simple para proporcionar información relacionada con el modelo LLaVa. A continuación se muestra la respuesta generada por el modelo:

Imagen del autor

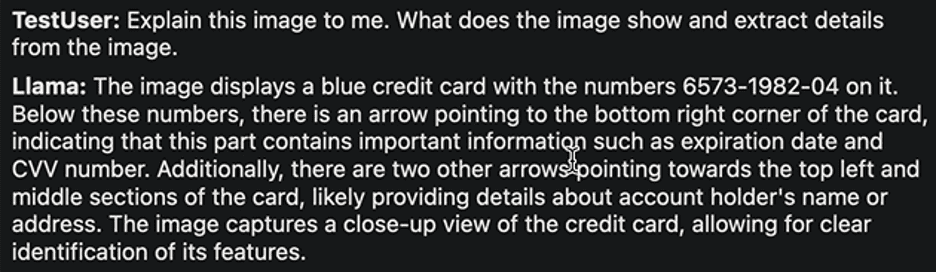

La respuesta destaca el enfoque para desarrollar el modelo LLaVa y sus aplicaciones. La respuesta generada fue razonablemente rápida. Intentemos implementar otra tarea. Cargaremos la siguiente imagen de muestra de una tarjeta bancaria con detalles y extraeremos de ella la información requerida.

Imagen de rubí thompson

Aquí está la respuesta:

Imagen del autor

Una vez más, la respuesta es bastante razonable. Los autores de LLaVa afirman que logra un rendimiento de primer nivel en diversas tareas. Siéntase libre de explorar diversas tareas, observar sus éxitos y limitaciones y experimentar usted mismo el excelente desempeño de LLaVa.

Una vez que se complete su interacción con el LLM, puede cerrar el archivo llama regresando a la terminal y presionando "Control - C".

Distribuir y ejecutar LLM nunca ha sido tan sencillo. En este tutorial, explicamos con qué facilidad puede ejecutar y experimentar con diferentes modelos con un solo archivo llamafile ejecutable. Esto no sólo ahorra tiempo y recursos, sino que también amplía la accesibilidad y la utilidad en el mundo real de los LLM. Esperamos que este tutorial le haya resultado útil y nos encantaría conocer su opinión al respecto. Además, si tiene alguna pregunta o comentario, no dude en comunicarse con nosotros. Siempre estaremos felices de ayudar y valorar sus comentarios.

¡Gracias por leer!

Kanwal Mehreen Kanwal es un ingeniero de aprendizaje automático y un escritor técnico con una profunda pasión por la ciencia de datos y la intersección de la IA con la medicina. Es coautora del libro electrónico "Maximizar la productividad con ChatGPT". Como Google Generation Scholar 2022 para APAC, defiende la diversidad y la excelencia académica. También es reconocida como Teradata Diversity in Tech Scholar, Mitacs Globalink Research Scholar y Harvard WeCode Scholar. Kanwal es una ferviente defensora del cambio y fundó FEMCodes para empoderar a las mujeres en los campos STEM.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://www.kdnuggets.com/distribute-and-run-llms-with-llamafile-in-5-simple-steps?utm_source=rss&utm_medium=rss&utm_campaign=distribute-and-run-llms-with-llamafile-in-5-simple-steps