Εικόνα από συγγραφέα

Για πολλούς από εμάς, η εξερεύνηση των δυνατοτήτων των LLMs φάνηκε απρόσιτη. Είτε πρόκειται για λήψη περίπλοκου λογισμικού, για την εξεύρεση κωδικοποίησης ή για την ανάγκη ισχυρών μηχανημάτων – το να ξεκινήσετε με τα LLM μπορεί να φαίνεται τρομακτικό. Αλλά απλά φανταστείτε, εάν μπορούσαμε να αλληλεπιδράσουμε με αυτά τα ισχυρά μοντέλα γλώσσας τόσο εύκολα όσο ξεκινώντας οποιοδήποτε άλλο πρόγραμμα στους υπολογιστές μας. Χωρίς εγκατάσταση, χωρίς κωδικοποίηση, απλώς κάντε κλικ και μιλήστε. Αυτή η προσβασιμότητα είναι βασική τόσο για τους προγραμματιστές όσο και για τους τελικούς χρήστες. Το llamaFile εμφανίζεται ως μια νέα λύση, συγχωνεύοντας το καλέστε.cpp με Cosmopolitan Libc σε ένα ενιαίο πλαίσιο. Αυτό το πλαίσιο μειώνει την πολυπλοκότητα των LLM προσφέροντας α ένα εκτελέσιμο αρχείο που ονομάζεται "αρχείο λάμα", το οποίο λειτουργεί σε τοπικά μηχανήματα χωρίς να χρειάζεται εγκατάσταση.

Πως λειτουργεί, λοιπόν? llamaFile προσφέρει δύο βολικές μέθοδοι για την εκτέλεση LLM:

- Η πρώτη μέθοδος περιλαμβάνει τη λήψη της τελευταίας έκδοσης του llamafile μαζί με τα αντίστοιχα βάρη μοντέλου από το Hugging Face. Μόλις έχετε αυτά τα αρχεία, είστε έτοιμοι!

- Η δεύτερη μέθοδος είναι ακόμα πιο απλή - μπορείτε να έχετε πρόσβαση προϋπάρχοντα παραδείγματα llamafiles που έχουν ενσωματωμένα βάρη.

Σε αυτό το σεμινάριο, θα εργαστείτε με το llamafile του Μοντέλο LLaVa χρησιμοποιώντας τη δεύτερη μέθοδο. Είναι ένα μοντέλο παραμέτρων 7 δισεκατομμυρίων που έχει κβαντιστεί σε 4 bit με τα οποία μπορείτε να αλληλεπιδράσετε μέσω συνομιλίας, να ανεβάσετε εικόνες και να κάνετε ερωτήσεις. Τα παραδείγματα llamafiles άλλων μοντέλων είναι επίσης διαθέσιμα, αλλά θα εργαστούμε με το μοντέλο LLaVa καθώς το μέγεθος του αρχείου llamafi είναι 3.97 GB, ενώ τα Windows έχουν μέγιστο μέγεθος εκτελέσιμου αρχείου 4 GB. Η διαδικασία είναι αρκετά απλή και μπορείτε να εκτελέσετε LLM ακολουθώντας τα βήματα που αναφέρονται παρακάτω.

Πρώτα, πρέπει να κατεβάσετε το εκτελέσιμο αρχείο llava-v1.5-7b-q4.llamafile (3.97 GB) από την πηγή που παρέχεται εδώ.

Ανοίξτε το τερματικό του υπολογιστή σας και μεταβείτε στον κατάλογο όπου βρίσκεται το αρχείο. Στη συνέχεια, εκτελέστε την ακόλουθη εντολή για να εκχωρήσετε άδεια στον υπολογιστή σας να εκτελέσει αυτό το αρχείο.

chmod +x llava-v1.5-7b-q4.llamafileΕάν χρησιμοποιείτε Windows, προσθέστε ".exe" στο όνομα του αρχείου llamafile στο τέλος. Μπορείτε να εκτελέσετε την ακόλουθη εντολή στο τερματικό για αυτό το σκοπό.

rename llava-v1.5-7b-q4.llamafile llava-v1.5-7b-q4.llamafile.exeΕκτελέστε το αρχείο λάμα με την ακόλουθη εντολή.

./llava-v1.5-7b-q4.llamafile -ngl 9999

⚠️ Δεδομένου ότι το MacOS χρησιμοποιεί το zsh ως προεπιλεγμένο κέλυφος και εάν τρέχετε απέναντι zsh: exec format error: ./llava-v1.5-7b-q4.llamafile σφάλμα τότε πρέπει να εκτελέσετε αυτό:

bash -c ./llava-v1.5-7b-q4.llamafile -ngl 9999

Για Windows, η εντολή σας μπορεί να μοιάζει με αυτό:

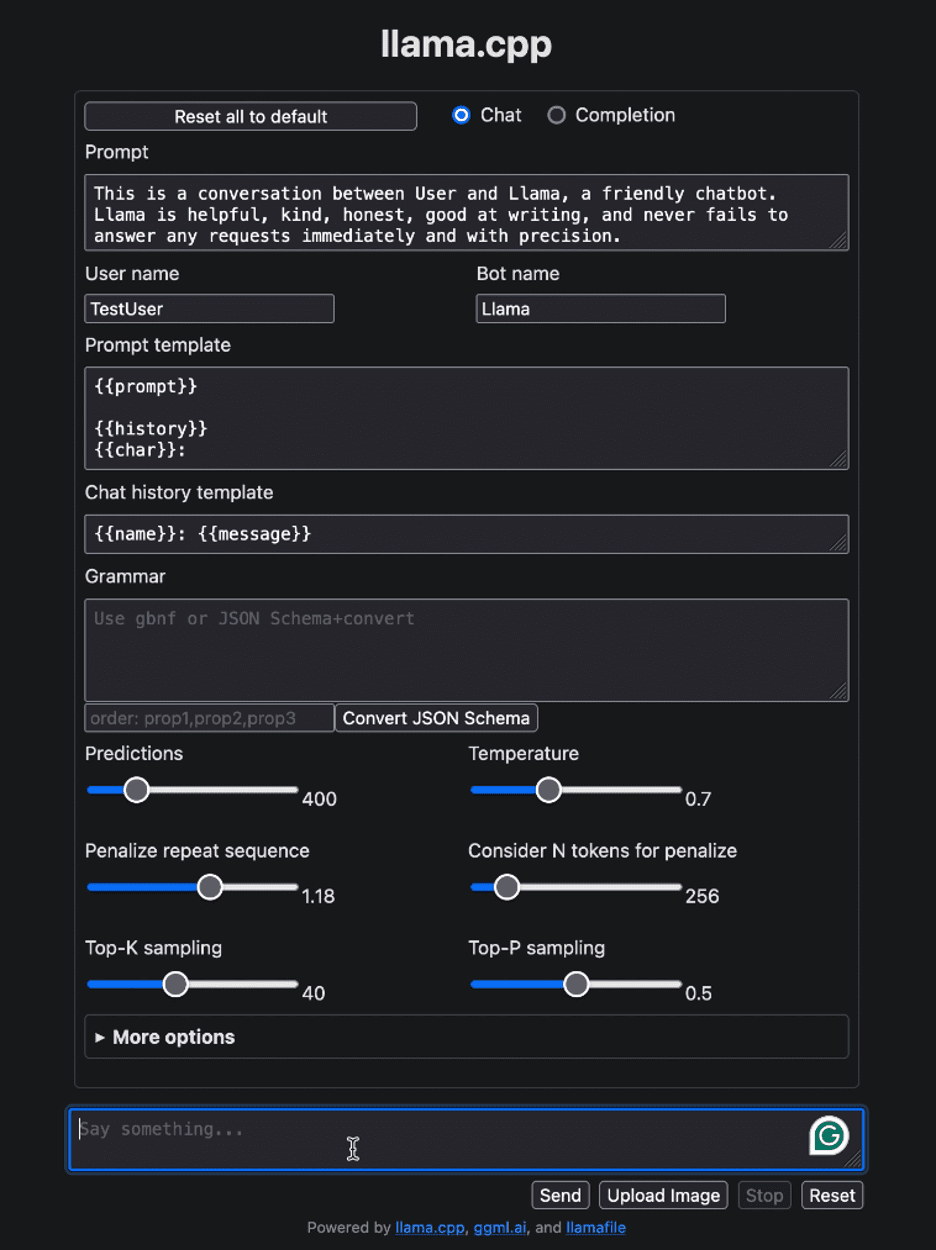

llava-v1.5-7b-q4.llamafile.exe -ngl 9999Μετά την εκτέλεση του llamafile, θα πρέπει να ανοίξει αυτόματα το προεπιλεγμένο πρόγραμμα περιήγησής σας και να εμφανίσει τη διεπαφή χρήστη όπως φαίνεται παρακάτω. Εάν δεν το κάνει, ανοίξτε το πρόγραμμα περιήγησης και μεταβείτε στο http://localhost:8080 χειροκίνητα.

Εικόνα από συγγραφέα

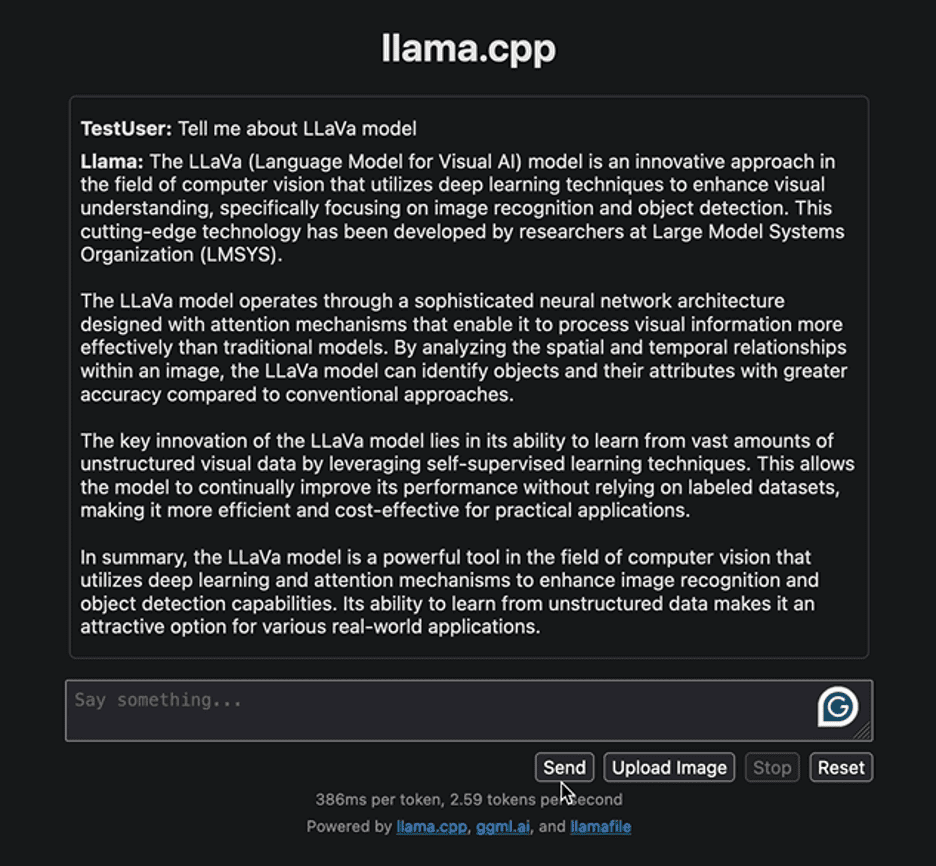

Ας ξεκινήσουμε αλληλεπιδρώντας με τη διεπαφή με μια απλή ερώτηση για να παρέχουμε κάποιες πληροφορίες σχετικά με το μοντέλο LLaVa. Παρακάτω είναι η απάντηση που δημιουργείται από το μοντέλο:

Εικόνα από συγγραφέα

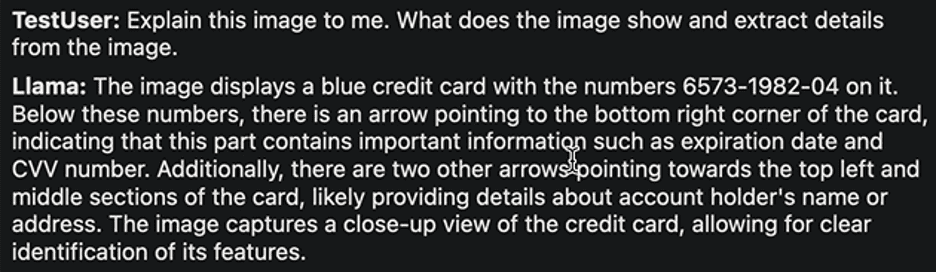

Η απάντηση υπογραμμίζει την προσέγγιση για την ανάπτυξη του μοντέλου LLaVa και των εφαρμογών του. Η απόκριση που δημιουργήθηκε ήταν σχετικά γρήγορη. Ας προσπαθήσουμε να εφαρμόσουμε μια άλλη εργασία. Θα ανεβάσουμε το παρακάτω δείγμα εικόνας μιας τραπεζικής κάρτας με λεπτομέρειες και θα εξαγάγουμε τις απαιτούμενες πληροφορίες από αυτήν.

Εικόνα από Ρούμπι Τόμσον

Ιδού η απάντηση:

Εικόνα από συγγραφέα

Και πάλι, η ανταπόκριση είναι αρκετά λογική. Οι συντάκτες του LLaVa ισχυρίζονται ότι επιτυγχάνει κορυφαία απόδοση σε διάφορες εργασίες. Μη διστάσετε να εξερευνήσετε διάφορες εργασίες, να παρατηρήσετε τις επιτυχίες και τους περιορισμούς τους και να ζήσετε μόνοι σας την εξαιρετική απόδοση του LLaVa.

Μόλις ολοκληρωθεί η αλληλεπίδρασή σας με το LLM, μπορείτε να τερματίσετε τη λειτουργία του αρχείου λάμα επιστρέφοντας στο τερματικό και πατώντας «Control – C».

Η διανομή και η εκτέλεση LLM δεν ήταν ποτέ πιο απλή. Σε αυτό το σεμινάριο, εξηγήσαμε πόσο εύκολα μπορείτε να εκτελέσετε και να πειραματιστείτε με διαφορετικά μοντέλα με ένα μόνο εκτελέσιμο αρχείο llamafile. Αυτό όχι μόνο εξοικονομεί χρόνο και πόρους, αλλά επεκτείνει επίσης την προσβασιμότητα και την πραγματική χρησιμότητα των LLM. Ελπίζουμε ότι βρήκατε αυτό το σεμινάριο χρήσιμο και θα θέλαμε να ακούσουμε τις σκέψεις σας για αυτό. Επιπλέον, εάν έχετε οποιεσδήποτε ερωτήσεις ή σχόλια, μη διστάσετε να επικοινωνήσετε μαζί μας. Είμαστε πάντα στην ευχάριστη θέση να βοηθήσουμε και να εκτιμήσουμε τη συμβολή σας.

Ευχαριστούμε που το διαβάσατε!

Kanwal Mehreen Ο Kanwal είναι μηχανικός μηχανικής μάθησης και τεχνικός συγγραφέας με βαθύ πάθος για την επιστήμη των δεδομένων και τη διασταύρωση της τεχνητής νοημοσύνης με την ιατρική. Συνέγραψε το ebook «Μεγιστοποίηση της παραγωγικότητας με το ChatGPT». Ως υπότροφος Google Generation 2022 για το APAC, υπερασπίζεται τη διαφορετικότητα και την ακαδημαϊκή αριστεία. Έχει επίσης αναγνωριστεί ως υπότροφος Teradata Diversity in Tech, Mitacs Globalink Research Scholar και Harvard WeCode Scholar. Ο Kanwal είναι ένθερμος υποστηρικτής της αλλαγής, έχοντας ιδρύσει το FEMCodes για να ενδυναμώσει τις γυναίκες στους τομείς STEM.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://www.kdnuggets.com/distribute-and-run-llms-with-llamafile-in-5-simple-steps?utm_source=rss&utm_medium=rss&utm_campaign=distribute-and-run-llms-with-llamafile-in-5-simple-steps