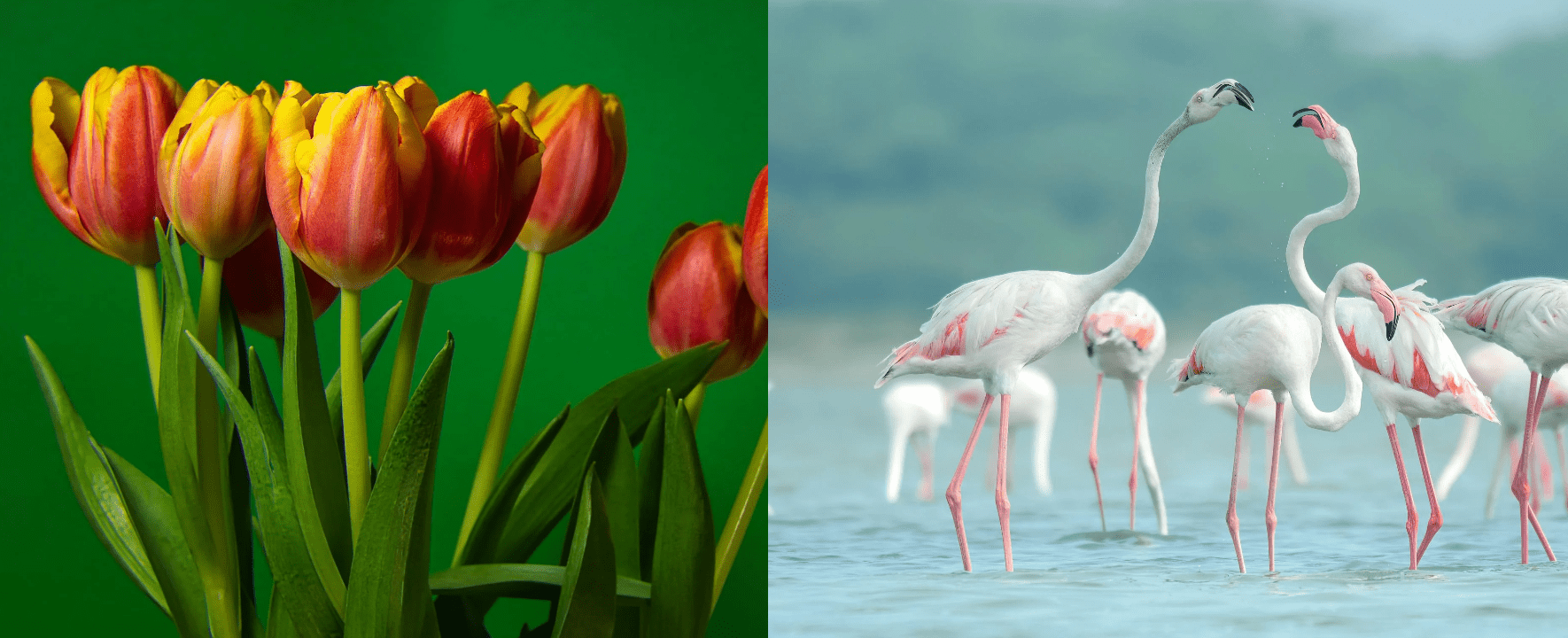

Εικόνα από συγγραφέα

Η Anthropic κυκλοφόρησε πρόσφατα μια νέα σειρά μοντέλων τεχνητής νοημοσύνης που έχουν ξεπεράσει τόσο το GPT-4 όσο και το Gemini σε δοκιμές αναφοράς. Με τη βιομηχανία της τεχνητής νοημοσύνης να αναπτύσσεται και να εξελίσσεται ταχέως, τα μοντέλα Claude 3 κάνουν σημαντικά βήματα ως το επόμενο μεγάλο πράγμα στα μοντέλα μεγάλων γλωσσών (LLM).

Σε αυτήν την ανάρτηση ιστολογίου, θα εξερευνήσουμε τα σημεία αναφοράς απόδοσης των 3 μοντέλων του Claude. Θα μάθουμε επίσης για το νέο API της Python που υποστηρίζει απλή, ασύγχρονη και ροή απόκρισης, μαζί με τις βελτιωμένες δυνατότητες όρασής του.

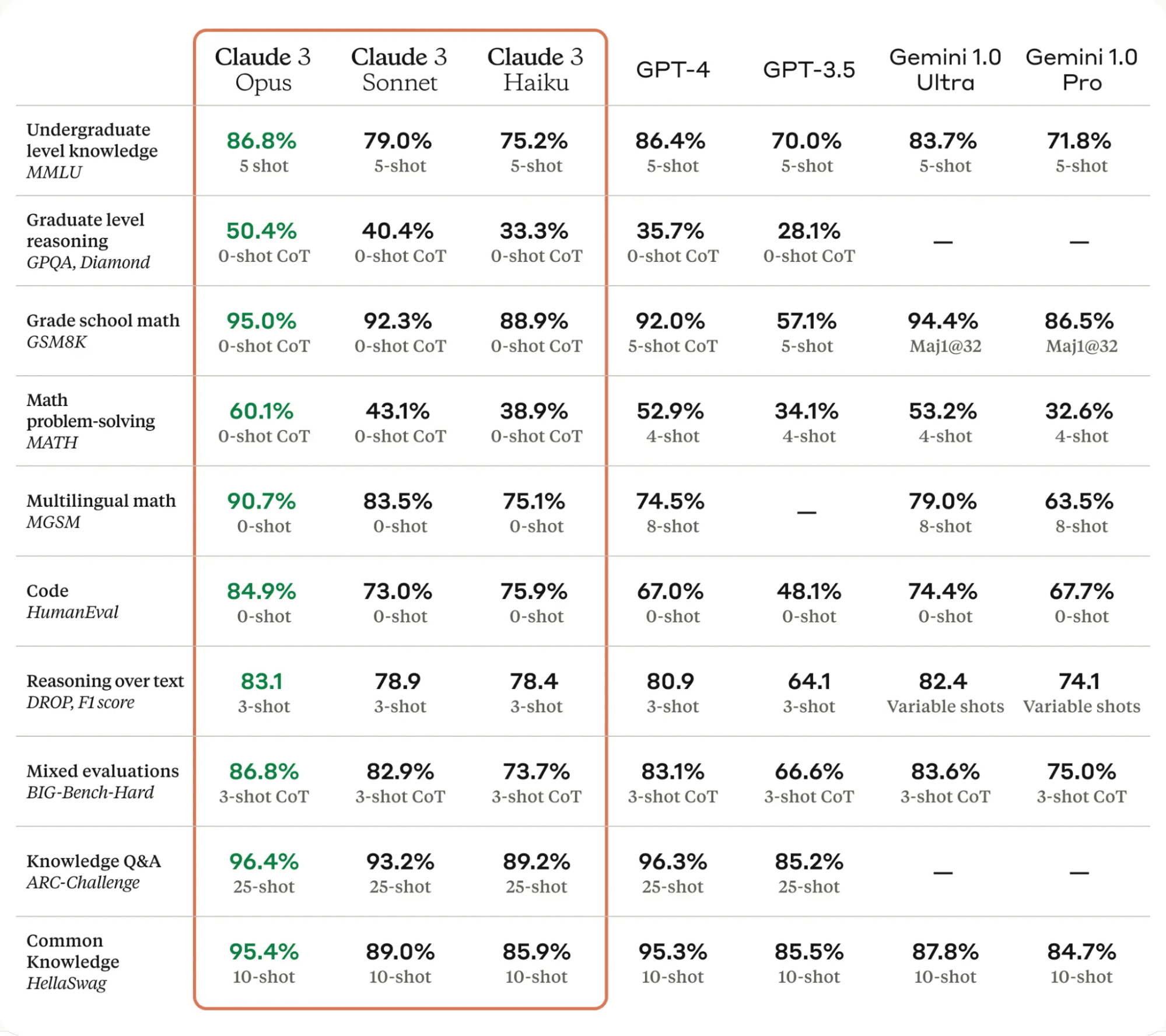

Το Claude 3, είναι ένα σημαντικό άλμα προς τα εμπρός στον τομέα της τεχνολογίας AI. Ξεπερνά τα τελευταίας τεχνολογίας γλωσσικά μοντέλα σε διάφορα κριτήρια αξιολόγησης, συμπεριλαμβανομένων των MMLU, GPQA και GSM8K, επιδεικνύοντας σχεδόν ανθρώπινα επίπεδα κατανόησης και ευχέρειας σε σύνθετες εργασίες.

Τα μοντέλα Claude 3 διατίθενται σε τρεις παραλλαγές: Haiku, Sonnet και Opus, το καθένα με τις μοναδικές του δυνατότητες και δυνάμεις.

- Haiku είναι το πιο γρήγορο και οικονομικό μοντέλο, ικανό να διαβάζει και να επεξεργάζεται ερευνητικές εργασίες με πυκνότητα πληροφοριών σε λιγότερο από τρία δευτερόλεπτα.

- Ασμάτιο είναι 2 φορές ταχύτερος από τον Claude 2 και το 2.1, υπερέχοντας σε εργασίες που απαιτούν γρήγορες απαντήσεις, όπως η ανάκτηση γνώσης ή η αυτοματοποίηση πωλήσεων.

- Έργο προσφέρει παρόμοιες ταχύτητες με τις Claude 2 και 2.1 αλλά με πολύ υψηλότερα επίπεδα νοημοσύνης.

Σύμφωνα με τον παρακάτω πίνακα, το Claude 3 Opus ξεπέρασε τα GPT-4 και Gemini Ultra σε όλα τα σημεία αναφοράς LLM, καθιστώντας το τον νέο ηγέτη στον κόσμο της τεχνητής νοημοσύνης.

Πίνακας από Κλαούντια 3

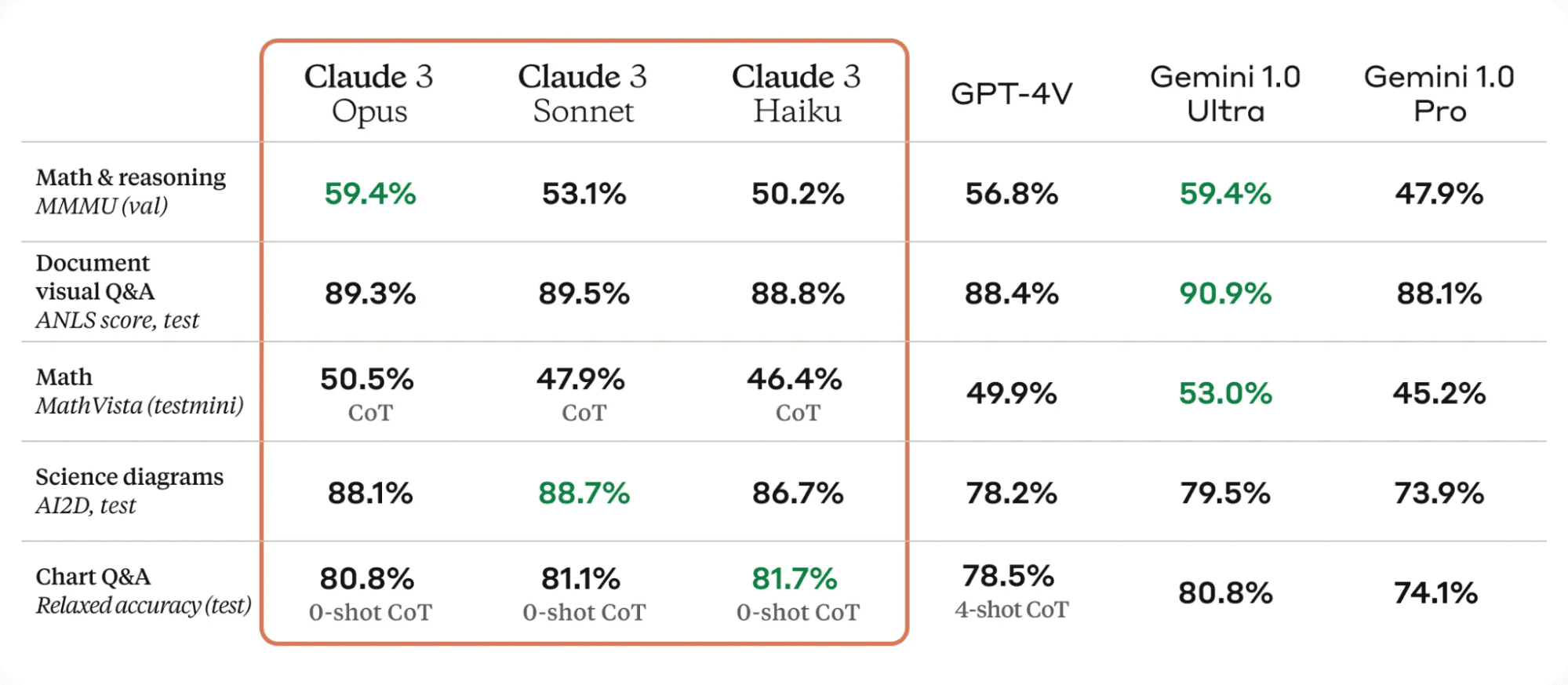

Μία από τις σημαντικές βελτιώσεις στα μοντέλα Claude 3 είναι οι δυνατές τους δυνατότητες όρασης. Μπορούν να επεξεργαστούν διάφορες οπτικές μορφές, συμπεριλαμβανομένων φωτογραφιών, διαγραμμάτων, γραφημάτων και τεχνικών διαγραμμάτων.

Πίνακας από Κλαούντια 3

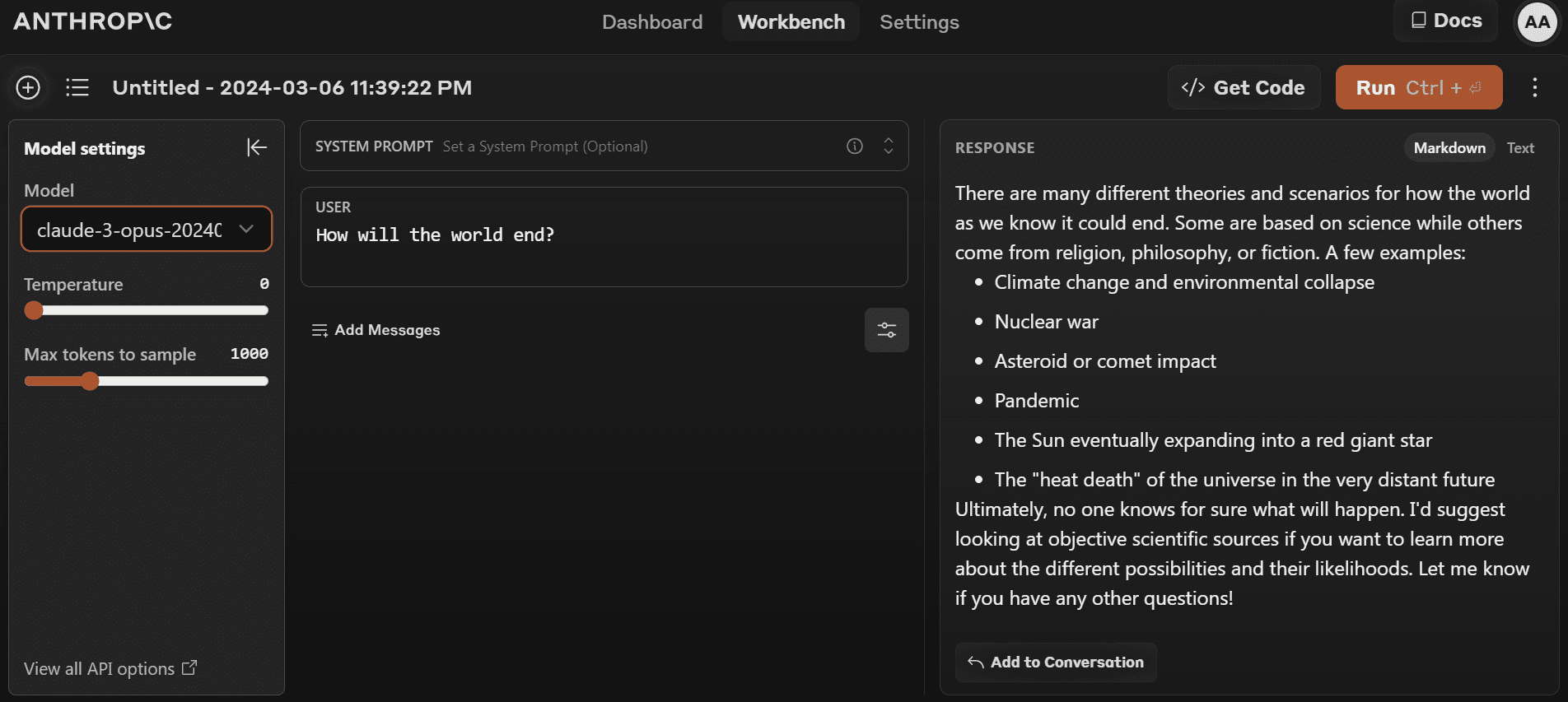

Μπορείτε να ξεκινήσετε να χρησιμοποιείτε το πιο πρόσφατο μοντέλο μεταβαίνοντας στο https://www.anthropic.com/claude και δημιουργία νέου λογαριασμού. Είναι αρκετά απλό σε σύγκριση με την παιδική χαρά OpenAI.

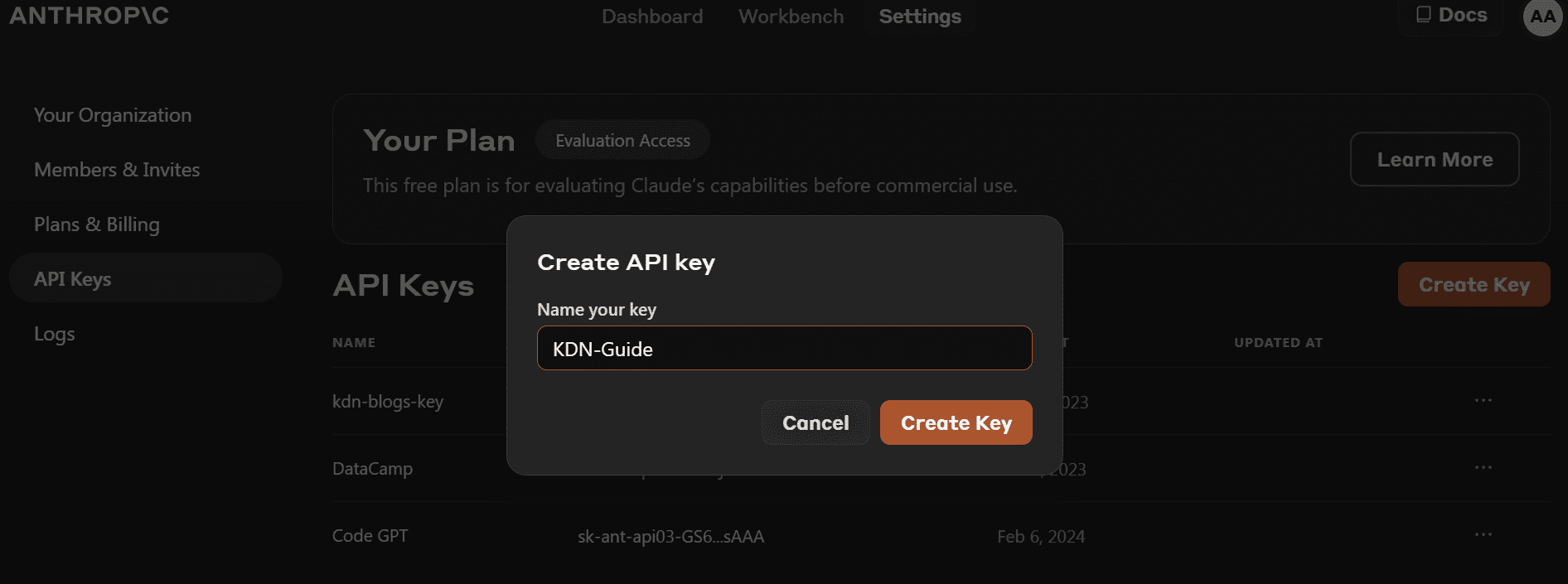

- Πριν εγκαταστήσουμε το πακέτο Python, πρέπει να πάμε στο https://console.anthropic.com/dashboard και λάβετε το κλειδί API.

- Αντί να παρέχετε το κλειδί API απευθείας για τη δημιουργία του αντικειμένου πελάτη, μπορείτε να ορίσετε τη μεταβλητή περιβάλλοντος «ANTHROPIC_API_KEY» και να την παρέχετε ως κλειδί.

- Εγκαταστήστε το πακέτο «anthropic» Python χρησιμοποιώντας PIP.

pip install anthropic- Δημιουργήστε το αντικείμενο πελάτη χρησιμοποιώντας το κλειδί API. Θα χρησιμοποιήσουμε τον πελάτη για δημιουργία κειμένου, δυνατότητα πρόσβασης όρασης και ροή.

import os

import anthropic

from IPython.display import Markdown, display

client = anthropic.Anthropic(

api_key=os.environ["ANTHROPIC_API_KEY"],

)Ας δοκιμάσουμε το παλιό API της Python για να ελέγξουμε αν εξακολουθεί να λειτουργεί ή όχι. Θα παρέχουμε στο API ολοκλήρωσης το όνομα μοντέλου, το μέγιστο μήκος διακριτικού και το μήνυμα προτροπής.

from anthropic import HUMAN_PROMPT, AI_PROMPT

completion = client.completions.create(

model="claude-3-opus-20240229",

max_tokens_to_sample=300,

prompt=f"{HUMAN_PROMPT} How do I cook a original pasta?{AI_PROMPT}",

)

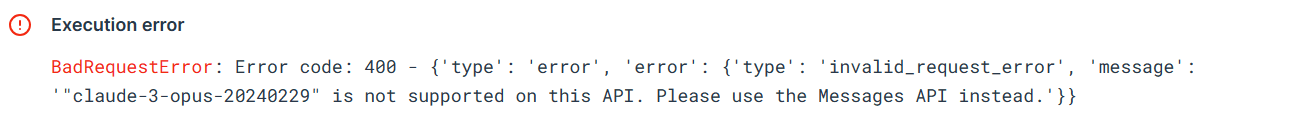

Markdown(completion.completion)Το σφάλμα δείχνει ότι δεν μπορούμε να χρησιμοποιήσουμε το παλιό API για το μοντέλο `claude-3-opus-20240229`. Αντ' αυτού πρέπει να χρησιμοποιήσουμε το Messages API.

Ας χρησιμοποιήσουμε το Messages API για να δημιουργήσουμε την απάντηση. Αντί για προτροπή, πρέπει να παρέχουμε στο όρισμα μηνύματα μια λίστα λεξικών που περιέχει το ρόλο και το περιεχόμενο.

Prompt = "Write the Julia code for the simple data analysis."

message = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1024,

messages=[

{"role": "user", "content": Prompt}

]

)

Markdown(message.content[0].text)Η χρήση του IPython Markdown θα εμφανίσει την απόκριση ως μορφή Markdown. Αυτό σημαίνει ότι θα εμφανίζει σημεία κουκκίδων, μπλοκ κώδικα, επικεφαλίδες και συνδέσμους με καθαρό τρόπο.

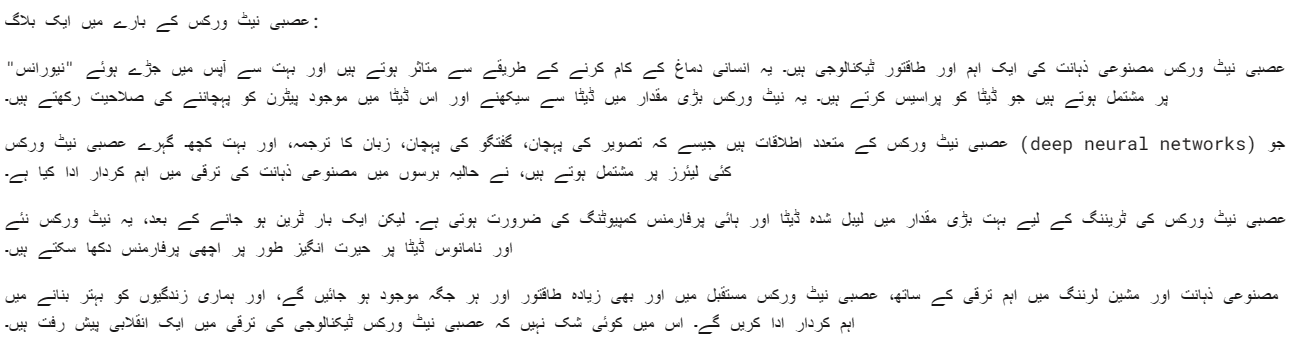

Μπορούμε επίσης να παρέχουμε μια προτροπή συστήματος για να προσαρμόσουμε την απάντησή σας. Στην περίπτωσή μας, ζητάμε από τον Claude 3 Opus να απαντήσει στη γλώσσα Ουρντού.

client = anthropic.Anthropic(

api_key=os.environ["ANTHROPIC_API_KEY"],

)

Prompt = "Write a blog about neural networks."

message = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1024,

system="Respond only in Urdu.",

messages=[

{"role": "user", "content": Prompt}

]

)

Markdown(message.content[0].text)Το μοντέλο Opus είναι αρκετά καλό. Εννοώ ότι μπορώ να το καταλάβω πολύ καθαρά.

Τα σύγχρονα API εκτελούν αιτήματα API διαδοχικά, αποκλείοντας έως ότου ληφθεί μια απάντηση πριν από την κλήση της επόμενης κλήσης. Τα ασύγχρονα API, από την άλλη πλευρά, επιτρέπουν πολλαπλά ταυτόχρονα αιτήματα χωρίς αποκλεισμό, καθιστώντας τα πιο αποτελεσματικά και επεκτάσιμα.

- Πρέπει να δημιουργήσουμε έναν πελάτη Async Anthropic.

- Δημιουργήστε την κύρια λειτουργία με async.

- Δημιουργήστε την απόκριση χρησιμοποιώντας τη σύνταξη αναμονής.

- Εκτελέστε την κύρια συνάρτηση χρησιμοποιώντας τη σύνταξη αναμονής.

import asyncio

from anthropic import AsyncAnthropic

client = AsyncAnthropic(

api_key=os.environ["ANTHROPIC_API_KEY"],

)

async def main() -> None:

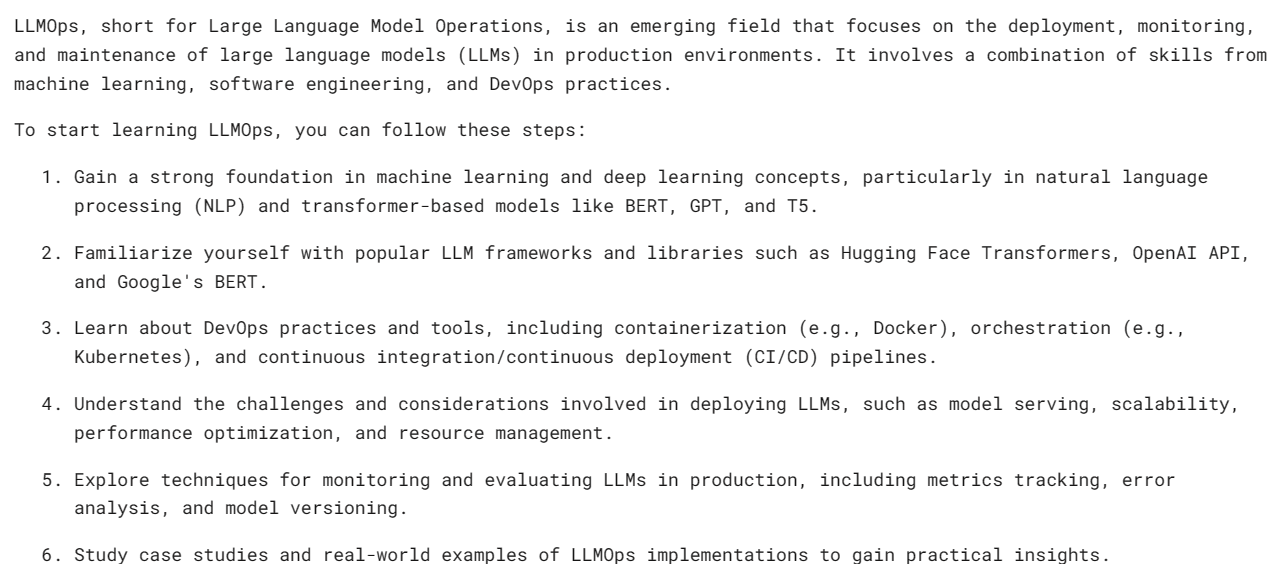

Prompt = "What is LLMOps and how do I start learning it?"

message = await client.messages.create(

max_tokens=1024,

messages=[

{

"role": "user",

"content": Prompt,

}

],

model="claude-3-opus-20240229",

)

display(Markdown(message.content[0].text))

await main()

Σημείωση: Εάν χρησιμοποιείτε το async στο Σημειωματάριο Jupyter, δοκιμάστε να χρησιμοποιήσετε το await main(), αντί για το asyncio.run(main())

Η ροή είναι μια προσέγγιση που επιτρέπει την επεξεργασία των αποτελεσμάτων ενός γλωσσικού μοντέλου μόλις γίνει διαθέσιμο, χωρίς να περιμένει την πλήρη απάντηση. Αυτή η μέθοδος ελαχιστοποιεί την αντιληπτή καθυστέρηση επιστρέφοντας το διακριτικό εξόδου ανά διακριτικό, αντί για όλα ταυτόχρονα.

Αντί για "messages.create", θα χρησιμοποιήσουμε το "messages.stream" για ροή απόκρισης και θα χρησιμοποιήσουμε έναν βρόχο για να εμφανίσουμε πολλές λέξεις από την απάντηση μόλις είναι διαθέσιμες.

from anthropic import Anthropic

client = anthropic.Anthropic(

api_key=os.environ["ANTHROPIC_API_KEY"],

)

Prompt = "Write a mermaid code for typical MLOps workflow."

completion = client.messages.stream(

max_tokens=1024,

messages=[

{

"role": "user",

"content": Prompt,

}

],

model="claude-3-opus-20240229",

)

with completion as stream:

for text in stream.text_stream:

print(text, end="", flush=True)Όπως μπορούμε να δούμε, δημιουργούμε την ανταπόκριση αρκετά γρήγορα.

Μπορούμε να χρησιμοποιήσουμε μια λειτουργία async και με τη ροή. Απλά πρέπει να είσαι δημιουργικός και να τα συνδυάζεις.

import asyncio

from anthropic import AsyncAnthropic

client = AsyncAnthropic()

async def main() -> None:

completion = client.messages.stream(

max_tokens=1024,

messages=[

{

"role": "user",

"content": Prompt,

}

],

model="claude-3-opus-20240229",

)

async with completion as stream:

async for text in stream.text_stream:

print(text, end="", flush=True)

await main()

Το Claude 3 Vision έχει βελτιωθεί με την πάροδο του χρόνου και για να λάβετε την απάντηση, πρέπει απλώς να παρέχετε τον τύπο εικόνας base64 στο API μηνυμάτων.

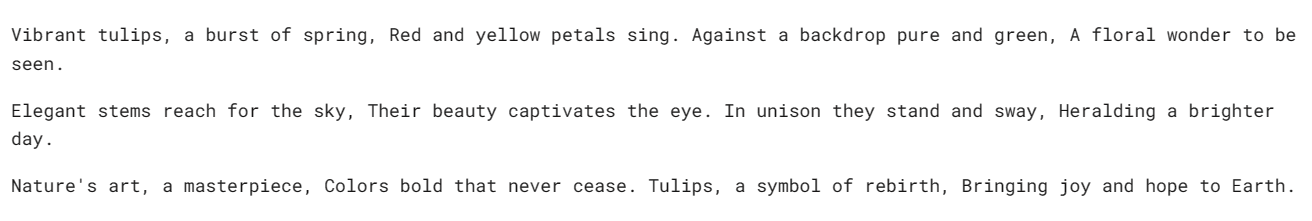

Σε αυτό το παράδειγμα, θα χρησιμοποιήσουμε τουλίπες (Εικόνα 1) και Flamingos (Εικόνα 2) φωτογραφίες από το Pexel.com για να δημιουργήσετε την απάντηση κάνοντας ερωτήσεις σχετικά με την εικόνα.

Θα χρησιμοποιήσουμε τη βιβλιοθήκη `httpx` για να ανακτήσουμε και τις δύο εικόνες από το pexel.com και να τις μετατρέψουμε σε κωδικοποίηση base64.

import anthropic

import base64

import httpx

client = anthropic.Anthropic()

media_type = "image/jpeg"

img_url_1 = "https://images.pexels.com/photos/20230232/pexels-photo-20230232/free-photo-of-tulips-in-a-vase-against-a-green-background.jpeg"

image_data_1 = base64.b64encode(httpx.get(img_url_1).content).decode("utf-8")

img_url_2 = "https://images.pexels.com/photos/20255306/pexels-photo-20255306/free-photo-of-flamingos-in-the-water.jpeg"

image_data_2 = base64.b64encode(httpx.get(img_url_2).content).decode("utf-8")Παρέχουμε εικόνες με κωδικοποίηση base64 στο API μηνυμάτων σε μπλοκ περιεχομένου εικόνας. Ακολουθήστε το μοτίβο κωδικοποίησης που φαίνεται παρακάτω για να δημιουργήσετε με επιτυχία την απάντηση.

message = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1024,

messages=[

{

"role": "user",

"content": [

{

"type": "image",

"source": {

"type": "base64",

"media_type": media_type,

"data": image_data_1,

},

},

{

"type": "text",

"text": "Write a poem using this image."

}

],

}

],

)

Markdown(message.content[0].text)Έχουμε ένα όμορφο ποίημα για τις τουλίπες.

Ας προσπαθήσουμε να φορτώσουμε πολλές εικόνες στο ίδιο API μηνυμάτων Claude 3.

message = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1024,

messages=[

{

"role": "user",

"content": [

{

"type": "text",

"text": "Image 1:"

},

{

"type": "image",

"source": {

"type": "base64",

"media_type": media_type,

"data": image_data_1,

},

},

{

"type": "text",

"text": "Image 2:"

},

{

"type": "image",

"source": {

"type": "base64",

"media_type": media_type,

"data": image_data_2,

},

},

{

"type": "text",

"text": "Write a short story using these images."

}

],

}

],

)

Markdown(message.content[0].text)Έχουμε μια σύντομη ιστορία για έναν κήπο με τουλίπες και φλαμίνγκο.

Εάν αντιμετωπίζετε προβλήματα με την εκτέλεση του κώδικα, εδώ είναι ένα Deepnote χώρο εργασίας όπου μπορείτε να ελέγξετε και να εκτελέσετε μόνοι σας τον κώδικα.

Νομίζω ότι το Claude 3 Opus είναι ένα πολλά υποσχόμενο μοντέλο, αν και μπορεί να μην είναι τόσο γρήγορο όσο το GPT-4 και το Gemini. Πιστεύω ότι οι χρήστες επί πληρωμή μπορεί να έχουν καλύτερες ταχύτητες.

Σε αυτό το σεμινάριο, μάθαμε για τη νέα σειρά μοντέλων από την Anthropic που ονομάζεται Claude 3, εξετάσαμε το σημείο αναφοράς της και δοκιμάσαμε τις δυνατότητες όρασής της. Μάθαμε επίσης να δημιουργούμε απαντήσεις απλές, ασύγχρονες και ροής. Είναι πολύ νωρίς για να πούμε αν είναι το καλύτερο LLM εκεί έξω, αλλά αν δούμε τα επίσημα σημεία αναφοράς δοκιμών, έχουμε έναν νέο βασιλιά στο θρόνο της AI.

Αμπίντ Αλί Αουάν (@1abidaliawan) είναι πιστοποιημένος επαγγελματίας επιστήμονας δεδομένων που λατρεύει την κατασκευή μοντέλων μηχανικής μάθησης. Επί του παρόντος, εστιάζει στη δημιουργία περιεχομένου και στη σύνταξη τεχνικών ιστολογίων για τη μηχανική μάθηση και τις τεχνολογίες επιστήμης δεδομένων. Ο Abid είναι κάτοχος μεταπτυχιακού τίτλου στη Διοίκηση Τεχνολογίας και πτυχίου στη Μηχανική Τηλεπικοινωνιών. Το όραμά του είναι να δημιουργήσει ένα προϊόν τεχνητής νοημοσύνης χρησιμοποιώντας ένα νευρωνικό δίκτυο γραφημάτων για μαθητές που παλεύουν με ψυχικές ασθένειες.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://www.kdnuggets.com/getting-started-with-claude-3-opus-that-just-destroyed-gpt-4-and-gemini?utm_source=rss&utm_medium=rss&utm_campaign=getting-started-with-claude-3-opus-that-just-destroyed-gpt-4-and-gemini