Bild vom Autor

Die Large Language Models (LLM) spielen derzeit verrückt. Wenn Sie als Organisation jedoch nicht über die richtigen Ressourcen verfügen, kann es schwierig sein, auf die große Welle von Sprachmodellen aufzuspringen. Das Trainieren und Bereitstellen großer Sprachmodelle kann schwierig sein und Sie fühlen sich plötzlich ausgeschlossen. Open-Source-LLMs wie die LLaMA-Reihe von Meta haben die Verfügbarkeit von LLM-Ressourcen ermöglicht.

Und zur Open-Source-Sammlung hinzuzufügen ist MosaikML-Grundlagen' neueste Ergänzung ihrer Serie – MPT-7B.

MPT steht für „MosaicML Pretrained Transformer“. MPT-Modelle sind reine GPT-Decoder-Transformatoren mit vielen Verbesserungen:

- Leistungsoptimierte Layer-Implementierungen

- Größere Trainingsstabilität aufgrund von Architekturänderungen

- Keine Einschränkungen hinsichtlich der Kontextlänge

MPT-7B ist ein Transformatormodell, das von Grund auf mit 1T-Tokens aus Text und Code trainiert wurde. Ja, 1 Billion! Das Training erfolgte auf der Plattform „MosaicML“ in einem Zeitrahmen von 9.5 Tagen ohne menschliches Eingreifen. Kostet für MosaicML etwa 200 US-Dollar.

Da es Open Source ist, steht es für die kommerzielle Nutzung zur Verfügung und das Tool wird die Art und Weise, wie Unternehmen und Organisationen mit ihren prädiktiven Analysen und Entscheidungsprozessen arbeiten, grundlegend verändern.

Die Hauptmerkmale des MPT-7B sind:

- Lizenziert für die kommerzielle Nutzung

- Auf einer großen Datenmenge trainiert (1T-Tokens)

- Kann extrem lange Eingaben verarbeiten

- Optimiert für schnelles Training und Inferenz

- Hocheffizienter Open-Source-Trainingscode.

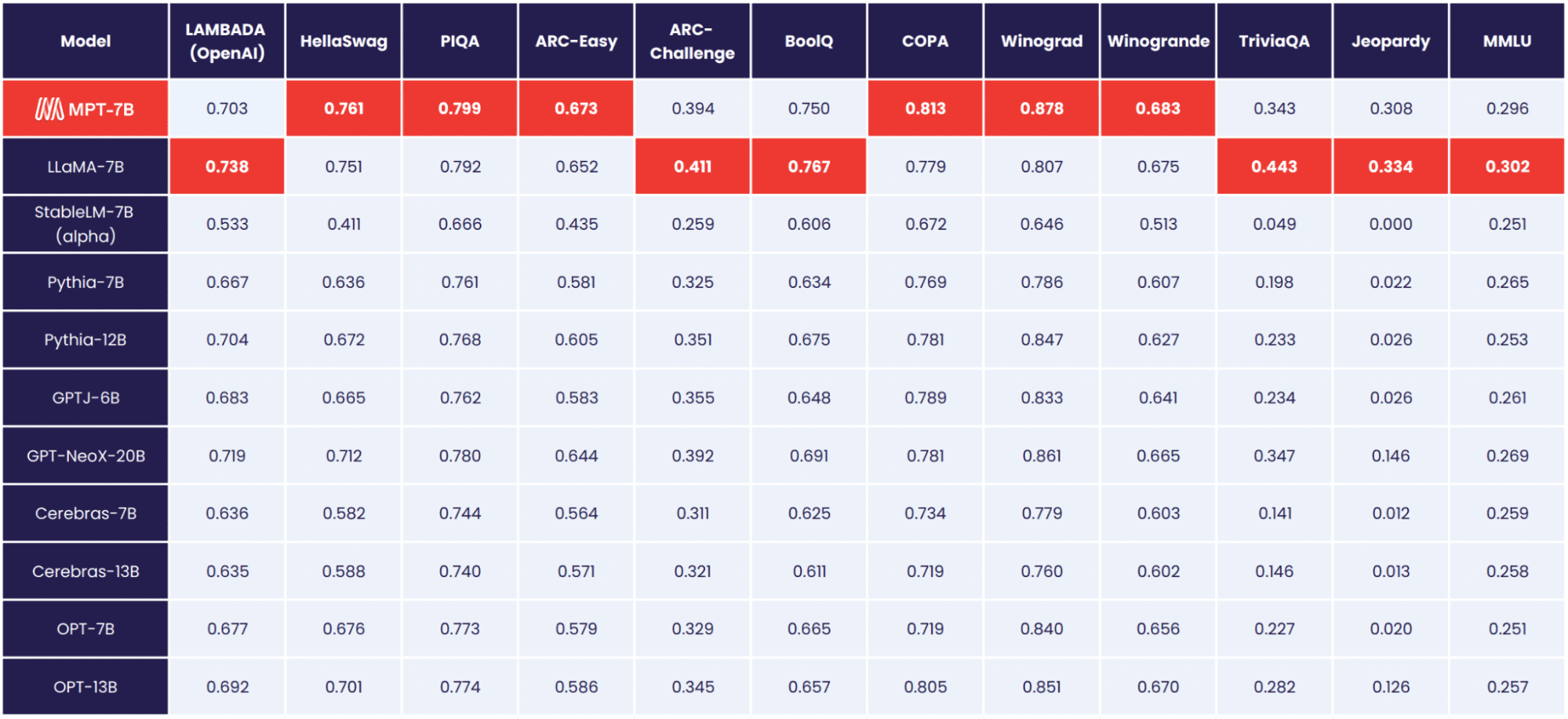

MPT-7B ist das Basismodell und übertrifft nachweislich andere Open-Source-Modelle 7B – 20B. Die Qualität von MPT-7B entspricht LLaMA-7B. Um die Qualität von MPT-7B zu bewerten, hat die MosaicML Foundation 11 Open-Source-Benchmarks zusammengestellt und diese auf branchenübliche Weise bewertet.

Bild von MosaikML-Stiftung

Die Stiftungen von MosaicML veröffentlichen außerdem drei weitere, fein abgestimmte Modelle:

- MPT-7B-Anleitung

- MPT-7B-Chat

- MPT-7B-StoryWriter-65k+

MPT-7B-Anleitung

Das MPT-7B-Anleitung Das Modell ist für die Befolgung von Kurzanleitungen vorgesehen. Mit 26,834 vom 14. Mai ermöglicht Ihnen MPT-7B-Instruct das Stellen schneller und kurzer Fragen und liefert Ihnen eine sofortige Antwort. Sie haben eine Frage und möchten nur eine einfache Antwort – verwenden Sie MPT-7B-Instruct.

Warum ist das so toll? Typischerweise wird LLMs beigebracht, weiterhin Text basierend auf den bereitgestellten Eingaben zu generieren. Einige suchen jedoch nach LLMs, die ihre Eingaben als Anweisungen behandeln. Durch die Befehlsfeinabstimmung können LLMs befehlsfolgende Ausgaben ausführen.

MPT-7B-Chat

Ja, wir haben einen weiteren Chatbot. MPT-7B-Chat erzeugt Dialog. Wenn Sie beispielsweise möchten, dass der Chatbot eine Rede generiert, indem Sie ihm einen Kontext geben, generiert er einen konversationsorientierten Text. Oder vielleicht möchten Sie einen Tweet schreiben, der einen Absatz aus einem Artikel paraphrasiert. Dadurch kann der Dialog für Sie generiert werden!

Warum ist das so toll? MPT-7B Chat ist für eine Vielzahl von Gesprächsaufgaben bereit und gut ausgestattet und bietet Benutzern nahtlosere, ansprechendere Multi-Turn-Interaktionen.

MPT-7B-StoryWriter-65k+

Das ist für die Geschichtenschreiber! Für diejenigen, die Geschichten schreiben möchten, die einen langen Kontext haben, MPT-7B-StoryWriter-65k+ ist ein Modell, das genau dafür konzipiert ist. Das Modell wurde durch Feinabstimmung des MPT-7B mit einem gebaut Kontextlänge von 65 Token, und es können mehr als 65 Token extrapoliert werden. Die MosaicML Foundation konnte 84 Token auf einem einzelnen Knoten mit A100-80-GB-GPUs generieren.

Warum ist das so toll? Dies liegt daran, dass die meisten Open-Source-LLMs nur Sequenzen mit bis zu einigen tausend Token verarbeiten können. Aber allein durch die Verwendung eines einzelnen Knotens von 8xA100-80GB auf der MosaikML-Plattform können Sie MPT-7B so optimieren, dass es Kontextlängen von bis zu 65 verarbeitet!

Das MosaikML-Team hat diese Modelle in nur wenigen Wochen erstellt. In nur wenigen Wochen kümmerten sie sich um die Datenaufbereitung, Schulung, Feinabstimmung und Bereitstellung.

Die Daten stammen aus verschiedenen Quellen, wobei in jeder Quelle jeweils eine Milliarde Token verfügbar waren. Die Anzahl der effektiven Token liegt in jeder Quelle immer noch bei einer Milliarde! Das Team verwendet EleutherAIs, GPT-NeoX und 20B TokenizerDies ermöglicht es ihnen, mit einem vielfältigen Datenmix zu trainieren, eine konsistente Raumtrennung anzuwenden und vieles mehr.

Alle MPT-7B-Modelle wurden auf dem trainiert MosaikML-Plattform, mit A100-40GB- und A100-80GB-GPUs von Oracle Cloud.

Wenn Sie mehr über die Tools und Kosten von MPT-7B erfahren möchten, lesen Sie Folgendes: MPT-7B-Blog.

Die MosaikML-Plattform kann als bester Ausgangspunkt für private, kommerzielle oder gemeinschaftsbezogene Organisationen zur Erstellung benutzerdefinierter LLMs angesehen werden. Die Verfügbarkeit dieser Open-Source-Ressource wird es Unternehmen ermöglichen, diese Tools freier zu nutzen, um die aktuellen organisatorischen Herausforderungen zu bewältigen.

Kunden können LLMs bei jedem Computeranbieter oder jeder Datenquelle trainieren und gleichzeitig Effizienz, Datenschutz und Kostentransparenz wahren.

Wofür werden Sie MPT-7B Ihrer Meinung nach verwenden? Lass es uns unten in den Kommentaren wissen

Nisha Arya ist Data Scientist, freiberuflicher technischer Redakteur und Community Manager bei KDnuggets. Sie ist besonders daran interessiert, Data Science Karriereberatung oder Tutorials und theoriebasiertes Wissen rund um Data Science anzubieten. Sie möchte auch die verschiedenen Möglichkeiten untersuchen, wie künstliche Intelligenz der Langlebigkeit des menschlichen Lebens zugute kommt/kann. Eine begeisterte Lernende, die ihr technisches Wissen und ihre Schreibfähigkeiten erweitern möchte, während sie anderen hilft, sie zu führen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Die Zukunft prägen mit Adryenn Ashley. Hier zugreifen.

- Kaufen und verkaufen Sie Anteile an PRE-IPO-Unternehmen mit PREIPO®. Hier zugreifen.

- Quelle: https://www.kdnuggets.com/2023/05/introducing-mpt7b-new-opensource-llm.html?utm_source=rss&utm_medium=rss&utm_campaign=introducing-mpt-7b-a-new-open-source-llm